Linux的hadoop部署

转自http://blog.sina.com.cn/s/blog_46dcac190101dpi2.html

我的系统是CentOS5.6。所用hadoop的版本是hadoop-1.0.4.tar.gz。

JDK的版本是jdk-6u24-linux-i586.bin

准备好上述软件和文件之后。接下来需要做的就是先后安装文件了。

首先是安装jdk

我们把jdk-6u24-linux-i586.bin放于/usr/local/下。进入此目录

执行命令./jdk-6u24-linux-i586.bin。那么jdk就解包在当前文件下

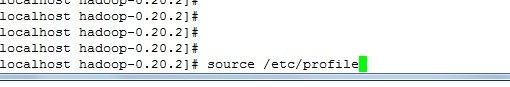

再执行

在文档里面加上如下语句,作用是配置jdk的环境变量

Java安装完毕

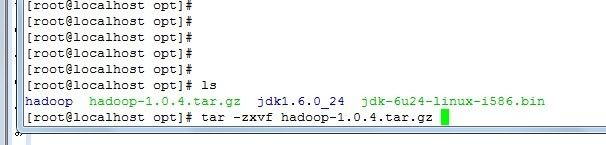

接下来安装hadoop

来到hadoop的放置文件夹下,我的是听前辈的帖子说是放在opt下。。。

用 tar解压

解压完毕后,进入hadoop文件夹

修改conf文件夹下的hadoop-env.sh文件

在文件内加入这句:

保存好。

这样配置好后,整个hadoop就相当于一个单机的hadoop了。我们可以做个实验。

[root@localhost hadoop-0.20.2]# mkdir input

[root@localhost hadoop-0.20.2]# cd input

[root@localhost input]# echo "hey man">test1.txt

[root@localhost input]# echo "hey woman">test2.txt

[root@localhost input]# cd ..

[root@localhost hadoop-0.20.2]# bin/hadoop jar hadoop-examples-0.20.2.jar wordcount input output

运行完之后就可以看到当前目录下有一个output的文件夹。打开文件夹下的文件,就可以得到hadoop examplewordcount运行后的结果啦!!

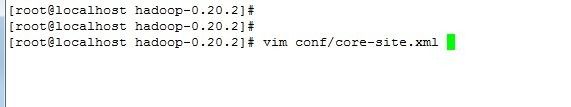

如果需要改成伪集群就要修改另外3个配置文件了。

这三个文件都存在与hadoop目录的conf文件夹下

文件名是core-site.xml,hdfs-site.xml,mapred-site.xml

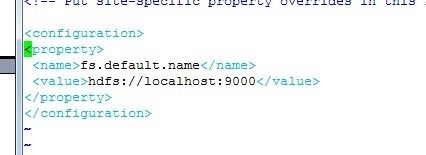

先配置core-site.xml

按如下配置

接下来配置hdfs-site.xml

配置如下

再接下来配置mapred-site.xml

配置如下

其中localhost就是自己的IP地址了。。

用下面的指令格式化namenode

然后启动hadoop

伪集群就搭建好了。之后就可以进行测试了!

在浏览器中输入地址http://localhost:50030/可观察jobtracker的情况。

在浏览器中输入地址http://localhost:50070可以查看当前hadoop的文件系统的的状态。

那么就用数据对这个集群进行测试

[root@localhost hadoop-0.20.2]# bin/hadoop dfs -copyFromLocal input inTest

运行这条指令后,就可以

用http://localhost:50030/在里面看到两个文件都被送到HDFS上面,并且可以看到task和job的状态。

之后再运行以下指令

[root@localhost hadoop-0.20.2]# bin/hadoop jar hadoop-examples-0.20.2.jar wordcount inTest outTest

那么就对分布在HDFS上的文件进行reduce了。

处理完之后

就可以用http://localhost:50070,在文件系统里面看到outTest这个处理结果的文件了

也可以用指令bin/hadoop dfs -cat outTest/* 查看

最后,关闭hadoop

bin/stop-all.sh