R2CNN(论文翻译)

OrientationRobust场景文本检测的R2CNN

摘要

在本文中,我们提出了一种称为R2CNN的新方法,用于在自然场景图像中检测任意方向的文本。该框架基于FasterR-CNN [1]结构。首先,我们使用区域建议网络(RPN)生成包围不同方向文本的轴对齐边界框。然后,针对RPN提出的每个轴对齐文本框,使用不同的pooled size提取它的pooled特征,并连接特征,这些获得的特征同时被用于文本/非文本预测得分,轴对齐框和倾斜最小区域框。最后,我们使用一个倾斜的非极大抑制来获得检测结果。我们的方法在文本检测基准测试(ICDAR 2015和ICDAR 2013)中取得了具有竞争力的结果。

1.Introduction

自然场景中的文本(例如街道牌,商店牌,good names)在我们的日常生活中扮演着重要角色。他们携带有关环境的基本信息。理解场景文本后,可以在很多领域使用,如基于文本的检索,翻译等。通常有两个关键步骤可以理解场景文本:文本检测和文本识别(文本分类)。本文重点介绍场景文本检测。场景文本检测具有挑战性,因为场景文本具有不同的尺寸,宽高比,字体样式,光照,透视失真,方向等。由于方向信息对于场景文本识别和其他任务是有用的,因此场景文本检测不同于普通目标检测任务,除了轴对齐边界框信息之外,还应该预测文本的方向。

虽然大多数以前的文本检测方法是设计用于检测水平或接近水平的文本[2,3,4,5,6,7,8,9,10,11,12,13,14],还有一些方法试图解决具有任意方向的文本检测问题[15,16,17,18,19,20,31,32,33,34]。最近,面向任意方向的场景文本检测是一个热门的研究领域,这可以从ICDAR2015竞赛中偶然场景文本检测频繁的结果更新中看出[21]。虽然传统的文本检测方法是基于滑窗或连接组件(connected components)[2,3,4,6,10,13,17,18,19,20],但基于深度学习的方法最近已被广泛研究[7,8,9,12,15,16,31,32,33,34]。

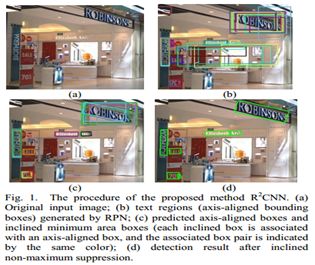

本文提出了一种用于检测任意方向场景文本的方法R2CNN。它基于Faster R-CNN架构[1]。图1显示了所提出的方法的过程。图1(a)是原始输入图像。我们首先使用RPN生成包围文本的轴对齐边界框 (图1(b))。 然后,我们对候选框进行分类,调整轴对齐框并预测具有不同pooledsizes的pooled特征的倾斜最小区域框(图1(c))。最后,倾斜非极大抑制用于后处理倾斜候选框以获得最终检测结果(图1(d))。我们的方法在ICDAR 2015文本检测基准测试中获得了82.54%的F-measure,在ICDAR2013文本检测基准测试中获得了87.73%。

本论文的贡献:

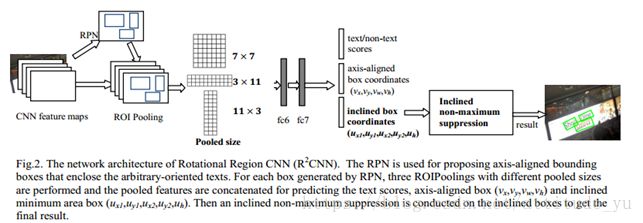

我们引入了一种用于检测任意方向场景文本的新框架(图2)。它基于Faster R-CNN[1]。RPN用于提出文本区域,Fast R-CNN模型[23]被修改用于文本区域分类,细化调整和预测倾斜框。

任意方向的文本检测问题被表述为一个多任务问题。该方法的核心是预测RPN生成的每个候选框的文本分数,轴对齐框和倾斜最小区域框。

为充分利用文本特征,我们针对每个RPN候选框使用不同的pooled sizes(7×7,11×3,3×11)做了多个ROI Poolings。连接各自池化后的特征用于进一步的检测。

我们对FasterR-CNN的修改还包括添加一个较小的anchor来检测小场景文本,并使用倾斜的非极大抑制来对检测候选框进行后处理以获得最终结果。

2.Related work

传统的场景文本检测方法包括基于滑动窗口的方法和基于连接组件(CCs)的方法[2,3,4,6,10,13,17,18,19,20]。基于滑动窗口的方法通过图像密集地移动一个多尺度窗口,然后将候选分类为字符或非字符以检测字符候选。基于CCs的方法是基于CCs生成字符候选。特别是,在ICDAR 2015[21]和ICDAR 2013[22]比赛中,基于最大稳定极值区域(MSER)的方法取得了良好的表现。这些传统方法采用自下而上的策略,并且经常需要几个步骤来检测文本(例如,字符检测,文本行构建和文本行分类)。

通用目标检测技术是近年来一个热门的研究领域。基于深度学习的技术大大提高了对象检测能力。一种目标检测方法依赖于区域建议,如R-CNN [24],SPPnet [25],Fast R-CNN [23],Raster CNN [1]和R-FCN [26]。另一个目标检测方法家族不依赖区域建议并直接估计目标候选对象,如SSD[27]和YOLO [28]。我们的方法基于FasterR-CNN架构。在Faster R-CNN中,提出了一个区域建议网络(RPN),用于直接从卷积特征图中生成高质量的目标建议。RPN生成的建议随后被改进基于Fast R-CNN模型进行分类[23]。由于场景文本具有方向性,与一般目标不同,所以一般目标检测方法不能直接用于场景文本检测。

基于深度学习的场景文本检测方法[7,8,9,12,15,16,31,32,33,34]实现了比传统方法更好的性能。TextBoxes是一个具有单个深度神经网络的端到端快速场景文本检测器[8]。DeepText通过Inception-RPN生成单词区域建议,然后使用文本检测网络对每个单词建议进行评分和refines[7]。全卷积回归网络(FCRN)利用合成图像训练场景文本检测模型[12]。但是,这些方法旨在生成轴对齐的检测框,并且不解决文本方向问题。Connectionist Text Proposal Network(CTPN)检测固定宽度的垂直框,使用BLSTM捕获顺序信息,然后链接垂直框以获得最终检测框[9]。它擅长检测水平文本,但不适合高度倾斜的文本。基于完全卷积网络(FCN)的方法被设计用于检测多方向的场景文本[16]。这种方法需要三个步骤:文本块FCN的文本块检测,基于MSER的多方向文本行候选生成和文本行候选分类。旋转区域建议网络(RRPN)也被提出来检测任意方向的场景文本[15],它基于Faster R-CNN [1]。RPN被修改以产生具有文本方向角度信息的倾斜建议,并且之后的分类和回归是基于倾斜的建议。SegLink [31]被提出通过检测segments和links来检测定向文本。它适用于任意长度的文本行。EAST [32]旨在在自然场景中产生快速准确的文本检测框。DMPNet[33]设计用于检测更紧密文本的四边形。深度直接回归[34]被提出用于多方向的场景文本检测。

我们的目标是检测任意方向的场景文本,与RRPN类似[15],我们的网络也基于FasterR-CNN [1],但我们采用不同的策略,而不是产生倾斜建议。我们认为RPN有资格生成文本候选,并根据RPN提出的候选文本预测方向信息。

3.Proposed Approach

在本节中,我们介绍我们的方法来检测任意方向的场景文本。图2显示了所提出的R2CNN的架构。我们首先介绍我们如何形式化任意方向的文本检测问题,然后介绍R2CNN的细节。之后,描述我们的训练目标。

3.1 Problem definition

在ICDAR2015比赛[21]中,场景文本检测的ground truth由顺时针方向四个坐标点(x1,y1,x2,y2,x3,y3,x4,y4)表示,如图3(a)所示。该标签是在字符级。四点形成一个四边形,这可能不是一个矩形。尽管由于perspectivedistortion,场景文本可以被不规则的四边形更紧密地包围,它们可以被倾斜的具有方向的矩形粗略地包围(图3(b))。由于我们认为倾斜的矩形能够覆盖大部分文本区域,因此我们将任意方向的场景文本检测任务近似为检测倾斜的最小区域矩形。在本文的其余部分,当我们提到边界框时,它指的是一个rectangular框。

尽管表示倾斜矩形的直接方法是使用角度来表示其方向,但我们不采用这种策略,因为角度目标在某些特殊点中不稳定。例如,旋转角度为90的矩形与旋转角度为-90的相同矩形非常相似,但它们的角度相当不同。这使得网络很难学习检测垂直文本。我们不使用角度来表示方位信息,而是使用顺时针方向的前两个点的坐标和边界框的高度来表示倾斜的矩形(x1,y1,x2,y2,h)。我们假设第一个点始终表示场景文本左上角的点。图3(b)和图3(c)显示了两个例子。(x1,y1)为第一点的坐标,(x2,y2)为第二点的顺时针坐标,h为倾斜最小区域矩形的高度。

3.2 Rotational Region CNN

概述算法。我们采用流行的两阶段目标检测策略,包括区域建议和区域分类。R2CNN基于Faster R-CNN [1]。图2显示了R2CNN的体系结构。RPN首先用于生成文本区域建议,这是包含任意方向文本的轴对齐边界框(图1b)。然后针对每个建议,对卷积特征图执行具有不同pooled sizes(7×7,11×3,3×11)的若干ROI Poolings,并将pooled特征串联。通过连接的特征和全连接层,我们可以预测文本/非文本评分,轴对齐框和倾斜最小区域框(图1c)。之后,对倾斜框进行倾斜非极大抑制的后处理以获得检测结果(图1d)。

RPN for proposing axis-aligned boxes。我们使用RPN生成包围任意方向文本的轴对齐边界框。这是合理的,因为轴对齐框中的文本属于以下情况之一:a)文本处于水平方向; b)文字处于垂直方向; c)文本位于轴对齐框的对角线方向。如图1(b)所示,RPN能够以任意方向文本的轴对齐框形式生成文本区域。与一般文本检测相比,还有更多的小场景文字。我们通过在RPN中利用较小的anchor比例来解决这一问题。在Faster R-CNN中的原始anchor 缩放是(8,16,32),我们研究了两种策略:a)将anchor比例缩放更改为较小的尺寸,并使用(4,8,16); b)增加一个新的anchor缩放并利用(4,8,16,32)。我们的实验证实,采用较小的anchor有助于场景文本检测。我们将RPN的其他设置与更快Faster R-CNN [1]保持一致,包括锚点aspect ratios,正样本和负样本的定义等。

ROIPoolings of different pooled sizes。FasterR-CNN框架在特征图上进行ROIPooling,每个RPN建议的池化大小为7×7。由于一些文本的宽度比它们的高度大得多,我们尝试使用三种不同大小的ROIPoolings来捕捉更多文本特征。 pooled 特征被连接在一起以便进一步检测。具体而言,我们添加了两个pooled sizes:11×3和3×11。pooled size 为3×11被认为捕捉更多的水平特征,并帮助检测宽度远大于其高度的水平文本。pooled size 为11×3被认为捕捉更多的垂直特征,并帮助检测高度远远大于宽度垂直文本。

Regression for text/non-text scores,axis-aligned boxes,and inclined minimum area boxes。在我们的方法中,在RPN之后,我们将由RPN生成的建议框分类为文本或非文本,细化调整包含任意方向文本的轴对齐边界框并预测倾斜边界框。每个倾斜框都与轴对齐框相关联(图1(c)和图4(a))。虽然我们的检测目标是倾斜边界框,但我们认为增加额外约束(轴对齐边界框)可以提高性能。我们的评估也证实了这个想法的有效性。

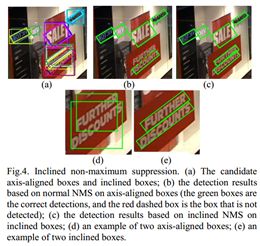

Inclined non-maximum suppression。非极大抑制(NMS)广泛用于通过当前目标检测方法对检测候选框进行后处理。由于我们估计了轴对齐边界框和倾斜边界框,我们既可以在轴对齐边界框上执行常规NMS,也可以在倾斜边界框上执行倾斜NMS。在倾斜NMS中,传统的IoU(Intersection-over-Union)计算被修改为两个倾斜边界框之间的IoU。IoU计算方法使用的是[15]中的。

图4说明了两种NMS执行后的检测结果。 图4(a)显示了每个轴对齐的边界框与倾斜的边界框相关联的预测候选框。图4(b)显示了正常NMS对轴对齐框的影响。图4(c)显示了倾斜NMS对倾斜框的影响。如图4(b)所示,红色虚线框中的文本在轴对齐框上的正常NMS下未检测到。图4(d)和图4(e)显示了倾斜NMS更适合倾斜场景文本检测的原因。我们可以看到,对于紧密相邻的倾斜文本,正常的NMS可能会丢失一些文本,因为轴对齐框之间的IoU可能很高(图4(d)),但倾斜的NMS不会错过文本,因为倾斜的IoU值较低 图4(e))

3.3 Training objective(Multi-task loss)

RPN的训练损失与FasterR-CNN [1]相同。在本节中,我们仅介绍R2CNN通过RPN生成的每个轴对齐框的损失函数。

我们在每个建议框中定义的损失函数是文本/非文本分类损失和方框回归损失的总和。方框回归损失由两部分组成:包含任意方向文本的轴对齐方框的损失以及倾斜最小区域框的损失。每个建议框的多任务损失函数定义如下:

lamda1和lamda2是控制三项之间权衡的平衡参数.

方框回归仅对文字进行。t是类别标签的indicator。文本标记为1(t = 1),背景标记为0(t = 0)。参数p =(p0,p1)是由softmax函数计算出的文本和背景类别的概率。是真实类t的对数损失。

![]() 是truth 轴对齐边界框回归目标的元组,包括中心点的坐标及其宽度和高度,

是truth 轴对齐边界框回归目标的元组,包括中心点的坐标及其宽度和高度,![]() 是文本标签的预测元组。

是文本标签的预测元组。 ![]() 是truth 倾斜边界框回归目标的元组,包括倾斜框的前两个点的坐标及其高度,以及

是truth 倾斜边界框回归目标的元组,包括倾斜框的前两个点的坐标及其高度,以及![]() 是文本标签的预测元组。 我们使用[24]中给出参数v和v*,其中v和v*指定相对于目标建议的尺度不变转换和对数空间高度/宽度偏移。对于倾斜边界框,

是文本标签的预测元组。 我们使用[24]中给出参数v和v*,其中v和v*指定相对于目标建议的尺度不变转换和对数空间高度/宽度偏移。对于倾斜边界框,![]()

![]() 的参数与

的参数与![]() 的参数相同。

的参数相同。 ![]() 的参数与

的参数与![]() 的参数相同。

的参数相同。

让(w,w*)(vi,vi*)or (ui,ui*),Lreg(w,w*)定义为:

4.Experiments

4.1 Implementation details

Training Data。我们的训练数据集包括来自ICDAR 2015年训练数据集[21]的1000个偶然场景文本图像和我们收集的2000个重点场景文本图像。我们收集的图像中的场景文本与ICDAR 2015中的模糊文本明显不同。尽管我们的简单实验表明,额外收集的图像不会增加ICDAR2015的性能,但我们仍将它们加入训练中,以使我们的模型更加鲁棒,对不同种类的场景文本都有效。由于ICDAR 2015训练数据集包含难以检测到的标签为“###”,我们只使用可读的文本进行训练。此外,我们只使用由多个字符组成的场景文本进行训练。

为了支持任意方向的场景文本检测,我们通过旋转图像来增强ICDAR 2015训练数据集和我们自己的数据。我们以以下角度旋转图像(-90,-75,-60,-45,-30,-15,0,15,30,45,60,75,90)。因此,数据增强后,我们的训练数据集由39000个图像组成。

ICDAR 2015中的文本有四个顺时针方向的矩形点坐标。由于我们简化了第3.1节介绍的检测倾斜矩形的附带文本检测问题,我们通过计算包围四边形的最小面积矩形,从四边形生成ground truth倾斜边界框(矩形数据)。 然后,我们计算包围文本的最小轴对齐边界框作为ground truth轴对齐框。对我们收集的图像进行类似的处理以生成groundtruth数据。

Training。我们的网络由ImageNet分类的预训练VGG16模型初始化[29]。我们使用端到端的训练策略。所有模型都迭代训练了20e4次。学习率从e-3开始,经过5e4,10e4和15e4迭代后乘以0.1。权重衰减为0.0005,动量为0.9。所有实验都使用single scale训练。图像的最短边设置为720,而图像的最长边设置为1280。我们选择这个图像尺寸是因为ICDAR 2015 [21]中的训练和测试图像的尺寸(宽度:1280,高度:720)。

5. Conclusion

在本文中,我们引入了R2CNN(R2CNN),用于检测任意方向的场景文本。该框架基于Faster R-CNN结构[1]。RPN用于生成轴对齐的区域建议框。然后在多个ROIPoolings对建议执行不同大小(7×7,11×3,3×11)的池化,并使用连接的特征对建议框进行分类,估计轴对齐框和倾斜最小区域框。之后,倾斜NMS在倾斜框上进行。评估表明,我们的方法可以在ICDAR2015和ICDAR2013上取得有竞争力的结果。

该方法可以视为基于轴对齐框学习倾斜框,并且可以很容易地适应SSD [27]和YOLO [28]等其他目标检测框架以检测具有方向的对象。