[Nutch]Nutch重要命令使用说明

之前几篇博文对nucth抓取周期的几个命令做了说明,本篇博文将对nutch抓取周期以外的几个重要的命令的使用进行详细的说明。

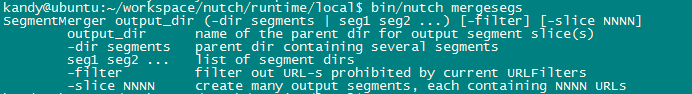

1. mergesegs

合并多个segment为一个segment。

参数:

参数说明:

- output_dir: 输出目录

- dir:合并路径

命令:

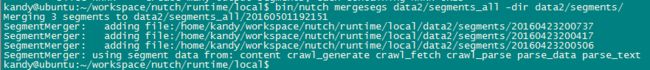

bin/nutch mergesegs data2/segments_all -dir data2/segments/合并结果:

从结果可以看出,是把三个segments合并为了一个segment。

从结果来看,大小没有变,是因为数据量比较小,如果数据量很大的话,效果也会相当的明显。另外hadoop对于处理大文件有先天的优势,所以合并的命令有非常大的作用。

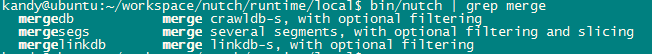

合并的命令有3个:

另外两个:mergedb和mergelinkdb的使用方法和mergesegs的使用完全一样,这里不做详细说明。

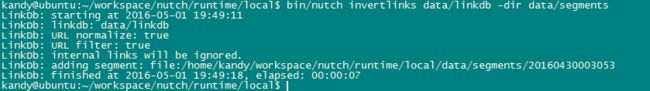

2. invertlinks

- linkdb: linkdb路径

- dir:输出路径

执行命令:

bin/nutch mergesegs data2/segments_all -dir data2/segments/可以看到,在data目录下面生成了linkdb目录了:

![]()

3. parsechecker

对一个url进行源数据的解析以及文本内容的解析。

参数:

![]()

参数说明:

- url:需要check的url。

执行命令:

bin/nutch parsechecker http://www.cnbeta.com执行结果:

![[Nutch]Nutch重要命令使用说明_第4张图片](http://img.e-com-net.com/image/info8/f366043af4ae4dd9a5abfc895349db5f.jpg)

![[Nutch]Nutch重要命令使用说明_第5张图片](http://img.e-com-net.com/image/info8/542e96b9b8db484e8714d81ba837a639.jpg)

从执行结果可以看出有213条外链,网站签名等信息。

4. domainstats

域统计:从crwaldb中计算域名统计信息。

参数:

![]()

参数说明:

- inputDirs:输入目录,为crawldb路径;

- outDir:输出目录。

- host|domain|suffix|tld:从小到大的范围统计。

执行命令:

bin/nutch domainstats data2/crawldb/current/ host host

bin/nutch domainstats data2/crawldb/current/ domian domain

bin/nutch domainstats data2/crawldb/current/ suffix suffix

bin/nutch domainstats data2/crawldb/current/ tld tld5. webgraph

从已经存在的segment从生成一个web graph。

参数:

![[Nutch]Nutch重要命令使用说明_第8张图片](http://img.e-com-net.com/image/info8/0b23c9c9a80a494e94e9ef633e421ee5.png)

参数说明:

- segment:单独或者多个的segment目录;

- segmentDir:使用的segment的目录;

- webgraphdb:web graph 数据库路径。

执行命令:

bin/nutch webgraph -segmentDir data2/segments/ -webgraphdb data2/webgraphdb6. nodedumper

- asSequenceFile:是否把输出文件设置为一个序列文件;

- group:根据host或者domain分组;

- inlinks:根据输入连接排序;

- outlinks:根据输出连接排序;

- sorces:根据分数排序;

- output:输出目录;

- topn:根据自然顺序显示N条结果;

- webgraphdb:webgraphdb目录。

执行命令:

bin/nutch nodedumper -topn 1 -inlinks -output inlinks_topn_1 -webgraphdb data2/webgraphdb执行命令:

bin/nutch nodedumper -topn 1 -outlinks -output outlinks_topn_1 -webgraphdb data2/webgraphdb执行命令:

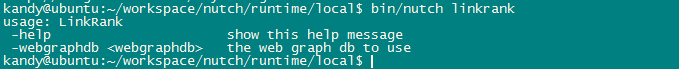

bin/nutch nodedumper -topn 1 -scores -output scores_topn_1 -webgraphdb data2/webgraphdb7. linkrank

- webgraphdb:webgraphdb的路径。

执行命令:

bin/nutch linkrank -webgraphdb data2/webgraphdb再来通过nodedumper看下分值:

执行命令:

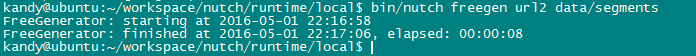

bin/nutch nodedumper -scores -output after_inject_score -topn 1 -webgraphdb data2/webgraphdb8. freegen

轻量级抓取:从文本文件里面生成一个segment,然后对这个segment进行抓取。

参数:

![[Nutch]Nutch重要命令使用说明_第14张图片](http://img.e-com-net.com/image/info8/01ba754c6516432b8c15ea0314c2d856.png)

参数说明:

- inputDir:输入路径;

- segmentsDir:segments路径。

执行命令:

mkdir url2

vim url2/url.txt//输入http://cnbbeta.com

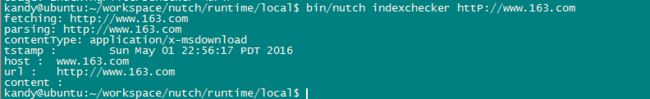

bin/nutch freegen url2 data/segments9. indexchecker

- url:需要进行检查的url。

执行命令:

bin/nutch indexchecker httP://www.163.com![[Nutch]Nutch重要命令使用说明_第1张图片](http://img.e-com-net.com/image/info8/3cb85e04d85f4b17963c722965d818e8.png)

![[Nutch]Nutch重要命令使用说明_第2张图片](http://img.e-com-net.com/image/info8/acab7c0cf80d4ad09fafaaac673fd4b0.png)

![[Nutch]Nutch重要命令使用说明_第3张图片](http://img.e-com-net.com/image/info8/d67696fb3fe44c88a0c49a8d3d42048b.png)

![[Nutch]Nutch重要命令使用说明_第6张图片](http://img.e-com-net.com/image/info8/f3e4e4591e564d37a715f80d63c32fa0.jpg)

![[Nutch]Nutch重要命令使用说明_第7张图片](http://img.e-com-net.com/image/info8/3be33abbf3b84dd6872af7fe38d71b01.png)

![[Nutch]Nutch重要命令使用说明_第9张图片](http://img.e-com-net.com/image/info8/f4293048740d4c0c920fbbaec799f840.jpg)

![[Nutch]Nutch重要命令使用说明_第10张图片](http://img.e-com-net.com/image/info8/9d9b764018c74b5fa9a4d6b25d9d0807.png)

![[Nutch]Nutch重要命令使用说明_第11张图片](http://img.e-com-net.com/image/info8/0fdb410bca494e69aa1f9bb2c36fca77.png)

![[Nutch]Nutch重要命令使用说明_第12张图片](http://img.e-com-net.com/image/info8/cdbb6c51e5b74b60aeb04606958601d3.jpg)

![[Nutch]Nutch重要命令使用说明_第13张图片](http://img.e-com-net.com/image/info8/d134e898703c482f855d862485174952.jpg)