作者:张江

制造出能够像人类一样思考的机器是科学家们最伟大的梦想之一。用智慧的大脑解读智慧必将成为科学发展的终极。而验证这种解读的最有效手段,莫过于再造一个智慧大脑——人工智能(Artificial Intelligence,AI)。

人们对人工智能的了解恐怕主要来自于好莱坞的科幻片。这些荧幕上的机器(见图1-1)要么杀人如麻,如《终结者》《黑客帝国》;要么小巧可爱,如《机器人瓦利》;要么多愁善感,如《人工智能》;还有一些则大音希声、大象无形,如《黑客帝国》中的Matrix网络,以及《超验骇客》《超体》。所有这些荧幕上的人工智能都具备一些共同特征:异常强大、能力非凡。

然而,现实中的人工智能却与这些荧幕上的机器人相差甚远,但它们的确已经在我们身边。搜索引擎、邮件过滤器、智能语音助手Siri、二维码扫描器、游戏中的NPC(非玩家扮演角色)都是近60年来人工智能技术实用化的产物。这些人工智能都是一个个单一功能的“裸”程序,没有坚硬的、灵活的躯壳,更没有想象中那么善解人意,甚至不是一个完整的个体。为什么想象与现实存在那么大的差距?这是因为,真正的人工智能的探索之路充满了波折与不确定。

历史上,研究人工智能就像是在坐过山车,忽上忽下。梦想的肥皂泡一次次被冰冷的科学事实戳破,科学家们不得不一次次重新回到梦的起点。作为一个独立的学科,人工智能的发展非常奇葩。它不像其他学科那样从分散走向统一,而是从1956年创立以来就不断地分裂,形成了一系列大大小小的子领域。也许人工智能注定就是大杂烩,也许统一的时刻还未到来。然而,人们对人工智能的梦想却是永远不会磨灭的。

本章将按历史的顺序介绍人工智能的发展。从早期的哥德尔、图灵等人的研究到“人工智能”一词的提出,再到后期的人工智能三大学派:符号学派、连接学派和行为学派,以及近年来的新进展:贝叶斯网络、深度学习、通用人工智能;最后我们将对未来的人工智能进行展望。

梦的开始(1900—1956)

大卫•希尔伯特

说来奇怪,人工智能之梦开始于一小撮20世纪初期的数学家。这些人真正做到了用方程推动整个世界。

历史的车轮倒回到1900年,世纪之交的数学家大会在巴黎如期召开,德高望重的老数学家大卫•希尔伯特(David Hilbert)庄严地向全世界数学家们宣布了23个未解决的难题。这23道难题道道经典,而其中的第二问题和第十问题则与人工智能密切相关,并最终促成了计算机的发明。

希尔伯特的第二问题来源于一个大胆的想法——运用公理化的方法统一整个数学,并运用严格的数学推理证明数学自身的正确性。这个野心被后人称为希尔伯特纲领,虽然他自己没能证明,但却把这个任务交给了后来的年轻人,这就是希尔伯特第二问题:证明数学系统中应同时具备一致性(数学真理不存在矛盾)和完备性(任意真理都可以被描述为数学定理)。

库尔特•哥德尔

希尔伯特的勃勃野心无疑激励着每一位年轻的数学家,其中就包括一个来自捷克的年轻人:库尔特•哥德尔(Kurt Godel)。他起初是希尔伯特的忠实粉丝,并致力于攻克第二问题。然而,他很快发现,自己之前的努力都是徒劳的,因为希尔伯特第二问题的断言根本就是错的:任何足够强大的数学公理系统都存在着瑕疵:一致性和完备性不能同时具备。很快,哥德尔倒戈了,他背叛了希尔伯特,但却推动了整个数学的发展,于1931年提出了被美国《时代周刊》评选为20世纪最有影响力的数学定理:哥德尔不完备性定理。

尽管早在1931年,人工智能学科还没有建立,计算机也没有发明,但是哥德尔定理似乎已经为人工智能提出了警告。这是因为如果我们把人工智能也看作一个机械化运作的数学公理系统,那么根据哥德尔定理,必然存在着某种人类可以构造、但是机器无法求解的人工智能的“软肋”。这就好像我们无法揪着自己的脑袋脱离地球,数学无法证明数学本身的正确性,人工智能也无法仅凭自身解决所有问题。所以,存在着人类可以求解但是机器却不能解的问题,人工智能不可能超过人类。

但问题并没有这么简单,上述命题成立的一个前提是人与机器不同,不是一个机械的公理化系统。然而,这个前提是否成立迄今为止我们并不知道,所以这一问题仍在争论之中。关于此观点的延伸讨论请参见本书第4章。

艾伦•图灵

另外一个与哥德尔年龄相仿的年轻人被希尔伯特的第十问题深深地吸引了,并决定为此奉献一生。这个人就是艾伦•图灵(Alan Turing)。

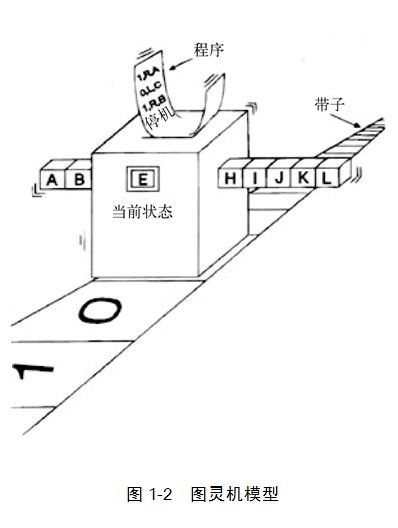

希尔伯特第十问题的表述是:“是否存在着判定任意一个丢番图方程有解的机械化运算过程。”这句话的前半句比较晦涩,我们可以先忽略,因为后半句是重点,“机械化运算过程”用今天的话说就是算法。然而,当年,算法这个概念还是相当模糊的。于是,图灵设想出了一个机器——图灵机,它是计算机的理论原型,圆满地刻画出了机械化运算过程的含义,并最终为计算机的发明铺平了道路。

图灵机模型(见图1-2)形象地模拟了人类进行计算的过程。假如我们希望计算任意两个3位数的加法:139+919。我们需要一张足够大的草稿纸以及一支可以在纸上不停地涂涂写写的笔。之后,我们需要从个位到百位一位一位地按照10以内的加法规则完成加法。我们还需要考虑进位,例如9+9=18,这个1就要加在十位上。我们是通过在草稿纸上记下适当的标记来完成这种进位记忆的。最后,我们把计算的结果输出到了纸上。

图灵机把所有这些过程都模型化了:草稿纸被模型化为一条无限长的纸带,笔被模型化为一个读写头,固定的10以内的运算法则模型化为输入给读写头的程序,对于进位的记忆则被模型化为读写头的内部状态。于是,设定好纸带上的初始信息,以及读写头的当前内部状态和程序规则,图灵机就可以运行起来了。它在每一时刻读入一格纸带的信息,并根据当前的内部状态,查找相应的程序,从而给出下一时刻的内部状态并输出信息到纸带上。关于图灵机的详细描述,请参见本书第2章。

图灵机模型一经提出就得到了科学家们的认可,这无疑给了图灵莫大的鼓励。他开始鼓起勇气,展开想象的翅膀,进一步思考图灵机运算能力的极限。1940年,图灵开始认真地思考机器是否能够具备类人的智能。他马上意识到这个问题的要点其实并不在于如何打造强大的机器,而在于我们人类如何看待智能,即依据什么标准评价一台机器是否具备智能。于是,图灵在1950年发表了《机器能思考吗?》一文,提出了这样一个标准:如果一台机器通过了“图灵测试”,则我们必须接受这台机器具有智能。那么,图灵测试究竟是怎样一种测试呢?

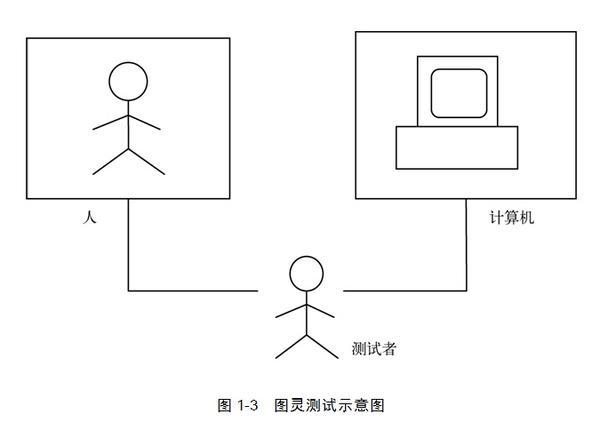

如图1-3所示,假设有两间密闭的屋子,其中一间屋子里面关了一个人,另一间屋子里面关了一台计算机:进行图灵测试的人工智能程序。然后,屋子外面有一个人作为测试者,测试者只能通过一根导线与屋子里面的人或计算机交流——与它们进行联网聊天。假如测试者在有限的时间内无法判断出这两间屋子里面哪一个关的是人,哪一个是计算机,那么我们就称屋子里面的人工智能程序通过了图灵测试,并具备了智能。事实上,图灵当年在《机器能思考吗?》一文中设立的标准相当宽泛:只要有30%的人类测试者在5分钟内无法分辨出被测试对象,就可以认为程序通过了图灵测试。

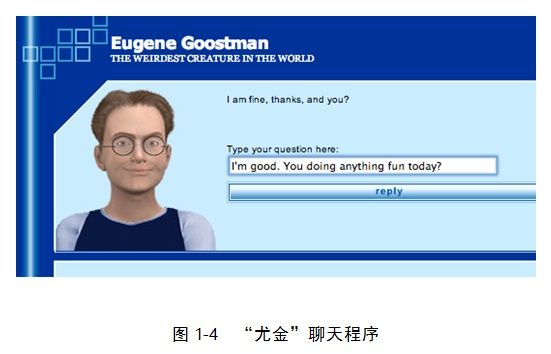

2014年6月12日,一个名为“尤金”(Eugene Goostman)的聊天程序(见图1-4)成功地在5分钟内蒙骗了30%的人类测试者,从而达到了图灵当年提出来的标准。很多人认为,这款程序具有划时代的意义,它是自图灵测试提出64年后第一个通过图灵测试的程序。但是,很快就有人提出这只不过是一个噱头,该程序并没有宣传的那么厉害。例如,谷歌公司的工程总监、未来学家雷•库兹韦尔(Ray Kurzweil)就表示,这个聊天机器人号称只有13岁,并使用第二语言来回答问题,这成为了该程序重大缺陷的借口。另外,测试者只有5分钟与之展开互动,这大大增加了他们在短期内被“欺骗”的概率。

由此可见,图灵将智能等同于符号运算的智能表现,而忽略了实现这种符号智能表现的机器内涵。这样做的好处是可以将所谓的智能本质这一问题绕过去,它的代价是人工智能研制者们会把注意力集中在如何让程序欺骗人类测试者上,甚至可以不择手段。所以,对于将图灵测试作为评判机器具备智能的唯一标准,很多人开始质疑。因为人类智能还包括诸如对复杂形式的判断、创造性地解决问题的方法等,而这些特质都无法在图灵测试中体现出来。

总而言之,图灵的研究无疑大大推动了人工智能的进展。然而,图灵本人却于1954年死于一个被剧毒氰化物注射过的苹果,享年仅仅42岁。传闻他是一名同性恋,这在当时的英国是非法的。于是英国政府强行给他注射一种药物抑制他的同性恋倾向,这导致他最终在治疗期间痛苦万分地自杀了。据说,苹果公司为了纪念这位计算机科学之父,特意用那个被图灵咬掉一口的苹果作为公司的logo。1966年,美国计算机协会设立了以图灵命名的图灵奖,以专门奖励那些对计算机事业作出重要贡献的人,这相当于计算机领域的诺贝尔奖。

约翰•冯•诺依曼

就在哥德尔绞尽脑汁捉摸希尔伯特第二问题的时候,另外一个来自匈牙利布达佩斯的天才少年也在思考同样的问题,他就是大名鼎鼎的约翰•冯•诺依曼(John von Neumann)。

然而,冯•诺依曼远没有哥德尔走运。到了1931年,冯•诺依曼即将在希尔伯特第二问题上获得突破,却突然得知哥德尔已经发表了哥德尔定理,先他一步。于是,冯•诺依曼一气之下开始转行研究起了量子力学。就在他的量子力学研究即将结出硕果之际,另外一位天才物理学家保罗•狄拉克(Paul Dirac)又一次抢了他的风头,出版了《量子力学原理》,并一举成名。这比冯•诺依曼的《量子力学的数学基础》整整早了两年。

受到两次打击之后,冯•诺依曼开始把部分注意力从基础数学转向了工程应用领域,终于大获成功。1945年,凭借出众的才华,冯•诺依曼在火车上完成了早期的计算机EDVAC的设计,并提出了我们现在熟知的“冯•诺依曼体系结构”。

冯•诺依曼的计算机与图灵机是一脉相承的,但最大的不同就在于,冯•诺依曼的读写头不再需要一格一格地读写纸带,而是根据指定的地址,随机地跳到相应的位置完成读写。这也就是我们今天所说的随机访问存储器(Random Access Memory,RAM)的前身。关于冯•诺依曼体系结构和现代计算机的工作原理,请参见本书第3章。

冯•诺依曼的计算机终于使得数学家们的研究结出了硕果,也最终推动着人类历史进入了信息时代,使得人工智能之梦成为了可能。

诺伯特•维纳

我们要介绍的最后一位数学家是美国的天才神童诺伯特•维纳(Norbert Wiener)。据说维纳三岁的时候就开始在父亲的影响下读天文学和生物学的图书。七岁的时候他所读的物理学和生物学的知识范围已经超出了他父亲。他年纪轻轻就掌握了拉丁语、希腊语、德语和英语,并且涉猎人类科学的各个领域。后来,他留学欧洲,曾先后拜师于罗素、希尔伯特、哈代等哲学、数学大师。维纳在他70年的科学生涯中,先后涉足数学、物理学、工程学和生物学,共发表240多篇论文,著作14本。

然而,与我们的主题最相关的,则要数维纳于1948年提出来的新兴学科“控制论”(Cybernetics)了。“Cybernetics”一词源于希腊语的“掌舵人”。在控制论中,维纳深入探讨了机器与人的统一性——人或机器都是通过反馈完成某种目的的实现,因此他揭示了用机器模拟人的可能性,这为人工智能的提出奠定了重要基础。维纳也是最早注意到心理学、脑科学和工程学应相互交叉的人之一,这促使了后来认知科学的发展。

这几位数学大师不满足于“躲进小楼成一统”,埋头解决一两个超级数学难题。他们的思想大胆地拥抱了斑驳复杂的世界,最终用他们的方程推动了社会的进步,开启了人工智能之梦。

梦的延续(1956—1980)

在数学大师们铺平了理论道路,工程师们踏平了技术坎坷,计算机已呱呱落地的时候,人工智能终于横空出世了。而这一历史时刻的到来却是从一个不起眼的会议开始的。

达特茅斯会议

1956年8月,在美国汉诺斯小镇宁静的达特茅斯学院中,约翰•麦卡锡(John McCarthy)、马文•闵斯基(Marvin Minsky,人工智能与认知学专家)、克劳德•香农(Claude Shannon,信息论的创始人)、艾伦•纽厄尔(Allen Newell,计算机科学家)、赫伯特•西蒙(Herbert Simon,诺贝尔经济学奖得主)等科学家正聚在一起,讨论着一个完全不食人间烟火的主题:用机器来模仿人类学习以及其他方面的智能。

会议足足开了两个月的时间,虽然大家没有达成普遍的共识,但是却为会议讨论的内容起了一个名字:人工智能。因此,1956年也就成为了人工智能元年。

黄金时期

达特茅斯会议之后,人工智能获得了井喷式的发展,好消息接踵而至。机器定理证明——用计算机程序代替人类进行自动推理来证明数学定理——是最先取得重大突破的领域之一。在达特茅斯会议上,纽厄尔和西蒙展示了他们的程序:“逻辑理论家”可以独立证明出《数学原理》第二章的38条定理;而到了1963年,该程序已能证明该章的全部52条定理。1958年,美籍华人王浩在IBM704计算机上以3~5分钟的时间证明了《数学原理》中有关命题演算部分的全部220条定理。而就在这一年,IBM公司还研制出了平面几何的定理证明程序。

1976年,凯尼斯•阿佩尔(Kenneth Appel)和沃夫冈•哈肯(Wolfgang Haken)等人利用人工和计算机混合的方式证明了一个著名的数学猜想:四色猜想(现在称为四色定理)。这个猜想表述起来非常简单易懂:对于任意的地图,我们最少仅用四种颜色就可以染色该地图,并使得任意两个相邻的国家不会重色;然而证明起来却异常烦琐。配合着计算机超强的穷举和计算能力,阿佩尔等人把这个猜想证明了。

另一方面,机器学习领域也获得了实质的突破,在1956年的达特茅斯会议上,阿瑟•萨缪尔(Arthur Samuel)研制了一个跳棋程序,该程序具有自学习功能,可以从比赛中不断总结经验提高棋艺。1959年,该跳棋程序打败了它的设计者萨缪尔本人,过了3年后,该程序已经可以击败美国一个州的跳棋冠军。

1956年,奥利弗•萨尔夫瑞德(Oliver Selfridge)研制出第一个字符识别程序,开辟了模式识别这一新的领域。1957年,纽厄尔和西蒙等开始研究一种不依赖于具体领域的通用问题求解器,他们称之为GPS(General Problem Solver)。1963年,詹姆斯•斯拉格(James Slagle)发表了一个符号积分程序SAINT,输入一个函数的表达式,该程序就能自动输出这个函数的积分表达式。过了4年后,他们研制出了符号积分运算的升级版SIN,SIN的运算已经可以达到专家级水准。

遇到瓶颈

所有这一切来得太快了,胜利冲昏了人工智能科学家们的头脑,他们开始盲目乐观起来。例如,1958年,纽厄尔和西蒙就自信满满地说,不出10年,计算机将会成为世界象棋冠军,证明重要的数学定理,谱出优美的音乐。照这样的速度发展下去,2000年人工智能就真的可以超过人类了。

然而,历史似乎故意要作弄轻狂无知的人工智能科学家们。1965年,机器定理证明领域遇到了瓶颈,计算机推了数十万步也无法证明两个连续函数之和仍是连续函数。萨缪尔的跳棋程序也没那么神气了,它停留在了州冠军的层次,无法进一步战胜世界冠军。

最糟糕的事情发生在机器翻译领域,对于人类自然语言的理解是人工智能中的硬骨头。计算机在自然语言理解与翻译过程中表现得极其差劲,一个最典型的例子就是下面这个著名的英语句子:

The spirit is willing but the flesh is weak. (心有余而力不足。)

当时,人们让机器翻译程序把这句话翻译成俄语,然后再翻译回英语以检验效果,得到的句子竟然是:

The wine is good but the meet is spoiled.(酒是好的,肉变质了。)

这简直是驴唇不对马嘴嘛。怪不得有人挖苦道,美国政府花了2000万美元为机器翻译挖掘了一座坟墓。有关自然语言理解的更多内容,请参见本书第10章。

总而言之,越来越多的不利证据迫使政府和大学削减了人工智能的项目经费,这使得人工智能进入了寒冷的冬天。来自各方的事实证明,人工智能的发展不可能像人们早期设想的那样一帆风顺,人们必须静下心来冷静思考。

知识就是力量

经历了短暂的挫折之后,AI研究者们开始痛定思痛。爱德华•费根鲍姆(Edward A. Feigenbaum)就是新生力量的佼佼者,他举着“知识就是力量”的大旗,很快开辟了新的道路。

费根鲍姆分析到,传统的人工智能之所以会陷入僵局,就是因为他们过于强调通用求解方法的作用,而忽略了具体的知识。仔细思考我们人类的求解过程就会发现,知识无时无刻不在起着重要作用。因此,人工智能必须引入知识。

于是,在费根鲍姆的带领下,一个新的领域专家系统诞生了。所谓的专家系统就是利用计算机化的知识进行自动推理,从而模仿领域专家解决问题。第一个成功的专家系统DENDRAL于1968年问世,它可以根据质谱仪的数据推知物质的分子结构。在这个系统的影响下,各式各样的专家系统很快陆续涌现,形成了一种软件产业的全新分支:知识产业。1977年,在第五届国际人工智能大会上,费根鲍姆用知识工程概括了这个全新的领域。

在知识工程的刺激下,日本的第五代计算机计划、英国的阿尔维计划、西欧的尤里卡计划、美国的星计划和中国的863计划陆续推出,虽然这些大的科研计划并不都是针对人工智能的,但是AI都作为这些计划的重要组成部分。

然而,好景不长,在专家系统、知识工程获得大量的实践经验之后,弊端开始逐渐显现了出来,这就是知识获取。面对这个全新的棘手问题,新的“费根鲍姆”没有再次出现,人工智能这个学科却发生了重大转变:它逐渐分化成了几大不同的学派。

群龙问鼎(1980—2010)

专家系统、知识工程的运作需要从外界获得大量知识的输入,而这样的输入工作是极其费时费力的,这就是知识获取的瓶颈。于是,在20世纪80年代,机器学习这个原本处于人工智能边缘地区的分支一下子成为了人们关注的焦点。

尽管传统的人工智能研究者也在奋力挣扎,但是人们很快发现,如果采用完全不同的世界观,即让知识通过自下而上的方式涌现,而不是让专家们自上而下地设计出来,那么机器学习的问题其实可以得到很好地解决。这就好比我们教育小孩子,传统人工智能好像填鸭式教学,而新的方法则是启发式教学:让孩子自己来学。

事实上,在人工智能界,很早就有人提出过自下而上的涌现智能的方案,只不过它们从来没有引起大家的注意。一批人认为可以通过模拟大脑的结构(神经网络)来实现,而另一批人则认为可以从那些简单生物体与环境互动的模式中寻找答案。他们分别被称为连接学派和行为学派。与此相对,传统的人工智能则被统称为符号学派。自20世纪80年代开始,到20世纪90年代,这三大学派形成了三足鼎立的局面。

符号学派

作为符号学派的代表,人工智能的创始人之一约翰•麦卡锡在自己的网站上挂了一篇文章《什么是人工智能》,为大家阐明什么是人工智能(按照符号学派的理解)。

(人工智能)是关于如何制造智能机器,特别是智能的计算机程序的科学和工程。它与使用机器来理解人类智能密切相关,但人工智能的研究并不需要局限于生物学上可观察到的那些方法。

在这里,麦卡锡特意强调人工智能研究并不一定局限于模拟真实的生物智能行为,而是更强调它的智能行为和表现的方面,这一点和图灵测试的想法是一脉相承的。另外,麦卡锡还突出了利用计算机程序来模拟智能的方法。他认为,智能是一种特殊的软件,与实现它的硬件并没有太大的关系。

纽厄尔和西蒙则把这种观点概括为“物理符号系统假说”(physical symbolic system hypothesis)。该假说认为,任何能够将物理的某些模式(pattern)或符号进行操作并转化成另外一些模式或符号的系统,就有可能产生智能的行为。这种物理符号可以是通过高低电位的组成或者是灯泡的亮灭所形成的霓虹灯图案,当然也可以是人脑神经网络上的电脉冲信号。这也恰恰是“符号学派”得名的依据。

在“物理符号系统假说”的支持下,符号学派把焦点集中在人类智能的高级行为,如推理、规划、知识表示等方面。这些工作在一些领域获得了空前的成功。

人机大战

计算机博弈(下棋)方面的成功就是符号学派名扬天下的资本。早在1958年,人工智能的创始人之一西蒙就曾预言,计算机会在10年内成为国际象棋世界冠军。然而,正如我们前面讨论过的,这种预测过于乐观了。事实比西蒙的预言足足晚了40年的时间。

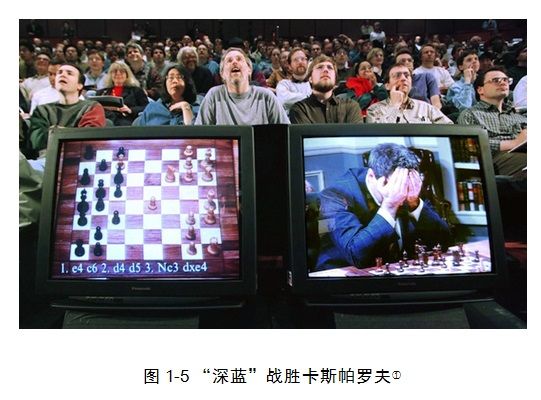

1988年,IBM开始研发可以与人下国际象棋的智能程序“深思”——一个可以以每秒70万步棋的速度进行思考的超级程序。到了1991年,“深思II”已经可以战平澳大利亚国际象棋冠军达瑞尔•约翰森(Darryl Johansen)。1996年,“深思”的升级版“深蓝”开始挑战著名的人类国际象棋世界冠军加里•卡斯帕罗夫(Garry Kasparov),却以2:4败下阵来。但是,一年后的5月11日,“深蓝”最终以3.5:2.5的成绩战胜了卡斯帕罗夫(见图1-5),成为了人工智能的一个里程碑。

图片来源:http://cdn.theatlantic.com/static/mt/assets/science/kasparov615.jpg。

人机大战终于以计算机的胜利划上了句号。那是不是说计算机已经超越了人类了呢?要知道,计算机通过超级强大的搜索能力险胜了人类——当时的“深蓝”已经可以在1秒钟内算两亿步棋。而且,“深蓝”存储了100年来几乎所有的国际特级大师的开局和残局下法。另外还有四位国际象棋特级大师亲自“训练”“深蓝”,真可谓是超豪华阵容。所以,最终的结果很难说是计算机战胜了人,更像是一批人战胜了另一批人。最重要的是,国际象棋上的博弈是在一个封闭的棋盘世界中进行的,而人类智能面对的则是一个复杂得多的开放世界。

然而,时隔14年后,另外一场在IBM超级计算机和人类之间的人机大战刷新了记录,也使得我们必须重新思考机器是否能战胜人类这个问题。因为这次的比赛不再是下棋,而是自由的“知识问答”,这种竞赛环境比国际象棋开放得多,因为提问的知识可以涵盖时事、历史、文学、艺术、流行文化、科学、体育、地理、文字游戏等多个方面。因此,这次的机器胜利至少证明了计算机同样可以在开放的世界中表现得不逊于人类。

这场人机大战的游戏叫作《危险》(Jeopardy),是美国一款著名的电视节目。在节目中,主持人通过自然语言给出一系列线索,然后,参赛队员要根据这些线索用最短的时间把主持人描述的人或者事物猜出来,并且以提问的方式回答。例如当节目主持人给出线索“这是一种冷血的无足的冬眠动物”的时候,选手应该回答“什么是蛇?”而不是简单地回答“蛇”。由于问题会涉及各个领域,所以一般知识渊博的人类选手都很难获胜。

然而,在2011年2月14日到2月16日期间的《危险》比赛中,IBM公司的超级计算机沃森(Watson)却战胜了人类选手(见图1-6)。

图片来源:http://cdn.geekwire.com/wp-content/uploads/IBM-Watson.jpg。

这一次,IBM打造的沃森是一款完全不同于以往的机器。首先,它必须是一个自然语言处理的高手,因为它必须在短时间内理解主持人的提问,甚至有的时候还必须理解语言中的隐含意思。而正如我们前文所说,自然语言理解始终是人工智能的最大难题。其次,沃森必须充分了解字谜,要领会双关语,并且脑中还要装满诸如莎士比亚戏剧的独白、全球主要的河流和各国首都等知识,所有这些知识并不限定在某个具体的领域。所以,沃森的胜利的确是人工智能界的一个标志性事件。

可以说,人机大战是人工智能符号学派1980年以来最出风头的应用。然而,这种无休止的人机大战也难逃成为噱头的嫌疑。事实上,历史上每次吸引眼球的人机大战似乎都必然伴随着IBM公司的股票大涨,这也就不难理解为什么IBM会花重金开发出一款又一款大型计算机去参加这么多无聊的竞赛,而不是去做一些更实用的东西了。

实际上,20世纪80年代以后,符号学派的发展势头已经远不如当年了,因为人工智能武林霸主的地位很快就属于其他学派了。

连接学派

我们知道,人类的智慧主要来源于大脑的活动,而大脑则是由一万亿个神经元细胞通过错综复杂的相互连接形成的。于是,人们很自然地想到,我们是否可以通过模拟大量神经元的集体活动来模拟大脑的智力呢?

对比物理符号系统假说,我们不难发现,如果将智力活动比喻成一款软件,那么支撑这些活动的大脑神经网络就是相应的硬件。于是,主张神经网络研究的科学家实际上在强调硬件的作用,认为高级的智能行为是从大量神经网络的连接中自发出现的,因此,他们又被称为连接学派。

神经网络

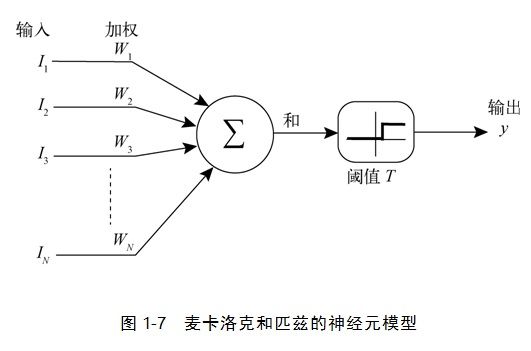

连接学派的发展也是一波三折。事实上,最早的神经网络研究可以追溯到1943年计算机发明之前。当时,沃伦•麦卡洛克(Warren McCulloch)和沃尔特•匹兹(Walter Pitts)二人提出了一个单个神经元的计算模型,如图1-7所示。

在这个模型中,左边的I1,I2,…,IN为输入单元,可以从其他神经元接受输出,然后将这些信号经过加权(W1,W2,…,WN)传递给当前的神经元并完成汇总。如果汇总的输入信息强度超过了一定的阈值(T),则该神经元就会发放一个信号y给其他神经元或者直接输出到外界。该模型后来被称为麦卡洛克匹兹模型,可以说它是第一个真实神经元细胞的模型。

1957

年,弗兰克•罗森布拉特(Frank Rosenblatt)对麦卡洛克匹兹模型进行了扩充,即在麦卡洛克匹兹神经元上加入了学习算法,扩充的模型有一个响亮的名字:感知机。感知机可以根据模型的输出y与我们希望模型的输出y*之间的误差,调整权重W1,W2,…,WN来完成学习。

我们可以形象地把感知机模型理解为一个装满了大大小小水龙头(W1,W2,…,WN)的水管网络,学习算法可以调节这些水龙头来控制最终输出的水流,并让它达到我们想要的流量,这就是学习的过程。

这样,感知机就好像一个可以学习的小孩,无论什么问题,只要明确了我们想要的输入和输出之间的关系,都可能通过学习得以解决,至少它的拥护者是这样认为的。

然而,好景不长,1969年,人工智能界的权威人士马文•闵斯基给连接学派带来了致命一击。他通过理论分析指出,感知机并不像它的创立者罗森布拉特宣称的那样可以学习任何问题。连一个最简单的问题:判断一个两位的二进制数是否仅包含0或者1(即所谓的XOR问题)都无法完成。这一打击是致命的,本来就不是很热的神经网络研究差点就被闵斯基这一棒子打死了。

多则不同

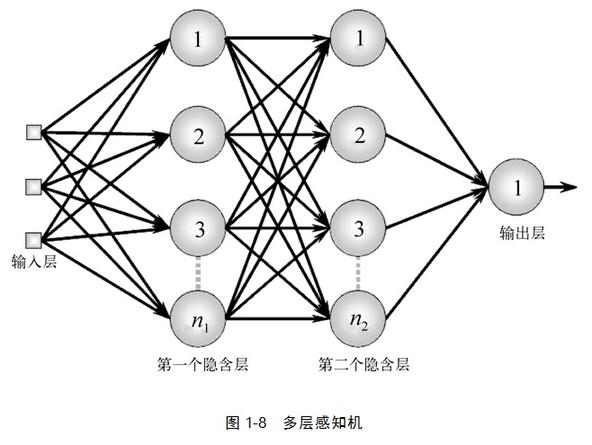

1974年,人工智能连接学派的救世主杰夫•辛顿(Geoffrey Hinton)终于出现了。他曾至少两次挽回连接学派的败局,1974年是第一次,第二次会在下文提到。辛顿的出发点很简单——“多则不同”:只要把多个感知机连接成一个分层的网络,那么,它就可以圆满地解决闵斯基的问题。如图1-8所示,多个感知机连接成为一个四层的网络,最左面为输入层,最右面为输出层,中间的那些神经元位于隐含层,右侧的神经元接受左侧神经元的输出。

但接下来的问题是,“人多吃得多”,那么多个神经元,可能有几百甚至上千个参数需要调节,我们如何对这样复杂的网络进行训练呢?辛顿等人发现,采用几年前阿瑟•布赖森(Arthur Bryson)等人提出来的反向传播算法(Back propagation algorithm,简称BP算法)就可以有效解决多层网络的训练问题。

还是以水流管道为例来说明。当网络执行决策的时候,水从左侧的输入节点往右流,直到输出节点将水吐出。而在训练阶段,我们则需要从右往左来一层层地调节各个水龙头,要使水流量达到要求,我们只要让每一层的调节只对它右面一层的节点负责就可以了,这就是反向传播算法。事实证明,多层神经网络装备上反向传播算法之后,可以解决很多复杂的识别和预测等问题。

几乎是在同一时间,又有几个不同的神经网络模型先后被提出,这些模型有的可以完成模式聚类,有的可以模拟联想思维,有的具有深厚的数学物理基础,有的则模仿生物的构造。所有这些大的突破都令连接学派名声大噪,异军突起。

统计学习理论

然而,连接学派的科学家们很快又陷入了困境。虽然各种神经网络可以解决问题,但是,它们究竟为什么会成功以及为什么在有些问题上会屡遭失败,却没有人能说得清楚。对网络运行原理的无知,也使得人们对如何提高神经网络运行效率的问题无从下手。因此,连接学派需要理论的支持。

2000年左右,弗拉基米尔•万普尼克(Vladimir Naumovich Vapnik)和亚历克塞•泽范兰杰斯(Alexey Yakovlevich Chervonenkis)这两位俄罗斯科学家提出了一整套新的理论:统计学习理论,受到连接学派的顶礼膜拜。

该理论大意可概括为“杀鸡焉用宰牛刀”。我们的模型一定要与待解决的问题相匹配,如果模型过于简单,而问题本身的复杂度很高,就无法得到预期的精度。反过来,若问题本身简单,而模型过于复杂,那么模型就会比较僵死,无法举一反三,即出现所谓的“过拟合”(overfitting)现象。

实际上,统计学习理论的精神与奥卡姆剃刀原理有着深刻的联系。威廉•奥卡姆(William Occum,1287—1347)是中世纪时期的著名哲学家,他留下的最重要的遗产就是奥卡姆剃刀原理。该原理说,如果对于同一个问题有不同的解决方案,那么我们应该挑选其中最简单的一个。神经网络或者其他机器学习模型也应该遵循类似的原理,只有当模型的复杂度与所解决的问题相匹配的时候,才能让模型更好地发挥作用。

然而,统计学习理论也有很大的局限性,因为理论的严格分析仅仅限于一类特殊的神经网络模型:支持向量机(Supporting Vector Machine)。而对于更一般的神经网络,人们还未找到统一的分析方法。所以说,连接学派的科学家们虽然会向大脑学习如何构造神经网络模型,但实际上他们自己也不清楚这些神经网络究竟是如何工作的。不过,他们这种尴尬局面也是无独有偶,另外一派后起之秀虽然来势汹汹,却也没有解决理论基础问题,这就是行为学派。

行为学派

行为学派的出发点与符号学派和连接学派完全不同,他们并没有把目光聚焦在具有高级智能的人类身上,而是关注比人类低级得多的昆虫。即使这样简单的动物也体现出了非凡的智能,昆虫可以灵活地摆动自己的身体行走,还能够快速地反应,躲避捕食者的攻击。而另一方面,尽管蚂蚁个体非常简单,但是,当很多小蚂蚁聚集在一起形成庞大的蚁群的时候,却能表现出非凡的智能,还能形成严密的社会分工组织。

正是受到了自然界中这些相对低等生物的启发,行为学派的科学家们决定从简单的昆虫入手来理解智能的产生。的确,他们取得了不错的成果。

机器昆虫

罗德尼•布鲁克斯(Rodney Brooks)是一名来自美国麻省理工学院的机器人专家。在他的实验室中有大量的机器昆虫(如图1-9所示)。相对于那些笨拙的机器人铁家伙来说,这些小昆虫要灵活得多。

这些机器昆虫没有复杂的大脑,也不会按照传统的方式进行复杂的知识表示和推理。它们甚至不需要大脑的干预,仅凭四肢和关节的协调,就能很好地适应环境。当我们把这些机器昆虫放到复杂的地形中的时候,它们可以痛快地爬行,还能聪明地避开障碍物。它们看起来的智能事实上并不来源于自上而下的复杂设计,而是来源于自下而上的与环境的互动。这就是布鲁克斯所倡导的理念。

如果说符号学派模拟智能软件,连接学派模拟大脑硬件,那么行为学派就算是模拟身体了,而且是简单的、看起来没有什么智能的身体。例如,行为学派的一个非常成功的应用就是美国波士顿动力公司(Boston Dynamics)研制开发的机器人“大狗②。如图1-10所示,“大狗”是一个四足机器人,它能够在各种复杂的地形中行走、攀爬、奔跑,甚至还可以背负重物。“大狗”模拟了四足动物的行走行为,能够自适应地根据不同的地形调整行走的模式。推荐感兴趣的读者扫描下方二维码观看视频介绍。

图片来源:http://grant.solarbotics.net/walkman.htm。BigDog,参见http://www.bostondynamics.com/robot_bigdog.html。

[+]查看原图当这只大狗伴随着“沙沙”的机器运作声朝你走来时,你一定会被它的气势所吓到,因为它的样子很像是一头公牛呢!

进化计算

我们从生物身上学到的东西还不仅仅是这些。从更长的时间尺度看,生物体对环境的适应还会迫使生物进化,从而实现从简单到复杂、从低等到高等的跃迁。

约翰•霍兰(John Holland)是美国密西根大学的心理学、电器工程以及计算机的三科教授。他本科毕业于麻省理工学院,后来到了密西根大学师从阿瑟•伯克斯(Arthur Burks,曾是冯•诺依曼的助手)攻读博士学位。1959年,他拿到了全世界首个计算机科学的博士头衔。别看霍兰个头不高,他的骨子里却有一种离经叛道的气魄。他在读博期间就对如何用计算机模拟生物进化异常着迷,并最终发表了他的遗传算法。

遗传算法对大自然中的生物进化进行了大胆的抽象,最终提取出两个主要环节:变异(包括基因重组和突变)和选择。在计算机中,我们可以用一堆二进制串来模拟自然界中的生物体。而大自然的选择作用——生存竞争、优胜劣汰——则被抽象为一个简单的适应度函数。这样,一个超级浓缩版的大自然进化过程就可以搬到计算机中了,这就是遗传算法。

图片来源:http://www.militaryfactory.com/armor/detail.asp?armor_id=184。

遗传算法在刚发表的时候并没有引起多少人的重视。然而,随着时间的推移,当人工智能的焦点转向机器学习时,遗传算法就一下子家喻户晓了,因为它的确是一个非常简单而有效的机器学习算法。与神经网络不同,遗传算法不需要把学习区分成训练和执行两个阶段,它完全可以指导机器在执行中学习,即所谓的做中学(learning by doing)。同时,遗传算法比神经网络具有更方便的表达性和简单性。

无独有偶,美国的劳伦斯•福格尔(Lawrence Fogel)、德国的因戈•雷伯格(Ingo Rechenberg)以及汉斯•保罗•施韦费尔(Hans-Paul Schwefel)、霍兰的学生约翰•科扎(John Koza)等人也先后提出了演化策略、演化编程和遗传编程。这使得进化计算大家庭的成员更加多样化了。

人工生命

无论是机器昆虫还是进化计算,科学家们关注的焦点都是如何模仿生物来创造智能的机器或者算法。克里斯托弗•兰顿(Chirstopher Langton)进行了进一步提炼,提出了“人工生命”这一新兴学科。人工生命与人工智能非常接近,但是它的关注点在于如何用计算的手段来模拟生命这种更加“低等”的现象。

人工生命认为,所谓的生命或者智能实际上是从底层单元(可以是大分子化合物,也可以是数字代码)通过相互作用而产生的涌现属性(emergent property)。“涌现”(emergence)这个词是人工生命研究中使用频率最高的词之一,它强调了一种只有在宏观具备但不能分解还原到微观层次的属性、特征或行为。单个的蛋白质分子不具备生命特征,但是大量的蛋白质分子组合在一起形成细胞的时候,整个系统就具备了“活”性,这就是典型的涌现。同样地,智能则是比生命更高一级(假如我们能够将智能和生命分成不同等级的话)的涌现——在生命系统中又涌现出了一整套神经网络系统,从而使得整个生命体具备了智能属性。现实世界中的生命是由碳水化合物编织成的一个复杂网络,而人工生命则是寄生于01世界中的复杂有机体。

人工生命的研究思路是通过模拟的形式在计算机数码世界中产生类似现实世界的涌现。因此,从本质上讲,人工生命模拟的就是涌现过程,而不太关心实现这个过程的具体单元。我们用01数字代表蛋白质分子,并为其设置详细的规则,接下来的事情就是运行这个程序,然后盯着屏幕,喝上一杯咖啡,等待着令人吃惊的“生命现象”在电脑中出现。

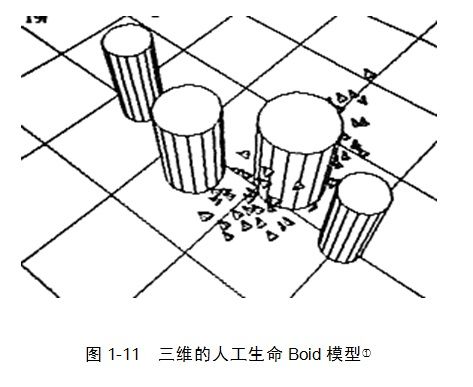

模拟群体行为是人工生命的典型应用之一。1983年,计算机图形学家克雷格•雷诺兹(Craig Reynolds)曾开发了一个名为Boid的计算机模拟程序(见图1-11),它可以逼真地模拟鸟群的运动,还能够聪明地躲避障碍物。后来,肯尼迪(Kennedy)等人于1995年扩展了Boid模型,提出了PSO(粒子群优化)算法,成功地通过模拟鸟群的运动来解决函数优化等问题。

类似地,利用模拟群体行为来实现智能设计的例子还有很多,例如蚁群算法、免疫算法等,共同特征都是让智能从规则中自下而上地涌现出来,并能解决实际问题。关于人工生命的详细讨论,可以参考本书11~13章。

然而,行为学派带来的问题似乎比提供的解决方法还多。究竟在什么情况下能够发生涌现?如何设计底层规则使得系统能够以我们希望的方式涌现?行为学派、人工生命的研究者们无法回答。更糟糕的是,几十年过去了,人工生命研究似乎仍然只擅长于模拟小虫子、蚂蚁之类的低等生物,高级的智能完全没有像他们预期的那样自然涌现,而且没有丝毫迹象。

图片来源:http://www.red3d.com/cwr/boids/。

三大学派间的关系

正如我们前面提到的,这三个学派大致是从软件、硬件和身体这三个角度来模拟和理解智能的。但是,这仅仅是一个粗糙的比喻。事实上,三大学派之间还存在着很多微妙的差异和联系。

首先,符号学派的思想和观点直接继承自图灵,他们是直接从功能的角度来理解智能的。他们把智能理解为一个黑箱,只关心这个黑箱的输入和输出,而不关心黑箱的内部构造。因此,符号学派利用知识表示和搜索来替代真实人脑的神经网络结构。符号学派假设知识是先验地存储于黑箱之中的,因此,它很擅长解决利用现有的知识做比较复杂的推理、规划、逻辑运算和判断等问题。

连接学派则显然要把智能系统的黑箱打开,从结构的角度来模拟智能系统的运作,而不单单重现功能。这样,连接学派看待智能会比符号学派更加底层。这样做的好处是可以很好地解决机器学习的问题,并自动获取知识;但是弱点是对于知识的表述是隐含而晦涩的,因为所有学习到的知识都变成了连接权重的数值。我们若要读出神经网络中存储的知识,就必须要让这个网络运作起来,而无法直接从模型中读出。连接学派擅长解决模式识别、聚类、联想等非结构化的问题,但却很难解决高层次的智能问题(如机器定理证明)。

行为学派则研究更低级的智能行为,它更擅长模拟身体的运作机制,而不是脑。同时,行为学派非常强调进化的作用,他们认为,人类的智慧也理应是从漫长的进化过程中逐渐演变而来的。行为学派擅长解决适应性、学习、快速行为反应等问题,也可以解决一定的识别、聚类、联想等问题,但在高级智能行为(如问题求解、逻辑演算)上则相形见绌。

有意思的是,连接学派和行为学派似乎更加接近,因为他们都相信智能是自下而上涌现出来的,而非自上而下的设计。但麻烦在于,怎么涌现?涌现的机制是什么?这些深层次问题无法在两大学派内部解决,而必须求助于复杂系统科学。

三大学派分别从高、中、低三个层次来模拟智能,但现实中的智能系统显然是一个完整的整体。我们应如何调解、综合这三大学派的观点呢?这是一个未解决的开放问题,而且似乎很难在短时间内解决。主要的原因在于,无论是在理论指导思想还是计算机模型等方面,三大学派都存在着太大的差异。

分裂与统一

于是,就这样磕磕碰碰地,人工智能走入了新的世纪。到了2000年前后,人工智能的发展非但没有解决问题,反而引入了一个又一个新的问题,这些问题似乎变得越来越难以回答,而且所牵扯的理论也越来越深。于是,很多人工智能研究者干脆当起了“鸵鸟”,对理论问题不闻不问,而是一心向“应用”看齐。争什么争呀,实践是检验真理的唯一标准,无论是符号、连接、行为,能够解决实际问题的鸟就是好鸟。

群龙无首

在这样一种大背景下,人工智能开始进一步分化,很多原本隶属于人工智能的领域逐渐独立成为面向具体应用的新兴学科,我们简单罗列如下:

自动定理证明

模式识别

机器学习

自然语言理解

计算机视觉

自动程序设计

每一个领域都包含大量具体的技术和专业知识以及特殊的应用背景,不同分支之间也几乎是老死不相往来,大一统的人工智能之梦仿佛破灭了。于是,计算机视觉专家甚至不愿意承认自己搞的叫人工智能,因为他们认为,人工智能已经成为了一个仅仅代表传统的符号学派观点的专有名词,大一统的人工智能概念没有任何意义,也没有存在的必要。这就是人工智能进入2000年之后的状况。

【未完】待续......

阅读原文