最前沿:堪比E=mc2,Al-GA才是实现AGI的指标性方法论?

原文链接: https://aiprocon.csdn.net

作者 | Flood Sung

转载自知乎

导读:在读完Uber AI Lab发表的一篇关于AGI的论文之后,本文作者恍然觉得有一种道破天机的感觉。他评价道,虽然这篇论文是泛泛之谈,却揭示了一些真正实现AGI的方法论——AI-GA(AI-generating algorithms),这也许是通往AGI的一条道路。

1 前言

最近,Uber AI Lab的Jeff Clune发了一篇很特别的paper:

AI-GAs: AI-generating algorithms, an alternate paradigm for producing general artificial intelligence(https://arxiv.org/abs/1905.10985)读罢深感和我对AGI的思考不谋而合,特和大家分享一下这里面的思想。

先说结论:AI-GA这篇文章虽然是泛泛而谈,但是我认为是一篇具有历史性意义的文章,因为这里面揭示的就是真正实现AGI的方法论。

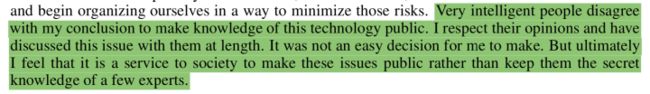

我们来看一下paper里面的这一段话:

什么感觉?

道破天机的感觉!

在Jeff Clune眼里very intelligent people会是什么人呢?只能是最顶级的学术大牛了,比如paper acknowledgements里面的Peter Dayan (德国马普所)Zoubin Ghahramani (剑桥大学)还有一堆openai和uber ai lab的人。

为什么Jeff Clune会说“It was not an easy decision for me to make." ? 因为以前AGI根本就是一个概念,是触碰不到的地方。具体的实现途径是什么?没人说清楚。

DeepMind和OpenAI推崇的DRL深度强化学习就是AGI吗?不是。为什么呢?因为AGI应该内部就包含了DRL,而不是DRL创造AGI。后面的具体分析我们会说DRL的作用,确实是AGI必不可少的组件。

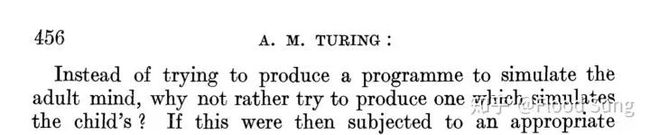

现在,Jeff Clune以个人名义写了AI-GA,可以说把AGI的实现途径说清楚了。 我们知道,AGI这一个目标在Alan Turing提出图灵测试的时候可以说就有了,甚至Alan Turing在他1950年的人工智能开篇论文 Computing Machinery and Intelligence 中说了:

这实际上已经道明了AGI的实现途径了。牛逼的图灵,才提出人工智能就已经睿智的看到了实现的方向。我们后人不过是把图灵的思想具体化而已,而Jeff Clune提出的AI-GA正是一条具体化的实现道路。

那么,就让我们一起来道破天机吧!(以下内容包含大量个人思考)

2 什么是通用人工智能AGI(Artificial General Intelligence)?

AGI称为通用人工智能,或者叫强人工智能,简单的说就是创造和人类一样聪明甚至比人还聪明的计算机程序。现在已经实现的很多程序(神经网络也是一段程序)比如AlphaGo,AlphaStar 都只是在某一个特定领域超越人类,还谈不上AGI。但是AlphaGo相比以前的深蓝,完全通过自学习的方法实现,已经是革命性的突破。

3 什么是AI-GA?

AI-GA 核心包含了三个部分:

- meta-learning architectures (Meta Learning 神经网络结构,即AutoML)

- meta-learning the learning algorithms themselves (即现在常说的Meta Learning)

- generating effective learning environments (生成有效的学习环境)

为了让更多的读者理解这三个部分,我们先解释一下Meta Learning。

4 什么是Meta ?

Meta-X = X about X

X可以代指任何事物。

比如: 1) Meta-Book: Book about Book 一本书里面的主角在写一本书 2)Meta-Movie: Movie about Movie 一部电影里面的主角在拍一部电影

可能更有名的例子是:

你在桥上看风景,那么楼上看你的人可以称为Meta-Person:Person about Person 看风景的人的眼里有一个你在看风景。

看风景的人在楼上看你。

------《断章》卞之琳

还有一个很酷的例子就是无限镜了:

https://www.bilibili.com/video/av11156770/

https://www.bilibili.com/video/av11156770/

这是一个Meta-Meta-...-Meta-Mirror。镜子里面还有镜子,无尽头。

5 什么是Meta Learning?

学习这个概念相对上面的书,镜子这种具体的概念显得比较抽象,不好理解。什么是学习呢?什么又是学习如何学习呢?

举个栗子:

什么是学习?

比如学习语文,数学,物理,化学,我们学的是具体的1+1=2,E=mc2

什么是学习如何学习?

比如不管是学数学物理还是化学生物,我们都要先学习理解一些概念,然后通过练习和更多的思考来掌握和拓展这些概念。能够触类旁通举一反三。这些都是学习的技巧。我们说一个人学习成绩很好是不仅仅是说他学习好,而是学习能力很强,知道如何学习。

这里我们可以看到,meta learning的知识是更通用更抽象的,甚至是无法具化的东西。比如怎么学会举一反三?怎么学会理性分析?这些能力不局限于任何一个科目或知识。 而只有让AI能够meta learning,能够learning to learn,才有可能实现AGI!

6 理解AI-GA第一步:我们的宇宙,达尔文生物进化就是最好的AGI算法

因为我们人类就是显而易见的AGI,所以如果假设我们这个宇宙是高维生物创造出来的虚拟世界,那么他们成功了。

那么,我们是如何被创造出来的呢?

智慧是如何被创造出来的呢?

这么一个哲学性的问题或许放到春秋时代,放到古希腊也是一个常被讨论的问题。但是现在,我们可以有一个更科学性的解释(脑洞):

我们的宇宙自带一系列的初始化参数简称宇宙常数,然后通过大爆炸诞生各种星球进行演化。拓展一下,实际上有无数个不同宇宙常数的宇宙在同时进行大爆炸之后的演化。

在演化过程当中,由于有几乎无限的样本(星球),也就是对整个”文明“空间进行了无尽的探索,其中产生了地球这一个幸运儿,诞生了生命。而在生命的演化过程中,生命体的DNA自带了生存的本能(不以生存为本能的生物都被淘汰光了),因为留下了我们这样的智慧体,不断的提升文明水平,甚至现在在考虑创造智能来超越自己。

这就是natural evolution,而这是诞生AGI最自然的方式。总会有那么一个像地球这样的星球出现,能够产生智能,演化出高级文明。

实际上说到这,我们会越来越相信我们这个世界就是虚拟世界,就和Elon Musk相信的一样。我们不过是虚拟世界下演化过程中的尘埃而已。 宇宙常数不就是对应我们训练神经网络所用的超参吗?

也许另一个宇宙光速不是300000m/s,而是3000000m/s。

创造我们的高维生物具备一种几乎无限计算的能力来模拟整个宇宙演化的过程。

而反过来,假设我们有一天也具备了这种无限计算能力,我们或许也可以创造我们的宇宙,去演化里面的文明。

从这个角度看,我们是creature,创造我们的是meta-creature,而我们有一天也可以变成meta-creature。现在我们创造的虚拟世界可以说是一个简化版。以目前VR技术的发展,10年我相信我们将可以实现在VR中看到的和现实别无二致的效果,虚拟将不再是虚拟。

有人会有疑问:我们能拥有无限计算能力吗?

这个完全取决于这个宇宙的设定,如果这个宇宙有一个计算能力上限,那么我们就至多到那个上限。但我相信这个计算能力上限会几乎是无限的。 作为参考,让我们思考一下能量energy。

想象我们回到100年前,回到爱因斯坦发现相对论的1905年之前。

当时的人们能想象能量的极限在哪里?也许是水力,也许是煤炭。

然后,我们再想一下爱因斯坦发现E=mc2是一件多么疯狂的事情!

意味着一点点的质量都具有难以估量的能量。而这就是核能,就是原子弹产生的源头。

假如未来人类可以通过强相互作用力来获取能量,那么这个能量几乎是无限的了。

所以,当我们能够获取无限的计算能力的时候,我们也就可以变成meta-creature。(我觉得这是一个比God上帝高级的多的词汇)

7 理解AI-GA:Meta Learning是关键

现在我们可以来理解AI-GA了。

AI-GA 的三个部分:

- meta-learning architectures (Meta Learning 神经网络结构,即AutoML)

- meta-learning the learning algorithms themselves (即现在常说的Meta Learning)

- generating effective learning environments (生成有效的学习环境)

首先AI-GA是完全基于神经网络的,其次AI-GA的核心思想在于meta learning的inner loop内循环是完全自学习的,没有任何的inductive bias或者说先验知识。

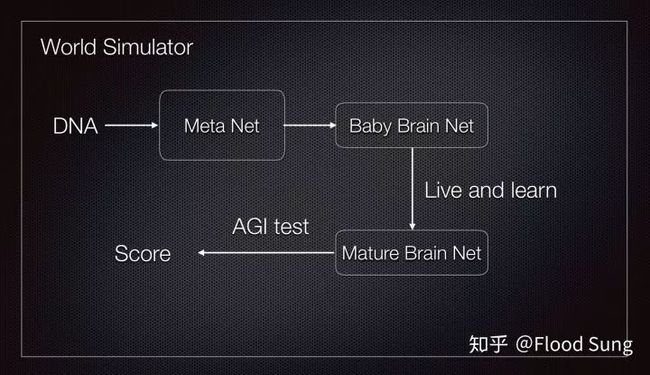

我们就想象一下我们构造了一个婴儿大脑的神经网络,然后通过生活和学习慢慢成长为成熟的大脑。我们现在要meta learning这个婴儿大脑。而这个所谓的”婴儿大脑“就需要包括Jeff Clune提到两个部分:

我们就想象一下我们构造了一个婴儿大脑的神经网络,然后通过生活和学习慢慢成长为成熟的大脑。我们现在要meta learning这个婴儿大脑。而这个所谓的”婴儿大脑“就需要包括Jeff Clune提到两个部分:

大脑的神经网络结构

大脑内部的神经网络参数具备学会学习的能力

所以我们需要能够meta learning这两部分。

第一部分其实就是现在最火的AutoML (NAS)神经网络结构搜索,用神经网络自动的寻找一个最优的网络结构。所以称为meta learning architectures更合适。

第二部分就是现在一样最火的meta learning,学习算法本身。

但是现在不管是第一部分还有第二部分还是too young,为什么这么说?

- 现在的AutoML搜索的网络结构依然只是前向传播的连接方式,而人类的大脑恐怕不是这样。AutoML能够自动构建带memory的神经网络呢?AutoML能构造出比LSTM更好的网络结构吗?AutoML能构造出带feedback的网络结构吗?

- 现在的meta reinforcement learning,并不能处理超长的sequence,MAML做n次梯度将没有意义。使用evolution的做法正如前面分析宇宙发现的问题,需要巨量的算力,目前还远远达不到。

然后Jeff Clune还提出了第三部分,我们需要为训练这个meta learning agent构建合适的训练环境。我们还无法创造宇宙,我们还不具备无限的算力。要创造AGI,我们需要针对性的创建适合的训练环境。这是一个大问题,也确实是比较少人涉及的研究问题。Jeff Clune他们倒是研究了一下,提出了POET,还挺有意思的:

POET: Endlessly Generating Increasingly Complex and Diverse Learning Environments and their Solutions through the Paired Open-Ended Trailblazer(https://eng.uber.com/poet-open-ended-deep-learning/)

但是要创造AGI,这样的环境显然是远远不够的。Jeff Clune呼吁更多的研究者研究一下这一部分。

说到这里AI-GA已经理解完成了。AI-GA需要两个loop:一个outer loop和inner loop。我们可以把outer loop对比为多重宇宙及无数的星球,而inner loop就是星球上生物的演化。我们需要构建化两个loop,从而实现AGI!Jeff Clune说的前两部分都是inner loop,而第三部分是outer loop。我们可以使用任何方法包括evolution或drl的方法来训练inner loop。

8 理解AI-GA:意义是什么?

是的,不得不承认,AGI要实现还需要很长的一段路。

但是,我们要看到,我们比图灵说的具体化太多了。

我们有了具体的实现方式,Jeff Clune说的每一部分都是现在实实在在的,目前学术界最火爆的研究问题。

人工智能的发展过程中走了很多的弯路(当然我们可以认为这是一种探索exploration),而现在,我们确定了方向,并且这个方向是正确的可能性极高,我们在这个方向下还有很多值得研究,就如我在前面指出来的automl和metarl的问题。如果你打算创造AGI,那么你就应该朝这些方向去努力。

9 结语

AI-GA大概就像E=mc2一样,虽然远远达不到E=mc2的宇宙真理级,但AI-GA指明了发展AGI的方向,而实现AGI的意义在我看来比E=mc2的大得多,因为有了AGI,我们就可以利用AGI来发现更多的宇宙理论。这里不得不考虑一下伦理问题,安全问题,AGI实现了人类会不会毁灭的问题。这和E=mc2是一样的,E=mc2使人类进入了核时代,核能既可以创造能源,也可以是足够毁灭人类的核弹。但是核弹被创造出来,人类还没毁灭,这靠着我们人类每一个人的生物本能------活着!而这就够了,在活着这件事上所有人类不分种族都一样。相信AGI的出现将使人类进入宇宙文明的篇章!

原文链接:https://zhuanlan.zhihu.com/p/74813776

(*本文为 AI科技大本营转载文章,转载请联系作者)

◆

精彩推荐

◆

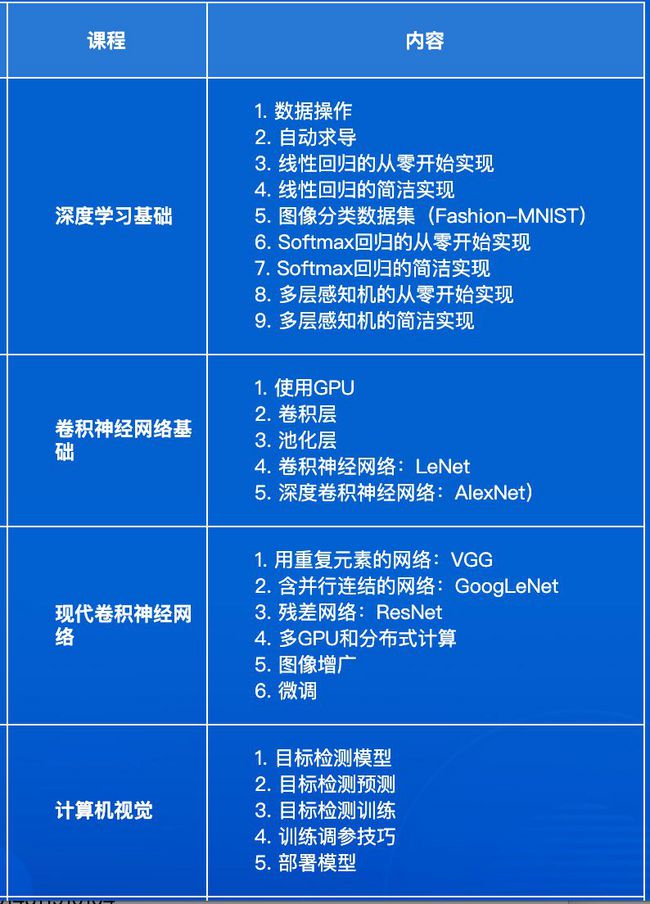

AI ProCon 2019 邀请到了亚马逊首席科学家@李沐,在大会的前一天(9.5)亲授「深度学习实训营」 ,通过动手实操,帮助开发者全面了解深度学习的基础知识和开发技巧。

距离「培训+会议」优惠票 2149 元 (3.5折) 限时抢购结束 仅剩 1 天 ,扫描下方二维码购票,即享折扣。

3.5 折最后倒计时 1 天,8 月 12 日将开启 5 折票

社群福利

扫码添加小助手,回复:大会,加入2019 AI开发者大会福利群,每周一、三、五 更新学习资源、技术福利,还有抽奖活动~

推荐阅读

1万+字原创读书笔记,机器学习的知识点全在这篇文章里了

开源之战

别再造假数据了,来试试Faker这个库吧!

国外大神制作的超棒NumPy可视化教程

突发!Python再次第一,Java和C下降,凭什么?

白话中台战略:中台是个什么鬼?

伟创力回应扣押华为物资;谷歌更新图片界面;Python 3.8.0b3 发布 | 极客头条

沃尔玛也要发币了,Libra忙活半天为他人做了嫁衣?

知名饮料制造商股价暴涨500%惊动FBI,只因在名字中加入了"区块链" ?