- Lua嵌入式爬虫实现步骤

q56731523

lua爬虫开发语言r语言

在Lua中实现嵌入式爬虫,通俗点说就是指在一个宿主程序(如Nginx/OpenResty、Redis等)中使用Lua脚本来完成网络爬取任务。由于Lua本身的标准库并不包含网络请求功能,因此我们需要依赖宿主环境提供的网络库。在Lua中实现嵌入式爬虫通常指在资源受限环境(如OpenResty/Nginx、Redis、IoT设备)中运行的轻量级网络爬取工具。以下是关键实现方案和示例:核心方案:基于Ope

- OKHttp框架

一个快乐的小测试

自动化测试okhttpandroidjava自动化

一、OKHttp简介初识OKHttpOkHttp是一个处理网络请求的开源项目,是Android端一个较新的轻量级网络框架,支持HTTP/HTTPS协议、请求头设置、响应解析等功能,并且支持异步调用,因此在接口测试中也是一种非常优秀的选择。OkHttp是一个高效的HTTP客户端,其特性包括:支持HTTP/2,并且允许同一个主机地址的所有请求共享同一个socket连接,这样能减少服务器的请求次数通过连

- 轻量级行人属性识别算法设计

pk_xz123456

深度学习算法算法人工智能

轻量级行人属性识别算法设计一、算法框架设计我们提出一种基于注意力机制与特征解耦的轻量级网络(ALFD-Net),整体架构包含三个核心模块:importtorchimporttorch.nnasnnfromtorchvision.modelsimportmobilenet_v3_smallclassALFD_Net(nn.Module):def__init__(self,num_attributes

- ResNet改进(30):融合MobileNet和ResNet的轻量级网络设计

点我头像干啥

ResNet改进【有效涨点!】网络人工智能神经网络python

在深度学习领域,模型架构的创新往往能带来性能的显著提升。今天我将介绍一种结合了MobileNet和ResNet优势的混合架构——ResNetWithMobileNet,这是一种既保持了残差连接优势又具有轻量级特性的网络设计。整体结构设计核心组件解析1.DepthwiseSeparableConvolution(深度可分离卷积)深度可分离卷积是MobileNet的核心创新,它将标准卷积分解为两个步骤

- 网络流量可视化分析平台-流影-FlowShadow

hackoffice

系统搭建网络安全解决方案网络安全网络安全

专注于网络行为分析识别和威胁行为追溯挖掘提供轻量级网络行为可视化分析与安全态势感知综合解决方案适用于入侵检测、攻防演练、威胁狩猎、网络安全态势感知等应用场景看清网络通讯、看见网络行为、看懂网络威胁,守护每一位用户数字化安全发展之路国内首个开源网络流量可视化分析平台流影:--开源网络流量可视化分析平台

- 实现一个超轻量级实例分割网络的思路

CV工程师小朱

深度学习笔记深度学习应用实例分割yolactpicodet深度学习

文章目录前言一、基本思路二、picodet三、yolact三、picodet+yolact总结前言在某些工业领域,由于成本问题算力有限,只能实时跑一些超轻量级网络,拿目标检测来说,例如yolo-fast,pp-picodet这些。如果要跑实例分割,目前好像没有什么超轻量级的网络。所以就有想法如何实现一个超轻量级实例分割网络。一、基本思路基于超轻量级目标检测pp-picodet,增加一个掩膜分支。参

- 探秘 Mininet:解锁网络仿真与 SDN 开发的密码

漫谈网络

网络技术进阶通途网络mininetsdn

Mininet是一个轻量级网络仿真工具,常用于SDN(软件定义网络)开发、网络协议测试和拓扑实验。以下是典型命令解释,以及Mininet的核心使用方法和常见指令场景:一、典型命令解析sudomn--controller=remote,ip=127.0.0.1,port=6633--switchovsk,protocols=OpenFlow13--mac--controller=remote:指定使

- 轻量级网络设计原理与代码实战案例讲解

AI天才研究院

AI大模型企业级应用开发实战DeepSeekR1&大数据AI人工智能大模型计算计算科学神经计算深度学习神经网络大数据人工智能大型语言模型AIAGILLMJavaPython架构设计AgentRPA

轻量级网络设计原理与代码实战案例讲解作者:禅与计算机程序设计艺术/ZenandtheArtofComputerProgramming1.背景介绍1.1问题的由来随着深度学习在各个领域的广泛应用,神经网络模型变得越来越庞大和复杂。然而,大规模模型在计算资源、存储空间以及推理速度方面提出了更高的要求,这在移动设备、嵌入式系统等资源受限的环境中尤为明显。为了解决这一问题,轻量级网络设计应运而生。1.2研

- 轻量级的注意力网络(LANMSFF)模型详解及代码复现

清风AI

深度学习算法详解及代码复现深度学习人工智能神经网络python计算机视觉

定义与特点在深度学习领域,轻量化网络设计已成为一个重要的研究方向。LANMSFF模型作为一种新型的轻量级网络架构,在保持高性能的同时,显著降低了模型的复杂度。LANMSFF模型的核心特点可以概括为以下几个方面:轻量级设计:通过精心设计的网络结构和参数优化,在保持较高性能的同时,显著降低了模型的复杂度。注意力机制:引入了一种新的注意力机制,能够有效地捕捉图像中的关键特征,提高模型的表达能力。多尺度特

- Python从0到100(八十六):神经网络-ShuffleNet通道混合轻量级网络的深入介绍

是Dream呀

Pythonpython神经网络网络

前言:零基础学Python:Python从0到100最新最全教程。想做这件事情很久了,这次我更新了自己所写过的所有博客,汇集成了Python从0到100,共一百节课,帮助大家一个月时间里从零基础到学习Python基础语法、Python爬虫、Web开发、计算机视觉、机器学习、神经网络以及人工智能相关知识,成为学习学习和学业的先行者!欢迎大家订阅专栏:零基础学Python:Python从0到100最新

- 轻量级网络应用 服务生活

MhZhou0412

生活

LostNet:AsmartwayforlostandfindMeihuaZhou,IvanFung,LiYang,NanWan,KekeDi,TingtingWangDuetotheenormouspopulationgrowthofcitiesinrecentyears,objectsarefrequentlylostandunclaimedonpublictransportation,inr

- YOLOv8改进 更换轻量级网络结构

学yolo的小白

UpgradeYOLOv8进阶YOLO目标检测深度学习

一、GhostNet论文论文地址:1911.11907.pdf(arxiv.org)二、GhostNet结构GhostNet是一种高效的目标检测网络,具有较低的计算复杂度和较高的准确性。该网络采用了轻量级的架构,可以在计算资源有限的设备上运行,并能够快速地实时检测图像中的目标物体。GhostNet基于MobileNetV3的设计思路,采用了Ghost模块来减少网络参数数量,从而减少计算量并提高模型

- 图像分类】【深度学习】【轻量级网络】【Pytorch版本】EfficientNet_V2模型算法详解

牙牙要健康

深度学习算法分类

【图像分类】【深度学习】【轻量级网络】【Pytorch版本】EfficientNet_V2模型算法详解文章目录【图像分类】【深度学习】【轻量级网络】【Pytorch版本】EfficientNet_V2模型算法详解前言EfficientNet_V2讲解自适应正则化的渐进学习(ProgressiveLearningwithadaptiveRegularization)EfficientNet_V2的模

- 3.2 ThunderNet思考

深度学习模型优化

1设计思想ThunderNet的优化目标是二阶段检测器中计算开销大的结构。在backbone部分,设计了轻量级网络SNet;在detection部分,借鉴Light-HeadR-CNN的思路,并进一步压缩RPN和R-CNN子网络。为了避免性能的衰退,设计了2个高效的结构CEM和SAM来改善性能。2网络架构图1ThunderNet网络架构ThunderNet的输入是分辨率的图像。Backbone部分

- 【图像分类】【深度学习】【轻量级网络】【Pytorch版本】EfficientNet_V1模型算法详解

牙牙要健康

图像分类深度学习轻量级网络深度学习算法分类

【图像分类】【深度学习】【轻量级网络】【Pytorch版本】EfficientNet_V1模型算法详解文章目录【图像分类】【深度学习】【轻量级网络】【Pytorch版本】EfficientNet_V1模型算法详解前言EfficientNet_V1讲解问题辨析(ProblemFormulation)缩放尺寸(ScalingDimensions)复合缩放(CompoundScaling)Efficie

- Coap在Andorid中的简单应用

秦汉春秋

AndroidJavacaliforniumcoap广播

Andlink设备使用了Coap来进行配网和一定的数据交互,因此记录一下。Coap协议Coap可以简单理解为是为了在物联网场景下实现web功能而产生的一种轻量级网络协议;主要特点有使用UDP方式传输以及基于REST等。coap协议的服务地址和http的url类似:coap://192.168.52.101:5683/qlink/request也同样接收POST/GET/PUT/DELETE等请求;

- 暗光增强——Zero-DCE网络推理测试

佐咖

暗光增强增强现实

目录一、Zero-DCE方法1.1网络优点1.2网络适用场景1.3网络不适用场景二、源码包三、测试四、测试结果五、推理速度六、总结一、Zero-DCE方法Zero-DCE(Zero-ReferenceDeepCurveEstimation)是一种用于低光照增强的网络。1.1网络优点无需参考数据:Zero-DCE不需要任何配对或非配对的数据进行训练,这避免了过拟合的风险。轻量级网络:Zero-DCE

- 【图像分类】【深度学习】【轻量级网络】【Pytorch版本】ShuffleNet_V2模型算法详解

牙牙要健康

图像分类深度学习轻量级网络深度学习算法分类

【图像分类】【深度学习】【轻量级网络】【Pytorch版本】ShuffleNet_V2模型算法详解文章目录【图像分类】【深度学习】【轻量级网络】【Pytorch版本】ShuffleNet_V2模型算法详解前言ShuffleNet_V2讲解四条实用指导思想G1:相等的通道宽度可以降低存储访问成本G2:大量的分组卷积数量会增加存储访问G3:网络碎片化会降低并行度G4:元素级操作是不可忽略的Shuffl

- 【图像分类】【深度学习】【轻量级网络】【Pytorch版本】ShuffleNet_V1模型算法详解

牙牙要健康

图像分类深度学习轻量级网络深度学习算法分类

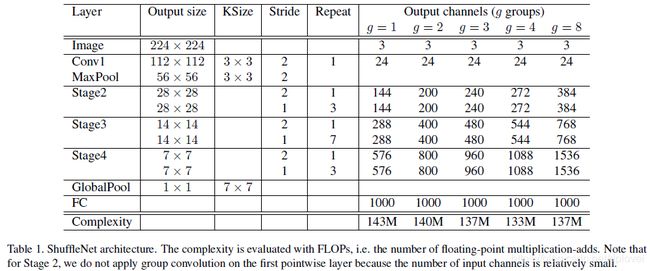

【图像分类】【深度学习】【轻量级网络】【Pytorch版本】ShuffleNet_V1模型算法详解文章目录【图像分类】【深度学习】【轻量级网络】【Pytorch版本】ShuffleNet_V1模型算法详解前言ShuffleNet_V1讲解groupconvolution(分组卷积)ChannelShuffle(通道混洗)ShuffleNetUint(ShuffleNet基础单元)ShuffleNe

- 【目标检测实验系列】YOLOv5创新点改进:融合高效轻量级网络结构GSConv,减轻模型复杂度的同时保持检测精度!(内含源代码,超详细改进代码流程)

弗兰随风小欢

目标检测实验系列目标检测YOLO人工智能YOLOv5GSConvSCI论文计算机视觉

自我介绍:本人硕士期间全程放养,目前成果:一篇北大核心CSCD录用,两篇中科院三区已见刊,一篇中科院三区在投。如何找创新点,如何放养过程厚积薄发,如何写中英论文,找期刊等等。本人后续会以自己实战经验详细写出来,还请大家能够点个关注和赞,收藏一下,谢谢大家1.文章主要内容本篇博客主要涉及将GSConv融合到YOLOv5模型中。通过GSConv替换普通的卷积结构,减轻模型复杂度的同时保持检测精度。(通

- CoordAttention解读

周先森爱吃素

论文解读CoordAttention

简介在轻量级网络上的研究表明,通道注意力会给模型带来比较显著的性能提升,但是通道注意力通常会忽略对生成空间选择性注意力图非常重要的位置信息。因此,新加坡国立大学的QibinHou等人提出了一种为轻量级网络设计的新的注意力机制,该机制将位置信息嵌入到了通道注意力中,称为coordinateattention(简称CoordAttention,下文也称CA),该论文已被CVPR2021收录。不同于通道

- 【图像分类】【深度学习】【轻量级网络】【Pytorch版本】MobileNets_V3模型算法详解

牙牙要健康

图像分类深度学习轻量级网络深度学习算法分类

【图像分类】【深度学习】【轻量级网络】【Pytorch版本】MobileNets_V3模型算法详解文章目录【图像分类】【深度学习】【轻量级网络】【Pytorch版本】MobileNets_V3模型算法详解前言MobleNet_V3讲解SE模块(SqueezeExcitation)重新设计激活函数反向残差结构(InvertedResiduals)重新设计耗时层结构MobleNet_V3模型结构Mob

- 图像识别经典轻量级网络模型总结梳理、原理解析与优劣对比分析

Together_CZ

网络深度学习人工智能

在前面的很多博文中,我们不止一次提到过,在实际业务项目开发过程中,我们会经常使用到轻量级的网络模型,本文主要是总结梳理前面经常使用到的一些轻量级的图像识别模型。【MobileNetv1】MobileNetv1是一种轻量级的卷积神经网络(CNN)架构,由Google团队在2017年提出。它的设计初衷是为了在移动设备上实现高性能的图像识别和物体检测任务,同时降低模型的计算量和内存占用。MobileNe

- 轻量级网络结构的目标检测算法——Yolov8介绍

LittroInno

目标跟踪人工智能计算机视觉yolov8

1.Yolov8算法概述Yolov8是一种目标检测算法,它通过独特的双路径预测和紧密的连接的卷积网络进行目标检测。该算法采用了轻量级网络结构,同时保持了较高的性能,因此具有高效的特点。此外,Yolov8还采用了级联和金字塔的思想,使算法能够处理不同大小的目标。在Yolov8中,目标检测任务被分解为两个独立的子任务,即分类和定位。每个子任务都有自己的网络路径,这使得算法能够更好地处理不同大小的目标。

- 阅读笔记 | Edge-Cloud Polarization and Collaboration: A Comprehensive Survey for AI

一条独龙

笔记笔记edge人工智能

内容概要这篇是一篇综述性文章,主要关于云计算、边缘计算以及边云协同计算在人工智能方面的进展。论文的主要内容如下:云计算AI:讨论了用于云计算的CPU、GPU、TPU和DPU等硬件。介绍了计算机视觉、自然语言处理和网络服务等领域基于云计算的AI模型。边缘计算AI:概述了用于边缘计算的VPU、边缘TPU、移动GPU和神经处理单元等硬件。探讨了轻量级网络架构设计、模型压缩等技术来满足边缘计算的限制。边缘

- Android使用Okhttp进行数据交互

全栈开发Dream

前言在遇到Android数据交互的情况时,思考过采取什么方式,在经过一段时间的学习,最终采取Okhttp这一个轻量级网络框架。1、工具类实现publicclassOkHttpUtil{publicfinalstaticStringTAG="OkHttpUtil";publicfinalstaticintCONNECT_TIMEOUT=60;publicfinalstaticintREAD_TIME

- 轻量级网络之mobilenet v1

GEETEST极验

论文分享萝卜兔编辑整理卷积神经网络广泛应用在各种任务,比如图像分类、目标检测等,性能也越来越好,但都趋向于使用更深更复杂的结构来提升性能而不太关注计算代价,使得将这些模型直接部署在移动设备困难重重。本文针对传统卷积计算量大的缺点,对传统卷积模块进行了改进,该结构更高效,为在移动设备上部署带来了可能。RooflineModel在介绍具体的原理之前,我们先来与模型计算性能相关的几个概念:(1)计算量:

- CGNet: A Light-weight Context Guided Network for Semantic Segmentation

顾北向南

论文地址:https://arxiv.org/pdf/1811.08201代码地址:https://github.com/wutianyiRosun/CGNet1.摘要本文提出了一种新颖的上下文引导网络(CGNet),它是一种用于移动设备语义分割的轻量级网络。我们首先提出了ContextGuided(CG)块,它学习了局部特征和周围环境的联合特征,并进一步改善了与全局背景的联合特征。基于CG块,我

- 【图像分类】【深度学习】【轻量级网络】【Pytorch版本】MobileNets_V2模型算法详解

牙牙要健康

图像分类轻量级网络深度学习深度学习算法分类

【图像分类】【深度学习】【轻量级网络】【Pytorch版本】MobileNets_V2模型算法详解文章目录【图像分类】【深度学习】【轻量级网络】【Pytorch版本】MobileNets_V2模型算法详解前言MobleNet_V2讲解反向残差结构(InvertedResiduals)兴趣流形(Manifoldofinterest)线性瓶颈层(LinearBottlenecks)MobleNet_V

- 图像分类(七) 全面解读复现ShuffleNetV1-V2

小酒馆燃着灯

图像分类机器学习深度学习分类人工智能python机器学习深度学习算法

ShuffleNetV1前言前面我们学了MobileNetV1-3,从这篇开始我们学习ShuffleNet系列。ShuffleNet是Face++(旷视)在2017年发布的一个高效率可以运行在手机等移动设备的网络结构,论文发表在CVRP2018上。这个新的轻量级网络使用了两个新的操作:pointwisegroupconvolution和channelshuffle,在保持精度的同时大大降低计算成本

- Enum用法

不懂事的小屁孩

enum

以前的时候知道enum,但是真心不怎么用,在实际开发中,经常会用到以下代码:

protected final static String XJ = "XJ";

protected final static String YHK = "YHK";

protected final static String PQ = "PQ";

- 【Spark九十七】RDD API之aggregateByKey

bit1129

spark

1. aggregateByKey的运行机制

/**

* Aggregate the values of each key, using given combine functions and a neutral "zero value".

* This function can return a different result type

- hive创建表是报错: Specified key was too long; max key length is 767 bytes

daizj

hive

今天在hive客户端创建表时报错,具体操作如下

hive> create table test2(id string);

FAILED: Execution Error, return code 1 from org.apache.hadoop.hive.ql.exec.DDLTask. MetaException(message:javax.jdo.JDODataSto

- Map 与 JavaBean之间的转换

周凡杨

java自省转换反射

最近项目里需要一个工具类,它的功能是传入一个Map后可以返回一个JavaBean对象。很喜欢写这样的Java服务,首先我想到的是要通过Java 的反射去实现匿名类的方法调用,这样才可以把Map里的值set 到JavaBean里。其实这里用Java的自省会更方便,下面两个方法就是一个通过反射,一个通过自省来实现本功能。

1:JavaBean类

1 &nb

- java连接ftp下载

g21121

java

有的时候需要用到java连接ftp服务器下载,上传一些操作,下面写了一个小例子。

/** ftp服务器地址 */

private String ftpHost;

/** ftp服务器用户名 */

private String ftpName;

/** ftp服务器密码 */

private String ftpPass;

/** ftp根目录 */

private String f

- web报表工具FineReport使用中遇到的常见报错及解决办法(二)

老A不折腾

finereportweb报表java报表总结

抛砖引玉,希望大家能把自己整理的问题及解决方法晾出来,Mark一下,利人利己。

出现问题先搜一下文档上有没有,再看看度娘有没有,再看看论坛有没有。有报错要看日志。下面简单罗列下常见的问题,大多文档上都有提到的。

1、没有返回数据集:

在存储过程中的操作语句之前加上set nocount on 或者在数据集exec调用存储过程的前面加上这句。当S

- linux 系统cpu 内存等信息查看

墙头上一根草

cpu内存liunx

1 查看CPU

1.1 查看CPU个数

# cat /proc/cpuinfo | grep "physical id" | uniq | wc -l

2

**uniq命令:删除重复行;wc –l命令:统计行数**

1.2 查看CPU核数

# cat /proc/cpuinfo | grep "cpu cores" | u

- Spring中的AOP

aijuans

springAOP

Spring中的AOP

Written by Tony Jiang @ 2012-1-18 (转)何为AOP

AOP,面向切面编程。

在不改动代码的前提下,灵活的在现有代码的执行顺序前后,添加进新规机能。

来一个简单的Sample:

目标类:

[java]

view plain

copy

print

?

package&nb

- placeholder(HTML 5) IE 兼容插件

alxw4616

JavaScriptjquery jQuery插件

placeholder 这个属性被越来越频繁的使用.

但为做HTML 5 特性IE没能实现这东西.

以下的jQuery插件就是用来在IE上实现该属性的.

/**

* [placeholder(HTML 5) IE 实现.IE9以下通过测试.]

* v 1.0 by oTwo 2014年7月31日 11:45:29

*/

$.fn.placeholder = function

- Object类,值域,泛型等总结(适合有基础的人看)

百合不是茶

泛型的继承和通配符变量的值域Object类转换

java的作用域在编程的时候经常会遇到,而我经常会搞不清楚这个

问题,所以在家的这几天回忆一下过去不知道的每个小知识点

变量的值域;

package 基础;

/**

* 作用域的范围

*

* @author Administrator

*

*/

public class zuoyongyu {

public static vo

- JDK1.5 Condition接口

bijian1013

javathreadConditionjava多线程

Condition 将 Object 监视器方法(wait、notify和 notifyAll)分解成截然不同的对象,以便通过将这些对象与任意 Lock 实现组合使用,为每个对象提供多个等待 set (wait-set)。其中,Lock 替代了 synchronized 方法和语句的使用,Condition 替代了 Object 监视器方法的使用。

条件(也称为条件队列或条件变量)为线程提供了一

- 开源中国OSC源创会记录

bijian1013

hadoopsparkMemSQL

一.Strata+Hadoop World(SHW)大会

是全世界最大的大数据大会之一。SHW大会为各种技术提供了深度交流的机会,还会看到最领先的大数据技术、最广泛的应用场景、最有趣的用例教学以及最全面的大数据行业和趋势探讨。

二.Hadoop

&nbs

- 【Java范型七】范型消除

bit1129

java

范型是Java1.5引入的语言特性,它是编译时的一个语法现象,也就是说,对于一个类,不管是范型类还是非范型类,编译得到的字节码是一样的,差别仅在于通过范型这种语法来进行编译时的类型检查,在运行时是没有范型或者类型参数这个说法的。

范型跟反射刚好相反,反射是一种运行时行为,所以编译时不能访问的变量或者方法(比如private),在运行时通过反射是可以访问的,也就是说,可见性也是一种编译时的行为,在

- 【Spark九十四】spark-sql工具的使用

bit1129

spark

spark-sql是Spark bin目录下的一个可执行脚本,它的目的是通过这个脚本执行Hive的命令,即原来通过

hive>输入的指令可以通过spark-sql>输入的指令来完成。

spark-sql可以使用内置的Hive metadata-store,也可以使用已经独立安装的Hive的metadata store

关于Hive build into Spark

- js做的各种倒计时

ronin47

js 倒计时

第一种:精确到秒的javascript倒计时代码

HTML代码:

<form name="form1">

<div align="center" align="middle"

- java-37.有n 个长为m+1 的字符串,如果某个字符串的最后m 个字符与某个字符串的前m 个字符匹配,则两个字符串可以联接

bylijinnan

java

public class MaxCatenate {

/*

* Q.37 有n 个长为m+1 的字符串,如果某个字符串的最后m 个字符与某个字符串的前m 个字符匹配,则两个字符串可以联接,

* 问这n 个字符串最多可以连成一个多长的字符串,如果出现循环,则返回错误。

*/

public static void main(String[] args){

- mongoDB安装

开窍的石头

mongodb安装 基本操作

mongoDB的安装

1:mongoDB下载 https://www.mongodb.org/downloads

2:下载mongoDB下载后解压

- [开源项目]引擎的关键意义

comsci

开源项目

一个系统,最核心的东西就是引擎。。。。。

而要设计和制造出引擎,最关键的是要坚持。。。。。。

现在最先进的引擎技术,也是从莱特兄弟那里出现的,但是中间一直没有断过研发的

- 软件度量的一些方法

cuiyadll

方法

软件度量的一些方法http://cuiyingfeng.blog.51cto.com/43841/6775/在前面我们已介绍了组成软件度量的几个方面。在这里我们将先给出关于这几个方面的一个纲要介绍。在后面我们还会作进一步具体的阐述。当我们不从高层次的概念级来看软件度量及其目标的时候,我们很容易把这些活动看成是不同而且毫不相干的。我们现在希望表明他们是怎样恰如其分地嵌入我们的框架的。也就是我们度量的

- XSD中的targetNameSpace解释

darrenzhu

xmlnamespacexsdtargetnamespace

参考链接:

http://blog.csdn.net/colin1014/article/details/357694

xsd文件中定义了一个targetNameSpace后,其内部定义的元素,属性,类型等都属于该targetNameSpace,其自身或外部xsd文件使用这些元素,属性等都必须从定义的targetNameSpace中找:

例如:以下xsd文件,就出现了该错误,即便是在一

- 什么是RAID0、RAID1、RAID0+1、RAID5,等磁盘阵列模式?

dcj3sjt126com

raid

RAID 1又称为Mirror或Mirroring,它的宗旨是最大限度的保证用户数据的可用性和可修复性。 RAID 1的操作方式是把用户写入硬盘的数据百分之百地自动复制到另外一个硬盘上。由于对存储的数据进行百分之百的备份,在所有RAID级别中,RAID 1提供最高的数据安全保障。同样,由于数据的百分之百备份,备份数据占了总存储空间的一半,因而,Mirror的磁盘空间利用率低,存储成本高。

Mir

- yii2 restful web服务快速入门

dcj3sjt126com

PHPyii2

快速入门

Yii 提供了一整套用来简化实现 RESTful 风格的 Web Service 服务的 API。 特别是,Yii 支持以下关于 RESTful 风格的 API:

支持 Active Record 类的通用API的快速原型

涉及的响应格式(在默认情况下支持 JSON 和 XML)

支持可选输出字段的定制对象序列化

适当的格式的数据采集和验证错误

- MongoDB查询(3)——内嵌文档查询(七)

eksliang

MongoDB查询内嵌文档MongoDB查询内嵌数组

MongoDB查询内嵌文档

转载请出自出处:http://eksliang.iteye.com/blog/2177301 一、概述

有两种方法可以查询内嵌文档:查询整个文档;针对键值对进行查询。这两种方式是不同的,下面我通过例子进行分别说明。

二、查询整个文档

例如:有如下文档

db.emp.insert({

&qu

- android4.4从系统图库无法加载图片的问题

gundumw100

android

典型的使用场景就是要设置一个头像,头像需要从系统图库或者拍照获得,在android4.4之前,我用的代码没问题,但是今天使用android4.4的时候突然发现不灵了。baidu了一圈,终于解决了。

下面是解决方案:

private String[] items = new String[] { "图库","拍照" };

/* 头像名称 */

- 网页特效大全 jQuery等

ini

JavaScriptjquerycsshtml5ini

HTML5和CSS3知识和特效

asp.net ajax jquery实例

分享一个下雪的特效

jQuery倾斜的动画导航菜单

选美大赛示例 你会选谁

jQuery实现HTML5时钟

功能强大的滚动播放插件JQ-Slide

万圣节快乐!!!

向上弹出菜单jQuery插件

htm5视差动画

jquery将列表倒转顺序

推荐一个jQuery分页插件

jquery animate

- swift objc_setAssociatedObject block(version1.2 xcode6.4)

啸笑天

version

import UIKit

class LSObjectWrapper: NSObject {

let value: ((barButton: UIButton?) -> Void)?

init(value: (barButton: UIButton?) -> Void) {

self.value = value

- Aegis 默认的 Xfire 绑定方式,将 XML 映射为 POJO

MagicMa_007

javaPOJOxmlAegisxfire

Aegis 是一个默认的 Xfire 绑定方式,它将 XML 映射为 POJO, 支持代码先行的开发.你开发服 务类与 POJO,它为你生成 XML schema/wsdl

XML 和 注解映射概览

默认情况下,你的 POJO 类被是基于他们的名字与命名空间被序列化。如果

- js get max value in (json) Array

qiaolevip

每天进步一点点学习永无止境max纵观千象

// Max value in Array

var arr = [1,2,3,5,3,2];Math.max.apply(null, arr); // 5

// Max value in Jaon Array

var arr = [{"x":"8/11/2009","y":0.026572007},{"x"

- XMLhttpRequest 请求 XML,JSON ,POJO 数据

Luob.

POJOjsonAjaxxmlXMLhttpREquest

在使用XMlhttpRequest对象发送请求和响应之前,必须首先使用javaScript对象创建一个XMLHttpRquest对象。

var xmlhttp;

function getXMLHttpRequest(){

if(window.ActiveXObject){

xmlhttp:new ActiveXObject("Microsoft.XMLHTTP

- jquery

wuai

jquery

以下防止文档在完全加载之前运行Jquery代码,否则会出现试图隐藏一个不存在的元素、获得未完全加载的图像的大小 等等

$(document).ready(function(){

jquery代码;

});

<script type="text/javascript" src="c:/scripts/jquery-1.4.2.min.js&quo