- 强化学习中的深度卷积神经网络设计与应用实例

数字扫地僧

计算机视觉cnn人工智能神经网络

I.引言强化学习(ReinforcementLearning,RL)是机器学习的一个重要分支,通过与环境的交互来学习最优策略。深度学习,特别是深度卷积神经网络(DeepConvolutionalNeuralNetworks,DCNNs)的引入,为强化学习在处理高维度数据方面提供了强大工具。本文将探讨强化学习中深度卷积神经网络的设计原则及其在不同应用场景中的实例。II.深度卷积神经网络在强化学习中的

- 【深度学习】 PyTorch一文详解

Nerous_

深度学习深度学习pytorch人工智能机器学习python

“PyTorchisadeeplearningframeworkthatprioritizessimplicityandflexibility,makingitthego-tochoiceforbothresearchersanddevelopers.”—Anonymous1.PyTorch简介1.1PyTorch的背景与发展PyTorch是由Facebook人工智能研究院(FAIR)开发的一个开

- Linux学习1_Linux命令及英文全称

Wang_Zhenwei

—Linux转载linux

LinuxCommandreferences(命令全称,方便记忆)aliasCreateyourownnameforacommandarchprintmachinearchitectureashashcommandinterpreter(shell)awk(gawk)patternscanningandprocessinglanguagebasenameRemovedirectoryandsuff

- CVPR 2024 | 低分辨率引领方向:通过自监督学习提升超分辨率的泛化能力

小白学视觉

计算机顶会顶刊论文解读计算机视觉深度学习CVPR计算机顶会论文解读

论文信息题目:Low-ResLeadstheWay:ImprovingGeneralizationforSuper-ResolutionbySelf-SupervisedLearning低分辨率引领方向:通过自监督学习提升超分辨率的泛化能力作者:HaoyuChen,WenboLi,JinjinGu,JingjingRen,HaozeSun,XueyiZou,ZhensongZhang,Youlia

- ACI EP Learning Whitepaper 1. ACI EP组件

m0_54931486

思科ACI网络思科ACIEndpointACIfabricNexusEP学习

1.ACIEndpointACI网络架构的Endpoint表整合了传统MAC地址表和ARP表的功能。其核心机制是通过硬件层直接学习数据包的源MAC地址与IP地址映射关系,摒弃了传统ARP协议依赖广播请求获取下一跳MAC地址的模式。这种设计优化体现在两方面:1)减少控制面ARP流量处理带来的资源消耗;2)基于终端实际流量即可实时感知主机IP/MAC地址的拓扑迁移,无需依赖GARP通告即可实现终端移动

- 机器学习课堂4线性回归模型+特征缩放

木尘152132

机器学习线性回归python

一、实验2-2,线性回归模型,计算模型在训练数据集和测试数据集上的均方根误差代码:#2-2线性回归模型importpandasaspdimportnumpyasnpimportmatplotlib.pyplotasplt#参数设置iterations=3000#迭代次数learning_rate=0.0001#学习率m_train=3000#训练样本的数量flag_plot_lines=False

- Virtual Machine Platform is not enabled. Enable it using the following PowerShell script (in an admi

朋也透william

docker

DockerDesktop安装指南以及Windows下WSL2和Hyper-V相关问题追查-寂寞姜大虎-博客园(cnblogs.com)https://www.cnblogs.com/qfl-blog/p/18200575

- 部分标签数据集生成与过滤特定标签方法

阳光明媚大男孩

机器学习人工智能

完整代码总结这段代码的目的是通过构建一个部分标签学习(PartialLabelLearning,PLL)框架来生成一个包含部分标签的数据集,并且支持根据给定的标签列表对数据集进行筛选和过滤。代码包含了多个类和函数,主要分为以下几部分:数据预处理与加载:使用PyTorch和torchvision来加载CIFAR-10数据集,并对其进行标准化处理。部分标签数据集的生成:为每个样本生成多个候选标签,并模

- 推测未来Agentic形态:Dynamic Cognitive Contextual Agent with Reinforcement Learning (DCCA-RL)

weixin_40941102

语言模型

在AIAgent设计模式领域,我们见证了从简单的ReAct到复杂的LATS的演进,这些模式通过反思、工具使用、规划和多代理协作,极大地提升了AI的自主性和智能性。然而,随着任务复杂度和动态性需求的增加,现有模式逐渐显现出局限性——多Agent协作带来的联合误差和单Agent设计的适应性不足。为此,我们基于对现有模式的全面分析,提出了一个更先进的单Agent框架:DynamicCognitiveCo

- PyTorch 深度学习实战(19):离线强化学习与 Conservative Q-Learning (CQL) 算法

进取星辰

PyTorch深度学习实战深度学习pytorch算法

在上一篇文章中,我们探讨了分布式强化学习与IMPALA算法,展示了如何通过并行化训练提升强化学习的效率。本文将聚焦离线强化学习(OfflineRL)这一新兴方向,并实现ConservativeQ-Learning(CQL)算法,利用Minari提供的静态数据集训练安全的强化学习策略。一、离线强化学习与CQL原理1.离线强化学习的特点无需环境交互:直接从预收集的静态数据集学习数据效率高:复用历史经验

- 一切皆是映射:DQN训练加速技术:分布式训练与GPU并行

AI天才研究院

计算AI大模型企业级应用开发实战ChatGPT计算科学神经计算深度学习神经网络大数据人工智能大型语言模型AIAGILLMJavaPython架构设计AgentRPA

1.背景介绍1.1深度强化学习的兴起近年来,深度强化学习(DeepReinforcementLearning,DRL)在游戏、机器人控制、自然语言处理等领域取得了令人瞩目的成就。作为一种结合深度学习和强化学习的强大技术,DRL能够使智能体在与环境交互的过程中学习最优策略,从而实现自主决策和控制。1.2DQN算法及其局限性深度Q网络(DeepQ-Network,DQN)是DRL的一种经典算法,它利用

- Moodle + Websoft9:创新教育的强大组合,助力教学与学习

开源软件

Moodle+Websoft9:构建未来课堂的技术基石一、Moodle:开源生态的深度解析•模块化设计:支持超800个官方插件,如H5P交互内容创作、BigBlueButton虚拟课堂,满足个性化教学需求。•学习分析引擎:内置LearningAnalyticsAPI,可集成Python/R语言进行深度学习,预测学生学业风险。•移动优先战略:MoodleApp支持离线学习、扫码签到,2023年新增A

- 书籍-《动手学深度学习(英文版)》

书籍:DiveintoDeepLearning作者:AstonZhang,ZacharyC.Lipton,MuLi,AlexanderJ.Smola出版:CambridgeUniversityPress编辑:陈萍萍的公主@一点人工一点智能下载:书籍下载-《动手学深度学习(英文版)》01书籍介绍深度学习已经彻底改变了模式识别,为计算机视觉、自然语言处理和自动语音识别等领域提供了强大的工具。应用深度学

- 根据论文复现大模型方法以及出错处理技巧

Ai玩家hly

从0倒1论文复现大模型复现Ai大模型复现

复现一篇论文中的大模型搭建涉及以下几个关键步骤:理解论文的模型架构、数据集处理、超参数设置以及实验环境的搭建。这里给出一个基本的实现方法示例,假设我们选择复现一个图像分类任务中的经典模型,例如ResNet。实现步骤示例1.理解论文和模型架构选择一篇关于ResNet的论文作为示例,例如《DeepResidualLearningforImageRecognition》(Heetal.,2015)。2.

- 集成学习(Ensemble Learning)基础知识1

代码骑士

#机器学习集成学习机器学习人工智能

文章目录一、集成学习1、基本概念2、回顾:误差的偏差-方差分解3、为什么集成学习有效?4、基学习器:“好而不同”5、集成学习的两个基本问题(1)如何训练出具有差异性的多个基学习器?(2)如何将多个基学习器的预测结果集成为最终的强学习器预测结果?二、自助法(Bagging)1、Bagging2、BootstrapBootstrap采样的数学性质3、Bagging:集成学习的两个基本问题(1)如何训练

- Chainlink 预言机的原理解析

Chainlink资讯

预言机Chainlink智能合约

本文来自于8月19日Chainlink开发者社区中国负责人Frank,在DAppLearning分享会上对于Chainlink预言机的原理的讲解,以下是这节分享会的总结内容。有兴趣的小伙伴可以结合视频一起学习:为什么区块链无法主动获取外界数据区块链的特点区块链是一个封闭的确定性系统,每一笔交易都需要不同节点共识,只有超过一定数量的节点共识成功,交易才会被真正认可,并写入区块链。因为对于外部API的

- ros smach 教程——(二)

白云千载尽

自动驾驶rospythonsmach状态机

ROSSMACH中级教程一、SMACH容器1.1状态机容器1.1.1创建状态机容器首先引入状态机容器fromsmachimportStateMachine由于SMACH状态机还提供状态接口,因此必须在构造时指定其结果和用户数据交互。sm=StateMachine(outcomes=['outcome1','outcome2'],input_keys=['input1','input2'],outp

- 论文笔记-Contrastive Learning for Unpaired Image-to-Image Translation

kingsleyluoxin

计算机视觉论文笔记深度学习python计算机视觉机器学习人工智能深度学习

论文信息标题:ContrastiveLearningforUnpairedImage-to-ImageTranslation作者:TaesungPark,AlexeiA.Efros,RichardZhang,Jun-YanZhu机构:UniversityofCalifornia,Berkeley;AdobeResearch代码链接https://github.com/taesungp/contra

- 【迁移学习入门之域适应的背景、理论与方法】进一步理解迁移学习啦?

985小水博一枚呀

深度学习学习笔记迁移学习人工智能机器学习域适应

【迁移学习入门之域适应的背景、理论与方法】进一步理解迁移学习啦?【迁移学习入门之域适应的背景、理论与方法】进一步理解迁移学习啦?文章目录【迁移学习入门之域适应的背景、理论与方法】进一步理解迁移学习啦?1.背景介绍2.理论基础2.1分布差异(DomainShift)2.2迁移学习理论(TransferLearningTheory)2.3领域不变特征(Domain-invariantFeatures)

- 宝石组合 第十五届蓝桥杯大赛软件赛省赛C/C++ 大学 B 组

Geometry Fu

蓝桥杯蓝桥杯c语言c++

宝石组合题目来源第十五届蓝桥杯大赛软件赛省赛C/C++大学B组原题链接蓝桥杯宝石组合https://www.lanqiao.cn/problems/19711/learning/问题描述P10426[蓝桥杯2024省B]宝石组合题目描述在一个神秘的森林里,住着一个小精灵名叫小蓝。有一天,他偶然发现了一个隐藏在树洞里的宝藏,里面装满了闪烁着美丽光芒的宝石。这些宝石都有着不同的颜色和形状,但最引人注目

- 统计机器学习 (Statistical Machine Learning) 原理与代码实例讲解

AGI大模型与大数据研究院

DeepSeekR1&大数据AI人工智能计算科学神经计算深度学习神经网络大数据人工智能大型语言模型AIAGILLMJavaPython架构设计AgentRPA

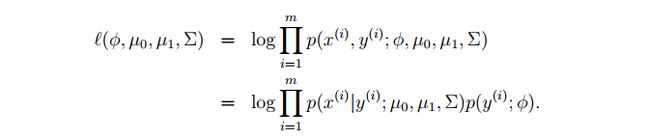

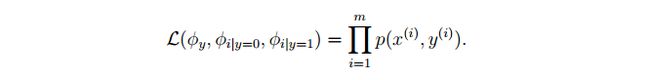

统计机器学习(StatisticalMachineLearning)原理与代码实例讲解1.背景介绍统计机器学习是现代人工智能和数据科学的核心领域之一。它结合了统计学和计算机科学的理论与方法,通过数据驱动的方式来构建预测模型和决策系统。统计机器学习不仅在学术研究中占据重要地位,还在工业界有广泛应用,如推荐系统、图像识别、自然语言处理等。2.核心概念与联系2.1统计学与机器学习的关系统计学关注数据的收

- 自动驾驶中控制模块状态机的作用与设计方法

程序员龙一

自动驾驶自动驾驶状态机control

问题解答:一、车辆状态机在自动驾驶控制模块中的核心作用在自动驾驶系统中,状态机(StateMachine)是控制模块的核心逻辑框架,用于管理车辆在不同运行阶段的行为和状态切换。其核心优势体现在以下几个方面:1.系统行为的模块化与可维护性模块化分层管理:状态机将复杂的车辆行为(如启动、停车、紧急避障、车道保持等)分解为独立的状态模块。每个状态专注于单一功能(例如“车道保持”状态仅处理横向控制),降低

- AI学习第二天--监督学习 半监督学习 无监督学习

iisugar

机器学习支持向量机人工智能

目录1.监督学习(SupervisedLearning)比喻:技术细节:形象例子:2.无监督学习(UnsupervisedLearning)比喻:技术细节:形象例子:3.半监督学习(Semi-SupervisedLearning)比喻:技术细节:形象例子:4.三者的对比与选择表格总结:5.实际案例对比案例:电商平台用户分群6.关键逻辑总结1.监督学习(SupervisedLearning)比喻:老

- 注意力机制+多尺度卷积

一只小小的土拨鼠

解构前沿:文献精读深度学习python人工智能YOLO深度学习

多尺度卷积先提供丰富的特征信息,注意力机制再从中筛选出关键信息,这样结合起来,不仅可以进一步提高模型的识别精度和效率,显著提升模型性能,还可以增强模型的可解释性。MPARN:multi-scalepathattentionresidualnetworkforfaultdiagnosisofrotatingmachines方法:论文介绍了一种用于旋转机械故障诊断的多尺度卷积神经网络结构,称为多尺度路

- KVM 内核优化全攻略:全方位释放服务器性能

TechStack 创行者

KVMLinux服务器运维KVM

KVM内核优化全攻略:全方位释放服务器性能在云计算、大数据、人工智能等前沿技术蓬勃发展的当下,服务器性能面临着前所未有的挑战。KVM(Kernel-basedVirtualMachine)作为开源虚拟化解决方案,凭借高效稳定的特性,广泛应用于企业数据中心。要充分发挥KVM性能优势,对其内核进行全面优化势在必行。本文将为你详细介绍一套涵盖通用优化及其他关键优化点的完整KVM内核优化方案,并结合实际案

- 数字接龙 第十五届蓝桥杯大赛软件赛省赛C/C++ 大学 B 组

Geometry Fu

蓝桥杯蓝桥杯c语言c++

数字接龙题目来源第十五届蓝桥杯大赛软件赛省赛C/C++大学B组原题链接蓝桥杯数字接龙https://www.lanqiao.cn/problems/19712/learning/问题描述题目描述小蓝最近迷上了一款名为《数字接龙》的迷宫游戏,游戏在一个大小为n×nn\timesnn×n的格子棋盘上展开,其中每一个格子处都有着一个0⋯k−10\cdotsk-10⋯k−1之间的整数。游戏规则如下:从左上

- 如何使用MATLAB进行高效的GPU加速深度学习模型训练?

百态老人

matlab深度学习开发语言

要使用MATLAB进行高效的GPU加速深度学习模型训练,可以遵循以下步骤和策略:选择合适的GPU硬件:首先,确保您的计算机配备有支持CUDA的NVIDIAGPU,并且其计算能力至少为3.0或以上。可以通过gpuDevice命令检查GPU是否具备加速功能。安装必要的工具箱:确保安装了MATLAB的DeepLearningToolbox和ParallelComputingToolbox,这些工具箱提供

- 【sklearn 03】逻辑回归、决策树、支持向量机

@金色海岸

sklearn逻辑回归决策树

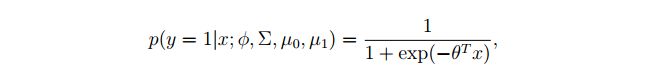

逻辑回归、决策树、支持向量机-逻辑回归logisticsregression(逻辑回归)算法是经典的分类算法,基本思想是构造一个概率的拟合函数。决策树决策树的基本思想是根据样例去推断其背后的树形知识表征支持向量机支持向量机SVM(supportvectormachine)的基本思想是寻找最大的间隔的分割超平面。离分割超平面最近的这些样本点称为支持向量机

- 嵌入式c语言进阶(三)状态机State Machine

niuTaylor

c语言开发语言

状态机(StateMachine)是一种描述系统在不同状态之间转换行为的数学模型或设计模式,广泛应用于嵌入式系统、业务流程、游戏开发等领域。以下从核心概念、实现方式、应用实战三方面进行详细解析:一、状态机核心概念四大要素现态(CurrentState):系统当前所处的状态。事件(Event):触发状态转移的条件,如用户操作、时间到期等。动作(Action):状态转移时执行的操作,例如发送通知、更新

- 【sklearn 02】监督学习、非监督下学习、强化学习

@金色海岸

sklearn学习人工智能

监督学习、非监督学习、强化学习**机器学习通常分为无监督学习、监督学习和强化学习三类。-第一类:无监督学习(unsupervisedlearning),指的是从信息出发自动寻找规律,分析数据的结构,常见的无监督学习任务有聚类、降维、密度估计、关联分析等。-第二类:监督学习(supervisedlearning),监督学习指的是使用带标签的数据去训练模型,并预测未知数据的标签。监督学习有两种,当预测

- C/C++Win32编程基础详解视频下载

择善Zach

编程C++Win32

课题视频:C/C++Win32编程基础详解

视频知识:win32窗口的创建

windows事件机制

主讲:择善Uncle老师

学习交流群:386620625

验证码:625

--

- Guava Cache使用笔记

bylijinnan

javaguavacache

1.Guava Cache的get/getIfPresent方法当参数为null时会抛空指针异常

我刚开始使用时还以为Guava Cache跟HashMap一样,get(null)返回null。

实际上Guava整体设计思想就是拒绝null的,很多地方都会执行com.google.common.base.Preconditions.checkNotNull的检查。

2.Guava

- 解决ora-01652无法通过128(在temp表空间中)

0624chenhong

oracle

解决ora-01652无法通过128(在temp表空间中)扩展temp段的过程

一个sql语句后,大约花了10分钟,好不容易有一个结果,但是报了一个ora-01652错误,查阅了oracle的错误代码说明:意思是指temp表空间无法自动扩展temp段。这种问题一般有两种原因:一是临时表空间空间太小,二是不能自动扩展。

分析过程:

既然是temp表空间有问题,那当

- Struct在jsp标签

不懂事的小屁孩

struct

非UI标签介绍:

控制类标签:

1:程序流程控制标签 if elseif else

<s:if test="isUsed">

<span class="label label-success">True</span>

</

- 按对象属性排序

换个号韩国红果果

JavaScript对象排序

利用JavaScript进行对象排序,根据用户的年龄排序展示

<script>

var bob={

name;bob,

age:30

}

var peter={

name;peter,

age:30

}

var amy={

name;amy,

age:24

}

var mike={

name;mike,

age:29

}

var john={

- 大数据分析让个性化的客户体验不再遥远

蓝儿唯美

数据分析

顾客通过多种渠道制造大量数据,企业则热衷于利用这些信息来实现更为个性化的体验。

分析公司Gartner表示,高级分析会成为客户服务的关键,但是大数据分析的采用目前仅局限于不到一成的企业。 挑战在于企业还在努力适应结构化数据,疲于根据自身的客户关系管理(CRM)系统部署有效的分析框架,以及集成不同的内外部信息源。

然而,面对顾客通过数字技术参与而产生的快速变化的信息,企业需要及时作出反应。要想实

- java笔记4

a-john

java

操作符

1,使用java操作符

操作符接受一个或多个参数,并生成一个新值。参数的形式与普通的方法调用不用,但是效果是相同的。加号和一元的正号(+)、减号和一元的负号(-)、乘号(*)、除号(/)以及赋值号(=)的用法与其他编程语言类似。

操作符作用于操作数,生成一个新值。另外,有些操作符可能会改变操作数自身的

- 从裸机编程到嵌入式Linux编程思想的转变------分而治之:驱动和应用程序

aijuans

嵌入式学习

笔者学习嵌入式Linux也有一段时间了,很奇怪的是很多书讲驱动编程方面的知识,也有很多书将ARM9方面的知识,但是从以前51形式的(对寄存器直接操作,初始化芯片的功能模块)编程方法,和思维模式,变换为基于Linux操作系统编程,讲这个思想转变的书几乎没有,让初学者走了很多弯路,撞了很多难墙。

笔者因此写上自己的学习心得,希望能给和我一样转变

- 在springmvc中解决FastJson循环引用的问题

asialee

循环引用fastjson

我们先来看一个例子:

package com.elong.bms;

import java.io.OutputStream;

import java.util.HashMap;

import java.util.Map;

import co

- ArrayAdapter和SimpleAdapter技术总结

百合不是茶

androidSimpleAdapterArrayAdapter高级组件基础

ArrayAdapter比较简单,但它只能用于显示文字。而SimpleAdapter则有很强的扩展性,可以自定义出各种效果

ArrayAdapter;的数据可以是数组或者是队列

// 获得下拉框对象

AutoCompleteTextView textview = (AutoCompleteTextView) this

- 九封信

bijian1013

人生励志

有时候,莫名的心情不好,不想和任何人说话,只想一个人静静的发呆。有时候,想一个人躲起来脆弱,不愿别人看到自己的伤口。有时候,走过熟悉的街角,看到熟悉的背影,突然想起一个人的脸。有时候,发现自己一夜之间就长大了。 2014,写给人

- Linux下安装MySQL Web 管理工具phpMyAdmin

sunjing

PHPInstallphpMyAdmin

PHP http://php.net/

phpMyAdmin http://www.phpmyadmin.net

Error compiling PHP on CentOS x64

一、安装Apache

请参阅http://billben.iteye.com/admin/blogs/1985244

二、安装依赖包

sudo yum install gd

- 分布式系统理论

bit1129

分布式

FLP

One famous theory in distributed computing, known as FLP after the authors Fischer, Lynch, and Patterson, proved that in a distributed system with asynchronous communication and process crashes,

- ssh2整合(spring+struts2+hibernate)-附源码

白糖_

eclipsespringHibernatemysql项目管理

最近抽空又整理了一套ssh2框架,主要使用的技术如下:

spring做容器,管理了三层(dao,service,actioin)的对象

struts2实现与页面交互(MVC),自己做了一个异常拦截器,能拦截Action层抛出的异常

hibernate与数据库交互

BoneCp数据库连接池,据说比其它数据库连接池快20倍,仅仅是据说

MySql数据库

项目用eclipse

- treetable bug记录

braveCS

table

// 插入子节点删除再插入时不能正常显示。修改:

//不知改后有没有错,先做个备忘

Tree.prototype.removeNode = function(node) {

// Recursively remove all descendants of +node+

this.unloadBranch(node);

// Remove

- 编程之美-电话号码对应英语单词

bylijinnan

java算法编程之美

import java.util.Arrays;

public class NumberToWord {

/**

* 编程之美 电话号码对应英语单词

* 题目:

* 手机上的拨号盘,每个数字都对应一些字母,比如2对应ABC,3对应DEF.........,8对应TUV,9对应WXYZ,

* 要求对一段数字,输出其代表的所有可能的字母组合

- jquery ajax读书笔记

chengxuyuancsdn

jQuery ajax

1、jsp页面

<%@ page language="java" import="java.util.*" pageEncoding="GBK"%>

<%

String path = request.getContextPath();

String basePath = request.getScheme()

- JWFD工作流拓扑结构解析伪码描述算法

comsci

数据结构算法工作活动J#

对工作流拓扑结构解析感兴趣的朋友可以下载附件,或者下载JWFD的全部代码进行分析

/* 流程图拓扑结构解析伪码描述算法

public java.util.ArrayList DFS(String graphid, String stepid, int j)

- oracle I/O 从属进程

daizj

oracle

I/O 从属进程

I/O从属进程用于为不支持异步I/O的系统或设备模拟异步I/O.例如,磁带设备(相当慢)就不支持异步I/O.通过使用I/O 从属进程,可以让磁带机模仿通常只为磁盘驱动器提供的功能。就好像支持真正的异步I/O 一样,写设备的进程(调用者)会收集大量数据,并交由写入器写出。数据成功地写出时,写入器(此时写入器是I/O 从属进程,而不是操作系统)会通知原来的调用者,调用者则会

- 高级排序:希尔排序

dieslrae

希尔排序

public void shellSort(int[] array){

int limit = 1;

int temp;

int index;

while(limit <= array.length/3){

limit = limit * 3 + 1;

- 初二下学期难记忆单词

dcj3sjt126com

englishword

kitchen 厨房

cupboard 厨柜

salt 盐

sugar 糖

oil 油

fork 叉;餐叉

spoon 匙;调羹

chopsticks 筷子

cabbage 卷心菜;洋白菜

soup 汤

Italian 意大利的

Indian 印度的

workplace 工作场所

even 甚至;更

Italy 意大利

laugh 笑

m

- Go语言使用MySQL数据库进行增删改查

dcj3sjt126com

mysql

目前Internet上流行的网站构架方式是LAMP,其中的M即MySQL, 作为数据库,MySQL以免费、开源、使用方便为优势成为了很多Web开发的后端数据库存储引擎。MySQL驱动Go中支持MySQL的驱动目前比较多,有如下几种,有些是支持database/sql标准,而有些是采用了自己的实现接口,常用的有如下几种:

http://code.google.c...o-mysql-dri

- git命令

shuizhaosi888

git

---------------设置全局用户名:

git config --global user.name "HanShuliang" //设置用户名

git config --global user.email "

[email protected]" //设置邮箱

---------------查看环境配置

git config --li

- qemu-kvm 网络 nat模式 (四)

haoningabc

kvmqemu

qemu-ifup-NAT

#!/bin/bash

BRIDGE=virbr0

NETWORK=192.168.122.0

GATEWAY=192.168.122.1

NETMASK=255.255.255.0

DHCPRANGE=192.168.122.2,192.168.122.254

TFTPROOT=

BOOTP=

function check_bridge()

- 不要让未来的你,讨厌现在的自己

jingjing0907

生活 奋斗 工作 梦想

故事one

23岁,他大学毕业,放弃了父母安排的稳定工作,独闯京城,在家小公司混个小职位,工作还算顺手,月薪三千,混了混,混走了一年的光阴。 24岁,有了女朋友,从二环12人的集体宿舍搬到香山民居,一间平房,二人世界,爱爱爱。偶然约三朋四友,打扑克搓麻将,日子快乐似神仙; 25岁,出了几次差,调了两次岗,薪水涨了不过百,生猛狂飙的物价让现实血淋淋,无力为心爱银儿购件大牌

- 枚举类型详解

一路欢笑一路走

enum枚举详解enumsetenumMap

枚举类型详解

一.Enum详解

1.1枚举类型的介绍

JDK1.5加入了一个全新的类型的”类”—枚举类型,为此JDK1.5引入了一个新的关键字enum,我们可以这样定义一个枚举类型。

Demo:一个最简单的枚举类

public enum ColorType {

RED

- 第11章 动画效果(上)

onestopweb

动画

index.html

<!DOCTYPE html PUBLIC "-//W3C//DTD XHTML 1.0 Transitional//EN" "http://www.w3.org/TR/xhtml1/DTD/xhtml1-transitional.dtd">

<html xmlns="http://www.w3.org/

- Eclipse中jsp、js文件编辑时,卡死现象解决汇总

ljf_home

eclipsejsp卡死js卡死

使用Eclipse编辑jsp、js文件时,经常出现卡死现象,在网上百度了N次,经过N次优化调整后,卡死现象逐步好转,具体那个方法起到作用,不太好讲。将所有用过的方法罗列如下:

1、取消验证

windows–>perferences–>validation

把 除了manual 下面的全部点掉,build下只留 classpath dependency Valida

- MySQL编程中的6个重要的实用技巧

tomcat_oracle

mysql

每一行命令都是用分号(;)作为结束

对于MySQL,第一件你必须牢记的是它的每一行命令都是用分号(;)作为结束的,但当一行MySQL被插入在PHP代码中时,最好把后面的分号省略掉,例如:

mysql_query("INSERT INTO tablename(first_name,last_name)VALUES('$first_name',$last_name')");

- zoj 3820 Building Fire Stations(二分+bfs)

阿尔萨斯

Build

题目链接:zoj 3820 Building Fire Stations

题目大意:给定一棵树,选取两个建立加油站,问说所有点距离加油站距离的最大值的最小值是多少,并且任意输出一种建立加油站的方式。

解题思路:二分距离判断,判断函数的复杂度是o(n),这样的复杂度应该是o(nlogn),即使常数系数偏大,但是居然跑了4.5s,也是醉了。 判断函数里面做了3次bfs,但是每次bfs节点最多