欢迎来到《每周CV论文推荐》。在这个专栏里,还是本着有三AI一贯的原则,专注于让大家能够系统性完成学习,所以我们推荐的文章也必定是同一主题的。

从事深度学习岗位,扎实的深度学习理论基础是必须掌握的,在前面我们已经给大家推荐过入门必须的模型结构相关的文章,今天给大家推荐必须精读的优化技术相关的文章。

作者&编辑 | 言有三

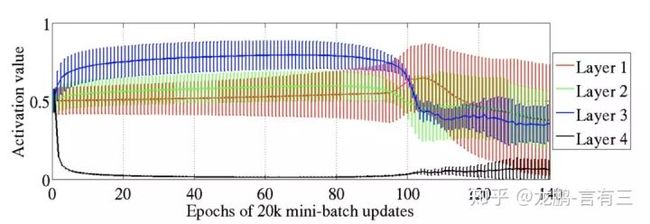

1 Xavier初始化方法

早期的深层神经网络就是被卡在了初始化上,xavier是一个非常有效的初始化方法,它的来龙去脉自然是需要仔细了解。

文章引用量:6000+

推荐指数:✦✦✦✦✦

[1] Glorot X, Bengio Y. Understanding the difficulty of training deep feedforward neural networks[C]//Proceedings of the thirteenth international conference on artificial intelligence and statistics. 2010: 249-256.

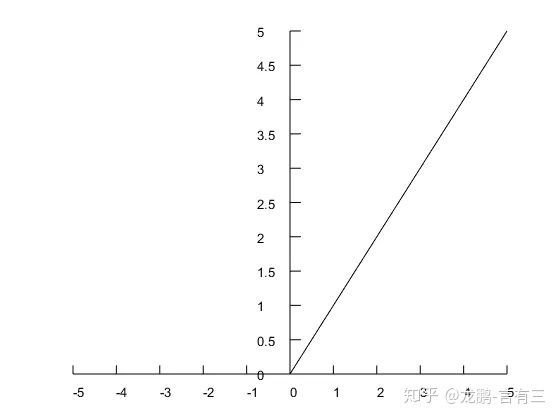

2 ReLU函数

简单而不光滑的ReLU为何开始取代sigmoid等激活函数,它为何有效,不需多说,基本上一直都被问。

文章引用量:4000+

推荐指数:✦✦✦✦✦

[2] Glorot X, Bordes A, Bengio Y. Deep sparse rectifier neural networks[C]//Proceedings of the fourteenth international conference on artificial intelligence and statistics. 2011: 315-323.

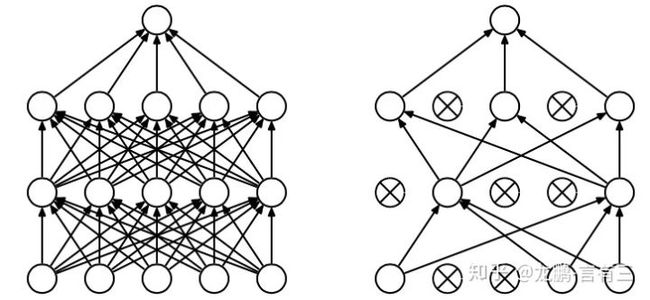

3 Dropout正则化技术

Dropout是AlexNet网络成功训练必不可缺少的工程技术,也是极为强大的正则化技术,在深度学习优化技术中举足轻重。

文章引用量:13000+

推荐指数:✦✦✦✦✦

[3] Srivastava N, Hinton G, Krizhevsky A, et al. Dropout: a simple way to prevent neural networks from overfitting[J]. The journal of machine learning research, 2014, 15(1): 1929-1958.

4 池化与步长

池化的思想和应用早就随着卷积而诞生,但是现在我们常常用带步长的卷积去替代池化,为什么呢?它们的对比究竟如何。

文章引用量:1400+

推荐指数:✦✦✦✦✧

[4] Springenberg J T, Dosovitskiy A, Brox T, et al. Striving for simplicity: The all convolutional net[J]. arXiv preprint arXiv:1412.6806, 2014.

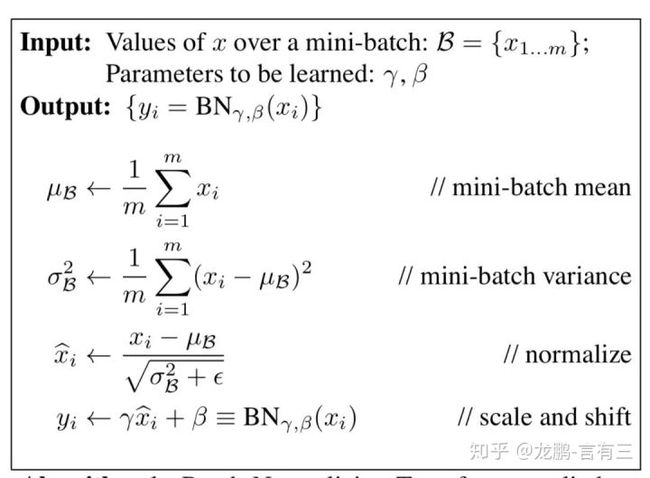

5 BN的提出

BN之强大,人尽皆知,不管你读过多少资料解读,这原文都是需要精读的。

文章引用量:11000+

推荐指数:✦✦✦✦✦

[5] Ioffe S, Szegedy C. Batch normalization: Accelerating deep network training by reducing internal covariate shift[J]. arXiv preprint arXiv:1502.03167, 2015.

鉴于理论文章读起来难度要高不少,本周就只推荐5篇,深度学习优化相关的内容这还只是前菜,希望大家提前做好准备。

6 如何获取文章与交流

找到有三AI开源项目即可获取。

https://github.com/longpeng2008/yousan.ai

文章细节众多,阅读交流在有三AI知识星球中进行,感兴趣可以加入。

总结

以上就是初入深度学习领域必读的理论相关的文章,下一期我们将介绍一些训练和测试数据使用技巧相关的文章。

如果想加入我们,后台留言吧

转载文章请后台联系

侵权必究

技术交流请移步知识星球

更多请关注知乎专栏《有三AI学院》和公众号《有三AI》