insert中overwrite 与分区

由https://blog.csdn.net/qq_41797451/article/details/80346361 这个链接我们可以知道overwrite 的作用是先删再写。

如果由分区,则删分区。 那么有分区,写的时候是怎么写呢? 下面我们来验证一下

use db;

set hive.exec.dynamic.partition=true;

set hive.exec.dynamic.partition.mode=nonstrict;

set hive.exec.max.dynamic.partitions.pernode=10000;

set hive.exec.max.dynamic.partitions=10000;

set hive.exec.max.created.files=10000;

create table if not exists test20190423

(

remark string

)

PARTITIONED BY

(

date_time string

);

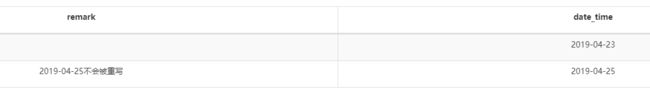

insert overwrite table test20190423 partition (date_time)

select

'' remark,

'2019-04-23' date_time

from default.dual

;

insert overwrite table test20190423 partition (date_time)

select

'2019-04-25不会被重写' remark,

'2019-04-25' date_time

from default.dual

继续往下走

use db;

set hive.exec.dynamic.partition=true;

set hive.exec.dynamic.partition.mode=nonstrict;

set hive.exec.max.dynamic.partitions.pernode=10000;

set hive.exec.max.dynamic.partitions=10000;

set hive.exec.max.created.files=10000;

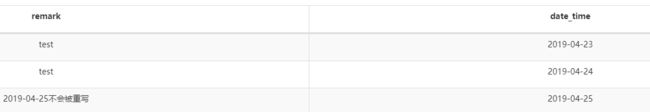

insert overwrite table test20190423 partition (date_time)

select

'test' remark,

'2019-04-23' date_time

from default.dual

union all

select

'test' remark,

'2019-04-24' date_time

from default.dual

;

得到结果

我们只需要明白一个问题就可以总结出overwrite的用法了。

overwrite :先删,后写入。

1.对于删,没分区则全删。 有分区,则删原来结果中能够与select 结果中相匹配的分区。

2.对于写入,不管有没有分区,都写入select 结果中的全部结果。

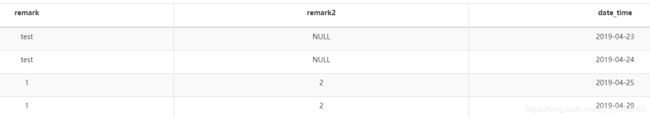

如果分区表要新增字段,新增字段的重写机制又是怎样子的呢?

use db;

alter table test20190423 add columns (remark2 string COMMENT '新添加的列') ;

use gftest;

set hive.exec.dynamic.partition=true;

set hive.exec.dynamic.partition.mode=nonstrict;

set hive.exec.max.dynamic.partitions.pernode=10000;

set hive.exec.max.dynamic.partitions=10000;

set hive.exec.max.created.files=10000;

insert overwrite table test20190423 PARTITION(date_time)

select

'1',

'2',

'2019-04-25'

from default.dual;

use gftest;

set hive.exec.dynamic.partition=true;

set hive.exec.dynamic.partition.mode=nonstrict;

set hive.exec.max.dynamic.partitions.pernode=10000;

set hive.exec.max.dynamic.partitions=10000;

set hive.exec.max.created.files=10000;

insert overwrite table test20190423 PARTITION(date_time)

select

'1',

'2',

'2019-04-29'

from default.dual;

查到的数据

可见旧分区的数据没有被重写到(新增字段的内容)

那该怎么办?

use gftest;

set hive.exec.dynamic.partition=true;

set hive.exec.dynamic.partition.mode=nonstrict;

set hive.exec.max.dynamic.partitions.pernode=10000;

set hive.exec.max.dynamic.partitions=10000;

set hive.exec.max.created.files=10000;

ALTER TABLE test20190423 DROP PARTITION(date_time='2019-04-25');

insert overwrite table test20190423 PARTITION(date_time)

select

'1',

'2',

'2019-04-25'

from default.dual;

得到结果

看来对于旧分区的数据,真的要DROP PARTITION 才行。

但是有个关键字CASCADE可以让新增字段不用变得那么麻烦。由于我用的hadoop版本问题,这个关键词没被支持,就没法尝试了。