Kafka基本架构介绍

1、什么是消息系统?

消息系统负责将数据从一个应用程序传输到另一个应用程序,因此应用程序可以专注于数据,但不担心如何共享它。 分布式消息传递基于可靠消息队列的概念。 消息在客户端应用程序和消息传递系统之间异步排队。 有两种类型的消息模式可用 - 一种是点对点,另一种是发布 - 订阅(pub-sub)消息系统。 大多数消息模式遵循 pub-sub 。

(1)点对点消息系统

在点对点系统中,消息被保留在队列中。 一个或多个消费者可以消耗队列中的消息,但是特定消息只能由最多一个消费者消费。 一旦消费者读取队列中的消息,它就从该队列中消失。 该系统的典型示例是订单处理系统,其中每个订单将由一个订单处理器处理,但多个订单处理器也可以同时工作。 下图描述了结构。

(2)发布 - 订阅消息系统

在发布 - 订阅系统中,消息被保留在主题中。 与点对点系统不同,消费者可以订阅一个或多个主题并使用该主题中的所有消息。 在发布 - 订阅系统中,消息生产者称为发布者,消息使用者称为订阅者。 一个现实生活的例子是Dish电视,它发布不同的渠道,如运动,电影,音乐等,任何人都可以订阅自己的频道集,并获得他们订阅的频道时可用。

2、什么是Kafka?

Apache Kafka是一个分布式发布 - 订阅消息系统和一个强大的队列,可以处理大量的数据,并使您能够将消息从一个端点传递到另一个端点。 Kafka适合离线和在线消息消费。 Kafka消息保留在磁盘上,并在群集内复制以防止数据丢失。 Kafka构建在ZooKeeper同步服务之上。 它与Apache Storm和Spark非常好地集成,用于实时流式数据分析。

Kafka专为分布式高吞吐量系统而设计。 与其他消息传递系统相比,Kafka具有更好的吞吐量,内置分区,复制和固有的容错能力,这使得它非常适合大规模消息处理应用程序。

Kafka可以在许多用例中使用, 其中一些列出如下:

- 指标 - Kafka通常用于操作监控数据。 这涉及聚合来自分布式应用程序的统计信息,以产生操作数据的集中馈送。

- 日志聚合解决方案 - Kafka可用于跨组织从多个服务收集日志,并使它们以标准格式提供给多个服务器。

- 流处理 - 流行的框架(如Storm和Spark Streaming)从主题中读取数据,对其进行处理,并将处理后的数据写入新主题,供用户和应用程序使用。 Kafka的强耐久性在流处理的上下文中也非常有用。

3、Kafka架构

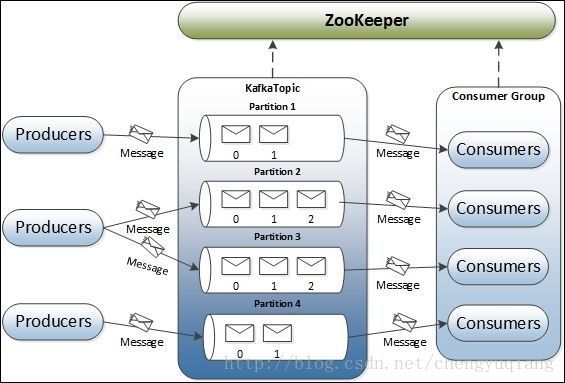

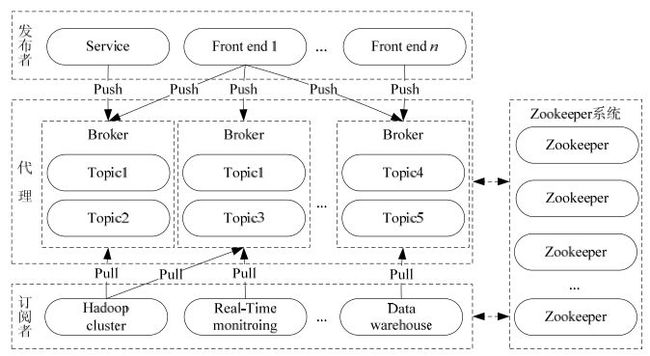

深入学习Kafka之前,必须了解主题(Topic)、经纪人(Broker)、生产者(Producer)或者发布者,以及消费者(Consumer)或者订阅者等主要术语。 下图说明了主要术语,表格详细描述了图表组件。

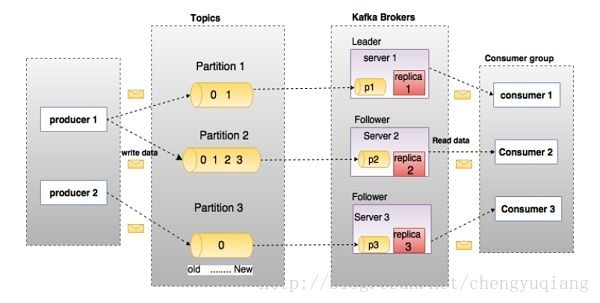

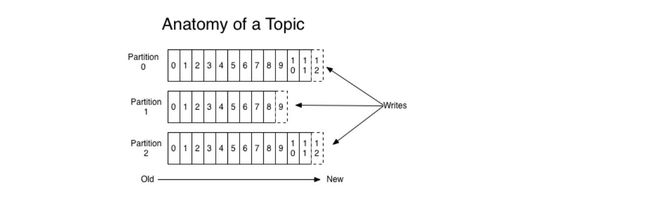

(1)Topics(主题)

属于特定类别的消息流称为主题。 数据存储在主题中。Topic相当于Queue。

主题被拆分成分区。 每个这样的分区包含不可变有序序列的消息。 分区被实现为具有相等大小的一组分段文件。

(2)Partition(分区)

- 一个Topic可以分成多个Partition,这是为了平行化处理。

- 每个Partition内部消息有序,其中每个消息都有一个offset序号。

- 一个Partition只对应一个Broker,一个Broker可以管理多个Partition。

(3)Partition offset(分区偏移)

每个分区消息具有称为 offset 的唯一序列标识。

(4)Replicas of partition(分区备份)

副本只是一个分区的备份。 副本从不读取或写入数据。 它们用于防止数据丢失。

(5)Brokers(经纪人)

- 代理是负责维护发布数据的简单系统。 每个代理可以每个主题具有零个或多个分区。 假设,如果在一个主题和N个代理中有N个分区,每个代理将有一个分区。

- 假设在一个主题中有N个分区并且多于N个代理(n + m),则第一个N代理将具有一个分区,并且下一个M代理将不具有用于该特定主题的任何分区。

- 假设在一个主题中有N个分区并且小于N个代理(n-m),每个代理将在它们之间具有一个或多个分区共享。 由于代理之间的负载分布不相等,不推荐使用此方案。

(6)Kafka Cluster(Kafka集群)

Kafka有多个代理被称为Kafka集群。 可以扩展Kafka集群,无需停机。 这些集群用于管理消息数据的持久性和复制。

(7)Producers(生产者)

生产者是发送给一个或多个Kafka主题的消息的发布者。 生产者向Kafka经纪人发送数据。 每当生产者将消息发布给代理时,代理只需将消息附加到最后一个段文件。实际上,该消息将被附加到分区。 生产者还可以向他们选择的分区发送消息。

(8)Consumers(消费者)

Consumers从经纪人处读取数据。 消费者订阅一个或多个主题,并通过从代理中提取数据来使用已发布的消息。

- Consumer自己维护消费到哪个offet

- 每个Consumer都有对应的group

- group内是queue消费模型:各个Consumer消费不同的partition,因此一个消息在group内只消费一次

- group间是publish-subscribe消费模型:各个group各自独立消费,互不影响,因此一个消息被每个group消费一次。

4、创建topic

创建一个叫做“test”的topic,它只有一个分区,一个副本。

[root@node1 kafka_2.11-0.11.0.1]# bin/kafka-topics.sh --create --zookeeper localhost:2181 --replication-factor 1 --partitions 1 --topic test

Created topic "test".

[2017-10-29 07:44:33,497] INFO [ReplicaFetcherManager on broker 1] Removed fetcher for partitions test-0 (kafka.server.ReplicaFetcherManager)

[2017-10-29 07:44:33,602] INFO Loading producer state from offset 0 for partition test-0 with message format version 2 (kafka.log.Log)

[2017-10-29 07:44:33,618] INFO Completed load of log test-0 with 1 log segments, log start offset 0 and log end offset 0 in 66 ms (kafka.log.Log)

[2017-10-29 07:44:33,658] INFO Created log for partition [test,0] in /var/log/kafka-logs with properties {compression.type -> producer, message.format.version -> 0.11.0-IV2, file.delete.delay.ms -> 60000, max.message.bytes -> 1000012, min.compaction.lag.ms -> 0, message.timestamp.type -> CreateTime, min.insync.replicas -> 1, segment.jitter.ms -> 0, preallocate -> false, min.cleanable.dirty.ratio -> 0.5, index.interval.bytes -> 4096, unclean.leader.election.enable -> false, retention.bytes -> -1, delete.retention.ms -> 86400000, cleanup.policy -> [delete], flush.ms -> 9223372036854775807, segment.ms -> 604800000, segment.bytes -> 1073741824, retention.ms -> 604800000, message.timestamp.difference.max.ms -> 9223372036854775807, segment.index.bytes -> 10485760, flush.messages -> 9223372036854775807}. (kafka.log.LogManager)

[2017-10-29 07:44:33,660] INFO Partition [test,0] on broker 1: No checkpointed highwatermark is found for partition test-0 (kafka.cluster.Partition)

[2017-10-29 07:44:33,665] INFO Replica loaded for partition test-0 with initial high watermark 0 (kafka.cluster.Replica)

[2017-10-29 07:44:33,667] INFO Partition [test,0] on broker 1: test-0 starts at Leader Epoch 0 from offset 0. Previous Leader Epoch was: -1 (kafka.cluster.Partition)

[root@node1 kafka_2.11-0.11.0.1]# 可以通过list命令查看创建的topic

[root@node1 kafka_2.11-0.11.0.1]# bin/kafka-topics.sh --list --zookeeper localhost:2181

test

[root@node1 kafka_2.11-0.11.0.1]#5、发送消息

[root@node1 kafka_2.11-0.11.0.1]# bin/kafka-console-producer.sh --broker-list localhost:9092 --topic test

>This is a message

>[2017-10-29 07:47:28,399] INFO Updated PartitionLeaderEpoch. New: {epoch:0, offset:0}, Current: {epoch:-1, offset-1} for Partition: test-0. Cache now contains 0 entries. (kafka.server.epoch.LeaderEpochFileCache)

This is another message

>^C[root@node1 kafka_2.11-0.11.0.1]#6、启动一个消费者

Kafka还有个消费者控制台,会把消息输出到标准输出。

[root@node2 kafka_2.11-0.11.0.1]# bin/kafka-console-consumer.sh --bootstrap-server localhost:9092 --topic test --from-beginning

[2017-10-29 07:49:32,094] INFO Topic creation {"version":1,"partitions":{"45":[1],"34":[2],"12":[1],"8":[3],"19":[2],"23":[3],"4":[2],"40":[2],"15":[1],"11":[3],"9":[1],"44":[3],"33":[1],"22":[2],"26":[3],"37":[2],"13":[2],"46":[2],"24":[1],"35":[3],"16":[2],"5":[3],"10":[2],"48":[1],"21":[1],"43":[2],"32":[3],"49":[2],"6":[1],"36":[1],"1":[2],"39":[1],"17":[3],"25":[2],"14":[3],"47":[3],"31":[2],"42":[1],"0":[1],"20":[3],"27":[1],"2":[3],"38":[3],"18":[1],"30":[1],"7":[2],"29":[3],"41":[3],"3":[1],"28":[2]}} (kafka.admin.AdminUtils$)

[2017-10-29 07:49:32,121] INFO [KafkaApi-2] Auto creation of topic __consumer_offsets with 50 partitions and replication factor 1 is successful (kafka.server.KafkaApis)

[2017-10-29 07:49:36,792] INFO [ReplicaFetcherManager on broker 2] Removed fetcher for partitions __consumer_offsets-22,__consumer_offsets-4,__consumer_offsets-7,__consumer_offsets-46,__consumer_offsets-25,__consumer_offsets-49,__consumer_offsets-16,__consumer_offsets-28,__consumer_offsets-31,__consumer_offsets-37,__consumer_offsets-19,__consumer_offsets-13,__consumer_offsets-43,__consumer_offsets-1,__consumer_offsets-34,__consumer_offsets-10,__consumer_offsets-40 (kafka.server.ReplicaFetcherManager)

[2017-10-29 07:49:36,919] INFO Loading producer state from offset 0 for partition __consumer_offsets-10 with message format version 2 (kafka.log.Log)

....

....

[2017-10-29 07:49:38,414] INFO [GroupCoordinator 2]: Stabilized group console-consumer-45516 generation 1 (__consumer_offsets-22) (kafka.coordinator.group.GroupCoordinator)

[2017-10-29 07:49:38,476] INFO [GroupCoordinator 2]: Assignment received from leader for group console-consumer-45516 for generation 1 (kafka.coordinator.group.GroupCoordinator)

[2017-10-29 07:49:38,566] INFO Updated PartitionLeaderEpoch. New: {epoch:0, offset:0}, Current: {epoch:-1, offset-1} for Partition: __consumer_offsets-22. Cache now contains 0 entries. (kafka.server.epoch.LeaderEpochFileCache)

This is a message

This is another message