深度学习tensorflow实战笔记(1)全连接神经网络(FCN)训练自己的数据(从txt文件中读取)

写在前面的话:离上一次写博客已经有些日子了,以前的工程都是在caffe平台下做的,caffe平台虽然挺好用的,但是caffe主要用于做CNN,对于其它的网络模型用起来不太方便,所以博主转战tensorflow,Google对待tensorflow就想当年对待Android一样,虽然现在推出了很多其它机器学习(深度学习)框架,不过tensorflow的便利性还是很值得称赞的,最起码博主感觉上手很容易的。

tensorflow平台用于机器学习或者深度学习的代码大多数是基于mnist或者cifar-10等标准数据集的,这种数据集封装了标注格式,tf平台都有专门的针对这类数据处理操作,但是要想训练自己的数据,并不是一件容易的事情,博主倒弄了几天,终于跑通了如果用多层感知机以及卷积神经网络训练自己的数据,包括数据读入、测试、特征提取等操作。本篇博客主要介绍如何从txt文件中读取自己的数据,用于训练多层感知机,后续的博客介绍如何处理图像数据,以及CNN的相关内容。都是一些非常实用的干货。

1、准备数据

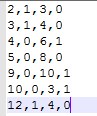

把数据放进txt文件中(数据量大的话,就写一段程序自己把数据自动的写入txt文件中,任何语言都能实现),数据之间用逗号隔开,最后一列标注数据的标签(用于分类),比如0,1。每一行表示一个训练样本。如下图所示。

其中前三列表示数据(特征),最后一列表示数据(特征)的标签。注意:标签需要从0开始编码!

其中前三列表示数据(特征),最后一列表示数据(特征)的标签。注意:标签需要从0开始编码!

2、实现全连接网络

这个过程我就不多说了,如何非常简单,就是普通的代码实现,本篇博客的重点在于使用自己的数据,有些需要注意的地方我在后面会做注释。直接上代码

#隐含层参数设置

in_units=3 #输入神经元个数

h1_units=5 #隐含层输出神经元个数

#第二个隐含层神经元个数

h2_units=6

W1=tf.Variable(tf.truncated_normal([in_units,h1_units],stddev=0.1)) #隐含层权重,W初始化为截断正态分布

b1=tf.Variable(tf.zeros([h1_units])) #隐含层偏执设置为0

W2=tf.Variable(tf.truncated_normal([h1_units,h2_units],stddev=0.1)) #第二个隐含层权重,W初始化为截断正态分布

b2=tf.Variable(tf.zeros([h2_units])) #第二个隐含层偏执设置为0

W3=tf.Variable(tf.zeros([h2_units,2])) #输出层权重和偏执都设置为0

b3=tf.Variable(tf.zeros([2]))

#定义输入变量x和dropout比率

x=tf.placeholder(tf.float32,[None,3]) #列是

keep_prob=tf.placeholder(tf.float32)

#定义一个隐含层

hidden1=tf.nn.relu(tf.matmul(x,W1)+b1)

hidden1_drop=tf.nn.dropout(hidden1,keep_prob)

#定义第二个隐藏层

hidden2=tf.nn.relu(tf.matmul(hidden1_drop,W2)+b2)

hidden2_drop=tf.nn.dropout(hidden2,keep_prob)in_units=3 #输入神经元个数,和特征的维度对应起来x=tf.placeholder(tf.float32,[None,3]) #和特征的维度对应起来3、实现损失函数

标准的softmax和交叉熵,不多说了。

y=tf.nn.softmax(tf.matmul(hidden2_drop,W3)+b3)

#定义损失函数和选择优化器

y_=tf.placeholder(tf.float32,[None,2]) #列是2,表示两类,行表示输入的训练样本个数,None表示不定

corss_entropy=tf.reduce_mean(-tf.reduce_sum(y_*tf.log(y),reduction_indices=[1]))

train_step=tf.train.AdagradOptimizer(0.3).minimize(corss_entropy)需要注意的地方:

y_=tf.placeholder(tf.float32,[None,2]) #有几类就写几,我写的是两类,所以就是24、从txt中读取数据,并做处理

重点来了,首先从txt中把数据读取出来,然后对标签进行独热编码,什么是独热编码?索引表示类别,是哪个类别这一维就是非零(用1)。代码实现:

data=np.loadtxt('txt.txt',dtype='float',delimiter=',')

#将样本标签转换成独热编码

def label_change(before_label):

label_num=len(before_label)

change_arr=np.zeros((label_num,2)) #2表示有两类

for i in range(label_num):

#该样本标签数据要求从0开始

change_arr[i,int(before_label[i])]=1

return change_arr

#用于提取数据

def train(data):

data_train_x=data[:7,:3] #取前几行作为训练数据,7表示前7行,3表示取前三列,排除数据标签

data_train_y=label_change(data[:7,-1])

return data_train_x,data_train_y

data_train_x,data_train_y=train(data)需要注意的地方在代码中我都做了注释,不再赘述。

5、开始训练和测试

训练部分for i in range(5): #迭代,取batch进行训练

img_batch, label_batch = tf.train.shuffle_batch([data_train_x, data_train_y], #随机取样本

batch_size=2,

num_threads=2,

capacity=7,

min_after_dequeue=2,

enqueue_many=True)

coord = tf.train.Coordinator()

threads = tf.train.start_queue_runners(coord=coord, sess=sess)

img_batch,label_batch=sess.run([img_batch,label_batch])

train_step.run({x:img_batch,y_:label_batch,keep_prob:0.75} #预测部分

correct_prediction=tf.equal(tf.argmax(y,1),tf.argmax(y_,1))

accuracy=tf.reduce_mean(tf.cast(correct_prediction,tf.float32))

print(accuracy.eval({x:data_train_x,y_:data_train_y,keep_prob:1.0})) 这样就全部流程完成。其中网络结构可以做相应的修改,核心在于如何从txt中读取自己的数据输入到全连接神经网络(多层感知机)中进行训练和测试。

当然,也可以在定义变量的时候直接输入,不用从txt中读取。即:

image=[[1.0,2.0,3.0],[9,8,5],[9,5,6],[7,5,3],[6,12,7],[8,3,6],[2,8,71]]

label=[[0,1],[1,0],[1,0],[1,0],[1,0],[0,1],[0,1]]

image_test=[[9,9,9]]

label_test=[[0,1]] 直接定于数据的话,适合小数据量的情况,大数据量的情况并不适用。

好了,本篇博客介绍到此结束。下一篇介绍如何处理图像数据。