BERT在关系学习中的应用

Matching the Blanks: Distributional Similarity for Relation Learning(2019 ACL)

典型的关系抽取可以大致分为以下三类:

- 第一类有监督或者远程监督的关系抽取,该类方法通过有限的模式去学习文本到关系之间的映射关系。

- 第二类为开放领域的关系抽取,该类方法消除了预定义模式的限制。

- 第三类为泛化能力较强的通用模式,该类方法既包含文本的多样性又包含关系的简洁性。

该论文主要依据关系的分布式假设,提出了一种直接从文本中学习关系表示的新方法。本文的主要贡献有以下两个方面:

- 该模型主要基于Transformer结构对实体对之间的关系进行编码。

- 该模型训练表示关系不需要任何的有监督数据或者是人类标注数据,只通过matching the blanks方法来训练模型(句子中的实体被特殊字符[BLANK]替换,其目标是使得关系表示相似,如果该文本关系表述中包含相同的实体对)。

Overview

Task definition

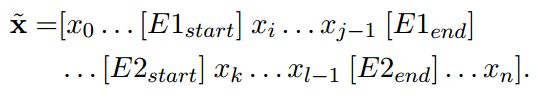

本文的目标是学习从文本关系表述到向量关系表示之间的一个映射关系。给定一个序列表示![]() ,其中

,其中![]() ,

,![]() 为其特殊的开始和结束表示符。

为其特殊的开始和结束表示符。![]() 和

和![]() 为其两个实体的token范围,其中

为其两个实体的token范围,其中![]() 。

。

一个关系表述就变成了三元组的形式: ![]() 。我们的目标是学习一个函数映射,

。我们的目标是学习一个函数映射, ![]() ,将三元组形式的关系表述转化为固定长度的向量化表示h。

,将三元组形式的关系表述转化为固定长度的向量化表示h。

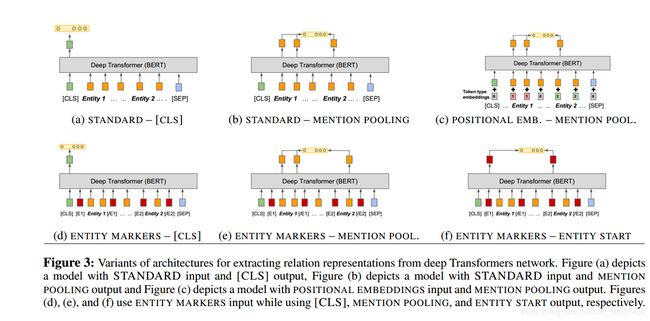

Architectures for Relation Learning

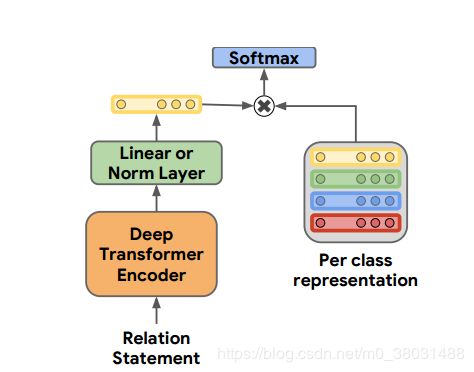

Relation Classification and Extraction Tasks

- 对于有监督分类任务:给定一个文本关系表述r,预测一个关系类型t(

),其中

),其中 代表一个固定数量的预定于关系集合。如果t=0代表该关系表述中不包含任何关系。

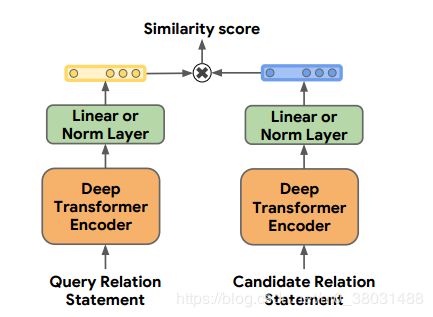

代表一个固定数量的预定于关系集合。如果t=0代表该关系表述中不包含任何关系。 - 对于few-shot关系分类任务:其测试集和验证集中包含的关系类别没有在训练集中出现过。

Relation Representations from Deep Transformers Model

在该文的所有实验中,均基于BERTLARGE模型,面向特定任务的loss来训练。该论文主要依据两个问题来进行关系表示:(1)在BERT中如何表示实体。(2)如何从BERT的输出中提取一个固定大小的向量来表示该关系。

Entity span identification

- Standard input:实验中不包含任何显示代表实体对的信息,该模型认为BERT理想的情况向可以识别出x中的实体。

- Positional embeddings:实验中为每个输入token都添加上了一个分段标记,目的使得模型可以明确x中的两个实体。

- Entity marker tokens:实验中添加了四个保留字段来明确实体的开始位置和结束位置,例如:

Fixed length relation representation

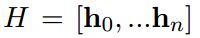

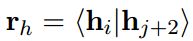

对于最后的关系向量表示hr,其实基于Transformer的最后隐层表示![]() 来生成的。

来生成的。

- [CLS] token:与标准BERT中的保留字段相同,用于句子分类。

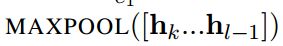

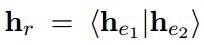

- Entity mention pooling:hr由两个实体向量表示

,

,

拼接而成,

拼接而成, 。

。 - Entity start state:当使用了Entity mention pooling,模型表示最后的关系仅通过将两个实体的开始标识向量拼接起来,

。

。

除了定于Transformer的输入和输出,对于不同的任务我们还定义了不同的loss。

- 对于有监督任务:一个标准的交叉熵损失。

Learning by Matching the Blanks

受启发于直接从带标签的文本中推导关系,该模型提出了一种新颖的encode训练函数![]() ,该方法不依赖于预定于或者带标签的数据。对于两个语义上表示相似的关系的r和r’,它们的内积值

,该方法不依赖于预定于或者带标签的数据。对于两个语义上表示相似的关系的r和r’,它们的内积值![]() 应该高。相反的若表达的语义不同,其内积值应当较低。

应该高。相反的若表达的语义不同,其内积值应当较低。

我们发现web文本汇总存在着很高的数据冗余,任意一对实体之间的每个关系都可能被反复陈述多次。![]() 很可能表达相同的关系同

很可能表达相同的关系同![]() ,若s1和s1’,s2和s2’表示的是相同的实体。基于这个观察,该论文提出了Matching the blanks(MTB)方法。

,若s1和s1’,s2和s2’表示的是相同的实体。基于这个观察,该论文提出了Matching the blanks(MTB)方法。

Learning Setup

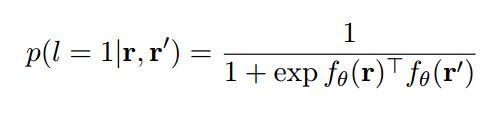

以下公式来判读两个关系表述是否表达相同的关系:

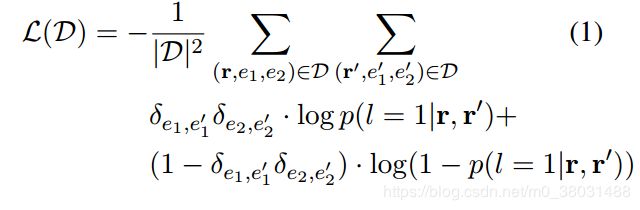

并且通过以下loss来训练:

Introducing Blanks

对于普通的关系表述:

为了避免实体表示对编码器的学习干预过大,该论文引入[BLANK]机制,每个实体对中的实体都有一点的概率被替换为一个普通的[BLANK]符号,

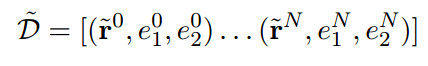

Matching the Blanks Training

使用采样策略从6亿对关系表述中来训练模型。

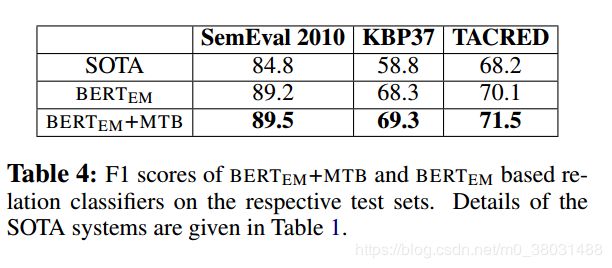

Experimental Evaluation

Few-shot Relation Matching

Supervised Relation Extraction

原文链接:https://arxiv.org/abs/1906.03158