人体姿态估计Alphapose配置安装教程(GPU,超详细,亲测有效!)

首先简单介绍一下Alposepose

该模型提出的论文:《RMPE: Regional Multi-Person Pose Estimation》ICCV 2017,是由上海交通大学提出的,目前在多人自讨估计的效果最好。

论文 网址:https://arxiv.org/abs/1612.00137

文章的写作背景是单人姿态估计的方法不能用在多人上面,而多人姿态估计方法虽然效果不错,但是太慢了(485 seconds per image)。它对于多人姿态估计的方法采用传统的自顶向下的方法,即先检测人,再识别人体姿态。检测使用的是SSD-512,识别人体姿态使用的是state-of-the-art的Stacked Hourglass方法。致力于解决对于imperfect proposal,通过调整,使得crop的单人能够被单人姿态估计方法很好的识别,从而克服检测带来的定位误差。

目前的人体检测方法会产生两个主要问题:定位错误,以及多余的检测结果,尤其是SPPE (singal person pose estimation)。这篇文章就是为解决这个问题而来的,提出了RMPE方法。包括了三个模块:Symmetric Spatial Transformer Network (SSTN)用于在不准确的bounding box下仍能提取准确的单个人的范围,这是组合到SPPE里面的。NMS是处理多余的候选框的,它是采用了新的距离量测的方法来计算姿态的相似度,且是数据驱动的,不是预先设定的。PGPG用于增多训练样本。

想大致了解人体姿态的相关发展史可以参考博客:https://blog.csdn.net/qq_38522972/article/details/82953477

-------------------------------------------------------------------------------------------------------------------------------------------------------------------------

OK,那么下面介绍如何安装配置Alphapose模型:

我的电脑:Ubuntu16.04,GPU,NVIDIA184

我们知道Ubuntu自带两个版本的python,分别是python2.7和python3.5,我想说github官网给的配置方法是有一定的细节未给出,需要亲身实践才能明白,这里我先简单说一下:pytorch必须要装在系统的python3.5,因为官网给的测试程序和命令是python3的。按照我以下的方法完全可成功配置!!!

1,先下载模型代码

git clone -b pytorch https://github.com/MVIG-SJTU/AlphaPose.git2,给python3.5安装必要的依赖项

pip install -r requirements.txt3,下载两个模型: duc_se.pth 和yolov3-spp.weights,分别将他们放在./models/sppe and ./models/yolo文件夹里

链接:https://pan.baidu.com/s/1JOQlOlMUzJeHFi5f5jmOlg

提取码:c5ob

4,安装pytorch!!!

先登陆官网

选择需要的配置条件

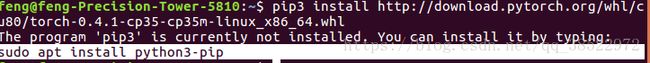

这样一来我们看到最下面显示的两条命令,把命令在Ubuntu终端运行,直接复制粘贴即可,复制到终端突然一个问题:

ok,缺什么我们就安装呗,简单

成功。

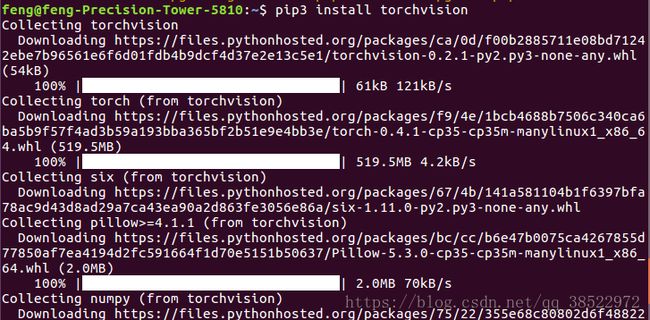

继续安装:

这样我们就在Ubuntu自带的python安装好pytorch了。为了验证我们是否安装成功,可以这样:

python3

import torch5,测试

测试图像:

python3 demo.py --indir ${img_directory} --outdir examples/res 测试视频并保存

python3 video_demo.py --video ${path to video} --outdir examples/res --save_video测试摄像头

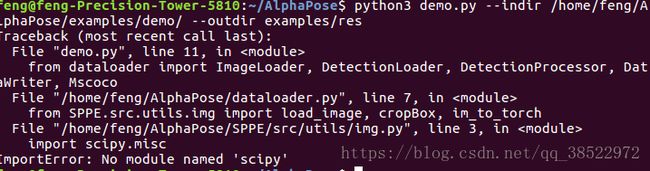

python3 webcam_demo.py --webcam 0 --outdir examples/res --vis到此应该就没问题,我手头正好有个视频,想测试一下,期待结果,结果出现一个问题

这个简单,少啥补啥呗

检测视频:

结果视频会保存来,如图:

如果先看整体效果图可以从我的百度云里看:

链接:https://pan.baidu.com/s/14gXJBa9yu9REIswxTOjHZg

提取码:2rzg