ID生成方案,基于twitter的snowflake分布式ID生成改造,在集群环境中多实例自动分配snowflake的workId,dataCenterId;如果是小项目小业务不需要考虑,直接基本snowflake在配置文件中配置即可,本项目将会在docker swarm 和 k8s中部署测试。

源码

- coding

# 单机多实例不同端口

git clone -b single-v1.0 https://git.dev.tencent.com/liangxiaobo/uuid-generate.git

# Docker Swarm集群模式

git clone -b cluster-v1.0 https://git.dev.tencent.com/liangxiaobo/uuid-generate.git

# k8s集群模式

git clone -b cluster-k8s-v1.0 https://git.dev.tencent.com/liangxiaobo/uuid-generate.git

- github

# 单机多实例不同端口

git clone -b single-v1.0 https://github.com/liangxiaobo/uuid-generate.git

# Docker Swarm集群模式

git clone -b cluster-v1.0 https://github.com/liangxiaobo/uuid-generate.git

# k8s集群模式

git clone -b cluster-k8s-v1.0 https://git.dev.tencent.com/liangxiaobo/uuid-generate.git

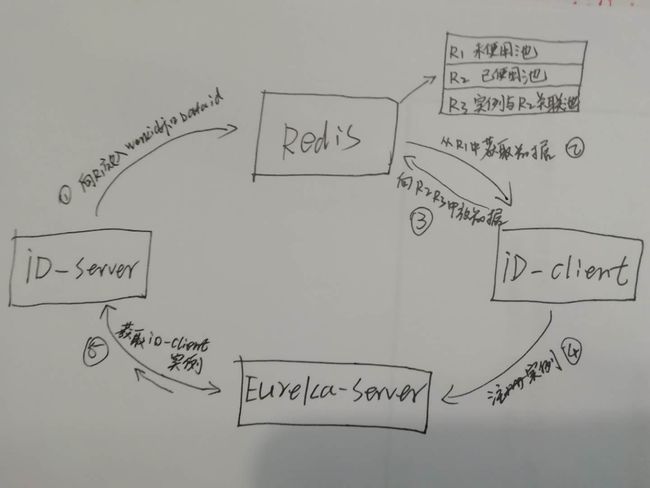

项目思路

- 以Eureka为注册中心

- Redis 存储

- ID-Server 配置种子数据的初始化并处理过期的配置种子

- ID-Client ID生成服务

定义简称

- Redis中自定义的三个存储简称 R1(未全用池)、R2(已使用池)、R3(id-client实例和R2中的数据关联池)

- workId和dataCenterId简称WD

大概思路是:

- 由一个应用ID-Server主动创建足够量的workId和DataCenterId,放到Redis中的R1中

- ID-Client是ID生成服务,需要配置workId和dataCenterId,所以启动时第一步从Redis的R1中读取可用的worId和dataCenterId,

第二步把拿到的可用WD放到放到R2中,第三步获取当前Eureka-client客户端的实例ID和刚才放入R2的数据关联放R3中,在此同时ID-Client也向Eureka-Server注册 - ID-Server会获取Eureka-Server中ID-Client的注册实例列表,定时判断,R3中的列表数据和Eureka-Server中的实例列表的差异,如果有差异表示有机器实例Down了,ID-Server主动收回R2中的数据给R1,并删除R3中无效应用实例的数据

ID-Server

当前设计ID-Server只能跑一个实例;

- 当ID-Server第一次运行,这时候Redis中的R1是空的,需要初始化配置数据(workId,dataCenterId 后面简称WD),配置文件中自定义参数

spring:

application:

name: uuid-server

redis: # redis配置 ========================

host: localhost

port: 6379

timeout: 5000ms

server:

port: 8082

eureka:

client:

registryFetchIntervalSeconds: 5

service-url:

defaultZone: http://localhost:8761/eureka/

fetch-registry: true # 只需要拉取注册表就可以

register-with-eureka: false # 不需要向Eureka注册

uuid:

# ID生成器的应用名称

client-application-name: uuid-snowflake-client

# 机器数量,默认2台,最大31*31=961台

machine-count: 10

# 同步检测已使用池中的数据和eureka注册表中的实例数30秒,生产环境设置10分钟以上

task-execution-interval: 30

R1 中存的是一个Map数据格式[{1:{workId:1,dataCenterId:1}}, {2:{workId:1,dataCenterId:2}}, ...]

R2 中存的数据格式Map [{1:{workId:1,dataCenterId:1}}, {2:{workId:1,dataCenterId:2}}, ...]

R3 中的数据格式 Map [{"实例1": 1}, {"实例2": 2}]

- 如果是重启ID-Server会主动去读取Redis中R1池中未被使用的WD

- 监控Redis中R3的数据列表,与Eureka-Server中的ID-Client实例列表相对比差异

ID-Client

- 启动时从Redis中的R1中取一个WD放到R2中,并和取出来的WD的KEY 关联后放到R3中记录

配置文件中需要注意的是:

......

eureka:

instance:

leaseRenewalIntervalInSeconds: 10

# 如果是集群模式部署,instance-id值必须设置

instance-id: ${spring.application.name}:${server.port}:${random.int}

......

- snowflake以单例模式运行

运行-单机

注意:运行顺序 Eureka-Server => ID-Server => ID-Client

单机多实例不同端口测试,跑两个实例端口分别是8121和8123

2019-06-10 19:25:55.910 INFO 39078 --- [freshExecutor-0] com.netflix.discovery.DiscoveryClient : Getting all instance registry info from the eureka server

2019-06-10 19:25:55.914 INFO 39078 --- [freshExecutor-0] com.netflix.discovery.DiscoveryClient : The response status is 200

2019-06-10 19:25:56.201 INFO 39078 --- [ main] c.l.u.s.s.u.Runner.SnowflakeRunner : 未使用DataPoolMap 10

2019-06-10 19:25:56.215 INFO 39078 --- [ main] c.l.u.s.s.u.Runner.SnowflakeRunner : 1. 应用 uuid-snowflake-client:8121:-1696405068 抽到的 key 8 value 为 UuidDataItemModel{workId=1, dataCenterId=8}

2019-06-10 19:25:56.215 INFO 39078 --- [ main] c.l.u.s.s.u.Runner.SnowflakeRunner : 2. 将抽到的数据到放已经使用的池子里

2019-06-10 19:25:56.228 INFO 39078 --- [ main] c.l.u.s.s.u.Runner.SnowflakeRunner : 3. 查询已使用池子数据 {8=UuidDataItemModel{workId=1, dataCenterId=8}}

2019-06-10 19:25:56.234 INFO 39078 --- [ main] c.l.u.s.s.u.Runner.SnowflakeRunner : 4. 查询应用和数据种子关联的池子 {uuid-snowflake-client:8121:-1696405068=8}

2019-06-10 19:25:56.234 INFO 39078 --- [ main] c.l.u.s.s.u.Runner.SnowflakeRunner : ============== 设置完成 workId=1, dataCenterId=8

第二个应用启动

2019-06-10 19:27:59.992 INFO 39088 --- [ main] io.lettuce.core.EpollProvider : Starting without optional epoll library

2019-06-10 19:27:59.993 INFO 39088 --- [ main] io.lettuce.core.KqueueProvider : Starting without optional kqueue library

2019-06-10 19:28:05.117 INFO 39088 --- [ main] c.l.u.s.s.u.Runner.SnowflakeRunner : 未使用DataPoolMap 9

2019-06-10 19:28:05.129 INFO 39088 --- [ main] c.l.u.s.s.u.Runner.SnowflakeRunner : 1. 应用 uuid-snowflake-client:8123:-70110274 抽到的 key 1 value 为 UuidDataItemModel{workId=1, dataCenterId=1}

2019-06-10 19:28:05.129 INFO 39088 --- [ main] c.l.u.s.s.u.Runner.SnowflakeRunner : 2. 将抽到的数据到放已经使用的池子里

2019-06-10 19:28:05.138 INFO 39088 --- [ main] c.l.u.s.s.u.Runner.SnowflakeRunner : 3. 查询已使用池子数据 {1=UuidDataItemModel{workId=1, dataCenterId=1}, 8=UuidDataItemModel{workId=1, dataCenterId=8}}

2019-06-10 19:28:05.147 INFO 39088 --- [ main] c.l.u.s.s.u.Runner.SnowflakeRunner : 4. 查询应用和数据种子关联的池子 {uuid-snowflake-client:8121:-1696405068=8, uuid-snowflake-client:8123:-70110274=1}

2019-06-10 19:28:05.147 INFO 39088 --- [ main] c.l.u.s.s.u.Runner.SnowflakeRunner : ============== 设置完成 workId=1, dataCenterId=1

访问 http://localhost:8121/generator/id 和 http://localhost:8123/generator/id

生成ID服务的端口:8121, workId: 1, dateCenterId: 8

生成ID服务的端口:8123, workId: 1, dateCenterId: 1

运行-集群模式-docker swarm

在现有的docker swarm环境中部署,这里不讲如何打包成docker image

docker swarm 的编排配置

https://github.com/liangxiaobo/uuid-generate/blob/cluster-v1.0/docker-swarm-compose.yml测试结果

[root@manager uuid-generate]# docker service ls

ID NAME MODE REPLICAS IMAGE PORTS

gjjf0oaou5zg id-app_uuid-eureka-server replicated 1/1 172.16.10.192:5000/bobo/uuid-eureka-server:latest *:8761->8761/tcp

wmwusdo737pm id-app_uuid-server replicated 1/1 172.16.10.192:5000/bobo/uuid-server:latest *:8082->8082/tcp

y97ceng663iz id-app_uuid-snowflake-client replicated 2/2 172.16.10.192:5000/bobo/uuid-snowflake-client:latest *:8123->8123/tcp

部署完成后可访问,你集群IP:端口,http://ip:8123/generator/id 多刷新几次

id-app_uuid-snowflake-client.2.0tkgecz302jw@work2 | 2019-06-12 17:16:50.522 INFO 1 --- [nio-8123-exec-2] o.s.web.servlet.DispatcherServlet : Completed initialization in 12 ms

id-app_uuid-snowflake-client.2.0tkgecz302jw@work2 | 2019-06-12 17:16:50.559 INFO 1 --- [nio-8123-exec-2] c.l.u.s.s.u.c.SnowflakeController : 生成ID服务的端口:8123, workId: 1, dateCenterId: 3

id-app_uuid-snowflake-client.2.0tkgecz302jw@work2 | 单例模式 ===== 进入

id-app_uuid-snowflake-client.2.0tkgecz302jw@work2 | 2019-06-12 17:19:16.838 INFO 1 --- [nio-8123-exec-4] c.l.u.s.s.u.c.SnowflakeController : 生成ID服务的端口:8123, workId: 1, dateCenterId: 3

id-app_uuid-snowflake-client.2.0tkgecz302jw@work2 | 2019-06-12 17:19:17.056 INFO 1 --- [nio-8123-exec-6] c.l.u.s.s.u.c.SnowflakeController : 生成ID服务的端口:8123, workId: 1, dateCenterId: 3

id-app_uuid-snowflake-client.2.0tkgecz302jw@work2 | 2019-06-12 17:19:17.238 INFO 1 --- [nio-8123-exec-8] c.l.u.s.s.u.c.SnowflakeController : 生成ID服务的端口:8123, workId: 1, dateCenterId: 3

id-app_uuid-snowflake-client.1.gxkc7k0xuyph@manager | 2019-06-12 17:21:23.632 INFO 1 --- [nio-8123-exec-7] o.a.c.c.C.[Tomcat].[localhost].[/] : Initializing Spring DispatcherServlet 'dispatcherServlet'

id-app_uuid-snowflake-client.1.gxkc7k0xuyph@manager | 2019-06-12 17:21:23.632 INFO 1 --- [nio-8123-exec-7] o.s.web.servlet.DispatcherServlet : Initializing Servlet 'dispatcherServlet'

id-app_uuid-snowflake-client.1.gxkc7k0xuyph@manager | 2019-06-12 17:21:23.640 INFO 1 --- [nio-8123-exec-7] o.s.web.servlet.DispatcherServlet : Completed initialization in 8 ms

id-app_uuid-snowflake-client.1.gxkc7k0xuyph@manager | 2019-06-12 17:21:23.673 INFO 1 --- [nio-8123-exec-7] c.l.u.s.s.u.c.SnowflakeController : 生成ID服务的端口:8123, workId: 1, dateCenterId: 9

id-app_uuid-snowflake-client.1.gxkc7k0xuyph@manager | 单例模式 ===== 进入

id-app_uuid-snowflake-client.1.gxkc7k0xuyph@manager | 2019-06-12 17:22:35.978 INFO 1 --- [nio-8123-exec-6] c.l.u.s.s.u.c.SnowflakeController : 生成ID服务的端口:8123, workId: 1, dateCenterId: 9

id-app_uuid-snowflake-client.1.gxkc7k0xuyph@manager | 2019-06-12 17:22:36.057 INFO 1 --- [nio-8123-exec-8] c.l.u.s.s.u.c.SnowflakeController : 生成ID服务的端口:8123, workId: 1, dateCenterId: 9

id-app_uuid-snowflake-client.1.gxkc7k0xuyph@manager | 2019-06-12 17:22:36.143 INFO 1 --- [io-8123-exec-10] c.l.u.s.s.u.c.SnowflakeController : 生成ID服务的端口:8123, workId: 1, dateCenterId: 9

id-app_uuid-snowflake-client.1.gxkc7k0xuyph@manager | 2019-06-12 17:22:36.225 INFO 1 --- [nio-8123-exec-2] c.l.u.s.s.u.c.SnowflakeController : 生成ID服务的端口:8123, workId: 1, dateCenterId: 9

运行-集群模式 k8s 部署

需要注意

1. 本实例在k8s中 uuid-eureka-server和uuid-server 只部署一个实例

2. 使用的docker私有库,请参考[k8s 从私有仓库拉取镜像](https://www.jianshu.com/p/3f24bbee72ad)

重新打包上传docker image

cd uuid-eureka-server/

mvn package docker:build -Dmaven.test.skip=true

cd uuid-server/

mvn package docker:build -Dmaven.test.skip=true

cd uuid-snowflake-client/

mvn package docker:build -Dmaven.test.skip=true

重新 docker push image

同上

执行

- 先发布Eureka-Server, 执行根目录的 eureka-k8s.yaml

kubectl create -f eureka-k8s.yaml

- 执行发布 uuid-server和uuid-snowflake-client 执行根目录的 uuid-k8s.yaml

kubectl create -f uuid-k8s.yaml

结果

查看pod

[root@master work]# kubectl get pod -o wide

NAME READY STATUS RESTARTS AGE IP NODE NOMINATED NODE READINESS GATES

nginx-65f88748fd-s9727 1/1 Running 1 27h 10.244.1.4 node1

uuid-eureka-server-0 1/1 Running 0 52m 10.244.1.37 node1

uuid-server-68c4b867c-7qt8p 1/1 Running 0 50m 10.244.1.38 node1

uuid-snowflake-client-866764b58-ltdc6 1/1 Running 0 50m 10.244.1.39 node1

uuid-snowflake-client-866764b58-nh6gl 1/1 Running 0 50m 10.244.2.25 node2

查看service

[root@master work]# kubectl get svc

NAME TYPE CLUSTER-IP EXTERNAL-IP PORT(S) AGE

kubernetes ClusterIP 10.1.0.1 443/TCP 29h

nginx NodePort 10.1.193.136 80:30057/TCP 27h

uuid-eureka-server NodePort 10.1.8.102 8761:32297/TCP 56m

uuid-snowflake-client NodePort 10.1.103.35 8123:31968/TCP 54m

其中访问 eureka-server地址 http://IP:32297 访问id生成服务 http://IP:31968/generator/id

- uuid-server的日志

INFO 1 --- [pool-7-thread-1] c.l.u.s.u.UuidServerApplication : 应用关联的种子 2

INFO 1 --- [pool-7-thread-1] c.l.u.s.u.UuidServerApplication : 服务应用注册数量: 2

应用关联的种子 和 服务应用注册数量 相等时,表示正常,否则表示有异常

注意

uuid-server项目主要工作是初始化 workid和dataCenterId到redis中,并监控redis中的关联池与实际Eureka-server中注册服务的变化,

监控的任务task-execution-interval: 30默认30秒执行一次,由于在生产环境中,uuid-snowflake-client注册的数量不确定,所以需要设置足够大的时长,10分钟以上,

30秒为测试环境。