Download Middleware(下载中间件)

Download Middleware是Scrapy的请求/响应处理的钩子框架。它是一个轻量级的低级系统,用于全局改变Scrapy的请求和响应。常用来添加代理,添加cookie,失败重新发起请求等等。

激活Download Middleware

要激活Download Middleware,请在settings.py中激活 DOWNLOADER_MIDDLEWARES设置,该设置是一个dict,其键是中间件类路径,其值是中间件命令。

这是一个例子:

DOWNLOADER_MIDDLEWARES = {

'myproject.middlewares.CustomDownloaderMiddleware': 543,

}

在之前的代码运行时,我们在日志可以看到很多downloadermiddlewares默认被配置启动,这些是通过DOWNLOADER_MIDDLEWARES_BASE配置的。

2019-04-07 15:28:48 [scrapy.middleware] INFO: Enabled downloader middlewares:

['scrapy.downloadermiddlewares.robotstxt.RobotsTxtMiddleware',

'scrapy.downloadermiddlewares.httpauth.HttpAuthMiddleware',

'scrapy.downloadermiddlewares.downloadtimeout.DownloadTimeoutMiddleware',

'scrapy.downloadermiddlewares.defaultheaders.DefaultHeadersMiddleware',

'scrapy.downloadermiddlewares.useragent.UserAgentMiddleware',

'scrapy.downloadermiddlewares.retry.RetryMiddleware',

'scrapy.downloadermiddlewares.redirect.MetaRefreshMiddleware',

'scrapy.downloadermiddlewares.httpcompression.HttpCompressionMiddleware',

'scrapy.downloadermiddlewares.redirect.RedirectMiddleware',

'scrapy.downloadermiddlewares.cookies.CookiesMiddleware',

'scrapy.downloadermiddlewares.stats.DownloaderStats']

2019-04-07 15:28:48 [scrapy.middleware] INFO: Enabled spider middlewares:

['scrapy.spidermiddlewares.httperror.HttpErrorMiddleware',

'scrapy.spidermiddlewares.offsite.OffsiteMiddleware',

'scrapy.spidermiddlewares.referer.RefererMiddleware',

'scrapy.spidermiddlewares.urllength.UrlLengthMiddleware',

'scrapy.spidermiddlewares.depth.DepthMiddleware']

如果要禁用内置中间件DOWNLOADER_MIDDLEWARES_BASE默认定义和启用的中间件 ,则必须在项目的DOWNLOADER_MIDDLEWARES设置中定义它为None。例如,如果要禁用用户代理中间件:

DOWNLOADER_MIDDLEWARES = {

'myproject.middlewares.CustomDownloaderMiddleware': 543,

'scrapy.downloadermiddlewares.useragent.UserAgentMiddleware': None,

}

编写自己的下载中间件

每个中间件组件都是一个Python类,它定义了以下一种或多种方法:

1、process_request(request, spider)

对于通过Download Middleware的每个请求,都会调用此方法。

process_request()应该:返回None,返回一个 Response对象,返回一个Request对象,或者抛出IgnoreRequest异常。

如果它返回None,Scrapy将继续处理此请求,执行所有其他中间件,直到最后。这个对整个框架没什么影响。

如果它返回一个Response对象,Scrapy将不再调用其他process_request()或process_exception()方法。在每次Response时,已安装的中间件的process_response()方法都会被调用。

如果它返回一个Request对象,Scrapy将停止调用process_request方法并重新安排返回的请求。从而循环往复地调度Request。

如果它引发IgnoreRequest异常,已安装的下载中间件的process_exception()方法将被调用。如果它们都不处理异常,则调用request()(Request.errback)中的errback函数。如果没有代码处理引发的异常,则会忽略它并且不会记录。

参数:

- request(

Request对象) - 正在处理的请求 - spider(

Spider对象) - 此请求所针对的蜘蛛

2、process_response (request,response,spider)

process_response()应该:返回一个Response对象,返回一个Request对象或抛出IgnoreRequest异常。

如果它返回 Response,将继续处理下一个中间件的process_response()。也就是对其他中间件没影响。

如果它返回一个Request对象,就不会调用process_response(),而是将process_request()重新加入到调度队列。

如果它引发IgnoreRequest异常,已安装的下载中间件的process_exception()方法将被调用。如果它们都不处理异常,则调用request()(Request.errback)中的errback函数。如果没有代码处理引发的异常,则会忽略它并且不会记录。

参数:

- request(

Request对象) - 发起响应的请求 - response(

Response对象) - 正在处理的响应 - spider(

Spider对象) - 此响应所针对的蜘蛛

3、process_exception(requset, exception, spider)

process_exception()应该返回:要么None是Response对象,要么是Request对象。

如果它返回None,Scrapy将继续处理此异常,执行任何其他已安装中间件的process_exception()方法,直到没有剩下中间件并且默认异常处理开始。

如果它返回一个Response对象,process_response()则启动已安装的中间件的方法链,并且Scrapy不会调用任何其他process_exception()中间件方法。

如果它返回一个Request对象,则重新安排返回的请求以便将来下载。这会停止执行process_exception()中间件的方法,就像返回响应一样。这个用于失败重复调用时很有用。

参数:

- request(是一个

Request对象) - 生成异常的请求 - exception(一个

Exception对象) - 引发的异常 - spider(

Spider对象) - 此请求所针对的蜘蛛

案例

1、通过process_request()设置代理

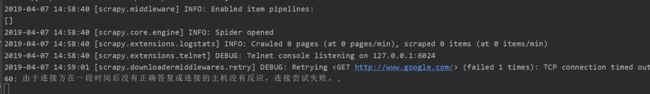

1、新建一个访问谷歌的爬虫程序,正常来说谷歌是没法访问的

2、通过process_request()设置代理

在middlewares.py中添加以下类,这里我本地有个1080端口的代理。

import logging

class ProxyMiddleware(object):

logger = logging.getLogger(__name__)

def process_request(self, request, spider):

self.logger.debug('Using Proxy')

request.meta['proxy'] = 'http://127.0.0.1:1080'

return None #可以省略

3、激活配置

在settings.py修改设置:

# Obey robots.txt rules

ROBOTSTXT_OBEY = False

# Override the default request headers:

DEFAULT_REQUEST_HEADERS = {

'user-agent': 'Mozilla/5.0 (Windows NT 10.0; WOW64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/72.0.3626.121 Safari/537.36',

'Accept-Language': 'en',

}

# Enable or disable downloader middlewares

# See http://scrapy.readthedocs.org/en/latest/topics/downloader-middleware.html

DOWNLOADER_MIDDLEWARES = {

'google.middlewares.ProxyMiddleware': 543,

}

这里将ROBOTSTXT_OBEY设置为False的原因见:https://blog.csdn.net/zzk1995/article/details/51628205

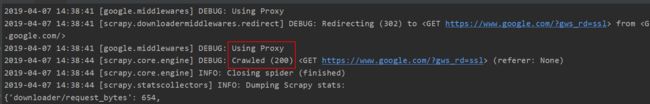

4、运行结果

在命令行中运行scrapy crawl mygoogle

返回200状态码 成功

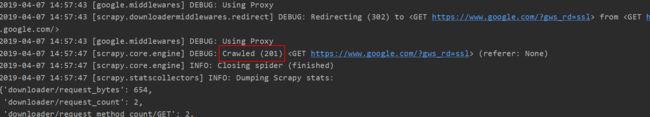

2、改写Response

1、通过process_response()修改状态码,其余配置和例子1一样

import logging

class ProxyMiddleware(object):

logger = logging.getLogger(__name__)

def process_request(self, request, spider):

self.logger.debug('Using Proxy')

request.meta['proxy'] = 'http://127.0.0.1:1080'

return None

def process_response(self, request, response, spider):

response.status = 201

return response

2、运行结果

可以看到状态码发生了改变

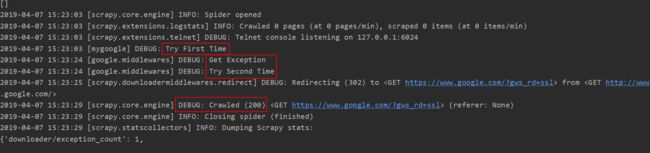

3、爬取失败后重试

其余配置和上述例子相同

1、自定义request函数,并且定义最大等待时长10s

import scrapy

class MygoogleSpider(scrapy.Spider):

name = "mygoogle"

allowed_domains = ["www.google.com"]

start_urls = ['http://www.google.com/']

def make_requests_from_url(self, url):

self.logger.debug('Try First Time')

return scrapy.Request(url=url, meta={'downlord_timeout': 10}, callback=self.parse, dont_filter=True)

def parse(self, response):

pass

2、关闭失败重连接,否则要等待很久

在settings.py中修改

# Enable or disable downloader middlewares

# See http://scrapy.readthedocs.org/en/latest/topics/downloader-middleware.html

DOWNLOADER_MIDDLEWARES = {

'google.middlewares.ProxyMiddleware': 543,

'scrapy.downloadermiddlewares.retry.RetryMiddleware': None,

}

3、添加失败后更换代理重连

import logging

class ProxyMiddleware(object):

logger = logging.getLogger(__name__)

# def process_request(self, request, spider):

# self.logger.debug('Using Proxy')

# request.meta['proxy'] = 'http://127.0.0.1:1080'

# return None

#

# def process_response(self, request, response, spider):

# response.status = 201

# return response

def process_exception(self, request, exception, spider):

self.logger.debug('Get Exception')

self.logger.debug('Try Second Time')

request.meta['proxy'] = 'http://127.0.0.1:1080'

return request

4、运行结果

参考:https://docs.scrapy.org/en/1.3/topics/downloader-middleware.html