进程和程序的区别

编写完毕的代码,在没有运行的时候,称之为程序

正在运行着的代码,就成为进程

进程,除了包含代码以外,还有需要运行的环境等,所以和程序是有区别的

进程的创建方法

创建进程之一fork( )

Python的os模块封装了常见的系统调用,其中就包括fork,可以在Python程序中轻松创建子进程

import os

# 注意,fork函数,只在Unix/Linux/Mac上运行,windows不可以

pid = os.fork() #调用os中fork方法,创建子进程

if pid == 0:

print('哈哈1')

else:

print('哈哈2')

非常值得注意的就是fork()的返回值。

- 子进程永远返回0,而父进程返回子进程的ID。

- 程序执行到os.fork()时,操作系统会创建一个新的进程(子进程),然后复制父进程的所有信息到子进程中

- 然后父进程和子进程都会从fork()函数中得到一个返回值,在子进程中这个值一定是0,而父进程中是子进程的 id号

创建进程之二

在上面我们在写代码块的时候,加了一句话,fork()在windows上是没有的,那有的小伙伴就会很疑问的说:那我在windows上就不能编写多进程的程序了吗?当然不是,由于Python是跨平台的,自然也应该提供一个跨平台的多进程支持。multiprocessing模块就是跨平台版本的多进程模块。

multiprocessing模块提供了一个Process类来代表一个进程对象

from multiprocessing import Process

import time

class c_process(Process):

def __init__(self):

super().__init__()

def run(self):

# time.sleep(3)

for i in range(5):

time.sleep(1)

print("hah")

p = c_process()

p.start()

p.join()

print("我是父进程")

"""

Process([group [, target [, name [, args [, kwargs]]]]])

target:表示这个进程实例所调用对象;

args:表示调用对象的位置参数元组;

kwargs:表示调用对象的关键字参数字典;

name:为当前进程实例的别名;

group:大多数情况下用不到;

Process类常用方法:

is_alive():判断进程实例是否还在执行;

join([timeout]):是否等待进程实例执行结束,或等待多少秒;

start():启动进程实例(创建子进程);

run():如果没有给定target参数,对这个对象调用start()方法时,就将执行对象中的run()方法;

terminate():不管任务是否完成,立即终止;

Process类常用属性:

name:当前进程实例别名,默认为Process-N,N为从1开始递增的整数;

pid:当前进程实例的PID值;

"""

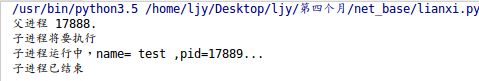

直观方法

#coding=utf-8

from multiprocessing import Process

import os

# 子进程要执行的代码

def run_proc(name):

print('子进程运行中,name= %s ,pid=%d...' % (name, os.getpid()))

if __name__=='__main__':

print('父进程 %d.' % os.getpid())

p = Process(target=run_proc, args=('test',))

print('子进程将要执行')

p.start()

p.join()

print('子进程已结束')

在实际开发中,我们一般不会用fork,因为它不支持windows哈哈。

需要注意

- 创建子进程时,只需要传入一个执行函数和函数的参数,创建一个Process实例,用start()方法启动,这样创建进程比fork()还要简单。

- join()方法可以等待子进程结束后再继续往下运行,通常用于进程间的同步。

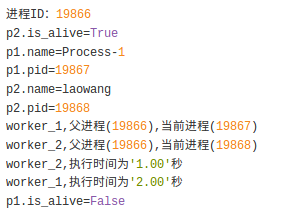

实例

#coding=utf-8

from multiprocessing import Process

import time

import os

#两个子进程将会调用的两个方法

def worker_1(interval):

print("worker_1,父进程(%s),当前进程(%s)"%(os.getppid(),os.getpid()))

t_start = time.time()

time.sleep(interval) #程序将会被挂起interval秒

t_end = time.time()

print("worker_1,执行时间为'%0.2f'秒"%(t_end - t_start))

def worker_2(interval):

print("worker_2,父进程(%s),当前进程(%s)"%(os.getppid(),os.getpid()))

t_start = time.time()

time.sleep(interval)

t_end = time.time()

print("worker_2,执行时间为'%0.2f'秒"%(t_end - t_start))

#输出当前程序的ID

print("进程ID:%s"%os.getpid())

#创建两个进程对象,target指向这个进程对象要执行的对象名称,

#args后面的元组中,是要传递给worker_1方法的参数,

#因为worker_1方法就一个interval参数,这里传递一个整数2给它,

#如果不指定name参数,默认的进程对象名称为Process-N,N为一个递增的整数

p1=Process(target=worker_1,args=(2,))

p2=Process(target=worker_2,name=“lawang",args=(1,))

#使用"进程对象名称.start()"来创建并执行一个子进程,

#这两个进程对象在start后,就会分别去执行worker_1和worker_2方法中的内容

p1.start()

p2.start()

#同时父进程仍然往下执行,如果p2进程还在执行,将会返回True

print("p2.is_alive=%s"%p2.is_alive())

#输出p1和p2进程的别名和pid

print("p1.name=%s"%p1.name)

print("p1.pid=%s"%p1.pid)

print("p2.name=%s"%p2.name)

print("p2.pid=%s"%p2.pid)

#join括号中不携带参数,表示父进程在这个位置要等待p1进程执行完成后,

#再继续执行下面的语句,一般用于进程间的数据同步,如果不写这一句,

#下面的is_alive判断将会是True,在shell(cmd)里面调用这个程序时

#可以完整的看到这个过程,大家可以尝试着将下面的这条语句改成p1.join(1),

#因为p2需要2秒以上才可能执行完成,父进程等待1秒很可能不能让p1完全执行完成,

#所以下面的print会输出True,即p1仍然在执行

p1.join()

print("p1.is_alive=%s"%p1.is_alive())

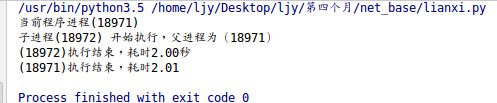

进程的创建之三

创建新的进程还能够使用类的方式,可以自定义一个类,继承Process类,每次实例化这个类的时候,就等同于实例化一个进程对象

from multiprocessing import Process

import time

import os

#继承Process类

class Process_Class(Process):

#因为Process类本身也有__init__方法,这个子类相当于重写了这个方法,

#但这样就会带来一个问题,我们并没有完全的初始化一个Process类,所以就不能使用从这个类继承的一些方法和属性,

#最好的方法就是将继承类本身传递给Process.__init__方法,完成这些初始化操作

def __init__(self,interval):

Process.__init__(self)

self.interval = interval

#重写了Process类的run()方法

def run(self):

print("子进程(%s) 开始执行,父进程为(%s)"%(os.getpid(),os.getppid()))

t_start = time.time()

time.sleep(self.interval)

t_stop = time.time()

print("(%s)执行结束,耗时%0.2f秒"%(os.getpid(),t_stop-t_start))

if __name__=="__main__":

t_start = time.time()

print("当前程序进程(%s)"%os.getpid())

p1 = Process_Class(2)

#对一个不包含target属性的Process类执行start()方法,就会运行这个类中的run()方法,所以这里会执行p1.run()

p1.start()

p1.join()

t_stop = time.time()

print("(%s)执行结束,耗时%0.2f"%(os.getpid(),t_stop-t_start))

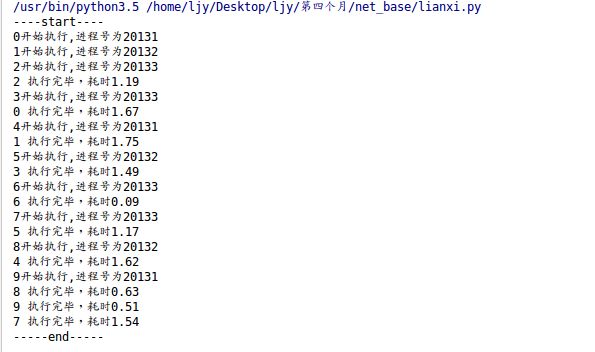

进程的创建之四

进程池,我们理解字面意思,就是存放进程的池子,可以为我们动态生成很多个进程。

当需要创建的子进程数量不多时,可以直接利用multiprocessing中的Process动态成生多个进程,但如果是上百甚至上千个目标,手动的去创建进程的工作量巨大,此时就可以用到multiprocessing模块提供的Pool方法。

当然,虽然池子很大,也是可以指定容量的。

初始化Pool时,可以指定一个最大进程数,当有新的请求提交到Pool中时,如果池还没有满,那么就会创建一个新的进程用来执行该请求;但如果池中的进程数已经达到指定的最大值,那么该请求就会等待,直到池中有进程结束,才会创建新的进程来执行

实例

from multiprocessing import Pool

import os,time,random

def worker(msg):

t_start = time.time()

print("%s开始执行,进程号为%d"%(msg,os.getpid()))

#random.random()随机生成0~1之间的浮点数

time.sleep(random.random()*2)

t_stop = time.time()

print(msg,"执行完毕,耗时%0.2f"%(t_stop-t_start))

po=Pool(3) #定义一个进程池,最大进程数3

for i in range(0,10):

#Pool.apply_async(要调用的目标,(传递给目标的参数元祖,))

#每次循环将会用空闲出来的子进程去调用目标

po.apply_async(worker,(i,))

print("----start----")

po.close() #关闭进程池,关闭后po不再接收新的请求

po.join() #等待po中所有子进程执行完成,必须放在close语句之后

print("-----end-----")

multiprocessing.Pool常用函数解析:

- apply_async(func[, args[, kwds]]) :使用非阻塞方式调用func(并行执行,堵塞方式必须等待上一个进程退出才能执行下一个进程),args为传递给func的参数列表,kwds为传递给func的关键字参数列表;

- apply(func[, args[, kwds]]):使用阻塞方式调用func

- close():关闭Pool,使其不再接受新的任务;

- terminate():不管任务是否完成,立即终止;

- join():主进程阻塞,等待子进程的退出, 必须在close或terminate之后使用;

apply阻塞式

from multiprocessing import Pool

import os,time,random

def worker(msg):

t_start = time.time()

print("%s开始执行,进程号为%d"%(msg,os.getpid()))

#random.random()随机生成0~1之间的浮点数

time.sleep(random.random()*2)

t_stop = time.time()

print(msg,"执行完毕,耗时%0.2f"%(t_stop-t_start))

po=Pool(3) #定义一个进程池,最大进程数3

for i in range(0,10):

po.apply(worker,(i,))

print("----start----")

po.close() #关闭进程池,关闭后po不再接收新的请求

po.join() #等待po中所有子进程执行完成,必须放在close语句之后

print("-----end-----")

查看进程ID

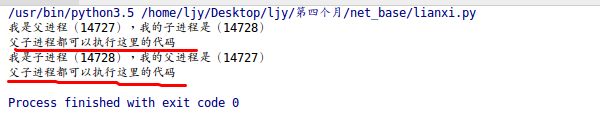

在这里我们会用到连个方法来实现,一个是getpid()和getppid(),前者获取当前进程的ID后者获取父进程的ID

import os

rpid = os.fork()

if rpid<0:

print("fork调用失败。")

elif rpid == 0:

print("我是子进程(%s),我的父进程是(%s)"%(os.getpid(),os.getppid()))

else:

print("我是父进程(%s),我的子进程是(%s)"%(os.getpid(),rpid))

print("父子进程都可以执行这里的代码")

在运行完成上面的代码后我们会看一个很有意思的结果:

红线所示,源代码中的print语句执行了两句,这个也印证了我们在上面所说的: 程序执行到os.fork()时,操作系统会创建一个新的进程(子进程),然后复制父进程的所有信息到子进程中所以,会出现上面红线所示的效果

多进程修改全局变量

虽然我们使用os.fork()开始了子进程,并且复制父进程的信息到子进程中,也执行,但是当父进程中修改变量时,子进程不受影响

import os

import time

num = 0

pid = os.fork()

if pid == 0:

time.sleep(1)

print("执行子进程",num)

else:

time.sleep(3)

num+=1

print('父进程',num)

# 通过返回结果可以看出,在父进程中修改的num,并没有影响全局变量

# 即:多进程中,每个进程中所有数据(包括全局变量)都各有拥有一份,互不影响

多次fork()问题

如果在一个程序,有2次的fork函数调用,是否就会有3个进程呢?

#coding=utf-8

import os

import time

# 注意,fork函数,只在Unix/Linux/Mac上运行,windows不可以

pid = os.fork()

if pid == 0:

print('哈哈1')

else:

print('哈哈2')

pid = os.fork()

if pid == 0:

print('哈哈3')

else:

print('哈哈4')

time.sleep(1)

在此要特别注意的是:**父进程、子进程执行顺序没有规律,完全取决于操作系统的调度算法 **

进程之间的通信 Queue

Process之间有时需要通信,操作系统提供了很多机制来实现进程间的通信。

#coding=utf-8

from multiprocessing import Queue

q=Queue(3) #初始化一个Queue对象,最多可接收三条put消息

q.put("消息1")

q.put("消息2")

print(q.full()) #False

q.put("消息3")

print(q.full()) #True

#因为消息列队已满下面的try都会抛出异常,第一个try会等待2秒后再抛出异常,第二个Try会立刻抛出异常

try:

q.put("消息4",True,2)

except:

print("消息列队已满,现有消息数量:%s"%q.qsize())

try:

q.put_nowait("消息4")

except:

print("消息列队已满,现有消息数量:%s"%q.qsize())

#推荐的方式,先判断消息列队是否已满,再写入

if not q.full():

q.put_nowait("消息4")

#读取消息时,先判断消息列队是否为空,再读取

if not q.empty():

for i in range(q.qsize()):

print(q.get_nowait())

理解之方法

初始化Queue()对象时(例如:q=Queue()),若括号中没有指定最大可接收的消息数量,或数量为负值,那么就代表可接受的消息数量没有上限(直到内存的尽头);

* Queue.qsize():返回当前队列包含的消息数量;

- Queue.empty():如果队列为空,返回True,反之False ;

- Queue.full():如果队列满了,返回True,反之False;

- Queue.get([block[, timeout]]):获取队列中的一条消息,然后将其从列队中移除,block默认值为True;

1)如果block使用默认值,且没有设置timeout(单位秒),消息列队如果为空,此时程序将被阻塞(停在读取状态),直到从消息列队读到消息为止,如果设置了timeout,则会等待timeout秒,若还没读取到任何消息,则抛出"Queue.Empty"异常;

2)如果block值为False,消息列队如果为空,则会立刻抛出"Queue.Empty"异常;

* Queue.get_nowait():相当Queue.get(False);

* Queue.put(item,[block[, timeout]]):将item消息写入队列,block默认值为True;

1)如果block使用默认值,且没有设置timeout(单位秒),消息列队如果已经没有空间可写入,此时程序将被阻塞(停在写入状态),直到从消息列队腾出空间为止,如果设置了timeout,则会等待timeout秒,若还没空间,则抛出"Queue.Full"异常;

2)如果block值为False,消息列队如果没有空间可写入,则会立刻抛出"Queue.Full"异常;

- Queue.put_nowait(item):相当Queue.put(item, False);

进程池中的Queue

如果要使用Pool创建进程,就需要使用multiprocessing.Manager()中的Queue(),而不是multiprocessing.Queue(),否则会得到一条如下的错误信息:

RuntimeError: Queue objects should only be shared between processes through inheritance.

from multiprocessing import Manager,Pool

import os,time,random

def reader(q):

print("reader启动(%s),父进程为(%s)"%(os.getpid(),os.getppid()))

for i in range(q.qsize()):

print("reader从Queue获取到消息:%s"%q.get(True))

def writer(q):

print("writer启动(%s),父进程为(%s)"%(os.getpid(),os.getppid()))

for i in "lawang":

q.put(i)

if __name__=="__main__":

print("(%s) start"%os.getpid())

q=Manager().Queue() #使用Manager中的Queue来初始化

po=Pool()

#使用阻塞模式创建进程,这样就不需要在reader中使用死循环了,可以让writer完全执行完成后,再用reader去读取

po.apply(writer,(q,))

po.apply(reader,(q,))

po.close()

po.join()

print("(%s) End"%os.getpid())