12月3日,为期三天的第四届世界互联网大会在浙江乌镇开幕,互联网和科技大佬们广泛讨论人工智能,AI成为本届大会最受关注的领域之一。

提到人工智能在移动手机端的应用,我们往往会立即想到 Siri,Cortana,Alexa , Google assistant 等个人语音助手,通过语音助手帮助解决日常工作的想法吸引了全世界各地的用户。但是,人工智能程序的潜力远不止语音助手,如今移动应用正在使用AI来大幅度提高用户满意度。手机作为与人类用户关系最密切的智能化产品,已成为AI产业的必争之地。

「AI手机」=「芯片」+「框架」+「应用场景」

然而,移动手机在人工智能领域到底将扮演着什么样的角色?它们已经能够独立进行学习,甚至提供类似人工智能等级的服务吗?今天,小线菌想和你分享,配备了人工智能的手机会有什么不同,又会为移动互联网行业带来什么变化。

原来手机可以这么用!

手机作为个人隐私性最强的工具,在公众场合使用手机时,你有没有经常担心旁边或背后有人偷瞄你的手机?

2017年的Neural Information Processing Systems (NIPS)会议于12月4日在加州长岛开幕,这次会议上,谷歌的开发人员Hee Jung Ryu和Florian Schroff打算展示一个应用在Google Pixel手机上的“防偷窥”功能,这个项目称之为「电子屏幕保护器」。只要在Pixel上打开前置摄像头,加上人脸识别和眼动追踪算法,就可以发现除了用户以外,有没有第三只眼在盯着屏幕看。

实际使用时,当它监测到有人偷瞄你的屏幕,无论你的屏幕正在做什么,它都会自动切换成前置摄像头的图像。更让偷窥者难堪的是,它的特写头像会被你的系统特别用红色标红,并且配上snapchat里的呕吐效果。

这个功能的精准度是非常高的,无论什么样的灯光环境,它都可以在0.002秒之内鉴别到“偷窥嫌疑人”。然而通常人类眨眼都需要用到0.12-0.2秒钟,之所以识别速度如此之快,就是由于这款人工智能软件是在手机上直接运行的,而并不需要发送到Google的云处理器上进行处理。

这款产品之所以能够引起注意,主要因为它显示出Google在将人工智能技术融入到手机系统中的野心。实际上,这并不是Google第一次在对眼球的追踪上下功夫,早在几年前,通过一个安置在Google Glass的眼动传感器,就可以识别用户的视线停留在了哪一个广告上,并根据用户瞳孔大小的变化,能够客观判断用户对注视着的广告的情绪反应。

什么是「人工智能手机」

首先,我们需要区分「智能手机」与「人工智能手机」,这就好像是宠物与导盲犬的区别。虽然宠物会服从你的命令,但导盲犬不仅会回应你的命令,而且还会引导你前进,并决定你认为最适合你的东西。

从表面上来看,我们日常使用的智能手机在不少功能上已经相当聪明,比如全自动的照片美化,人脸识别开锁,以及实时翻译,甚至推送到首页的广告都来源于你的搜索和浏览记录。但这是你手机自己“想”出来的结果吗?还不完全是。目前的智能应用几乎都是上传在云端上整理、计算来的模型。本地端的终端手机在人工智能里扮演的角色还只是一个数据收集的终端,甚至连学习都称不上。在上一代智能手机中,AI是基于云服务的,需要访问互联网连接,因此始终觉得这些“助手”离智能还差那么一点点。

去年大火的「Prisma」,在最初时3个神经网络都部署在云端。用户选取照片效果后,手机上的Prisma应用便将照片上传至服务器,云端的卷积神经网络在解读照片后,会根据用户选择的效果重新渲染出一张新照片,并下载到用户的手机上,这个过程即使显著降低图像处理过程的耗时,依旧因为服务器通讯问题越来越慢。随着用户迅速增长,2016年8月,创始人Alexey不得不直接使用iPhone处理器,Prisma成为第一个能够离线运行风格转换神经网络的手机应用。一张1080×1080分辨率的照片,半秒就能转换成全新的风格。可以看出,在手机上部署机器学习算法的需求是极强的。

传统的处理器通常需要成千上万的指令来完成一个神经元的处理。因此,通过云计算来实现这些任务是业界的共识。然而,数据隐私、计算的时效性等问题提醒我们,云端人工智能只是暂时的,端侧人工神经网络的构建才是未来的趋势。

在iPhone X上,我们利用AI算法支持面部识别系统Face ID、动画表情Animoji和增强现实应用AR程序的后台。在Google Pixel 2上,Now Playing功能使用每周更新的10万首歌曲数据库,手机将通过在主屏幕上自动推送通知,立即告知此刻正在播放的歌曲,或者在用户收到一封邮件时给出简短的回复建议。在Mate 10上,AI-vision摄像头扫描周围环境,相应地调整手机的设置,优化性能和用户体验,拍照时,手机还可以识别被拍照的物体,人物或场景。此外,AI引擎也能够补偿低分辨率的图像。如果在设备上查看的图片分辨率较低,则可以预测并补充丢失的像素,使图片可以完整显示和放大。

除此之外,新一代手机上更好的电池性能也部分归功于设备内的人工智能算法。华为表示,其人工智能将使公司的新手机能效提高50倍。设备内的人工智能算法将通过两种方式节省电源:首先,将电源分配给相关功能。所以如果用户没有使用某个功能,那么手机将不允许它不必要地消耗功率。其次,设备内的人工智能意味着不需要太多的云端处理,从而节省电量。

云端处理还有隐私泄露的风险。与之相比,在手机上本地化运行AI功能,不仅享有更快的性能,而且更加方便(不用联网)、隐私保护更好(你的数据不会被脱机发送)。

智能芯片领域竞争加剧

虽然很多手机已经打出了「人工智能手机」的概念,但是它们都没有人工智能需要的核心技术,那就是「AI芯片」。目前只有苹果和华为两家手机厂商可以提供AI芯片,苹果的iPhone 8 和iPhone X使用了仿生芯片A11,华为Mate 10 系列则搭载了华为自主研发麒麟 970 芯片。iPhone 8 在图像的立体化识别表现更优秀,配合新的深度摄像头和陀螺仪等配套硬件,在AR方面的表现更佳。而HUAWEI Mate 10系列似乎更注重在性能和速度上的表现。

与苹果不同的是,华为承载人工智能的麒麟970芯片是基于NPU(Neural Network Processing Unit神经网络单元)专用硬件处理单元。专门用于处理手机端的AI相关任务。处理速度是普通CPU的 25 倍以上。上文提到的实时拍照优化、识物功能正是基于此芯片而运行。

同时,制造和设计芯片的公司(例如高通和ARM)也正准备为业内其他厂商提供AI优化的硬件。采用ARM新发布的"Mail-G72"CPU,麒麟970把GPU的核心数量,从麒麟960时代的8核提升到了12核。三个部分通力协作,GPU和CPU负责计算的速度和力度,NPU则负责计算的深度,而HiAI移动计算架构则负责提高AI性能的密度。计算任务被明确分配,各个模块可以更独立进行资源的调配,就为整体计算工作大大的提高了效率。这样一来,在端侧部署部分AI计算任务就成了可能。

除了华为与苹果两家巨头之间的移动AI芯片卡位战,三星、vivo、小米等厂商自然也不甘落后,不过发力点却并不相同。

今年5月,三星为Galaxy S8配备了自主研发的人工智能平台「Bixby」并开始提供“Bixby Voice”服务。用户甚至可以为Bixby自定义口令,当你最着手机说“晚安,Bixby!”,Bixby就开始将手机调到夜间省电模式,同时关闭微信提醒,开启免打扰模式,设定惯常的 morningcall。9月21日,vivo发布的全面屏X20手机上已经配备了“智慧引擎4.0”功能。该智慧引擎拥有自主学习能力,可以根据用户使用习惯,智能分配CPU资源,管控耗电,维持手机使用流畅。11月28日的小米IoT开发者大会上,小米首席架构师小米人工智能与云平台副总裁崔宝秋表示,智能手机仍然是小米的核心战略,它将成为人工智能的最大平台。

这些尝试无疑将推动新的人机交互变革,我们不再需要去学习如何与机器进行互动,而是让机器去学习如何适应我们的世界。

多元化的AI框架

深度学习框架就是这个品牌的一套积木,各个组件就是某个模型或算法的一部分,你可以自己设计如何使用积木去堆砌符合你数据集的积木。对于手机程序开发者来说,深度学习框架的出现降低了入门的门槛,不再需要从复杂的神经网络开始编代码,你可以依据需要,使用已有的模型,模型的参数你自己训练得到,你也可以在已有模型的基础上增加自己的layer,或者是在顶端选择自己需要的分类器。目前活跃在视野中的移动端人工智能框架中,Facebook的「Caffe2 Go」,Google的「TensorFlow Lite」与Apple 的「CoreML」三足鼎立。

Caffe2

2016年11月,Facebook就已经发布了一个称为Caffe2Go的架构。Caffe2Go用于实时风格转移(Style Transfer),即在用户的移动电话端添加了类艺术(Art-like)过滤器。Caffe2Go最初推出时被使用在「Prisma」的「Style Transfer」以及「Snapchat」的「Filters」,可以在iOS、Android以及Raspberry Pi上通过短短几行代码来训练和部署轻量化模型。

TensorFlow Lite

谷歌今年发布了「TensorFlow lite」,让应用开发者可以在移动设备上部署人工智能。人工智能框架TensorFlow一直运行在许多平台上,从服务器机架到小型物联网设备,但随着过去几年机器学习模型的使用频次呈指数级增长,因此将其部署在移动和嵌入式设备上的需求越来越强烈。

它有以下三点重要特性:

轻量级:支持小 binary size 和快速初始化/启动的设备上机器学习模型的推断

跨平台:支持运行在许多不同平台上,目前支持Android 和iOS

快速:针对移动设备进行了优化,包括显著提高模型的加载时间,并支持硬件加速

目前TensorFlow lite支持「iOS」和「Android」系统。但是如果开发者使用其他系统,也可以经过一系列复杂而冗长的编译流程,将 TensorFlow 编译成移动操作系统所支持的软件库。除此之外,TensorFlow Lite完全可以本地部署,解决了没有联网造成的影响。最后,未来随着终端硬件能力的升级,完全可以做到训练在终端本地完成。

目前,Google已经发布了许多支持针对移动设备优化的模型。其中包括 MobileNet,支持1000多个对象类的计算机视觉,Inception v3 图像识别模型,以及 SmartReplay 自然语言处理模型。这些模型可以在应用程序中立即使用,但开发人员也可以根据需要从自定义数据集中创建自己的模型。

CoreML

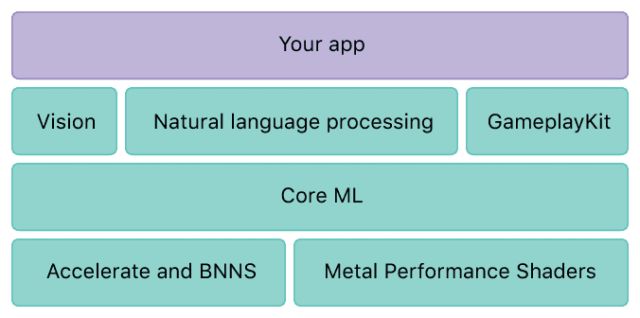

苹果公司在今年 6 月的 WWDC 正式发布了增强现实开发工具 ARKit,以及包含加速 iOS 设备机器学习能力的 CoreML 机器学习框架,它可以在iPhone、Macbook、Apple TV、Apple watch等任何一个苹果设备上使用。

Core ML 其实就是将一些已经训练好的神经网络、支持向量机、线性分析等集成到一个框架里,供开发者来调用。苹果开发者网站上已经有几套训练好的模型可供使用,其中包含了脸部识别、图像识别、自然语言识别等。

AI手机会是未来吗?

业界普遍认为,AI有望成为智能手机的下一个杀手级功能。因为AI技术可以让手机基于用户行为习惯自我学习进而优化、智能感知用户场景、预测用户行为再智能分配资源,确保系统最佳运转等。

而AI算力其实只是底层基础,场景构建才是AI手机的核心。

人工智能的发展正在推动全新的移动应用可能性。从苹果的Siri开始,未来几年它有可能进一步提升。机器学习已经摆脱了起步阶段,用户现在需要灵活的算法来实现无缝和直观的体验。

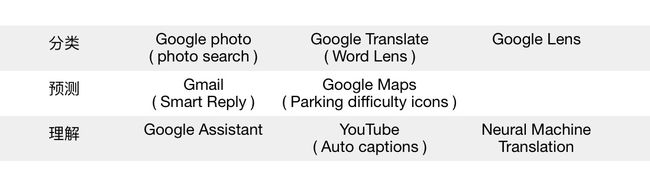

Google AI 和 ML 技术的标杆级产品

但未来随着运算架构与制程的演进,加入手机的传感器类型会不断增加,及像增强现实(AR)、混合现实(MR)等需要本地端计算能力强大到可以与环境互动的应用出现,由手机自己执行的学习、互动以及更智能化的运算功能也会随之普及。

让我们勒紧裤带,拭目以待吧!

参考资料

https://developers.googleblog.com/2017/11/announcing-tensorflow-lite.html

http://36kr.com/p/5079883.html

http://www.sohu.com/a/166005238_354973

http://www.chinaz.com/mobile/2017/1120/829938.shtml

http://36kr.com/p/5106372.html

http://36kr.com/p/5099634.html

http://www.xtecher.com/Xfeature/view?aid=6525

https://code.facebook.com/posts/196146247499076/delivering-real-time-ai-in-the-palm-of-your-hand/