无论是从业者,还是普通企业与个人,凡是关心数据价值,关注数据应用的,都无法绕开一个问题:开放数据的价值点在哪?

将这个问题细分,可以拆成3个更具体的问题:

如何采集开放数据?

开放数据如何做获取、交易、流通?

开放数据如何应用实践?

受知名数据媒体DT财经邀请,发源地大数据创始人兼CEO马建军,10.30晚上8点,在线直播回答了上述问题,并对网友提出的其他问题进行了答疑。

以下是演讲实录,希望能帮助到对此有疑问,但又错过直播的朋友。

——发源地创始人马建军演讲实录——

大家好,很高兴今天能和大家交流关于开放数据商业化的问题。

关于开放数据商业化,我们可从以下3个点展开说:

1.开放数据的采集。

2.开放数据的获取。

3.开放数据的应用实践与变现。

接下来我们结合PPT详细讲解。

/01/

开放数据应用

首先我们先来了解一下,什么叫大数据,以及它的应用场景在哪里,以及未来的市场规模是怎么样的?

大数据和很多行业都相关,理论上,你能想到接触到的任何行业/领域,大数据都可以应用其中。包括房产、金融、汽车等等,特别是最近几年很火的人工智能。大数据的价值在其中体现得淋漓尽致,没有数据,就没有AI(人工智能),也没有机器学习,深度挖掘等。

而(开放)数据的应用场景主要包括3大块:

①一个是企业需要数据做调研、挖掘、分析,我们统称为数据分析;

②二个就是数据可以做一些早前项目的运营启动,或者运营过程中的一些数据支撑,我们统称为运营启动;

③三个就是精准营销。在国内,(开放数据应用)在精准营销这块,增长空间非常大,而且非常落地,做得非常好。

具体的一些其他应用场景还可以细分,理论上都包含在这3大块内,这3点也是企业对开放数据的需求所在。

说到开放数据的市场空间规模,大家看图就可以了解,我就不多说了。

其实从12、13年开始,大数据(应用)就已经慢慢落地了。

15年左右,(开放数据用于)精准营销已经落地了。

运营启动,16年的时候,一些公司已经开始落地了,类似企查查、天眼查这类企业非常有代表性,大家可以了解。

至于说数据分析,这10多年来一直不温不火,在国内短期内可能很难落地。

/02/

开放数据获取

大数据其实包含两类,一类是内网/部数据,一类是外网/开放数据。

互联网上,能够通过普通权限看到,大众用户能看到,通过公开渠道可以获取的数据,我们都称为开放数据。

通过上面图片我们可以看到,目前获取这类数据,我们可以通过QQ群、威客网站等平台去购买,但这种方式,成本高、效率低,交易无保障,买的都是历史数据,这是方式1;

方式2是通过一些API模式去调用,如果你有合作的运营商、企业等可以获取一些数据,比如气象局数据、工商部门数据、电商平台数据等,这种方式前几年发展其实不错,但在未来,特别是数据源开放共享后,这个方式成本就越来越高,更活、更快的数据,必然取代这种(数据获取方式)。

第3种方式就是单机采集的方式。单机采集无法复用,导致数据资源浪费,数据利用率低,现在这种方式还是比较主流的,类似工具也很多,随着大数据与云计算的方式,这种方式肯定要更新迭代。

随着SaaS技术的发展,我们开发了一套新的云采集工具,属国内首款。用户不需要登陆,不用下载安装任何客户端或者浏览器插件。

我们想解决开放数据的采集、处理、清洗、脱敏等关键问题,方便用户使用,不需要用户去担心什么电脑性能、怎么存储、带宽网络等问题,全部交给服务器解决就行,而且诸如IP限制、反采集等问题,也无须担心。

按照我们的理解,未来开放数据的采集,基本上就基于SaaS系统在线上云端实现,用户要做的就很简单,登陆网站,打开工具,输入一些简单规则,完成采集,而且信息可以放云端,方便储存与使用,用户也不需要自己加服务器。

/03/

数据交易流通

其实,互联网不同企业间已经做了很多年数据交互/交易,但没有这个概念。

直到2015年,贵阳大数据交易所成立。

当时国家是想推动数据的开放、共享和交易。

这可能需要大家制定一些规则,比如什么样的数据可以开放,怎么开放,然后怎么去共享,然后怎么交易?

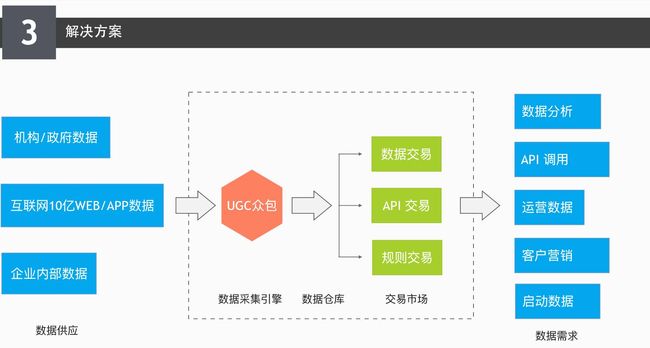

上面这张图可以看出目前我们的交易流通架构。

交易数据不像淘宝上卖东西,买了就可以用,它需要一个粗加工的过程,即便用户拿到数据需要自己深度清洗与加工,早期也是需要做粗加工的。

所以中间必须有这么一个环节,这个过程,我们叫数据从小麦加工到面粉。

数据就是小麦,粗加工使它成为面粉,面粉做成包子馒头,面包,这个叫数据应用,其实就是更深度的加工。

按我们的理解,现在数据不管是开放还是非开放,它从数据源头到客户需求,到终端应用这个节点,必须经过粗加工这一过程,才能拿来做交易,做变现,或者说做流通。

经历了数据加工这一过程,才能解决数据孤岛,实现数据价值最大化。

否则的话,还是停留在七八年前,那种叫黑产交易,或者叫数据包交易。

而我们这种模型就叫数据源交易,或者叫“活数据”交易,也有一种说法叫“快数据交易”,按照我的理解,其实这比快数据还升级一个版本,快数据还是孤立的,是一个个数据孤岛,数据源的交易更像是一个“管道的”交易。

这样交易能解决用户很多问题,包括数据的动态交互,数据安全,版权,隐私等,保障了数据交易完成了先授权,再脱敏,再确权这个过程。

/04/

数据应用示例

上面第一张图是一些数据类型示例,第二张图是我们平台交易大厅上的一些热门需求,大家可以看出哪些数据是比较有价值的,大家比较需求的。

有些数据,可能大家并不觉得有价值,但还是有很多需求。

这是什么原因呢?

大数据发展以来,对开放数据应用探索得出一个结论,越多海量数据关联在一起,打破数据孤岛后,一个独立数据价值会非常高。

这是一个很有价值、很有意义的结论。

但现在做数据变现,必须与海量数据关联,早期会比较累、比较苦,就像大众点评,早期做了很多事,后来累积起来才有价值。

大多数的用户数据需求,都不是基于单个数据的需求,而是对海量数据,或多个数据的需求。

举两个例子,我们之前有一个生物制药的客户,他们想采集全医疗行业的抗体数据,那个行业数据大概来源于5000个生物制药同行网站,以及学术网站里面的公开数据,所以他这个需求是基于5000个网站开放数据的整合、关联的一个使用。

另外一个例子,之前一个游戏行业的公司,他需要数据填充自己的论坛,需要游戏攻略网站TOP20的论坛数据,然后我们帮他采集下来,做结构化的清洗、存储、然后对接到他们线上数据库,完成了他们的运营冷启动。

这样的例子很多,从我们的交易来看,除非单一数据非常大,80%的数据最终落地的时候,都需要汇聚海量数据进行关联、融合。

一些诸如新闻资讯类的数据,看起来似乎没什么价值,被当作垃圾数据的,恰恰很多人在使用,在一些人眼中就是矿山,能挖出金矿、银矿,(数据有没有价值)就看你有没有这种思维、idea、它的天花板是你的idea。

开放数据的价值,很多公司都意识到了。有句话说:不管三七二十一,先把数据收集上来再说。可能我现在不知道怎么用,但以后会知道。

在我们看来,未来开放数据的体量一定远远大过内部数据,应用空间不可想象,非常非常大。就像百度搜索引擎10亿+网站,就是一个大的数据矿山,但这个矿山你不去挖,它就是数据孤岛,没有价值。

还有即使你挖了,如果你不能把一座座山融合贯通,那其实也是没有意义的。

总之一句话,开放数据想要应用,想要落地,就看数据的关联程度,融合贯通才能让数据价值体现。

/05/

Q&A

10.30晚上,不少观众提了一些高质量的问题,这里选取其中几个大家可能比较关心的代表性问题。

Q1:数据如何定价?

A:数据是一个服务,它可以标准化,但又没法完全标准化的一个商品。它不像手机、手表是明码标价的,传统的数据交易可以明码标价,比如他说我就100条数据(数据有限),但现在是“活的数据交易”,包括数据规则、API、数据交互、数量量,它不好标准化。

总的来说,数据交易也要看市场需求,比如供应商卖数据,如果定价高了,没人买,他也要降价,如果很多人买,他也会升价,这是一个市场选择的过程。

需求市场也是一样的,比如你去发源地发布一个数据需求,定价1元,可能没人问,如果你定价变成100,可能有人开始问,如果定价1000,可能马上就有人帮你解决了。

这就是一个市场选择的过程。

Q2:发源地的数据在获取后加工时,一般会进行哪些处理?是进行深入的数据挖掘还是只是一些基础的清洗?能不能分析一个实际的案例?

A:还是拿小麦做面粉来类比,小麦做成面粉,我们称之为粗加工,面粉做成面包、包子,我们称之为深度加工,有了前者,才有后者,深度加工类似于数据建模、数据分析、数据关联,我们作为一个平台,目前暂时不会做这些,我们只做前半部分,做数据的清洗,把数据结构化,解决数据应用的基础问题(脱敏、确权、安全、及时、可用),这是我们的定位。

例子比较多,比如说企查查的数据,每一个数据源采集之后,对每一个数据ID进行存储,把这些ID与其他ID做关联匹配,工商库的,专利数据库,股东等,把这些ID串联在一起,形成一个多维的数据源,这个价值就非常大。

用户查企业,就能全面了解这个公司各个层面的信息,股权结构,股东,股东还有哪些公司,专利有多少等等。

Q3:开放数据用户企业决策看起来不靠谱,这个问题怎么解决?

A:不仅是开放数据,包括内部数据也是,只要是数据用户数据决策,就是我们前面提到的数据分析,在国内就是觉得不靠谱。这是行业现状,是很多年根深蒂固的一个结果,短期内无法解决,需要时间的积累。

为什么中国国内咨询业发展这么多年,还有那么多坑呢,或者说买单的人不多,市场做不大呢?

都说水分太多,水分太多也有很多原因,比如说数据数量不够,维度不全,早期大家对数据重视不高,导致数据关联度低,最终导致做数据分析、数据挖掘时,价值不高,形成一个恶性循环,不像国外重视数据,技术、存储什么都跟得上,一个报告卖几十万很正常。

我们认为要解决这个问题,第一要对数据足够重视,重视程度要提起来;

第二,要动起手来,采集数据,数量和维度这两个关键核心点,要强化。

然后我们慢慢来改善这个问题。

发源地大数据(Finndy)是国内首家基于自研SaaS2.0云采集引擎的大数据交易平台,支持海量数据的分布式采集、计算及处理,以技术驱动数据交易。

科学分析、行业研究、内容扩充、运营启动,Finndy平台集合了全行业脱敏数据,满足企业对数据分析、数据运营及精准营销等方面的需求。