Python机器学习及实践——简介篇3(逻辑回归)

前面两篇都是介绍性的文字,这篇详细介绍完整的“良/恶性乳腺癌肿瘤预测”问题的Python源代码。

根据前两篇的描述,大家可以确定“良/恶性乳腺癌肿瘤预测”的问题属于二分类任务。待预测的类别分别是良性乳腺癌肿瘤和恶性乳腺癌肿瘤。通常我们使用离散的整数来代表类别。如下表,“肿瘤类型”一列列出了肿瘤的类型;0代表良性,1代表恶性。

| 肿块厚度 | 细胞尺寸 | 肿瘤类型 | 肿块厚度 | 细胞尺寸 | 肿瘤类型 | ||

| 0 | 1 | 1 | 0 | 3 | 8 | 8 | 0 |

| 1 | 4 | 4 | 0 | 4 | 1 | 1 | 0 |

| 2 | 1 | 1 | 0 | 5 | 10 | 10 | 1 |

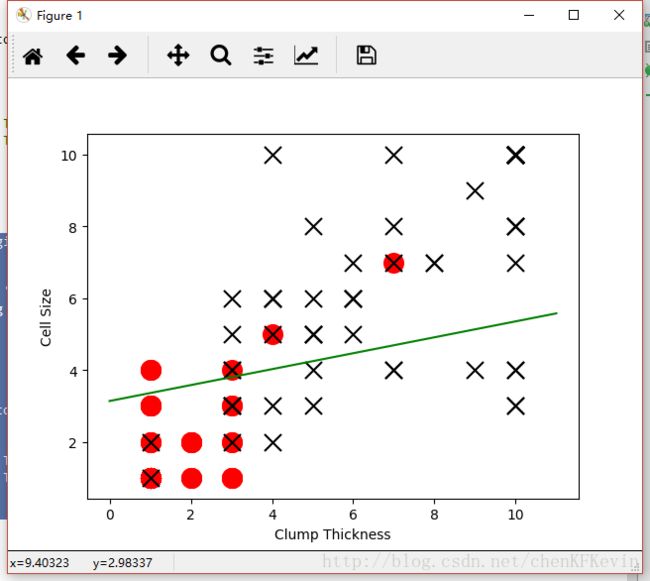

完整的数据集肿瘤的特征不止这两个,但是在这个例子中我们只取这两个特征,并且测试集数量为175条。我们先看一下这175条肿瘤样本在二维特征空间的分布情况,如下图所示。X代表恶性肿瘤,O代表良性肿瘤。

绘制这张图的代码如下:

# -*- coding:utf-8 -*-

# 导入pandas包,别名为pd

import pandas as pd

# 使用pandas的read_csv函数,将训练集读取进来并存至变量df_train

df_train = pd.read_csv('breast-cancer-train.csv')

# 使用pandas的read_csv函数,将测试集读取进来并存至变量df_test

df_test = pd.read_csv('breast-cancer-test.csv')

# 选取Clump Thickness和Cell Size作为特征,构建测试集中的正负分类样本

df_test_negative = df_test.loc[df_test['Type'] == 0][['Clump Thickness', 'Cell Size']]

df_test_positive = df_test.loc[df_test['Type'] == 1][['Clump Thickness', 'Cell Size']]

# 导入matplotlib工具包中的pyplot并命名为plt

import matplotlib.pyplot as plt

# 绘制图中的良性肿瘤样本点,标记为红色的o

plt.scatter(df_test_negative['Clump Thickness'], df_test_negative['Cell Size'], marker='o', s=200, c='red')

# 绘制图中的恶心肿瘤样本点,标记为黑色的x

plt.scatter(df_test_positive['Clump Thickness'], df_test_positive['Cell Size'], marker='x', s=150, c='black')

# 绘制x,y轴说明

plt.xlabel('Clump Thickness')

plt.ylabel('Cell Size')

# 显示图

plt.show() 绘制这张图的代码如下:

# -*- coding:utf-8 -*-

# 导入pandas包,别名为pd

import pandas as pd

# 导入matplotlib工具包中的pyplot并命名为plt

import matplotlib.pyplot as plt

# 使用pandas的read_csv函数,将训练集读取进来并存至变量df_train

df_train = pd.read_csv('breast-cancer-train.csv')

# 使用pandas的read_csv函数,将测试集读取进来并存至变量df_test

df_test = pd.read_csv('breast-cancer-test.csv')

# 选取Clump Thickness和Cell Size作为特征,构建测试集中的正负分类样本

df_test_negative = df_test.loc[df_test['Type'] == 0][['Clump Thickness', 'Cell Size']]

df_test_positive = df_test.loc[df_test['Type'] == 1][['Clump Thickness', 'Cell Size']]

# 导入numpy工具包,重命名为np

import numpy as np

# 利用numpy中的random函数随机采样直线的截距和系数

intercept = np.random.random([1])

coef = np.random.random([2])

lx = np.arange(0, 12)

ly = (-intercept - lx * coef[0]) / coef[1]

# 绘制一条随机直线

plt.plot(lx, ly, c='yellow')

plt.scatter(df_test_negative['Clump Thickness'], df_test_negative['Cell Size'], marker='o', s=200, c='red')

plt.scatter(df_test_positive['Clump Thickness'], df_test_positive['Cell Size'], marker='x', s=150, c='black')

plt.xlabel('Clump Thickness')

plt.ylabel('Cell Size')

plt.show()

绘制这张图的代码如下:

# -*- coding:utf-8 -*-

# 导入pandas包,别名为pd

import pandas as pd

# 导入numpy工具包,重命名为np

import numpy as np

# 导入matplotlib工具包中的pyplot并命名为plt

import matplotlib.pyplot as plt

# 导入sklearn中的逻辑斯蒂回归分类器

from sklearn.linear_model import LogisticRegression

# 使用pandas的read_csv函数,将训练集读取进来并存至变量df_train

df_train = pd.read_csv('breast-cancer-train.csv')

# 使用pandas的read_csv函数,将测试集读取进来并存至变量df_test

df_test = pd.read_csv('breast-cancer-test.csv')

# 选取Clump Thickness和Cell Size作为特征,构建测试集中的正负分类样本

df_test_negative = df_test.loc[df_test['Type'] == 0][['Clump Thickness', 'Cell Size']]

df_test_positive = df_test.loc[df_test['Type'] == 1][['Clump Thickness', 'Cell Size']]

lr = LogisticRegression()

# 使用前10条训练样本学习直线的系数和截距

lr.fit(df_train[['Clump Thickness', 'Cell Size']][:10], df_train['Type'][:10])

print 'Testing accuracy (10 training samples):', lr.score(df_test[['Clump Thickness', 'Cell Size']], df_test['Type'])

intercept = lr.intercept_

coef = lr.coef_[0, :]

lx = np.arange(0, 12)

# 原本这个分类面应该是lx*coef[0] + ly*coef[1] + intercept=0 映射到2维平面上之后,应该是:

ly = (-intercept - lx * coef[0]) / coef[1]

plt.plot(lx, ly, c='green')

plt.scatter(df_test_negative['Clump Thickness'], df_test_negative['Cell Size'], marker='o', s=200, c='red')

plt.scatter(df_test_positive['Clump Thickness'], df_test_positive['Cell Size'], marker='x', s=150, c='black')

plt.xlabel('Clump Thickness')

plt.ylabel('Cell Size')

plt.show()

print的值为:Testing accuracy (10 training samples): 0.868571428571

如上图所示,当学习了10条训练样本时,分类器的性能改进了一些,测试集上的分类准确性为86.9%;我们继续学习所有训练样本,分类器的性能进一步提升,在测试集上的分类准确性最终达到93.7%,如下图:

如上图所示,当学习了10条训练样本时,分类器的性能改进了一些,测试集上的分类准确性为86.9%;我们继续学习所有训练样本,分类器的性能进一步提升,在测试集上的分类准确性最终达到93.7%,如下图:

绘制这张图的代码如下:

# -*- coding:utf-8 -*-

# 导入pandas包,别名为pd

import pandas as pd

# 导入numpy工具包,重命名为np

import numpy as np

# 导入matplotlib工具包中的pyplot并命名为plt

import matplotlib.pyplot as plt

# 导入sklearn中的逻辑斯蒂回归分类器

from sklearn.linear_model import LogisticRegression

# 使用pandas的read_csv函数,将训练集读取进来并存至变量df_train

df_train = pd.read_csv('breast-cancer-train.csv')

# 使用pandas的read_csv函数,将测试集读取进来并存至变量df_test

df_test = pd.read_csv('breast-cancer-test.csv')

# 选取Clump Thickness和Cell Size作为特征,构建测试集中的正负分类样本

df_test_negative = df_test.loc[df_test['Type'] == 0][['Clump Thickness', 'Cell Size']]

df_test_positive = df_test.loc[df_test['Type'] == 1][['Clump Thickness', 'Cell Size']]

lr = LogisticRegression()

# 使用前10条训练样本学习直线的系数和截距

lr.fit(df_train[['Clump Thickness', 'Cell Size']], df_train['Type'])

print 'Testing accuracy (10 training samples):', lr.score(df_test[['Clump Thickness', 'Cell Size']], df_test['Type'])

intercept = lr.intercept_

coef = lr.coef_[0, :]

lx = np.arange(0, 12)

# 原本这个分类面应该是lx*coef[0] + ly*coef[1] + intercept=0 映射到2维平面上之后,应该是:

ly = (-intercept - lx * coef[0]) / coef[1]

plt.plot(lx, ly, c='green')

plt.scatter(df_test_negative['Clump Thickness'], df_test_negative['Cell Size'], marker='o', s=200, c='red')

plt.scatter(df_test_positive['Clump Thickness'], df_test_positive['Cell Size'], marker='x', s=150, c='black')

plt.xlabel('Clump Thickness')

plt.ylabel('Cell Size')

plt.show()

这份代码只是帮大家理清一下最为基础的python编程要素,方便对后面的实例进行理解和实践。

数据地址http://pan.baidu.com/s/1jI00k8Q,大家可以去下载。