机器学习(1): 线性回归——最小二乘法 小结

目录

1 最小二乘法简介

2 最小二乘法历史

3 基本形式

4 一元线性回归

5 多元线性回归

参考资料

1 最小二乘法简介

最小二乘法(Least square method,又称最小平方法)是一种数学优化技术。它通过最小化误差的平方和寻找数据的最佳函数匹配。利用最小二乘法可以简便地求得未知的数据,并使得这些求得的数据与实际数据之间误差的平方和为最小。最小二乘法还可用于曲线拟合。其他一些优化问题也可通过最小化能量或最大化熵用最小二乘法来表达。(来自于百度百科)

注:最小二乘法用途很广,不仅限于线性回归

2 最小二乘法历史

1801年,意大利天文学家朱赛普·皮亚齐发现了第一颗小行星谷神星。经过40天的跟踪观测后,由于谷神星运行至太阳背后,使得皮亚齐失去了谷神星的位置。随后全世界的科学家利用皮亚齐的观测数据开始寻找谷神星,但是根据大多数人计算的结果来寻找谷神星都没有结果。时年24岁的高斯也计算了谷神星的轨道。奥地利天文学家海因里希·奥尔伯斯根据高斯计算出来的轨道重新发现了谷神星。

高斯使用的最小二乘法的方法发表于1809年他的著作《天体运动论》中。

法国科学家勒让德于1806年独立发明“最小二乘法”,但因不为世人所知而默默无闻。

勒让德曾与高斯为谁最早创立最小二乘法原理发生争执。

1829年,高斯提供了最小二乘法的优化效果强于其他方法的证明,因此被称为高斯-马尔可夫定理。

最小二乘法不仅是19世纪最重要的统计方法,而且还可以称为数理统计学之灵魂。相关回归分析、方差分析和线性模型理论等数理统计学的几大分支都以最小二乘法为理论基础。正如美国统计学家斯蒂格勒( S. M. Stigler)所说,“最小二乘法之于数理统计学犹如微积分之于数学”。最小二乘法是参数回归的最基本得方法所以研究最小二乘法原理及其应用对于统计的学习有很重要的意义。(来自于百度百科)

3 基本形式

给定由 ![]() 个属性描述的示例

个属性描述的示例 ![]() ,其中

,其中 ![]() 是

是 ![]() 现在第

现在第 ![]() 个属性上取值,线性模型去学习一个通过属性的线性组合来进行预测的函数,即

个属性上取值,线性模型去学习一个通过属性的线性组合来进行预测的函数,即

![]()

一般用向量形式表示更为简洁:

![]()

其中,![]()

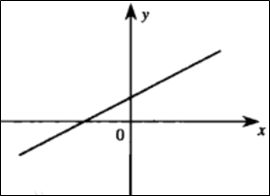

其实可以很简单的理解,如下图直线是由很多点组成的,如果事先不知道直线的方程,只有一些点,那么根据这些点求得的函数就是这条直线。我们的任务就是根据已知的一些数据求解得到函数。当然这只是一元线性回归,还有多元线性回归与之类似。

回归分析中,如果只包括一个自变量和一个因变量,且二者的关系可用一条直线近似表示,这种回归分析称为一元线性回归分析。如果回归分析中包括两个或两个以上的自变量,且因变量和自变量之间是线性关系,则称为多元线性回归分析。对于二维空间线性是一条直线;对于三维空间线性是一个平面,对于多维空间线性就是一个超平面。

4 一元线性回归

给定数据集:

![]()

其中,![]() 和

和 ![]() 。

。

而线性回归视图学得:

![]() , 使得

, 使得![]()

其实就是找到一个函数使得数据尽可能的在这个函数内。那么如何确定参数 ![]() 和

和 ![]() 呢?

呢?

显然,关键在于如何衡量 ![]() 与

与 ![]() 之间的差距,我们使用均方误差来进行度量。因此我们将差距最小问题转化为均方误差最小化,即:

之间的差距,我们使用均方误差来进行度量。因此我们将差距最小问题转化为均方误差最小化,即:

其中,![]() 分别表示

分别表示 ![]() 和

和 ![]() 的解。

的解。

均方误差的几何意义就是常用的欧式几何距离,简称欧氏距离(Euclidean distance)。基于均方误差最小化进行模型求解的方法称为最小二乘法。在线性回归中,最小二乘法就是试图找到一条直线,使得所有样本到直线上的欧氏距离之和最小。

求解 ![]() 和

和 ![]() 使

使  最小化的过程,称之为线性回归模型的最小二乘法“参数估计”(parameter estimation)。为了得到最小值,我们只需要将函数

最小化的过程,称之为线性回归模型的最小二乘法“参数估计”(parameter estimation)。为了得到最小值,我们只需要将函数 ![]() 求导即可。则

求导即可。则 ![]() 分别对

分别对 ![]() 和

和 ![]() 求导,得到:

求导,得到:

求得倒数为零的解,即为最优解,则令导数 ![]() ,

,![]() 可得到

可得到 ![]() 和

和 ![]() 的最优解分别为:

的最优解分别为:

5 多元线性回归

更一般的情况就是多元线性回归,给出数据集:

![]()

其中,![]() 和

和 ![]() 。

。

此时我们试图学得:

![]() , 使得

, 使得![]()

这种称之为多元线性回归(multivariate linear regression)。

类似地方法,可以利用最小二乘法来对进行估计。为了方便讨论,我们将 ![]() 和

和 ![]() 吸入向量形式

吸入向量形式![]() 。

。

相应的,把数据集 ![]() 表示为一个

表示为一个 ![]() 维大小的矩阵

维大小的矩阵 ![]() ,其中每行对应于一个示例,该行前

,其中每行对应于一个示例,该行前 ![]() 个元素对应于示例的

个元素对应于示例的 ![]() 个属性值,最后一个元素恒置为1,即:

个属性值,最后一个元素恒置为1,即:

再将标记也写成向量形式 ![]() ,类似地,均方误差最小化,即:

,类似地,均方误差最小化,即:

令 ![]() ,为了得到最小值,我们只需要将函数

,为了得到最小值,我们只需要将函数 ![]() 求导即可。则

求导即可。则 ![]() 对

对 ![]() 求导,得到:

求导,得到:

令 ![]() 即可得到最优解,但求导涉及到矩阵逆的计算,比单变量线性回归情形复杂很多,这里不再进行赘述。

即可得到最优解,但求导涉及到矩阵逆的计算,比单变量线性回归情形复杂很多,这里不再进行赘述。

参考资料

[1] https://www.cnblogs.com/wangkundentisy/p/7505487.html

[2] 周志华 著. 机器学习, 北京: 清华大学出版社, 2016年1月.