- 【从问题中去学习k8s】k8s中的常见面试题(夯实理论基础)(二十八)

向往风的男子

k8s学习kubernetes容器

本站以分享各种运维经验和运维所需要的技能为主《python零基础入门》:python零基础入门学习《python运维脚本》:python运维脚本实践《shell》:shell学习《terraform》持续更新中:terraform_Aws学习零基础入门到最佳实战《k8》从问题中去学习k8s《docker学习》暂未更新《ceph学习》ceph日常问题解决分享《日志收集》ELK+各种中间件《运维日常》

- K8S - Volume - NFS 卷的简介和使用

nvd11

K8Skubernetes容器云原生

在之前的文章里已经介绍了K8S中两个简单卷类型hostpath和emptydirk8s-Volume简介和HostPath的使用K8S-Emptydir-取代ELK使用fluentd构建loggingsaidcar但是这两种卷都有同1个限制,就是依赖于k8snodes的空间如果某个servicepod中需要的volumn空间很大,这时我们就需要考虑网络磁盘方案,其中NAS类型的Volume是常用且

- fluentd 简介,日志收集并导入BigQuery

nvd11

CloudspringEtlspringboot

日志收集的工具有很多种例如Splunk,很多大公司都在使用,但是个人使用的话并不合适,主要是需要license的…钱是1个大问题另1个常见开源的解决方案是ELK,但是搭建和学习成本高,如果只是为了日志收集并不值。对于k8s方案,还有1个开源选择,就是fluentd,本文的主题。Fluentd的简介Fluentd是一个开源的数据收集器,旨在实现日志数据的统一收集、处理和转发。它支持多种数据源和数据格

- ELK 架构中 ES 性能优化

xianjie0318

elk架构elasticsearch

1.背景由于目前日志采集流程中,经常遇到用户磁盘IO占用超过90%以上的场景,但是观察其日志量大约在2k~5k之间,整体数据量不大,所以针对该问题进行了一系列的压测和实验验证,最后得出这篇优化建议文档2.压测前期准备2.1制造大量日志该阶段为数据源输入阶段,为了避免瓶颈在数据制造侧,所以需要保证filebeat具有足够的日志制造能力最后效果,filebeat可以达到70kQPS的数据发往logst

- K8S - Emptydir - 取代ELK 使用fluentd 构建logging saidcar

nvd11

K8Skubernetes

由于k8s的无状态service通常部署在多个POD中,实现多实例面向高并发。但是k8s本身并没有提供集中查询多个pod的日志的功能其中1个常见方案就是ELK.本文的方案是利用fluentdsidecar和emptydir把多个pod的日志导向到bigquery的table中。Emptydir的简介Kubernetes中的EmptyDir是一种用于容器之间共享临时存储的空目录卷类型。EmptyDi

- 5分钟熟练上手ES的具体使用

佚名涙

elasticsearchjenkins大数据学习

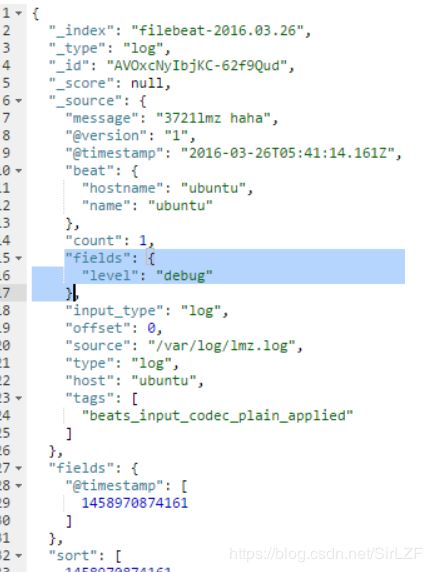

5分钟上手ES的具体使用相信有很多同学想要去学习elk时会使用docker等一些方式去下载相关程序,但提到真正去使用es的一系列操作时又会知之甚少。于是这一篇博客应运而生。本文就以下载好elk/efk系统后应该如何去使用为例,介绍es的具体操作。es关键字基本概念索引(Index):类似于关系型数据库中的“数据库”,是数据存储的容器。文档(Document):类似于关系型数据库中的“行”,是JSO

- 【从问题中去学习k8s】k8s中的常见面试题(夯实理论基础)(十一)

向往风的男子

k8s学习kubernetes容器

本站以分享各种运维经验和运维所需要的技能为主《python零基础入门》:python零基础入门学习《python运维脚本》:python运维脚本实践《shell》:shell学习《terraform》持续更新中:terraform_Aws学习零基础入门到最佳实战《k8》从问题中去学习k8s《docker学习》暂未更新《ceph学习》ceph日常问题解决分享《日志收集》ELK+各种中间件《运维日常》

- 【mysql】mysql之优化

向往风的男子

DBAmysql数据库

本站以分享各种运维经验和运维所需要的技能为主《python零基础入门》:python零基础入门学习《python运维脚本》:python运维脚本实践《shell》:shell学习《terraform》持续更新中:terraform_Aws学习零基础入门到最佳实战《k8》从问题中去学习k8s《docker学习》暂未更新《ceph学习》ceph日常问题解决分享《日志收集》ELK+各种中间件《运维日常》

- ELK架构介绍

星河漫漫l

elkelasticsearch运维服务器

一、ELK简介ELK是由三个开源软件组成的,分别是:Elasticsearch、Logstash和Kibana,这三个软件各自在日志管理和数据分析领域发挥着重要作用。Elasticsearch提供分布式存储和搜索能力;Logstash负责数据收集和处理,而Kibana则提供数据可视化和分析界面。他们共同构成了一个完整的日志管理解决方案,帮助企业高效利用日志数据进行监控、分析和安全审计。1.Elas

- ELK日志分析系统之集成Filebeat

奔跑吧邓邓子

高效运维

目录一、Filebeat是什么?二、集成Filebeat1.安装Filebeat2.配置3.启动本博在ELK日志分析系统搭建一文中,介绍了使用Elasticsearch、Logstash、Kibana来搭建ELK。不过由于Logstash是一个功能强大的日志服务,作为日志采集器会占用较多的系统资源,如果需要添加插件,全部服务器的Logstash都要添加插件,扩展性很差。而Filebeat作为一个轻

- 使用 ELK Stack 进行云原生日志记录和监控:AWS 中的开发运营方法

数云界

elk云原生aws

使用ELKStack进行云原生日志记录和监控欢迎来到雲闪世界。在当今的云原生世界中,日志记录和监控是强大的DevOps策略的重要组成部分。监控应用程序性能、跟踪错误和分析日志对于确保无缝操作和主动识别潜在问题至关重要。在本文中,我们将指导您使用AWS上的ELKStack(Elasticsearch、Logstash和Kibana)设置云原生日志记录和监控,从而实现以DevOps为中心的方法来管理基

- Vicky的ScalersTalk第六轮新概念朗读持续力训练Day50 20210319

Vicky_b9de

练习材料:AlostshipPart-1一艘沉船Thesalvageoperationhadbeenacompletefailure.Thesmallship,Elkor,whichhadbeensearchingtheBarentsSeaforweeks,wasonitswayhome.Aradiomessagefromthemainlandhadbeenreceivedbytheship'sc

- 一、ELK架构介绍

李白望明月

ELK基础介绍elk

一、ELK架构介绍ELK是一个应用套件,由Elasticsearch/Logstash/Kibana三个部分软件组成,简称ELK。ELK是一个做日志分析的管理系统。在服务器中的系统日志,网络日志,应用系统日志等各个日志收集/过滤/清洗,然后进行集中存放并可用实时检索/分析/展示日志。Logstash(收集日志)–>Elasticsearch(检索日志)–>Kibana(可视化)Elasticsea

- 【网络架构】ELK

云计算稿手

网络架构架构elk

目录一、ELK介绍1.1ELK是什么1.2Elasticsearch1.3Logstash1.4Kibana1.5为什么使用ELK二、ELK原理2.1工作原理2.2ELK的应用架构图三、ELK的安装部署3.1环境部署3.2前期环境3.3安装Elasticsearch3.3.1修改配置3.3.2查看节点信息3.4安装Logstash3.4.1安装服务3.4.2使用Logstash3.4.3对接ela

- ELK架构

小楚同学呀~

一、Logstash+elasticsearch+Kibana首先由Logstash分布于各个节点上搜集相关日志、数据,并经过分析、过滤后发送给远端服务器上elasticsearch进行存储。elasticsearch将数据以分片的形式压缩存储并提供多种API供用户查询,操作。用户也可以直观的通过配置KibanaWebPortal方便的对日志进行查询,并根据数据生成报表。优点:搭建简单,易于上手。

- SpringCloud集成ELK

echola_mendes

ELKspringcloudelkjava

1、添加依赖net.logstash.logbacklogstash-logback-encoder6.12、在logback-spring.xml中添加配置信息(logback-spring.xml在文末)192.168.2.203:4560............192.168.2.203:4560对应搭建的Logstash地址Logback日志打印由于SpringBoot项目在引用了sprn

- ELK7.8部署:Elasticsearch+Logstash+Kibana搭建分布式日志平台

_海风_

运维分布式

ELK7.8部署:Elasticsearch+Logstash+Kibana搭建分布式日志平台一、前言1、ELK简介2、ELK工作流二、准备工作1、服务器&软件环境说明2、ELK环境准备三、Elasticsearch部署1、准备工作2、配置四、Logstash部署1、准备工作2、Logstash配置五、Kibana部署1、准备工作2、Kibana配置与访问测试六、测试1、日志写入2、访问七、备注1

- ELK处理 SpringBoot 日志,真实太妙了!

进击的王小二

大数据javaelkspringboot

在排查线上异常的过程中,查询日志总是必不可缺的一部分。现今大多采用的微服务架构,日志被分散在不同的机器上,使得日志的查询变得异常困难。工欲善其事,必先利其器。如果此时有一个统一的实时日志分析平台,那可谓是雪中送碳,必定能够提高我们排查线上问题的效率。本文带您了解一下开源的实时日志分析平台ELK的搭建及使用。ELK简介ELK是一个开源的实时日志分析平台,它主要由Elasticsearch、Logst

- SpringBoot+Kafka+ELK 完成海量日志收集(超详细)

2401_83703797

程序员springbootkafkaelk

SpringBoot项目准备引入log4j2替换SpringBoot默认log,demo项目结构如下:pomIndexController测试Controller,用以打印日志进行调试InputMDC用以获取log中的[%X{hostName}]、[%X{ip}]、[%X{applicationName}]三个字段值NetUtil启动项目,访问/index和/ero接口,可以看到项目中生成了app

- spring cloud搭建elk

2301_79655496

程序员springcloudelkjenkins

elastic官网:https://www.elastic.co/cn/downloads1.elasticsearch-6.2.2(存储日志数据)wgethttps://artifacts.elastic.co/downloads/elasticsearch/elasticsearch-6.2.2.tar.gz2.logstash-6.2.2(收集日志数据)wgethttps://artifac

- 【从问题中去学习k8s】k8s中的常见面试题(夯实理论基础)(二十四)

向往风的男子

k8s学习kubernetes容器

本站以分享各种运维经验和运维所需要的技能为主《python零基础入门》:python零基础入门学习《python运维脚本》:python运维脚本实践《shell》:shell学习《terraform》持续更新中:terraform_Aws学习零基础入门到最佳实战《k8》从问题中去学习k8s《docker学习》暂未更新《ceph学习》ceph日常问题解决分享《日志收集》ELK+各种中间件《运维日常》

- 【从问题中去学习k8s】k8s中的常见面试题(夯实理论基础)(十九)

向往风的男子

k8s学习kubernetes容器

本站以分享各种运维经验和运维所需要的技能为主《python零基础入门》:python零基础入门学习《python运维脚本》:python运维脚本实践《shell》:shell学习《terraform》持续更新中:terraform_Aws学习零基础入门到最佳实战《k8》从问题中去学习k8s《docker学习》暂未更新《ceph学习》ceph日常问题解决分享《日志收集》ELK+各种中间件《运维日常》

- 【从问题中去学习k8s】k8s中的常见面试题(夯实理论基础)(二)

向往风的男子

k8s学习kubernetes容器

本站以分享各种运维经验和运维所需要的技能为主《python零基础入门》:python零基础入门学习《python运维脚本》:python运维脚本实践《shell》:shell学习《terraform》持续更新中:terraform_Aws学习零基础入门到最佳实战《k8》从问题中去学习k8s《docker学习》暂未更新《ceph学习》ceph日常问题解决分享《日志收集》ELK+各种中间件《运维日常》

- 【从问题中去学习k8s】k8s中的常见面试题(夯实理论基础)(二十三)

向往风的男子

k8s学习kubernetes容器

本站以分享各种运维经验和运维所需要的技能为主《python零基础入门》:python零基础入门学习《python运维脚本》:python运维脚本实践《shell》:shell学习《terraform》持续更新中:terraform_Aws学习零基础入门到最佳实战《k8》从问题中去学习k8s《docker学习》暂未更新《ceph学习》ceph日常问题解决分享《日志收集》ELK+各种中间件《运维日常》

- 【mysql】mysql之存储引擎学习

向往风的男子

DBAmysql学习数据库

本站以分享各种运维经验和运维所需要的技能为主《python零基础入门》:python零基础入门学习《python运维脚本》:python运维脚本实践《shell》:shell学习《terraform》持续更新中:terraform_Aws学习零基础入门到最佳实战《k8》从问题中去学习k8s《docker学习》暂未更新《ceph学习》ceph日常问题解决分享《日志收集》ELK+各种中间件《运维日常》

- 33.ES集群规划—整体规划

大勇任卷舒

集群规划集群大小设置的依据:ESJVMheap最大可以设置32G30Gheap大概能处理10T的数据量,如果内存很大如128G,可以在一台机器上运行多个ES节点两类应用场景:用于构建业务搜索功能模块,且多是垂直领域的搜索数据量级几千万到数十亿级别,一般2-4台机器规模用于大规模数据的实时OLAP(联机处理分析),如ELKStack,数据规模可能达到千亿或更多几十到上百节点的规模集群节点的角色分配节

- 单机 安装 ELK 日志分析系统

TheFlsah

Linux

一、ELK介绍ELKStack是软件集合Elasticsearch、Logstash、Kibana的简称,它们都是开源软件。新增了一个FileBeat,它是一个轻量级的日志收集处理工具(Agent),Filebeat占用资源少,适合于在各个服务器上搜集日志后传输给Logstash,官方也推荐此工具。Elasticsearch是一个基于Lucene的、支持全文索引的分布式存储和索引引擎,主要负责将日

- Kibana安装部署

季风泯灭的季节

ElasticStack技术栈及其详细应用运维elkkibana

目录一、环境准备二、安装部署2.1下载安装包到指定文件夹,并解压2.2重置kibana_system密码2.3编辑启动文件2.3进入界面三、使用3.1创建视图3.2视图优化概述Kibana是一个强大的开源数据可视化工具,它作为ElasticStack(以前称为ELKStack)中的一部分使用,与Elasticsearch紧密集成,Elasticsearch中的数据即通过Kibana界面向用户展示。

- redis数据结构

bullion

五种数据结构字符串(String)哈希(hash)字符串列表(list)字符串集合(set)有序字符串集合(sortedset)key命名定义的注意点不要过长不要过短统一的命名规范常用命令判断key是否存在:existskey删除key:delkey进入命令行:redis-cli权限:authpassword获取所有key:keys*字符串(String)二进制安全的,存入和获取的数据相同Valu

- 搭建elk日志管理系统

阿色你过来啊

学习分享elkelasticsearch大数据

ELK日志管理系统一.环境准备按照JDK1.8第一步:下载JDKhttps://www.oracle.com/technetwork/java/javase/downloads/jdk8-downloads-2133151.html第二步:安装mkdir/usr/jdktar-xvfjdk-8u112-linux-x64.tar.gz/usr/jdk第三步:配置环境变量命令:vim/etc/pro

- redis学习笔记——不仅仅是存取数据

Everyday都不同

returnSourceexpire/delincr/lpush数据库分区redis

最近项目中用到比较多redis,感觉之前对它一直局限于get/set数据的层面。其实作为一个强大的NoSql数据库产品,如果好好利用它,会带来很多意想不到的效果。(因为我搞java,所以就从jedis的角度来补充一点东西吧。PS:不一定全,只是个人理解,不喜勿喷)

1、关于JedisPool.returnSource(Jedis jeids)

这个方法是从red

- SQL性能优化-持续更新中。。。。。。

atongyeye

oraclesql

1 通过ROWID访问表--索引

你可以采用基于ROWID的访问方式情况,提高访问表的效率, , ROWID包含了表中记录的物理位置信息..ORACLE采用索引(INDEX)实现了数据和存放数据的物理位置(ROWID)之间的联系. 通常索引提供了快速访问ROWID的方法,因此那些基于索引列的查询就可以得到性能上的提高.

2 共享SQL语句--相同的sql放入缓存

3 选择最有效率的表

- [JAVA语言]JAVA虚拟机对底层硬件的操控还不完善

comsci

JAVA虚拟机

如果我们用汇编语言编写一个直接读写CPU寄存器的代码段,然后利用这个代码段去控制被操作系统屏蔽的硬件资源,这对于JVM虚拟机显然是不合法的,对操作系统来讲,这样也是不合法的,但是如果是一个工程项目的确需要这样做,合同已经签了,我们又不能够这样做,怎么办呢? 那么一个精通汇编语言的那种X客,是否在这个时候就会发生某种至关重要的作用呢?

&n

- lvs- real

男人50

LVS

#!/bin/bash

#

# Script to start LVS DR real server.

# description: LVS DR real server

#

#. /etc/rc.d/init.d/functions

VIP=10.10.6.252

host='/bin/hostname'

case "$1" in

sta

- 生成公钥和私钥

oloz

DSA安全加密

package com.msserver.core.util;

import java.security.KeyPair;

import java.security.PrivateKey;

import java.security.PublicKey;

import java.security.SecureRandom;

public class SecurityUtil {

- UIView 中加入的cocos2d,背景透明

374016526

cocos2dglClearColor

要点是首先pixelFormat:kEAGLColorFormatRGBA8,必须有alpha层才能透明。然后view设置为透明glView.opaque = NO;[director setOpenGLView:glView];[self.viewController.view setBackgroundColor:[UIColor clearColor]];[self.viewControll

- mysql常用命令

香水浓

mysql

连接数据库

mysql -u troy -ptroy

备份表

mysqldump -u troy -ptroy mm_database mm_user_tbl > user.sql

恢复表(与恢复数据库命令相同)

mysql -u troy -ptroy mm_database < user.sql

备份数据库

mysqldump -u troy -ptroy

- 我的架构经验系列文章 - 后端架构 - 系统层面

agevs

JavaScriptjquerycsshtml5

系统层面:

高可用性

所谓高可用性也就是通过避免单独故障加上快速故障转移实现一旦某台物理服务器出现故障能实现故障快速恢复。一般来说,可以采用两种方式,如果可以做业务可以做负载均衡则通过负载均衡实现集群,然后针对每一台服务器进行监控,一旦发生故障则从集群中移除;如果业务只能有单点入口那么可以通过实现Standby机加上虚拟IP机制,实现Active机在出现故障之后虚拟IP转移到Standby的快速

- 利用ant进行远程tomcat部署

aijuans

tomcat

在javaEE项目中,需要将工程部署到远程服务器上,如果部署的频率比较高,手动部署的方式就比较麻烦,可以利用Ant工具实现快捷的部署。这篇博文详细介绍了ant配置的步骤(http://www.cnblogs.com/GloriousOnion/archive/2012/12/18/2822817.html),但是在tomcat7以上不适用,需要修改配置,具体如下:

1.配置tomcat的用户角色

- 获取复利总收入

baalwolf

获取

public static void main(String args[]){

int money=200;

int year=1;

double rate=0.1;

&

- eclipse.ini解释

BigBird2012

eclipse

大多数java开发者使用的都是eclipse,今天感兴趣去eclipse官网搜了一下eclipse.ini的配置,供大家参考,我会把关键的部分给大家用中文解释一下。还是推荐有问题不会直接搜谷歌,看官方文档,这样我们会知道问题的真面目是什么,对问题也有一个全面清晰的认识。

Overview

1、Eclipse.ini的作用

Eclipse startup is controlled by th

- AngularJS实现分页功能

bijian1013

JavaScriptAngularJS分页

对于大多数web应用来说显示项目列表是一种很常见的任务。通常情况下,我们的数据会比较多,无法很好地显示在单个页面中。在这种情况下,我们需要把数据以页的方式来展示,同时带有转到上一页和下一页的功能。既然在整个应用中这是一种很常见的需求,那么把这一功能抽象成一个通用的、可复用的分页(Paginator)服务是很有意义的。

&nbs

- [Maven学习笔记三]Maven archetype

bit1129

ArcheType

archetype的英文意思是原型,Maven archetype表示创建Maven模块的模版,比如创建web项目,创建Spring项目等等.

mvn archetype提供了一种命令行交互式创建Maven项目或者模块的方式,

mvn archetype

1.在LearnMaven-ch03目录下,执行命令mvn archetype:gener

- 【Java命令三】jps

bit1129

Java命令

jps很简单,用于显示当前运行的Java进程,也可以连接到远程服务器去查看

[hadoop@hadoop bin]$ jps -help

usage: jps [-help]

jps [-q] [-mlvV] [<hostid>]

Definitions:

<hostid>: <hostname>[:

- ZABBIX2.2 2.4 等各版本之间的兼容性

ronin47

zabbix更新很快,从2009年到现在已经更新多个版本,为了使用更多zabbix的新特性,随之而来的便是升级版本,zabbix版本兼容性是必须优先考虑的一点 客户端AGENT兼容

zabbix1.x到zabbix2.x的所有agent都兼容zabbix server2.4:如果你升级zabbix server,客户端是可以不做任何改变,除非你想使用agent的一些新特性。 Zabbix代理(p

- unity 3d还是cocos2dx哪个适合游戏?

brotherlamp

unity自学unity教程unity视频unity资料unity

unity 3d还是cocos2dx哪个适合游戏?

问:unity 3d还是cocos2dx哪个适合游戏?

答:首先目前来看unity视频教程因为是3d引擎,目前对2d支持并不完善,unity 3d 目前做2d普遍两种思路,一种是正交相机,3d画面2d视角,另一种是通过一些插件,动态创建mesh来绘制图形单元目前用的较多的是2d toolkit,ex2d,smooth moves,sm2,

- 百度笔试题:一个已经排序好的很大的数组,现在给它划分成m段,每段长度不定,段长最长为k,然后段内打乱顺序,请设计一个算法对其进行重新排序

bylijinnan

java算法面试百度招聘

import java.util.Arrays;

/**

* 最早是在陈利人老师的微博看到这道题:

* #面试题#An array with n elements which is K most sorted,就是每个element的初始位置和它最终的排序后的位置的距离不超过常数K

* 设计一个排序算法。It should be faster than O(n*lgn)。

- 获取checkbox复选框的值

chiangfai

checkbox

<title>CheckBox</title>

<script type = "text/javascript">

doGetVal: function doGetVal()

{

//var fruitName = document.getElementById("apple").value;//根据

- MySQLdb用户指南

chenchao051

mysqldb

原网页被墙,放这里备用。 MySQLdb User's Guide

Contents

Introduction

Installation

_mysql

MySQL C API translation

MySQL C API function mapping

Some _mysql examples

MySQLdb

- HIVE 窗口及分析函数

daizj

hive窗口函数分析函数

窗口函数应用场景:

(1)用于分区排序

(2)动态Group By

(3)Top N

(4)累计计算

(5)层次查询

一、分析函数

用于等级、百分点、n分片等。

函数 说明

RANK() &nbs

- PHP ZipArchive 实现压缩解压Zip文件

dcj3sjt126com

PHPzip

PHP ZipArchive 是PHP自带的扩展类,可以轻松实现ZIP文件的压缩和解压,使用前首先要确保PHP ZIP 扩展已经开启,具体开启方法就不说了,不同的平台开启PHP扩增的方法网上都有,如有疑问欢迎交流。这里整理一下常用的示例供参考。

一、解压缩zip文件 01 02 03 04 05 06 07 08 09 10 11

- 精彩英语贺词

dcj3sjt126com

英语

I'm always here

我会一直在这里支持你

&nb

- 基于Java注解的Spring的IoC功能

e200702084

javaspringbeanIOCOffice

- java模拟post请求

geeksun

java

一般API接收客户端(比如网页、APP或其他应用服务)的请求,但在测试时需要模拟来自外界的请求,经探索,使用HttpComponentshttpClient可模拟Post提交请求。 此处用HttpComponents的httpclient来完成使命。

import org.apache.http.HttpEntity ;

import org.apache.http.HttpRespon

- Swift语法之 ---- ?和!区别

hongtoushizi

?swift!

转载自: http://blog.sina.com.cn/s/blog_71715bf80102ux3v.html

Swift语言使用var定义变量,但和别的语言不同,Swift里不会自动给变量赋初始值,也就是说变量不会有默认值,所以要求使用变量之前必须要对其初始化。如果在使用变量之前不进行初始化就会报错:

var stringValue : String

//

- centos7安装jdk1.7

jisonami

jdkcentos

安装JDK1.7

步骤1、解压tar包在当前目录

[root@localhost usr]#tar -xzvf jdk-7u75-linux-x64.tar.gz

步骤2:配置环境变量

在etc/profile文件下添加

export JAVA_HOME=/usr/java/jdk1.7.0_75

export CLASSPATH=/usr/java/jdk1.7.0_75/lib

- 数据源架构模式之数据映射器

home198979

PHP架构数据映射器datamapper

前面分别介绍了数据源架构模式之表数据入口、数据源架构模式之行和数据入口数据源架构模式之活动记录,相较于这三种数据源架构模式,数据映射器显得更加“高大上”。

一、概念

数据映射器(Data Mapper):在保持对象和数据库(以及映射器本身)彼此独立的情况下,在二者之间移动数据的一个映射器层。概念永远都是抽象的,简单的说,数据映射器就是一个负责将数据映射到对象的类数据。

&nb

- 在Python中使用MYSQL

pda158

mysqlpython

缘由 近期在折腾一个小东西须要抓取网上的页面。然后进行解析。将结果放到

数据库中。 了解到

Python在这方面有优势,便选用之。 由于我有台

server上面安装有

mysql,自然使用之。在进行数据库的这个操作过程中遇到了不少问题,这里

记录一下,大家共勉。

python中mysql的调用

百度之后能够通过MySQLdb进行数据库操作。

- 单例模式

hxl1988_0311

java单例设计模式单件

package com.sosop.designpattern.singleton;

/*

* 单件模式:保证一个类必须只有一个实例,并提供全局的访问点

*

* 所以单例模式必须有私有的构造器,没有私有构造器根本不用谈单件

*

* 必须考虑到并发情况下创建了多个实例对象

* */

/**

* 虽然有锁,但是只在第一次创建对象的时候加锁,并发时不会存在效率

- 27种迹象显示你应该辞掉程序员的工作

vipshichg

工作

1、你仍然在等待老板在2010年答应的要提拔你的暗示。 2、你的上级近10年没有开发过任何代码。 3、老板假装懂你说的这些技术,但实际上他完全不知道你在说什么。 4、你干完的项目6个月后才部署到现场服务器上。 5、时不时的,老板在检查你刚刚完成的工作时,要求按新想法重新开发。 6、而最终这个软件只有12个用户。 7、时间全浪费在办公室政治中,而不是用在开发好的软件上。 8、部署前5分钟才开始测试。