DeepMind强化学习综述:快速和缓慢的强化学习

背景

近年来,深度强化学习(RL)方法在人工智能方面取得了令人瞩目的进步,在从Atari到Go到无限制扑克等领域都超过了人类的表现。

这一进展引起了对了解人类学习感兴趣的认知科学家的关注。但是,人们一直担心,深层RL可能太低样本效率-也就是说,它可能太慢-无法为人类学习提供一个合理的模型。

在本综述中,作者通过描述最近开发的技术来反驳这种批评,这些技术使深层RL能够更灵活地运行,比以前的方法更快地解决问题。尽管这些技术是在AI环境中开发的,但我们建议它们可能会对心理学和神经科学产生深远的影响。这些AI方法产生的关键见解

要解决的问题

RL 很慢,也就是说大部分的 RL 方法非常的 sample inefficient.

问题来源

- DRL 需要增量的更新,在 使用梯度方法更新 NN 的时候,大的更新会让网络非常的不稳定

- 非常弱的 Induction Bias (可以理解为推导能力比较弱,很难从问题中发现真正有效的结构)

DeepMind列举了两个主要原因:

一种是增量参数调整(增量参数调整)原始算法从输入环境到输出人工智能动作,采用梯度下降法进行映射。

在这个过程中,每一个增量都需要非常小,这样新学到的信息就不会被覆盖,以前学到的经验也会被覆盖(这称为“灾难性干扰”)因此,学习过程非常缓慢。

二是弱感应偏压。任何学习过程都必须面对“偏见-差异权衡”

所谓偏见是在开始时限制一些可能的结果,人工智能从内部找到它想要的结果。限值越窄,人工智能只能考虑一些可能性,更快地得到结果。

弱归纳偏差,需要考虑更多的可能性,学习比较慢。重要的是,通用神经网络是一个极低偏差的系统,它们有大量的参数可以用来拟合广泛的数据。

drl是在rl中使用深度网络。因此,初始样本效率必须非常低,需要大量的数据来学习。

如何解决

deepmind引用了两种方法,正确的路径。

首先,解决参数增量问题:

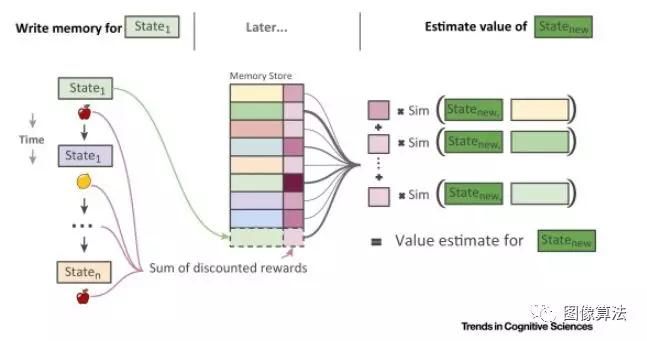

该方法是一种Episodic深度强化学习(Episodic DRL)它是为过去发生的事件保留显式记录(显式记录)。此记录将作为指导人工智能做出新决策的基础。

它类似于机器学习中的“非参数”方法,更类似于“基于样本”的心理学。

当遇到新事件时,新的内部决策(内部表示)将与存储的过去事件进行比较在中间匹配最高得分。

增量方法和增量方法的区别在于,在这里,可以立即使用从过去事件中学习到的信息,从而加快学习过程。

但是请注意,快速事件学习是基于缓慢的增量学习。

因为,在比较当前事件和过去事件的表示之前,AI必须首先学习这些表示:连接权重的学习仍然是增量的,就像传统的DRL算法一样。

慢慢学习角色化后,你就可以开始跑得很快了。

deepmind说,心理学和神经科学和人工智能领域(这一部分,你可以自己探索原文)都反映出“从慢变慢”并非巧合。

然后,解决感应偏压问题:

首先定义一个狭窄的范围,让人工智能探索。一切都明白了,你怎么知道该把它限制在哪里?

答案是借鉴过去的经验。

例如,第一次使用智能手机的人可能以前使用过其他设备。那里的经验可以帮助他快速学会如何使用智能手机。如果你没有这些经验,你只能广泛尝试,影响学习的速度。

这个想法也源于心理学,叫做“学会学习”

心理学家哈里·哈洛用猴子做实验:给猴子两个不熟悉的东西,一个做食物,一个做食物。换两个对象,然后换两个…很久以前的猴子都知道,不管东西是什么,不管它是在左边还是在右边,一边都没有食物。

回到人工智能领域,利用过去的经验加速学习。在机器学习中,它被称为元学习。

王和段领导的两项研究几乎同时发表。所有这些原则都被用于深层强化学习,即元强化学习(meta-rl)。

一个rnn由许多相互关联的rl任务训练。

慢慢调整rnn的权值,然后吸收各种rl任务中的公共点来改变网络设置。最初,它无法快速更改以支持任何单个任务。

关键是从rnn的活动动力学出发,生成一个独立的rl算法,在已有任务的基础上快速求解新任务。

一个rl算法可以生成另一个rl算法,即元增强学习。

与plot RL一样,meta RL还涉及快速和慢速之间的链接:

在学习不同的RL任务的过程中,RNN中的连接会缓慢地更新,在不同的任务之间建立一个公共部分并将其构建到网络中。

让这个rnn,实现新的rl算法,快速完成任务。毕竟,对于学习基础知识的速度慢已经存在一种归纳偏见(就像人类使用智能手机之前使用过的其他设备一样)。

然而,慢是快速的先决条件。

当然,plot-drl可以与meta-rl相结合,相互补充。

在幕式元康复学习中,元学习是在rnn中实现的,但与情节记忆系统叠加以恢复rnn中的活动模式。

就像plot rl一样,插曲内存对各种过去的事件进行编目,并可以进行查询。

但决策过程是不同的,而不是根据匹配得分选择下一步行动。它链接到rnn存储的活动模式。

这些模式非常重要,通过rnn,它们可以总结出代理所学到的东西。

当代理遇到类似于过去的情况时,它将恢复以前经验中的一些隐藏激活,这样以前学到的信息将派上用场并影响当前的策略。

这就是所谓的情景强化学习,它可以进一步加快强化学习的速度。

总结

标题是 RL, fast and slow. 但是我们会发现,即使是 fast 也来源于 slow, 就是想让一个Agent 在一个新任务上表现的又好又快依赖于 offline 大量的pre-train.

这个也和人类的遗传相似,遗传的过程可以看作是 RNN,经历了很多代之后的人类有了很多经验,这样才能在新任务上很快适应。

相关论文源码下载地址:关注“图像算法”微信公众号 回复“强化学习”