SIGIR2019|深度学习如何更好地用于学习排序(LTR)(已开源)

Revisiting Approximate Metric Optimization in the Age of Deep Neural Networks

Sebastian Bruch, Masrour Zoghi, Michael Bendersky, Marc Najork

Google Research

https://storage.googleapis.com/pub-tools-public-publication-data/pdf/203cdfb3cad97d962b742ac8d6d61d16ae6008c9.pdf

通过学习进行排序是有监督机器学习的一个分支,这种方法能够生成商品的排列,使得该有序列表的效用最大化。

跟大部分机器学习方法有所不同,目标函数不能直接利用梯度下降方法来优化,因为它要么处处不连续,要么处处水平。因此,通过学习进行排序的方法通常优化损失函数使其以一个排序效用为上界或者相对比较松弛。

一个显著的特例即为Qin等人提出的近似框架,利用一种更加直接的方法对度量优化进行排序。这篇文章重温该框架,这得益于近十年来神经网络的发展,本文通过实验表明了该方法的卓越性。

通过这项研究,希望来源于该想法的工作比之前更相关,并且在深度神经网络时代为通过学习进行排序奠定基础。

学习排序问题描述及相关的评价指标如下

由于梯度相关的缺陷,作者们提出了若干改进算法

LTR问题描述如下

评分函数 经验损失形式如下

相关方法如下

NDCG 以及 DCG 定义及特性如下

也可以利用一些方法直接最大化排序度量,或者利用一些技巧之后进而可以利用梯度下降来更容易地优化

近似NDCG的来由以及部分推导如下

不同的参数下sigmoid对指示函数的逼近程度如下

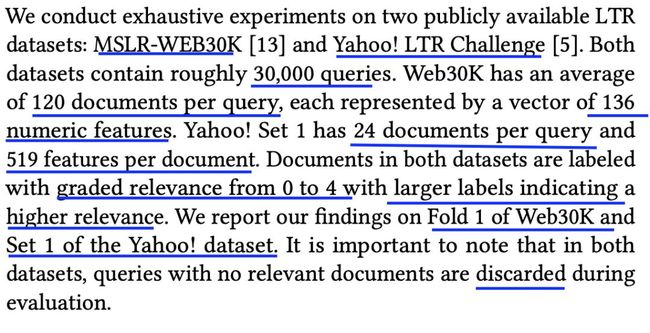

数据集信息如下

对比算法以及实验细节如下

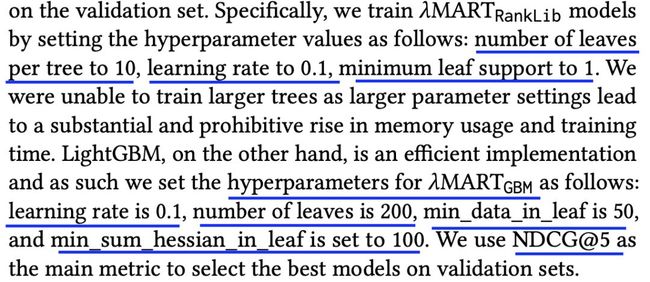

超参数设置如下

作者们所提方法细节如下

不同参数在数据集Web30K上的效果对比如下

结果表明,参数alpha过大或过小都不合适

不同的网络深度在数据集Web30K上的效果对比如下

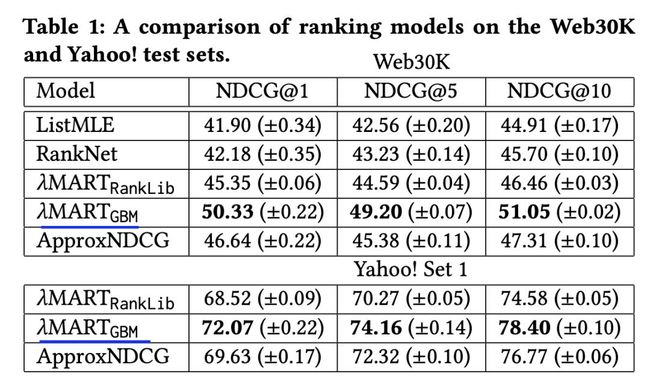

不同方法在数据集Web30K和Yahoo!上的效果对比如下

代码地址

https://github.com/tensorflow/ranking

![]() 我是分割线

我是分割线![]()

您可能感兴趣

SIGIR2019|利用DeepSHAP来解释神经检索模型(已开源)

SIGIR2019|胶囊网络来解释你喜欢什么不喜欢什么(已开源)

KDD2018|基于GBM的动态定价回归模型

KDD2018|超越deepfm的CTR预估模型深层兴趣网络DIN(已开源)

RecSys2019|优于DeepFM和XDeepFM的CTR模型FiBiNET

SIGIR2018|选择性GBDT(SelGB)用于排序学习(已开源)

AAAI2018|斯坦福大学提出并开源增强生成式模型

ijcai2017|CTR经典模型DeepFM,FNN,PNN,W&D,LR,FM对比(哈工大诺亚方舟提出CTR模型)

ICML2019|一种基于强化学习的推荐系统(GAN用户模型,佐治亚理工学院联合蚂蚁金服提出且已开源)

ICML2018|GBDT中如何寻找影响较大样本(普林斯顿大学联合Yandex提出并开源)

IJCAI2019|基于对抗变分自编码的协同过滤框架VAEGAN

聊聊CatBoost

聊聊XGBoost CatBoost LightGBM RF GBDT

IJCAI2019|新型特征增广GBDT--AugBoost(已开源)

IJCAI2019|清华大学提出并开源新型梯度提升决策树(梯度提升分段线性回归树)

新型梯度提升决策树GBDT-SPARSE(谷歌微软FaceBook加州大学联合提出)

ICML2019|深度学习鼻祖之一Bengio提出并开源图马尔科夫神经网络

GBDT,LR,深度学习如何联合发力(以推荐系统和游戏为例)

大规模GBDT系统应用场景及效果对比(LightGBM,XgBoost,DimBoost等)

新型在线预测模型DeepGBM(基于GBDT扩展的深度学习框架)

顶会中深度学习用于CTR预估的论文及代码集锦 (3)

NIPS2018深度学习(9)|亮点:多元卷积稀疏编码、循环关系网络

ICML 2018 深度学习论文及代码集锦(5)

深度学习用于文本摘要的论文及代码集锦

深度学习用于机器翻译的论文及代码集锦

深度学习用于序列标注中的论文及代码集锦

深度学习在推荐系统中的应用及代码集锦(4)

深度学习在OCR中的应用论文及代码集锦 (2)