Memory in Memory: 一种学习高阶非线性时空动态的神经网络

1、文章信息

《Memory In Memory: A Predictive Neural Network for Learning Higher-Order Non-Stationarity from Spatiotemporal Dynamics》。

2019年4月挂在arXiv上的一篇文章。

2、摘要

很多时空过程在很多方面都是非平稳的,例如局部像素值的空间相关性或时间依赖性等低阶非平稳性;以及降水预报中雷达回波积累、变形、消散等高阶可变性。任何非平稳过程都可以分解成确定性的、时变的多项式,加上一个零均值的随机项,通过适当地应用差分运算,我们可以把时变多项式变成一个常数,使确定性的组成部分变得可预测。

然而,以往用于时空预测的递归神经网络大多不能有效地利用差分信号,其相对简单的状态转换函数使其不能学习太复杂的时空变化。为此,我们提出了memory in memory (MIM)网络和相应的递归块。MIM块利用相邻重复状态之间的差异信号,通过两个级联的、自更新的记忆模块,对时空动态学中的非平稳和近似稳定特性进行建模。通过叠加多个MIM块,我们可以潜在地处理高阶非平稳性。MIM网络在4个时空预测任务上取得了最先进的结果,这些任务包括合成数据集和真实数据集。我们认为,这项工作的总体思路可以潜在地应用于其他时间序列预测任务。

3、简介

自然时空过程在空间和时间上都表现出复杂的非平稳性,其中相邻像素表现出局部相关性,它们的联合分布随着时间变化也呈现出非平稳性。学习时空非平稳性下的高阶特性对于许多视频预测任务具有特别重要的意义,例如对高度复杂的现实世界系统建模,如交通流和天气条件。一个性能良好的预测模型可以学习连续时空背景下的内在变化,这种变化可以被看作是平稳分量和确定性非平稳分量的组合。

非平稳时空预测的一个重大挑战是如何有效地捕捉每个像素及其局部区域的高阶趋势。例如,在进行降水预报时,应仔细考虑演进的雷达图上复杂多样的局部趋势,如图所示。

但由于空间和时间的复杂非平稳性,这一问题极为困难。大多数以前的工作使用递归的CNNs处理类似趋势的非平稳性或在RNNs中使用相对简单的状态转换。由于缺乏非平稳建模能力,因此无法对时空动态中的不确定性进行推理,并在一定程度上导致预测帧的模糊效应。

我们试图通过提出一种通用的在非平稳建模中更有效的RNNs体系结构来解决这个问题。我们发现,虽然递归预测模型中的遗忘门可以在记忆状态转换过程中传递、选择和丢弃信息,但它们太过简单,无法捕捉高维时间序列中的高阶非平稳趋势。特别是,在最近的PredRNN模型[32]中,遗忘门不能很好地用于降水预报:大约80%的遗忘门在所有时间戳上都是饱和的,这意味着几乎是时不变的内存状态转换。换句话说,未来的框架是通过近似线性外推来预测的。

在本文中,我们着重于改进RNNs的记忆转换功能。经典时间序列分析中的大多数统计预测方法都假设非平稳趋势可以通过执行适当的转换(如差分)来近似平稳。我们将这个概念引入到RNNs中,并提出了一种新的RNNs构建块,称为(Memory In Memory, MIM),它利用了循环路径中相邻隐藏状态之间的差异信息。MIM可以被看作是LSTM的改进版本,LSTM的遗忘门被另外两个嵌入的长短时记忆cell所代替。

MIM具有以下特点:(1)通过区分相邻的隐藏状态而不是原始图像,对时空的非平稳性进行统一建模。(2)通过叠加多个MIM块,我们的模型有机会使时空过程逐渐平稳化,使其更具可预测性。(3)值得注意的是,过度差分对时间序列预测是没有好处的,因为它不可避免地会导致信息的丢失。这是我们在memory转换中(hidden state)应用差分而不是在所有gate中应用差分的另一个原因。MIM有一个从LSTMs采用的内存单元,以及两个额外的循环模块,它们自己的内存嵌入到第一个内存的转换路径中。(4)MIM有一个从LSTMs获取的的memory cell,以及两个额外的循环模块,这两个额外的循环模块的memory被嵌入到第一个memory的转换路径中。利用这些模型分别对时空动态的高阶非平稳分量和近似平稳分量进行了建模。所提出的MIM网络在多个预测任务上取得了最先进的结果,包括一个广泛使用的综合数据集和三个真实世界的数据集。

4、主体内容

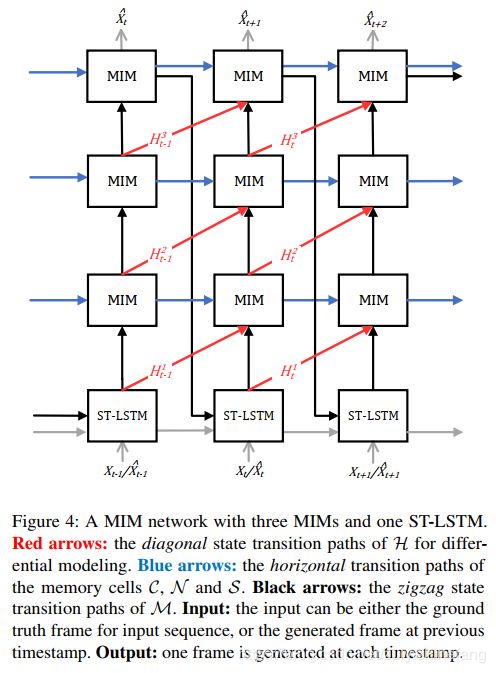

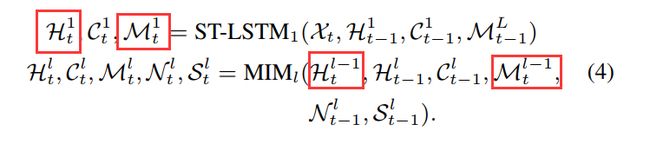

在本节中,首先介绍MIM块,用于从RNNs记忆转换学习高阶非平稳性。然后,讨论了一种新的RNN结构,它将多个MIM块在一起。MIM块具有对角状态连接,用于对时空预测中的差异信息建模。通过叠加多个MIM块,可以从时空动力学中学习高阶非平稳性。所提出的MIM状态转换方法可以集成到所有类似lstm的单元中。我们选择了时空LSTM (ST-LSTM) 作为我们在预测精度和计算效率之间进行权衡的基础网络。ST-LSTM具有双存储器结构dual-memory structure,Ct和Mt,如图所示。Mt的之字形memory flow,如图4中的黑色箭头所示,通过增加循环过渡深度来增强其短期建模能力。

Memory in Memory block

我们观察到时空序列中的复杂动态可以通过平稳变化和非平稳变化的组合来更有效地处理。假设我们有一个视频序列显示一个人以恒定的速度行走。速度可以看作是一个平稳的变量,腿的摆动应该看作是一个非平稳的过程,这显然更难以预测。不幸的是,在以前类似于lstm的模型中,遗忘门是一个简单的门结构,难以捕捉时空中的非平稳变化。在初步实验中,我们发现在最近的PredRNN模型中,大多数遗忘门是饱和的,这意味着单元总是记住平稳变化。

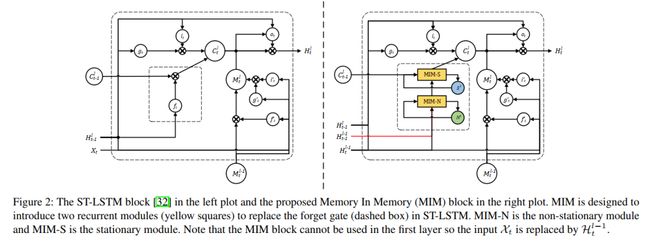

MIM块使用一系列级联的记忆转变而不是ST-LSTM中简单的、容易饱和的遗忘门来对非平稳变化进行建模。如图2(较小的虚线框),设计了两个级联时间记忆递归模块来代替ST-LSTM中时间遗忘门ft。

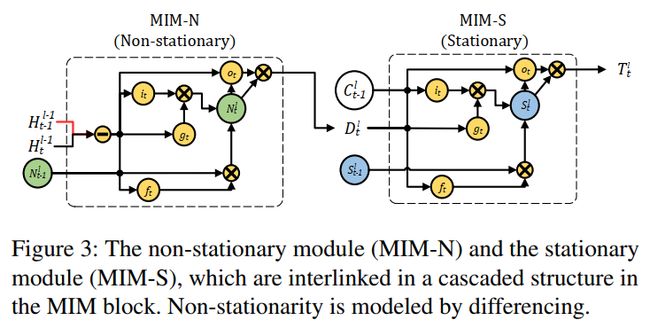

第一个模块额外以Ht-1作为输入,用于捕获基于两个状态之间的差分(Ht - Ht- 1)的非平稳变化。因此,我们将其命名为非平稳模块non-stationary module (如图3中所示的MIM-N)。它会基于差分平稳假设产生不同的特征Dt。另一个模块讲MIM-N的输出Dt以及外部的细胞状态Ct作为输入,以捕捉时空序列的近似平稳变化。因此,我们将其称为stationary module(如图3中所示的MIM-S)。通过将忘记门替换为级联的两个模块的最终输出Tt (如图3所示),非平稳动力学可以更有效地捕捉。MIM块关键运算此处不再罗列。

Memory In Memory Networks

通过叠加多个MIM块,我们的模型有机会捕捉到更高阶的非平稳性,使时空过程逐渐平稳,使未来序列更加可预测。该体系结构的关键思想是提供必要的隐藏状态,以生成差分后的特性并最好地促进非平稳性建模。

图4显示了我们提出的对角循环体系结构的示意图。我们给出隐状态H t−1和Ht到MIM块,在时间戳t≠1和层l≠1时生成差异特征,以供进一步使用,如图4中的对角线箭头。由于第一层没有任何先前的层,我们简单地使用了Spatiotemporal LSTM (ST-LSTM)生成它的隐藏状态。注意,在MIM中,时间差异是通过从隐藏状态Ht减去Ht−1来实现的。与直接对相邻原始图像进行差分相比,通过底层ST-LSTM层将局部区域的时空变化编码到隐藏表示中,对时间上相邻的隐状态进行差分可以更明显地揭示出非平稳性。

MIM网络的另一个显著特征是水平状态转换路径。由于MIM块具有两个级联的时间记忆模块,分别捕获非平稳和平稳动态,我们进一步沿着图4中的蓝色箭头传递两个时间记忆(非平稳记忆用N表示,平稳记忆用S表示)。

MIM网络在一个时间戳上生成一个帧。整个模型可以用一个ST-LSTM和L−1个MIMs表示(2≤L≤L)。注意,MIM块从L=2开始。

在克拉默分解的基础上,将高阶非平稳性描述为高阶多项式,在时空语境中,它指的是像素值统计的变化趋势。非平稳多项式的阶数可以通过几个不同的操作来减少。我们将时间序列分析和深度学习的思想融合在一起:用不同的输入逐层叠加MIMs。

5、试验部分

实验部分采用了Moving MNIST,TaxiBJ Traffic Flow(ST-ResNet公开的数据集),雷达回波图降水量预测的数据集以及Human3.6M数据集,都表现出最好的结果。

6、特别之处

差分的思想以及数据结果的展示方式值得学习借鉴。

Attention

如果你和我一样是轨道交通、道路交通、城市规划相关领域的,可以加微信:Dr_JinleiZhang,备注“进群”,加入交通大数据交流群!希望我们共同进步!