Netty中的三种Reactor(反应堆)( netty线程模型)

一、netty概述

1、netty是什么?

Netty是一个基于Java NIO的client-server网络服务框架,人们可以利用netty快速地开发网络应用,Netty是一个提供异步事件驱动的网络应用框架,用以快速开发高性能、高可靠的网络服务器和客户端程序。Netty简化了网络程序的开发,是很多框架和公司都在使用的技术。

2、netty的特点?

- 一个高性能、异步事件驱动的NIO框架,它提供了对TCP、UDP和文件传输的支持

- 使用更高效的socket底层,对epoll空轮询引起的cpu占用飙升在内部进行了处理,避免了直接使用NIO的陷阱,简化了NIO的处理方式。

- 采用多种decoder/encoder 支持,对TCP粘包/分包进行自动化处理

- 可使用接受/处理线程池,提高连接效率,对重连、心跳检测的简单支持

- 可配置IO线程数、TCP参数, TCP接收和发送缓冲区使用直接内存代替堆内存,通过内存池的方式循环利用ByteBuf

- 通过引用计数器及时申请释放不再引用的对象,降低了GC频率

- 使用单线程串行化的方式,高效的Reactor线程模型

- 大量使用了volitale、使用了CAS和原子类、线程安全类的使用、读写锁的使用

3、netty原理?

-

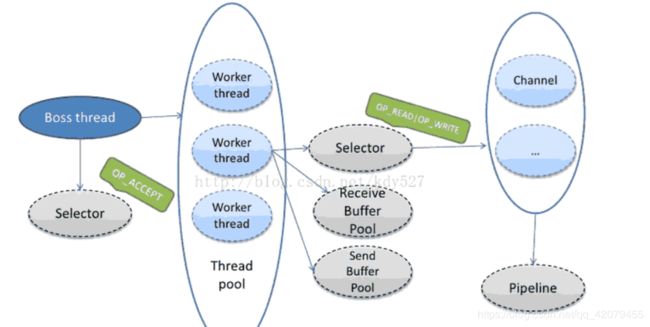

bossGroup线程:由这个线程池提供的线程是boss种类的,用于创建、连接、绑定socket,然后把这些socket传给worker线程池。在服务器端每个监听的socket都 有一个boss线程来处理。在客户端,只有一个boss线程来处理所有的socket。

-

workerGroup线程:Worker线 程执行所有的异步I/O。

他们不是通用的线程,开发人员需要注意不要把与其不同的任务赋给线程,这可能导致线程被阻塞、无法处理他们真正关心的任务,反过来会导致死锁和一些莫名其妙的性能问题。 -

ServerBootstrap:是一个对服务端做配置和启动的类

-

EventLoopGroup:它是继承于ScheduledExecutorService线程池接口的接口,而NioEventLoopGroup就是它的一个实现类。在服务器启动时,创建两个线程池,xi惯上一个叫bossGroup,一个叫workGroup,如果在构造函数中不指定创建的线程数量,会默认创建当前cpu个数的2倍个。

-

ChannelInitializer:当一个链接建立时,我们需要知道怎么来接收或者发送数据,当然,我们有各种各样的Handler实现来处理它,那么ChannelInitializer便是用来配置这些Handler,它会提供一个ChannelPipeline,并把Handler加入到ChannelPipeline。

关系:

可以这么说,ServerBootstrap监听的一个端口对应一个boss线程,它们一 一对应。比如你需要netty监听80和443端口,那么就会有两个boss线程分别负责处理来自两个端口的socket请求。在boss线程接收了socket连接请求后,会产生一个channel(一个打开的socket对应一个打开的channel),并把这个channel交给ServerBootstrap初始化时指定的ChannelInitializer来处理,boss线程则继续处理socket的请求。从worker线程池中找出一个worker线程来继续处理这个请求。

如果是Oio的话,那个这个channel上所有的socket消息,从开始到channel(socket)关闭,都只由这个特定的worker来处理,也就是说一个打开的socket对应一个指定的worker线程,这个worker线程在socket没有关闭的情况下,也只能为这个socket处理消息,无法服务其他socket。

当一个连接到达,Netty会注册一个channel,然后EventLoopGroup(worker)会分配一个EventLoop绑定到这个channel,在这个channel的整个生命周期过程中,都会由绑定的这个EventLoop来为它服务,而这个EventLoop就是一个线程。

3、netty的线程模型?

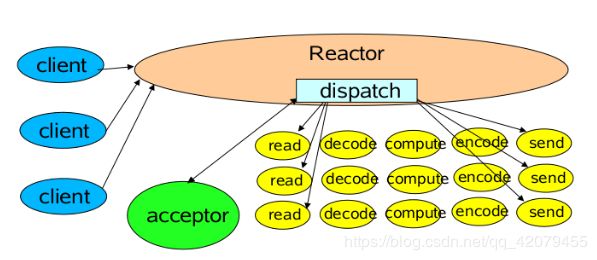

- 单线程模型:所有I/O操作都由一个线程完成,即多路复用、事件分发和处理都是在一个Reactor线程上完成的。既要接收客户端的连接请求,向服务端发起连接,又要发送/读取请求或应答/响应消息。一个NIO线程同时处理成百上千的链路,性能上无法支撑,速度慢,若线程进入死循环,整个程序不可用,对于高负载、大并发的应用场景不合适。

- 多线程模型:有一个NIO 线程(Acceptor) 只负责监听服务端,接收客户端的TCP 连接请求;NIO 线程池负责网络IO的操作,即消息的读取、解码、编码和发送;1 个NIO 线程可以同时处理N 条链路,但是1 个链路只对应1 个NIO 线程,这是为了防止发生并发操作问题。但在并发百万客户端连接或需要安全认证时,一个Acceptor 线程可能会存在性能不足问题。

- 主从多线程模型:Acceptor 线程用于绑定监听端口,接收客户端连接,将SocketChannel 从主线程池的Reactor线程的多路复用器上移除,重新注册到Sub 线程池的线程上,用于处理I/O 的读写等操作,从而保证mainReactor只负责接入认证、握手等操作。

二、netty的线程模型

1、 Reactor单线程模型

Reactor单线程模型,指的是所有的I/O操作都在同一个NIO线程上面完成,NIO线程的职责如下:

- 作为NIO服务端,接收客户端的TCP连接;

- 作为NIO客户端,向服务端发起TCP连接;

- 读取通信对端的请求或者应答消息;

- 向通信对端发送消息请求或者应答消息;

Reactor线程是个多面手,负责多路分离套接字,Accept新连接,并分派请求到处理器链中。该模型 适用于处理器链中业务处理组件能快速完成的场景。不过,这种单线程模型不能充分利用多核资源,所以实际使用的不多。

对于一些小容量应用场景,可以使用单线程模型,但是对于高负载、大并发的应用却不合适,主要原因如下:

- 一个NIO线程同时处理成百上千的链路,性能上无法支撑。即便NIO线程的CPU负荷达到100%,也无法满足海量消息的编码、解码、读取和发送;

- 当NIO线程负载过重之后,处理速度将变慢,这会导致大量客户端连接超时,超时之后往往进行重发,这更加重了NIO线程的负载,最终导致大量消息积压和处理超时,NIO线程会成为系统的性能瓶颈;

- 可靠性问题。一旦NIO线程意外跑飞,或者进入死循环,会导致整个系统通讯模块不可用,不能接收和处理外部信息,造成节点故障。

为了解决这些问题,演进出了Reactor多线程模型,下面我们一起学习下Reactor多线程模型。

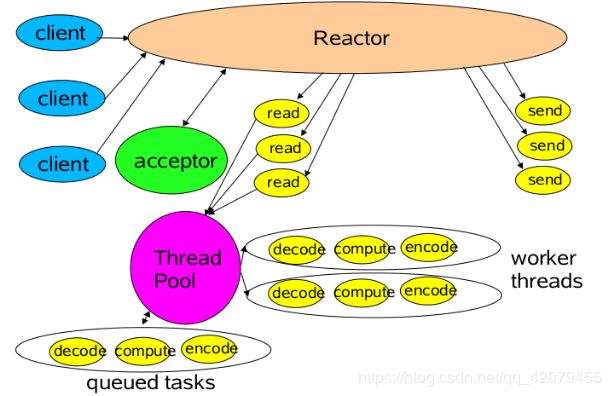

2、Reactor多线程模型

Reactor多线程模型与单线程模型最大区别就是有一组NIO线程处理I/O操作,它的特点如下:

- 有一个专门的NIO线程–acceptor新城用于监听服务端,接收客户端的TCP连接请求;

- 网络I/O操作–读、写等由一个NIO线程池负责,线程池可以采用标准的JDK线程池实现,它包含一个任务队列和N个可用的线程,由这些NIO线程负责消息的读取、解码、编码和发送;

- 1个NIO线程可以同时处理N条链路,但是1个链路只对应1个NIO线程,防止发生并发操作问题

在绝大多数场景下,Reactor多线程模型都可以满足性能需求;但是,在极特殊应用场景中,一个NIO线程负责监听和处理所有的客户端连接可能会存在性能问题。例如百万客户端并发连接,或者服务端需要对客户端的握手信息进行安全认证,认证本身非常损耗性能。这类场景下,单独一个Acceptor线程可能会存在性能不足问题,为了解决性能问题,产生了第三种Reactor线程模型–主从Reactor多线程模型。

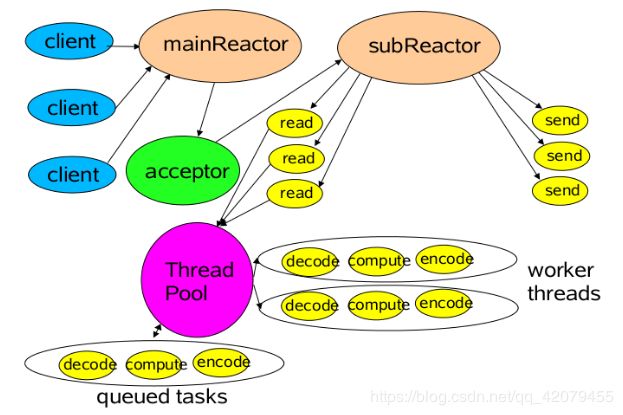

3、主从Reactor多线程模型

务端用于接收客户端连接的不再是1个单独的NIO线程,而是一个独立的NIO线程池。Acceptor接收到客户端TCP连接请求处理完成后(可能包含接入认证等),将新创建的SocketChannel注册到I/O线程池(sub reactor线程池)的某个I/O线程上,由它负责SocketChannel的读写和编解码工作。

Acceptor线程池只用于客户端的登录、握手和安全认证,一旦链路建立成功,就将链路注册到后端subReactor线程池的I/O线程上,有I/O线程负责后续的I/O操作。

第三种模型比起第二种模型,是将Reactor分成两部分,mainReactor负责监听server socket,accept新连接,并将建立的socket分派给subReactor。subReactor负责多路分离已连接的socket,读写网 络数据,对业务处理功能,其扔给worker线程池完成。通常,subReactor个数上可与CPU个数等同。

NioEventLoopGroup 与 Reactor 线程模型的对应Netty的线程模型并发固定不变,通过在启动辅助类中创建不同的EventLoopGroup实例并进行适当的参数配置,就可以支持上述三种Reactor线程模型。

Netty单线程模型服务端代码示例如下:

/**

* Netty单线程模型服务端代码示例

* @param port

*/

public void bind(int port) {

EventLoopGroup reactorGroup = new NioEventLoopGroup();

try {

ServerBootstrap b = new ServerBootstrap();

b.group(reactorGroup, reactorGroup)

.channel(NioServerSocketChannel.class)

.childHandler(new ChannelInitializer() {

@Override

protected void initChannel(SocketChannel ch) throws Exception {

ch.pipeline().addLast("http-codec", new HttpServerCodec());

ch.pipeline().addLast("aggregator", new HttpObjectAggregator(65536));

ch.pipeline().addLast("http-chunked", new ChunkedWriteHandler());

//后面代码省略

}

});

Channel ch = b.bind(port).sync().channel();

ch.closeFuture().sync();

} catch (InterruptedException e) {

e.printStackTrace();

} finally {

reactorGroup.shutdownGracefully();

}

}

Netty多线程模型代码如下:

/**

* Netty多线程模型代码

* @param port

*/

public void bind2(int port) {

EventLoopGroup acceptorGroup = new NioEventLoopGroup(1);

NioEventLoopGroup ioGroup = new NioEventLoopGroup();

try {

ServerBootstrap b = new ServerBootstrap();

b.group(acceptorGroup, ioGroup)

.channel(NioServerSocketChannel.class)

.childHandler(new ChannelInitializer() {

@Override

protected void initChannel(SocketChannel ch) throws Exception {

ch.pipeline().addLast("http-codec", new HttpServerCodec());

ch.pipeline().addLast("aggregator", new HttpObjectAggregator(65536));

ch.pipeline().addLast("http-chunked", new ChunkedWriteHandler());

//后面代码省略

}

});

Channel ch = b.bind(port).sync().channel();

ch.closeFuture().sync();

} catch (InterruptedException e) {

e.printStackTrace();

} finally {

acceptorGroup.shutdownGracefully();

ioGroup.shutdownGracefully();

}

}

Netty主从线程模型代码如下:

/**

* Netty主从线程模型代码

* @param port

*/

public void bind3(int port) {

EventLoopGroup acceptorGroup = new NioEventLoopGroup();

NioEventLoopGroup ioGroup = new NioEventLoopGroup();

try {

ServerBootstrap b = new ServerBootstrap();

b.group(acceptorGroup, ioGroup)

.channel(NioServerSocketChannel.class)

.childHandler(new ChannelInitializer() {

@Override

protected void initChannel(SocketChannel ch) throws Exception {

ch.pipeline().addLast("http-codec", new HttpServerCodec());

ch.pipeline().addLast("aggregator", new HttpObjectAggregator(65536));

ch.pipeline().addLast("http-chunked", new ChunkedWriteHandler());

//后面代码省略

}

});

Channel ch = b.bind(port).sync().channel();

ch.closeFuture().sync();

} catch (InterruptedException e) {

e.printStackTrace();

} finally {

acceptorGroup.shutdownGracefully();

ioGroup.shutdownGracefully();

}

}

说完Reacotr模型的三种形式,那么Netty是哪种呢?

其实,我还有一种Reactor模型的变种没说,那就是去掉线程池(没有了work线程池)的第三种形式的变种,这也 是Netty NIO的默认模式。

在实现上,Netty中的Boss类充当mainReactor,NioWorker类充当subReactor(默认 NioWorker的个数是Runtime.getRuntime().availableProcessors())。在处理新来的请求 时,NioWorker读完已收到的数据到ChannelBuffer中,之后触发ChannelPipeline中的ChannelHandler流。

Netty是事件驱动的,可以通过ChannelHandler链来控制执行流向。因为ChannelHandler链的执行过程是在 subReactor中同步的,所以如果业务处理handler耗时长,将严重影响可支持的并发数。

这种模型适合于像Memcache这样的应用场景,但 对需要操作数据库或者和其他模块阻塞交互的系统就不是很合适。Netty的可扩展性非常好,而像ChannelHandler线程池化的需要,可以通过在 ChannelPipeline中添加Netty内置的ChannelHandler实现类–ExecutionHandler实现,对使用者来说只是 添加一行代码而已。对于ExecutionHandler需要的线程池模型,Netty提供了两种可 选:

- 1) MemoryAwareThreadPoolExecutor

可控制Executor中待处理任务的上限(超过上限时,后续进来的任务将被阻 塞),并可控制单个Channel待处理任务的上限; - 2) OrderedMemoryAwareThreadPoolExecutor 是 MemoryAwareThreadPoolExecutor 的子类,它还可以保证同一Channel中处理的事件流的顺序性,这主要是控制事件在异步处 理模式下可能出现的错误的事件顺序,但它并不保证同一Channel中的事件都在一个线程中执行(通常也没必要)。一般来 说,OrderedMemoryAwareThreadPoolExecutor 是个很不错的选择,当然,如果有需要,也可以DIY一个。