【TensorFlow学习笔记】TensorFlow模型的保存与恢复

tf.train.Saver 类提供了保存和恢复模型(变量、图、图的元数据)的方法

1、保存模型

tf.train.Saver.save 方法以将变量保存到checkpoint文件中

# 创建 Saver 来管理模型中的所有变量

saver = tf.train.Saver()

with tf.Session() as sess:

······

# Save the variables to disk.

save_path = saver.save(sess, "/tmp/mnist.ckpt")

saver.export_meta_graph:在文件mnist.ckpt.meta中存储了元图的数据,但该文件是二进制的,无法直接查看,TensorFlow将其以json格式导出。

saver.export_meta_graph("/tmp/mnist.ckpt.meta.json",as_text=True)#导出元图并以json格式输出

2、恢复模型

tf.train.Saver.restore 方法以从checkpoint文件中恢复变量

saver = tf.train.Saver()

with tf.Session() as sess:

······

# Restore variables from disk.

save_path = saver.restore(sess, "/tmp/mnist.ckpt")

tf.train.import_meta_graph方法从.meta文件中加载持久化的图,不需要重新定义网络结构,与tf.get_default_graph().get_tensor_by_name()结合使用

saver = tf.train.import_meta_graph("/tmp/mnist.ckpt.meta")

with tf.Session() as sess:

saver.restore(sess, "/tmp/mnist.ckpt")

print sess.run(tf.get_default_graph().get_tensor_by_name("add:0"))

若已经训练了一个五层的神经网络,现在想要训练一个六层的新模型,并重用该五层的现有权重。可以使用 Saver 只恢复这前五层的权重:项目实战 | 解决fine-tune时修改网络结构导致加载模型错误的问题

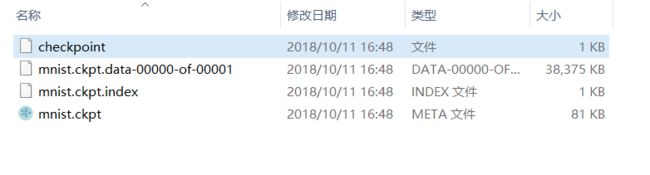

3、checkpoint:

以上代码将Tensorflow模型保存至ckpt文件中,但并没有名为 mnist.ckpt 的实体文件,它是为checkpoint创建的文件名的前缀。总共创建了4个文件:

checkpoint,保存了一个目录下所有模型文件列表

mnist.ckpt.meta,保存了计算图的结构;

mnist.ckpt,保存了每个变量的取值;

4、查看checkpoint中的某个变量:

方法一: 使用inspect_checkpoint 库快速检查某个检查点中的变量。

# import the inspect_checkpoint library

from tensorflow.python.tools import inspect_checkpoint as chkp

# print all tensors in checkpoint file

chkp.print_tensors_in_checkpoint_file("/tmp/mnist.ckpt", tensor_name='', all_tensors=True)

# print only tensor v1 in checkpoint file

chkp.print_tensors_in_checkpoint_file("/tmp/model.ckpt", tensor_name='v1', all_tensors=False)

方法二: 使用tf.train.NewCheckpointReader

import tensorflow as tf

reader = tf.train.NewCheckpointReader("/tmp/model.ckpt")

# print all tensors in checkpoint file

all_variables = reader.get_variable_to_shape_map()

# print only tensor v1 in checkpoint file

w1 = reader.get_tensor("v1")

5、取模型的中间变量

get_tensor_by_name()

6、使用GraphDef保存模型(.pb)

保存模型

import tensorflow as tf

v1 = tf.Variable(tf.constant(1.0, shape=[1]), name="v1")

v2 = tf.Variable(tf.constant(2.0, shape=[1]), name="v2")

result = tf.add(v1, v2, name="add")

with tf.Session() as sess:

sess.run(tf.global_variables_initializer())

# 保存模型

# 导出当前图的GraphDef部分即可完成从输入层到输出层的计算过程

graph_def = tf.get_default_graph().as_graph_def()

output_graph_def = tf.graph_util.convert_variables_to_constants(sess, graph_def, ['add'])

# 输出output_graph_def,可看到这是一个标准的图结构的数据(也就是静态图),不仅包含了节点,还包含了节点中的数据。

print(output_graph_def)

# 保存为pb文件

with tf.gfile.GFile("test/combined_model.pb", "wb") as f:

f.write(output_graph_def.SerializeToString())

加载模型

# 加载模型

with tf.gfile.FastGFile("test/combined_model.pb", 'rb') as f:

graph_def = tf.GraphDef()

graph_def.ParseFromString(f.read())

# 将保存的图读取到当前图中,return_elements表示返回的张量的名称,张量名称为节点名称后面加上(:0)

tf.import_graph_def(graph_def, return_elements=["add:0"])

tf.saved_model.simple_save保存适合投入使用的模型

参考:https://www.cnblogs.com/NSGUF/p/7911817.html