大数据技术之_11_HBase学习_01_HBase 简介+HBase 安装+HBase Shell 操作+HBase 数据结构+HBase 原理

大数据技术之_11_HBase学习_01

- 第1章 HBase 简介

- 1.1 什么是 HBase

- 1.2 HBase 特点

- 1.3 HBase 架构

- 1.3 HBase 中的角色

- 1.3.1 HMaster

- 1.3.2 RegionServer

- 1.3.3 其他组件

- 第2章 HBase 安装

- 2.1 Zookeeper 正常部署

- 2.2 Hadoop 正常部署

- 2.3 HBase 的解压

- 2.4 HBase 的配置文件

- 2.5 HBase 远程发送到其他集群

- 2.6 HBase 服务的启动

- 2.7 查看 HBase 页面

- 第3章 HBase Shell 操作

- 3.1 基本操作

- 3.2 表的操作

- 第4章 HBase 数据结构

- 4.1 RowKey(核心)

- 4.2 Column Family

- 4.3 Cell

- 4.4 Time Stamp

- 4.5 命名空间

- 第5章 HBase 原理

- 5.1 读流程

- 5.2 写流程

- 5.3 数据 Flush 过程

- 5.4 数据合并过程

第1章 HBase 简介

1.1 什么是 HBase

HBase 的原型是 Google 的 BigTable 论文,受到了该论文思想的启发,目前作为 Hadoop 的子项目来开发维护,

主要用于支持结构化的数据存储,当然也可以支持存储非结构化数据,因为 Hbase 是 NoSQL 数据库(NoSQL= Not only SQL)。

官方网站:http://hbase.apache.org

– 2006 年 Google 发表 BigTable 白皮书

– 2006 年开始开发 HBase

– 2008 年北京成功开奥运会,程序员默默地将 HBase 弄成了 Hadoop 的子项目

– 2010 年 HBase 成为 Apache 顶级项目

– 现在很多公司二次开发出了很多发行版本,你也开始使用了。

HBase 是一个高可靠性、高性能、面向列、可伸缩的分布式存储系统,利用 HBASE 技术可在廉价 PC Server 上搭建起大规模结构化存储集群。

HBase 的目标是存储并处理大型的数据,更具体来说是仅需使用普通的硬件配置,就能够处理由成千上万的行和列所组成的大型数据。

HBase 是 Google Bigtable 的开源实现,但是也有很多不同之处。比如:Google Bigtable 利用 GFS 作为其文件存储系统,HBase 利用 Hadoop HDFS 作为其文件存储系统;Google 运行 MAPREDUCE 来处理 Bigtable 中的海量数据,HBase 同样利用 Hadoop MapReduce 来处理 HBase 中的海量数据;Google Bigtable 利用 Chubby 作为协同服务,HBase 利用 Zookeeper 作为对应。

HBase 实现了在 HDFS 上随机读写。

1.2 HBase 特点

1)海量存储

Hbase 适合存储 PB 级别的海量数据,在 PB 级别的数据以及采用廉价 PC 存储的情况下,能在几十到百毫秒内返回数据。这与 Hbase 的极易扩展性息息相关。正式因为 Hbase 良好的扩展性,才为海量数据的存储提供了便利。

2)列式存储

这里的列式存储其实说的是列族存储,Hbase 是根据列族来存储数据的。列族下面可以有非常多的列,列族在创建表的时候就必须指定。

3)极易扩展

Hbase 的扩展性主要体现在两个方面,一个是基于上层处理能力(RegionServer)的扩展,一个是基于存储的扩展(HDFS)。

通过横向添加 RegionSever 的机器,进行水平扩展,提升 Hbase 上层的处理能力,提升 Hbsae 服务更多 Region 的能力。

备注:RegionServer 的作用是管理 region、承接业务的访问,这个后面会详细的介绍通过横向添加DataNode的机器,进行存储层扩容,提升 Hbase 的数据存储能力和提升后端存储的读写能力。

4)高并发

由于目前大部分使用 Hbase 的架构,都是采用的廉价 PC,因此单个IO的延迟其实并不小,一般在几十到上百ms之间。这里说的高并发,主要是在并发的情况下,Hbase 的单个IO延迟下降并不多。能获得高并发、低延迟的服务。

5)稀疏

稀疏主要是针对 Hbase 列的灵活性,在列族中,你可以指定任意多的列,在列数据为空的情况下,是不会占用存储空间的。

1.3 HBase 架构

HBase 是基于 HDFS 的一个存储框架。

Hbase架构如下图所示:

从图中可以看出 Hbase 是由 Client、Zookeeper、Master、HRegionServer、HDFS 等几个组件组成,下面来介绍一下几个组件的相关功能:

1)Client

Client 包含了访问 Hbase 的接口,另外 Client 还维护了对应的 cache 来加速 Hbase 的访问,比如 cache 的 .META.元数据的信息。

2)Zookeeper

HBase 通过 Zookeeper 来做 master 的高可用、RegionServer 的监控、元数据的入口以及集群配置的维护等工作。具体工作如下:

通过 Zoopkeeper 来保证集群中只有 1 个 master 在运行,如果 master 异常,会通过竞争机制产生新的 master 提供服务。

通过 Zoopkeeper 来监控 RegionServer 的状态,当 RegionSevrer 有异常的时候,通过回调的形式通知 Master RegionServer 上下线的信息。

通过 Zoopkeeper 存储元数据的统一入口地址。

3)Hmaster

master 节点的主要职责如下:

为 RegionServer 分配 Region。

维护整个集群的负载均衡。

维护集群的元数据信息。

发现失效的 Region,并将失效的 Region 分配到正常的 RegionServer 上。

当 RegionSever 失效的时候,协调对应 Hlog 的拆分。

4)HregionServer

HregionServer 直接对接用户的读写请求,是真正的“干活”的节点。它的功能概括如下:

管理 master 为其分配的 Region。

处理来自客户端的读写请求。

负责和底层 HDFS 的交互,存储数据到 HDFS。

负责 Region 变大以后的拆分。

负责 StoreFile 的合并工作。

5)HDFS

HDFS 为 Hbase 提供最终的底层数据存储服务,同时为 HBase 提供高可用(Hlog 存储在 HDFS)的支持,具体功能概括如下:

提供元数据和表数据的底层分布式存储服务。

数据多副本,保证的高可靠和高可用性。

注意:官方建议一张表建一个列族。因为一个列族很大,有很多个列,够存数据了。如果一张表有多个列族,数据的存储是不平均的,当数据切分的时候会出现数据倾斜,在 HDFS 上还会出现很多小文件,而文件的合并级别是 Store 级别的。

1.3 HBase 中的角色

1.3.1 HMaster

功能:

1.监控 RegionServer

2.处理 RegionServer 故障转移

3.处理元数据的变更

4.处理 Region 的分配或转移

5.在空闲时间进行数据的负载均衡

6.通过 Zookeeper 发布自己的位置给客户端

1.3.2 RegionServer

功能:

1.负责存储 HBase 的实际数据

2.处理分配给它的 Region

3.刷新缓存到 HDFS

4.维护 Hlog

5.执行压缩

6.负责处理 Region 分片

1.3.3 其他组件

1.Write-Ahead logs

HBase 的修改记录,当对 HBase 读写数据的时候,数据不是直接写进磁盘,它会在内存中保留一段时间(时间以及数据量阈值可以设定)。但把数据保存在内存中可能有更高的概率引起数据丢失,为了解决这个问题,数据会先写在一个叫做 Write-Ahead logfile 的文件中,然后再写入内存中。所以在系统出现故障的时候,数据可以通过这个日志文件重建。

2.Region

Hbase 表的分片,HBase 表会根据 RowKey 值被切分成不同的 Region 存储在 RegionServer 中,在一个 RegionServer 中可以有多个不同的 Region。

3.Store

HFile 存储在 Store 中,一个 Store 对应 HBase 表中的一个列族,一个列族可以切分成多个 Store。

4.Mem Store

顾名思义,就是内存存储,位于内存中,用来保存当前的数据操作,所以当数据保存在 WAL 中之后,RegsionServer 会在内存中存储键值对。

5.HFile

这是在磁盘上保存原始数据的实际的物理文件,是实际的存储文件。StoreFile 是以 Hfile 的存储形式存储在 HDFS 的。

第2章 HBase 安装

2.1 Zookeeper 正常部署

首先保证 Zookeeper 集群的正常部署,并启动之:

[atguigu@hadoop102 zookeeper-3.4.10]$ bin/zkServer.sh start

[atguigu@hadoop103 zookeeper-3.4.10]$ bin/zkServer.sh start

[atguigu@hadoop104 zookeeper-3.4.10]$ bin/zkServer.sh start

2.2 Hadoop 正常部署

Hadoop集群的正常部署并启动:

[atguigu@hadoop102 hadoop-2.7.2]$ sbin/start-dfs.sh

[atguigu@hadoop103 hadoop-2.7.2]$ sbin/start-yarn.sh

2.3 HBase 的解压

解压HBase到指定目录:

[atguigu@hadoop102 software]$ tar -zxvf hbase-1.3.1-bin.tar.gz -C /opt/module

修改解压后的hbase-1.3.1文件夹名称为hbase

[atguigu@hadoop102 module]$ mv hbase-1.3.1/ hbase

2.4 HBase 的配置文件

修改 HBase 对应的配置文件。

1)hbase-env.sh 修改内容:

[atguigu@hadoop102 conf]$ pwd

/opt/module/hbase/conf

[atguigu@hadoop102 conf]$ vim hbase-env.sh

修改JAVA_HOME

export JAVA_HOME=/opt/module/jdk1.8.0_144

注释掉以下部分:

# Configure PermSize. Only needed in JDK7. You can safely remove it for JDK8+

# export HBASE_MASTER_OPTS="$HBASE_MASTER_OPTS -XX:PermSize=128m -XX:MaxPermSize=128m"

# export HBASE_REGIONSERVER_OPTS="$HBASE_REGIONSERVER_OPTS -XX:PermSize=128m -XX:MaxPermSize=128m"

是否启动HBase自己的Zookeeper,默认是true,改为false

export HBASE_MANAGES_ZK=false

2)hbase-site.xml 修改内容:

<configuration>

<property>

<name>hbase.rootdirname>

<value>hdfs://hadoop102:9000/hbasevalue>

property>

<property>

<name>hbase.cluster.distributedname>

<value>truevalue>

property>

<property>

<name>hbase.master.portname>

<value>16000value>

property>

<property>

<name>hbase.zookeeper.quorumname>

<value>hadoop102:2181,hadoop103:2181,hadoop104:2181value>

property>

<property>

<name>hbase.zookeeper.property.dataDirname>

<value>/opt/module/zookeeper-3.4.10/zkDatavalue>

property>

configuration>

3)regionservers:

[atguigu@hadoop102 conf]$ vim regionservers

hadoop102

hadoop103

hadoop104

4)软连接 hadoop 配置文件到 hbase:(因为 hbase集群 是依赖于 hadoop集群 的)

[atguigu@hadoop102 module]$ ln -s /opt/module/hadoop-2.7.2/etc/hadoop/core-site.xml /opt/module/hbase/conf/core-site.xml

[atguigu@hadoop102 module]$ ln -s /opt/module/hadoop-2.7.2/etc/hadoop/hdfs-site.xml /opt/module/hbase/conf/hdfs-site.xml

2.5 HBase 远程发送到其他集群

[atguigu@hadoop102 module]$ xsync hbase/

2.6 HBase 服务的启动

1.启动方式1(单个启动)

以hadoop102为HMaster

[atguigu@hadoop102 hbase]$ bin/hbase-daemon.sh start master

[atguigu@hadoop102 hbase]$ bin/hbase-daemon.sh start regionserver

[atguigu@hadoop103 hbase]$ bin/hbase-daemon.sh start regionserver

[atguigu@hadoop104 hbase]$ bin/hbase-daemon.sh start regionserver

提示:如果集群之间的节点时间不同步,会导致 regionserver 无法启动,抛出 ClockOutOfSyncException异常(时钟同步异常) 。

修复提示:

a、同步时间服务

请参看帮助文档:https://www.cnblogs.com/chenmingjun/p/10545638.html

b、属性:hbase.master.maxclockskew 设置更大的值

<property>

<name>hbase.master.maxclockskewname>

<value>180000value>

<description>Time difference of regionserver from masterdescription>

property>

2.启动方式2(群起)

[atguigu@hadoop102 hbase]$ bin/start-hbase.sh

对应的停止服务:

[atguigu@hadoop102 hbase]$ bin/stop-hbase.sh

2.7 查看 HBase 页面

启动成功后,可以通过“host:port”的方式来访问 HBase 管理页面,例如:

http://hadoop102:16010

注意:HMaster的服务端口是16000,HMaster的web端口是16010。

第3章 HBase Shell 操作

3.1 基本操作

1.进入 HBase 客户端命令行

[atguigu@hadoop102 hbase]$ bin/hbase shell

2.查看帮助命令

hbase(main):001:0> help

3.查看当前数据库中有哪些表

hbase(main):002:0> list

3.2 表的操作

1.创建表

hbase(main):002:0> create 'student','info'

注意:删除字符的按键BackSpace的删除顺序是反过来的,即从左往右删。

2.插入数据到表

hbase(main):003:0> put 'student','1001','info:sex','male'

hbase(main):004:0> put 'student','1001','info:age','18'

hbase(main):005:0> put 'student','1002','info:name','Janna'

hbase(main):006:0> put 'student','1002','info:sex','female'

hbase(main):007:0> put 'student','1002','info:age','20'

3.扫描查看表数据

hbase(main):008:0> scan 'student'

hbase(main):009:0> scan 'student',{STARTROW => '1001', STOPROW => '1001'} 前闭后开

hbase(main):010:0> scan 'student',{STARTROW => '1001'}

4.查看表结构

hbase(main):011:0> describe 'student'

5.更新指定字段的数据

hbase(main):012:0> put 'student','1001','info:name','Nick'

hbase(main):013:0> put 'student','1001','info:age','100'

6.查看【指定行】或【指定列族:列】的数据

hbase(main):014:0> get 'student','1001'

hbase(main):015:0> get 'student','1002','info:name'

7.统计表数据行数

hbase(main):021:0> count 'student'

8.删除数据

删除某 rowkey 的全部数据:

hbase(main):016:0> deleteall 'student','1001'

注意:删除操作默认的时间戳是当前时间。在 HBase 中,增删改数据都是打时间戳!!!

删除某rowkey的某一列数据:

hbase(main):017:0> delete 'student','1002','info:sex'

注意:shell删除操作会将数据的所有版本都删除掉。但是在 HBase 的 API 操作中可以细粒度的控制删除哪一个版本。

9.清空表数据

hbase(main):018:0> truncate 'student'

提示:清空表的操作顺序为先 disable,然后再 truncate。

10.删除表

首先需要先让该表为 disable 状态:

hbase(main):019:0> disable 'student'

然后才能 drop 这个表:

hbase(main):020:0> drop 'student'

提示:如果直接 drop 表,会报错:ERROR: Table student is enabled. Disable it first.

11.变更表信息

设置将info列族中的数据存放3个版本:

hbase(main):022:0> alter 'student',{NAME => 'info', VERSIONS => 3}

hbase(main):022:0> get 'student','1001',{COLUMN => 'info:name', VERSIONS => 3}

第4章 HBase 数据结构

4.1 RowKey(核心)

与 nosql 数据库们一样,RowKey 是用来检索记录的主键。访问 HBASE table 中的行,只有三种方式:

1. 通过单个 RowKey 访问

2. 通过 RowKey 的 range(正则)

3. 全表扫描

RowKey 行键 (RowKey)可以是任意字符串(最大长度是64KB,实际应用中长度一般为 10-100bytes),在 HBASE 内部,RowKey 保存为字节数组。存储时,数据按照 RowKey 的字典序(byte order)排序存储。设计 RowKey 时,要充分利用排序存储这个特性,将经常一起读取的行存储放到一起。(位置相关性)面试相关。

4.2 Column Family

列族:HBASE 表中的每个列,都归属于某个列族。列族是表的 schema 的一部分(而列不是),必须在使用表之前定义。列名都以列族作为前缀。例如 courses:history,courses:math 都属于 courses 这个列族。

4.3 Cell

由 {rowkey, column Family:columu, version} 唯一确定的单元。cell中的数据是没有类型的,全部是字节码形式存贮。

关键字:无类型、字节码

4.4 Time Stamp

HBASE 中通过 rowkey 和 columns 确定的为一个存贮单元称为 cell。每个 cell 都保存 着同一份数据的多个版本。版本通过时间戳来索引。时间戳的类型是 64 位整型。时间戳可以由 HBASE(在数据写入时自动 )赋值,此时时间戳是精确到毫秒的当前系统时间。时间戳也可以由客户显式赋值。如果应用程序要避免数据版本冲突,就必须自己生成具有唯一性的时间戳。每个 cell 中,不同版本的数据按照时间倒序排序,即最新的数据排在最前面。

为了避免数据存在过多版本造成的的管理 (包括存贮和索引)负担,HBASE 提供了两种数据版本回收方式:一是保存数据的最后n个版本,二是保存最近一段时间内的版本(比如最近七天)。用户可以针对每个列族进行设置。

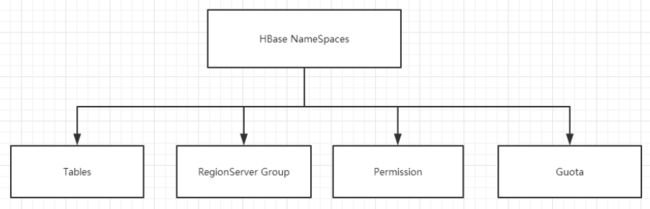

4.5 命名空间

Hbase 的命名空间就相当于 MySQL 中的 Database。

Hbase 的命名空间的主要作用是:使用命名空间来管理(区分)不同业务线上的表的问题。

命名空间的结构:

1) Tables:表,所有的表都是命名空间的成员,即表必属于某个命名空间,如果没有指定,则在 default 默认的命名空间中。

2) RegionServer Group:一个命名空间包含了默认的 RegionServer Group。

3) Permission:权限,命名空间能够让我们来定义访问控制列表ACL(Access Control List)。例如,创建表,读取表,删除,更新等等操作。

4) Quota:限额,可以强制一个命名空间可包含的 Region 的数量。

案列实操:

查看命名空间列表

hbase(main):007:0> list_namespace

创建新的命名空间

hbase(main):008:0> create_namespace 'bigdata'

在新的命名空间中创建表

hbase(main):009:0> create 'bigdata:student','info'

删除新的命名空间

hbase(main):008:0> drop_namespace 'bigdata'

注意:删除命名空间之前,该命名空间中要不存在任何表。否则,不能删除!

第5章 HBase 原理

5.1 读流程

- 1)Client 先访问 zookeeper,从 meta 表读取 region 的位置,然后读取 meta 表中的数据。meta 中又存储了用户表的 region 信息;

- 2)根据 namespace、表名和 rowkey 在 meta 表中找到对应的 region 信息;

- 3)找到这个 region 对应的 regionserver;

- 4)查找对应的 region;

- 5)先从 MemStore 找数据,如果没有,再到 BlockCache 里面读;

- 6)BlockCache 还没有,再到 StoreFile 上读(为了读取的效率);

7)如果是从 StoreFile 里面读取的数据,不是直接返回给客户端,而是先写入 BlockCache,再返回给客户端。注意:新版本的 HBase 中没有 ROOT 表。

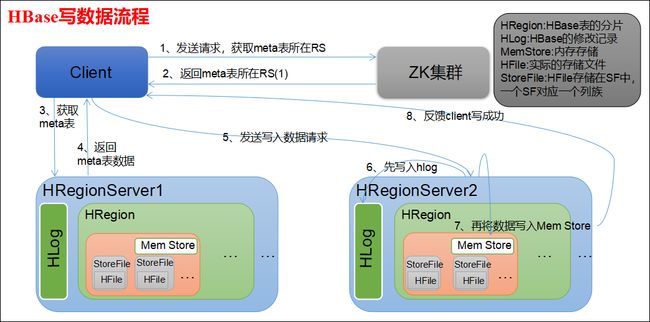

5.2 写流程

- 1)Client 向 HregionServer 发送写请求;

- 2)HregionServer 将数据写到 HLog(write ahead log)。为了数据的持久化和恢复;

- 3)HregionServer 将数据写到内存(MemStore);

- 4)反馈 Client 写成功。

5.3 数据 Flush 过程

- 1)当 MemStore 数据达到阈值(默认是128M,老版本是64M),将数据刷写到硬盘,将内存中的数据删除,同时删除 HLog 中的历史数据;

- 2)并将数据存储到 HDFS 中;

- 3)在 HLog 中做标记点。

注意:HBase 数据 Flush 触发时机:- (1) 当 MemStore 数据达到阈值(默认是128M,老版本是64M)。即单个 Region 里 Memstore 的缓存大小,超过那么整个 HRegion 就会 flush,默认 128M。

- (2) RegionServer 的全局 Memstore 的大小,超过该大小会触发 flush 到磁盘的操作,默认是堆大小的 40%,而且 Regionserver 级别的 flush 会阻塞客户端读写。

- (3) 内存中的文件在自动刷新之前能够存活的最长时间,默认是1h。

- (4) HLog 日志文件的大小达到 1G 时也会触发 flush 到磁盘的操作。

5.4 数据合并过程

- 1)当数据块达到 4 块,Hmaster 触发合并操作,Region 将数据块加载到本地,进行合并;

- 2)当合并的数据超过 256M,进行拆分,将拆分后的 Region 分配给不同的 HregionServer 管理;

- 3)当 HregionServer 宕机后,将 HregionServer 上的 hlog 拆分,然后分配给不同的 HregionServer 加载,修改 .META.;

注意1:HLog 会同步到 HDFS。

注意2:数据合并的时候会删除掉已经标记删除的数据。

我的GitHub地址:https://github.com/heizemingjun

我的博客园地址:https://www.cnblogs.com/chenmingjun

我的蚂蚁笔记博客地址:https://blog.leanote.com/chenmingjun

Copyright ©2018~2019 黑泽君

【转载文章务必保留出处和署名,谢谢!】