对抗样本(论文解读三): Adversarial Examples Improve Image Recognition

准备写一个论文学习专栏,先以对抗样本相关为主,后期可能会涉及到目标检测相关领域。

内容不是纯翻译,包括自己的一些注解和总结,论文的结构、组织及相关描述,以及一些英语句子和相关工作的摘抄(可以用于相关领域论文的写作及扩展)。

平时只是阅读论文,有很多知识意识不到,当你真正去着手写的时候,发现写完之后可能只有自己明白做了个啥。包括从组织、结构、描述上等等很多方面都具有很多问题。另一个是对于专业术语、修饰、语言等相关的使用,也有很多需要注意和借鉴的地方。

本专栏希望在学习总结论文核心方法、思想的同时,期望也可以学习和掌握到更多论文本身上的内容,不论是为自己还有大家,尽可能提供更多可以学习的东西。

当然,对于只是关心论文核心思想、方法的,可以只关注摘要、方法及加粗部分内容,或者留言共同学习。

Adversarial Examples Improve Image Recognition

Cihang Xie1,2∗ Mingxing Tan1 Boqing Gong1 Jiang Wang1 Alan Yuille2 Quoc V. Le1 1Google 2Johns Hopkins University

谷歌大脑的创始成员和 AutoML 的缔造者之一Quoc Le再推新研究论文 ,发表于2019/11/21

(昨天11/29刚看到的,今天迫不及待地学习一下)

对抗样本提高图像识别

1 Abstract

Adversarial examples are commonly viewed as a threat to ConvNets. Here we present an opposite perspective: adversarial examples can be used to improve image recognition models if harnessed in the right manner. We propose AdvProp, 引;

将对抗样本加入训练集再次训练,来防止模型过拟合。我们方法的关键是使用独立的辅助批处理规范来处理对抗性示例,因为它们与普通示例具有不同的底层分布。

对于最新的模型EfficientNet-B7其分类结果,在 ImageNet (+0.7%), ImageNet-C (+6.5%), ImageNet-A (+7.0%), StylizedImageNet (+4.8%).

在强化模型EfficientNet-B8下,无额外数据数据的情况下在ImageNet上实现top-1为85.5%。

(3.5B Instagram images (∼3000× more than ImageNet) and ∼9.4× more parameters. )

Models are available at

https://github.com/tensorflow/tpu/tree/ master/models/official/efficientnet.

(这里有很多以前未知的模型和数据集,需要了解一下)

2 Introduction

The existence of adversarial examples not only reveals the limited generalization ability of ConvNets, but also poses security threats on the real-world deployment of these models. 引

Recent works[15,13,31] also suggest that training with adversarial examples on large datasets, e.g., ImageNet[23],with supervised learning results in performance degradation on clean images. 对比

We observe all previous methods jointly train over clean images and adversarial examples without distinction even though they should be drawn from different underlying distributions.

In this paper, we propose AdvProp, short for Adversarial Propagation,

一个新的训练模式,通过简单且高效的两个批处理规范来建立不匹配分布的桥梁。两个批规范统计分布对应干净图像和对抗图像。这两个批处理规范在归一化层上适当地将两个分布分开,以便进行准确的统计估计。

3 Related Work

Adversarial Training. Adversarial training, which trains networks with adversarial examples, constitutes the current foundation of state-of-the-arts for defending against adversarial attacks [5, 15, 19, 31].

This paper focuses on standard supervised learning without extra data. Although using similar adversarial training techniques,we stand on an opposite perspective to previous works—we aim at using adversarial examples to improve clean image recognition accuracy.

在这里作者对于每一部分相关工作,都介绍了与自己工作的异同。

Benefits of Learning Adversarial Features. Adversarial examples make network representations align better with salient data characteristics and human perception[30]. Moreover, such trained models are much more robust to high frequency noise [32].

Zhang et al. [35] further suggest these adversarially learned feature representations are less sensitive to texture distortions and focus more on shape information.

Our proposed AdvProp can be characterized as a training paradigm which fully exploits the complementarity between clean images and their corresponding adversarial examples.

Data augmentation. ehorizontal flipping and random cropping, applying masking out [3] or adding Gaussian noise [18] to regions in images, or mixing up pairs of images and their labels in a convex manner [33].

Our work can be regarded as one type of data augmentation: creating additional training samples by injecting noise.

4 A Preliminary Way to Boost Performance

如果干净图像与对抗图像之间的分布不匹配可以适当地桥接,那么干净图像上的性能下降应该被被缓和当对抗图像用于训练。为了验证我们的假设,我们先检查一套简单的策略——先用对抗图像进行网络预训练,然后再用清晰的图像进行微调。

如上图所示,蓝、灰、橙分别表示:在干净图像上训练、在对抗图像上训练及先在对抗图像上训练再在干净图像上微调,三种情况下获得的模型的分类结果。

上面的结果提供了一个很有启发的信号——如果利用得当,对抗性的例子可以有利于模型的性能。尽管如此,我们注意到这种方法通常不能提高性能。 继续引

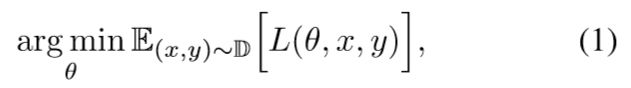

5 Methodology

我们的方法处理了分布不匹配的问题,通过在标准化层上显式解耦批量统计数据,从而实现对对抗和干净特征的有效吸收。

5.1 Adversarial Training

vanilla training :训练干净图像

Madry’s adversarial training :单独训练对抗图像

We train networks with a mixture of adversarial examples and clean image:混合训练

我们假设,对抗的例子和干净的图像之间的分布不匹配,阻止了网络从两个领域准确、有效地提取有价值的特征。接下来,我们将介绍如何通过我们的辅助批处理规范设计来适当地分离不同的分布。

5.2.Disentangled Learning via An Auxiliary BN

BN在每个小批次中计算均值和方差来规范输入特性。其固有假设是输入特征来自同一或相似分布。

我们认为对抗图像与干净图像含有不同的底层分布。为了将这种混合分布分解为两个简单的分布,分别对应干净的和对抗性的图像,我们在此提出一个辅助BN,以保证它的归一化统计只在对抗性的例子上执行。

我们可以将辅组BN概念化,输入数据包含n个分布,则可以附加n-1个辅组BN。

如上图所示,分别表示传统的BN与本文提出的辅组BN的网络结构。

5.2 AdvProp

我们利用如下方法来训练网络,输入干净图像,通过原BNs计算干净图像损失,通过辅组BNs生成相应对抗图像,并计算其损失,最后进行联合训练。

6.Experiments

6.1 Experiments Setup

Architectures. ranging from the light-weight EfficientNet-B0 to the large EfficientNet-B7. We follow the settings in [28] to train these networks: RMSProp optimizer with decay 0.9 and momentum 0.9; batch norm momentum 0.99; weight decay 1e-5; initial learning rate 0.256 that decays by 0.97 every 2.4 epochs; a fixed AutoAugment policy[1] is applied to augment training images.

(这里可以说是介绍的非常细致)

Adversarial Attackers. We choose Projected Gradient Descent (PGD) [19] under L∞ norm as the default attacker for generating adversarial examples on-the-fly.(动态)

Datasets. In addition to reporting performance on the original ImageNet validation set, we go beyond by testing the models on the following test sets:

ImageNet-C. image corruptions.

ImageNet-A . challenging scenarios (e.g., occlusion and fog scene).

Stylized-ImageNet . removing local texture cues while retaining global shape information.

(这一部分,介绍的都很细致)

5.2.ImageNet Results and Beyond

如上图所示,与baseline相比,使用AdvProp训练的网络,网络越大其性能提升越高。

Generalization on Distorted ImageNet Datasets.

如上结果表明,AdvProp通过允许模型学习比vanilla training更丰富的内部表征,显著提高了模型的泛化能力。更丰富的内部表征不仅为样式化的Stylized-ImageNet 数据集更好地分类提供了全局形状信息,同时增强了模型对常见图像破坏的鲁棒性。

Ablation on Adversarial Attacker Strength.

攻击强度对网络性能的影响。

5.3.Comparisons to Adversarial Training

AdvProp与传统的对抗训练相比较,在干净图像上的分类结果,越小的模型提升效果越大。这一结果表明,谨慎地处理BN统计估计对于用对抗性例子训练更好的模型是很重要的。

本篇论文的视觉还是非常独特的,当人们都聚焦于对抗样本的攻防时,其将其扩展到模型对干净图像的分类性能提升上,对于相关领域的研究还是有一个非常大的扩展的。

之前大佬研究猜测,将对抗样本比喻成实数中的无理数,而已知的干净样本仅仅相当于有理数的存在,也许对抗样本的存在,对于相关领域问题的影响,远不是我们目前所理解的这样。这是一个充满挑战与希望的地方,期待会有更多的研究和发现。