你的性取向,其实全写在脸上了

![]()

硅谷Live / 实地探访 / 热点探秘 / 深度探讨

我们已经听过很多遍类似的说法,即“人工智能代表未来科技的方向”。也许有人不太理解:为什么非得是人工智能,而不是别的技术呢?

这是因为人工智能(Artificial Intelligence,缩写为 AI)有着其它高科技无法比拟的优势,就是对“类型的识别”和“不断从过去的错误中学习提高的能力”。

唐太宗李世民曾言:以史为鉴,可以知兴替。小探看到一个对这句话的翻译,是“Who knows the history, who knows the future”,这句话同样可以用来描述人工智能。AI 不断从已有的数据总结经验,就能对未知的事情做出有把握的判断。要是放在古代,可不就是神仙吗?

事实上,现在的人工智能,真的越来越全能了。它已经用于写诗、创作歌曲、画画和诊断疾病。

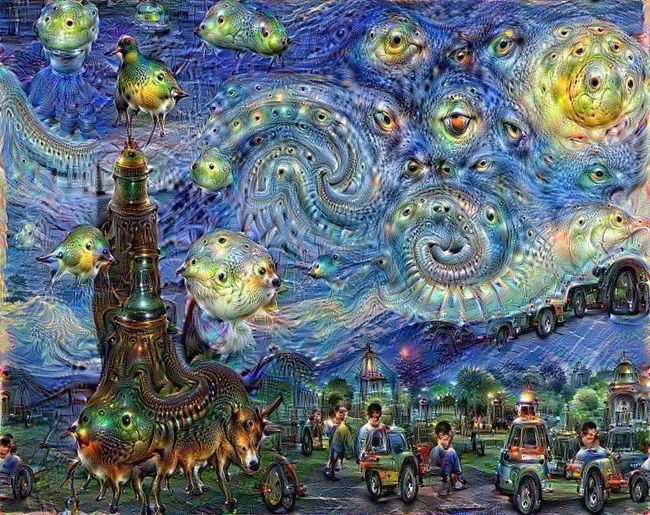

谷歌人工智能绘画,图片来自网络,版权属于原作者

最近,斯坦福大学两位研究人员Yilun Wang 和 Michal Kosinski,创造出一套人工智能系统,可以仅仅通过观察一个人的照片,就判断出此人的性倾向。

也就是说,你是直男还是同性恋,你喜欢女性还是男性,只要让这个 AI 系统看一看照片就得出结论,而且准确率贼高!

这个研究结果已经写成文章,名为《深度神经网络能比人类更准确地通过面部图片检测性取向》(Deep neural networks are more accurate than humans at detecting sexual orientation from facial images),并发明在《人格与社会心理学杂志》期刊上。

下面咱们来看看,人工智能是怎么做到这一点的。

首先,研究团队从美国约会网站的公开信息资料中提取出 35326 个面部图片样本,并将图片输入一个叫做 VGG-Face 的软件中,该软件会为每一个人脸图分配一个编号。研究人员使用了每个人的一到五张照片,用户则自己报告自己的性倾向和性行为。

然后,神经网络对这些图片进行学习和提取特征,然后把这些特征输入到一个旨在对性取向进行分类的逻辑回归中。

逻辑回归(Logistic Regression)是一种模型,和用于解决二分类(0 or 1)问题的机器学习方法,用于估计某种事物的可能性。在该模型对足够多的数据进行“学习”后,就可以将结果应用于对新样本的计算和判断之中。

该研究得到一个整体性的结果,就是“面部其实包含了更多超出人类大脑能够感知和翻译的信息”,但是人工智能有“能力”识别并总结出这些信息。

比如这个 AI 系统发现:同性恋男性和女性往往具有“性别非典型”特征和表情。举例说明,男同性恋者通常颌骨较窄,鼻子较长,前额较大,即看起来更偏清秀的“瓜子脸”;与直女相比,女同性恋者的下颚较大,前额较小,看起来更“俊朗”。

如图所示:左边是综合样本做出的异性恋者脸部图,右边则是同性恋者脸部图,能明显看出双方的差异,右图中的男女外形更为“中性”,基于性别的典型特征没有左边明显。

图片来自论文截图

此外,虽然女性一般会笑得更多,但女同性恋者的笑容比异性恋者少。而在修饰打扮方面,女同性恋者往往使用较少的眼妆,头发颜色更深,并且穿着暴露皮肤更少、衣领更高的衣服,较少女性化的修饰风格。

论文中总结道:“这项研究观察到的女性气质差异是很微妙的,散布在许多面部特征上,只有在检查许多面部图像的平均值时才会明显”。

此处来一张天海佑希的照片加以说明,怎样算是“更偏中性”。女神虽然不是同性恋,但却是“日本女生最想嫁的女人”。

图片来自网络,版权属于原作者

当然还有我们的国民女神林青霞:

图片来自网络,版权属于原作者

接下来大家一定会好奇:这个 AI 系统经过训练后,看到新的人物照片就能给出他的性倾向判断,那么它的准确率高不高?

答案是非常高,尤其是和人类相比较。

如果只给出某个人的一张照片,系统对男女性倾向的判断准确率分别为 81% 和 71%,与此对照,人类判断的准确率只有 61% 和 54%。如果能获得五张照片,那么准确率会进一步提高到 91% 和 83%。

小探时常在微博上看到有人宣称自己能一眼识别同性恋,也时不时看到网友点评某个男明星:“感觉他很有同性恋的气质哎”,或者猜测某两个男明星“他俩应该是真爱吧”......现在可好,不必再捕风捉影,只要把照片给这个人工智能系统,你就能获得更接近真相的判断结果。

不过,除了拿来娱乐,这个系统还有什么用处呢?

研究人员 Michal Kosinski 说,我们的研究结果为极富争议的“产前激素理论”提供了强有力的支持。该理论认为:人体的某些激素会在胎儿性别分化中发挥作用,并且后期也会影响成人的性取向,甚至是决定性因素。具体来说,同性恋倾向的形成,是因为男性胎儿对产前雄激素的暴露不足,或女性胎儿对该激素的暴露过多。

图片来自网络,版权属于原作者

同性恋的起源原因一直没有定论,而这项研究,为“同性恋有生理基础”这一判断提供了证据。

另外,这项技术现在是用来判断性倾向,但未来可以推广应用到检测情绪、智商、甚至是犯下某些罪行的倾向上。

但是,无论是现阶段的研究结果,还是未来的延伸方向,这项研究都引发了极大的道德争议。Kosinski 提到:“我们对这些结果感到非常不安,并花了很多时间考虑是否应该将它们公之于众”。

他们最终公开了论文,随后果然引发了轩然大波。

一部分人斥责此研究为“伪科学”,因为此研究的对象仅限于美国境内的白种人,并且不能判断双性恋者。

Kosinski 在一篇笔记中反驳道:虽然本研究并不能证明该结论同样适用于其他种族,但我们发现该结论有适用的可能性。相同的生物学、进化和文化因素促进了同性恋者和异性恋者之间差异的形成,这些因素也很可能会影响其他种族。而识别不了双性恋者,不会使得已有的结论失效。

但是更多的讨论集中在:此项研究是否侵犯了他人的性取向隐私。

有人认为,如果你打算和一个人成为朋友或者建立更亲密关系,那么知晓对方的性取向是必要的。此前天涯论坛上有过关于“同妻”的热帖,讲述女性嫁给男同性恋后痛苦的婚姻生活。而《华盛顿邮报》上一名作者也写文章说:“我曾经和一个男性第三次见面后,才知道他是打算跟我约会恋爱的”,并对自己没能及时察觉这种浪漫走向而感到很尴尬。

更多人认为:一个人的性取向应该是他或她的隐私,任何人不能随意知晓;在有些地方,如果性取向被公开,可能会带来严重的后果。

有人给该项研究人员发来了愤怒的邮件:“你肯定知道在一些国家,同性恋是犯罪行为。所以我认为你是一个支持谋杀同性恋者的恐同混蛋。如果不是,请你销毁所有跟这个话题有关的工作,否则,我希望能来个人杀了你,因为你的工作将使很多人受到折磨,甚至死亡。”

来自国际 LGBTI 联合会的图像,显示了世界上同性恋不合法的国家和地区

Kosinski 对这些警告和威胁进行了回复,表明他们并没有创建一个侵犯隐私的工具。此项研究工作其实内容有限,只研究了自称是同性恋或者异性恋的人群;但他同时承认:令人不安的是,我们发现这些技术确实存在这样的(侵犯隐私)风险。

如果这个人工智能系统流传开来,你的照片可能就会被未经允许拿去做测试。毕竟这个时代,想“人肉”出一个社交网络用户都能办到,获取几张照片并非难事。想一想:假如你到了结婚的年龄还没有对象,然后有人拿你的照片去做测试,恰好得出你可能有同性性取向,那么你就可能被流言蜚语缠上。

而小探还想延伸讨论一点:我们说到,该研究方法其实能推广到检测情绪智商乃至犯罪倾向上,假如一个人在这些方面的信息,都能被人工智能看照片加以判断,这不是妥妥的“刻板印象”吗?

人工智能经过大量数据分析得到一些普适性结论,然后将结论应用于新的个体上,这种做法人类社会也很常见,但却是不被倡导的。

普林斯顿大学信息技术和政策中心的一项研究发现:机器学习和 AI 算法,会不经意强化和扩大了社会上流传的,或者用户潜意识中的既定偏见。以上文的性倾向研究为例,如果被广泛使用,那么人们就更容易把气质柔和的男性或者外形俊朗的女性,和同性恋联系起来。

2013年,哈佛大学的一项研究也发现:非裔美国人的名字更容易和通缉令形成配对。如果这些数据进入人工智能系统,那么判断新样本时,一个非裔美国人的名字,显然会更容易得到“犯罪倾向高”的预测结果。这已经涉嫌种族歧视。

但是人工智能本身无罪,它就像一面镜子,折射出人类社会真实的一面,这个真实一面在美国经过几十年的洗礼,已经被藏起来了,大家只是嘴上不说而已,却被数据再次揭露出来。如果我们不主动纠正“刻板印象”,那么作为工具的人工智能就会加固这些印象。归根结底,主观能动性在人类手中,人工智能的进步,就如核武器一般,确实有可能被使用者拿来做坏事。

所以,人工智能可以准确判断你的性取向,你觉得,这是不是一件危险的事儿?

推荐阅读

![]()

区块链报告 | 脑机接口报告

硅谷人工智能 | 斯坦福校长

卫哲 | 姚劲波 | 胡海泉

垂直种植 | 无人车

王者荣耀 | 返老还童

![]()