MPEG中面向沉浸式视觉体验的标准化活动

业界对于HEVC的压缩性能比较认可,其实现复杂度也在不断地进行优化,但专利许可问题是HEVC在业界真正遇到的挑战。在HEVC编码专利许可问题的背景下,一些公司决定在MPEG国际标准组织以公开的方式来发展一个新的EVC标准。本文整理自浙江大学的虞露教授在LiveVideoStackCon 2019上海大会中的分享,详细介绍了近期在MPEG标准工作组中面向高沉浸感视觉体验而开展的一系列标准化活动。

文 / 虞露

整理 / LiveVideoStack

大家好,我是来自浙江大学的教授虞露,本次分享的主题是MPEG中面向沉浸式视觉体验的标准化活动,内容中介绍了近期在MPEG标准工作组中面向高沉浸感视觉体验而开展的一系列标准化活动,包括具有知识产权优势的MPEG-5 Essential Video Coding技术、全景视频的表达与编码方法、增强的3自由度和6自由度的视频及点云编码技术等。

1. MPEG

1.1 MPEG标准组织

MPEG标准组织官网:https://mpeg.chiariglione.org在每一次MPEG会后都会有新闻公报,有关MPEG最新标准化活动的成果和进展情况都会以公报的形式在官网发布,关于MPEG未来的动向大家可以关注MPEG主席的博客http://blog.chiariglione.org。上图中下半部分就是近期博客中提到的视频编码领域四十年标准化的发展历程。本次分享的主要内容是在沉浸式媒体方面的一些新的探索,除了新的MPEG标准MPEG-I(I: Immersive)外还有目前正在进行的MPEG-5 EVC,在MPEG-I中包括增强的三自由度视频(3DoF+)、六自由度视频(6DoF)和点云等标准化活动都在同步开展中。

1.2 MPEG-5 EVC

1.2.1 EVC提出的背景

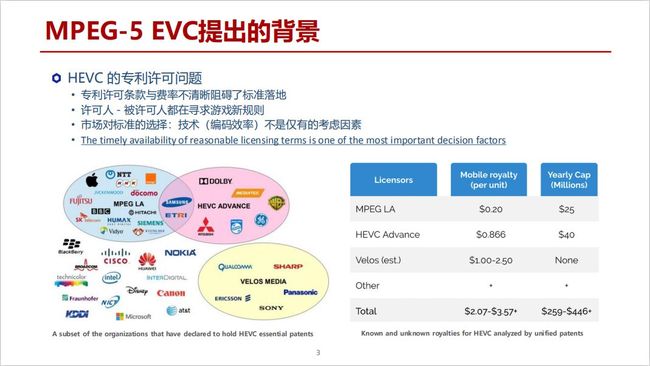

业界对于HEVC的压缩性能比较认可,其实现复杂度也在不断地进行优化,但专利许可问题是HEVC在业界真正遇到的挑战,专利许可条款与费率不清晰阻碍了标准落地。很多公司知道HEVC在性能和复杂度优化方面做得很好,但何时能够真正解决HEVC的收费问题目前还没有一个明确答案。

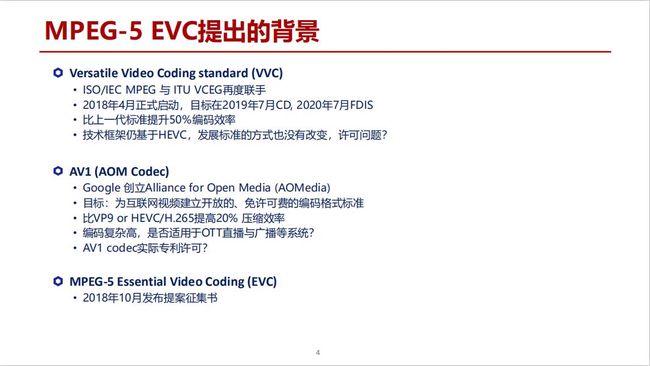

在HEVC编码专利许可问题的背景下,MPEG启动了VVC,它是ISO/IEC MPEG 与 ITU VCEG再度联手开展的新一代视频编码标准,这个项目在2018年4月正式启动,目标在2019年7月形成CD,2020年7月形成FDIS。但所有的技术提案方只承诺可以给业界授权,至于如何授权以及专利费用和条款的问题都是不清楚的,这与H.265存在同样的问题。在同一时期Google领导创立了AOM组织,目标是为互联网视频建立开放的、免许可费的编码格式标准,但这个目标能否达成依旧是个未知数。在这样的背景下,一些公司决定在MPEG国际标准组织以公开的方式来发展一个新的EVC标准。

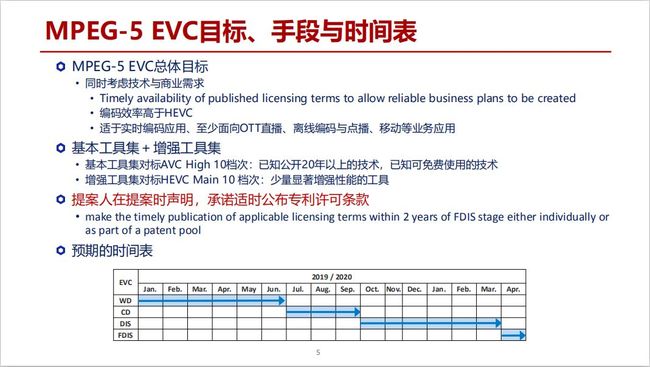

1.2.2 EVC目标、手段与时间表

EVC的做法与之前H.265和VVC标准不同,一方面要保证技术上的先进性,但同时也要结合商业上的需求,因此在技术提案时技术提案方需要承诺授权方式,目前EVC标准的提案中提案人都会做专门的声明,承诺适时公布专利许可条款。这样做会给市场更强的信心去实现这个标准,对推广成本的预估也更加清晰。EVC在AVC已经公开20年以上的免专利费技术基础上,推出了基本工具集、对标AVC;在基本工具集的基础上,EVC还增加少量性能显著、知识产权来源明确的工具,形成增强工具集,对标HEVC。

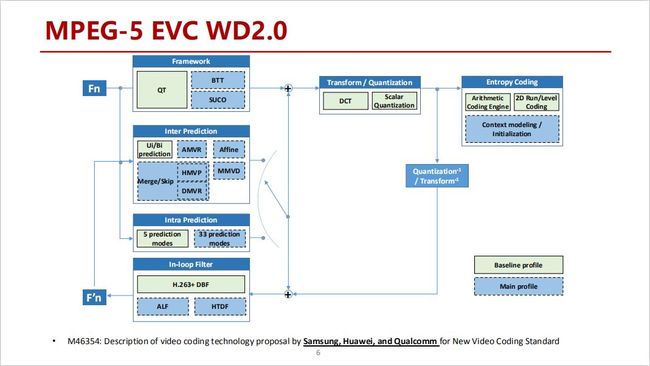

1.2.3 EVC WD2.0

三月底在MPEG会议上刚刚确立了EVC WD2.0,下一个版本就会是CD。上图中呈现了非常完整的编码流程,包括块划分、帧间预测、帧内预测、变换量化、环路滤波到最后的熵编码。其实,从H.261到H.265,包括VVC都一直采用这套框架,但其中所有模块分为两种不同颜色,绿色框中的是之前所说的基本工具集的工具,蓝色虚线框是增强工具集的工具。希望绿色框中的基本工具能够做到免专利费,而蓝色框中的增强工具则是有明确知识产权收费条款限定的。

1.2.4 EVC 基本工具集

在EVC标准发展过程当中,关于技术能否满足上述绿色模块免专利费的要求,做了很多调研分析。例如,在1994年的学术文献上就能发现采用四叉树的编码方法,距今已经二十年以上,哪怕当时是有专利申请也已过期了,目前就可以免费使用。这是一种分析策略。

其他方面包括帧内预测、帧间预测和模式编码等都是采用类似的方法,放心采用二十年以上的文献报道或者已知专利保护已失效的技术。比如Loop filter是H.263标准中的技术,但对这些技术重新组织之后,性能仍然可能超过AVC。

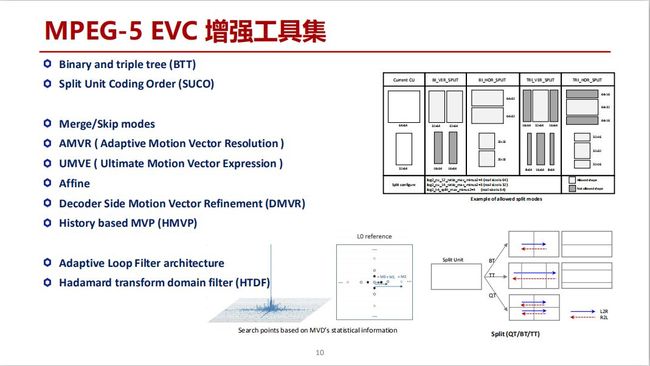

1.2.5 EVC 增强工具集

MPEG-5 EVC增强工具集中所有技术都是在技术提案中承诺适时公布明确的专利许可条款,这些技术的主要来源公司包括三星、华为和高通等。

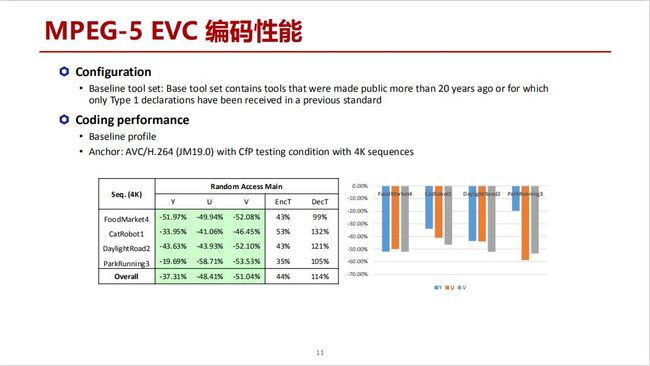

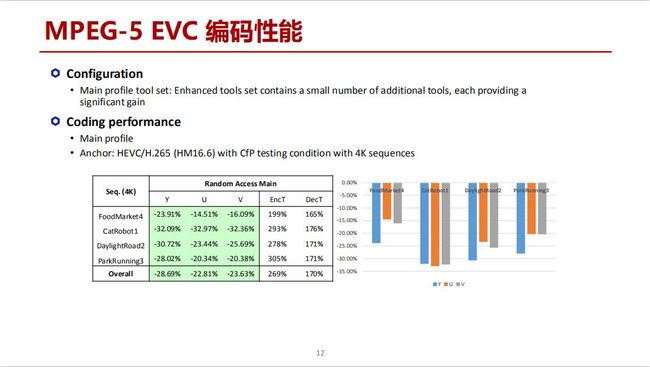

1.2.6 EVC 编码性能

在上述策略的基础上,目前一个是对标AVC测试Baseline profile的性能。可以看到在指定测试条件下,EVC Baseline profile在同样的恢复视频质量下比AVC节省了37%的码率,编码时间也更加节省,复杂度也可以接受,在Baseline profile上可以说明显超过了AVC。

EVC再上一层是Main profile,即增强的工具集。和HEVC相比在同样的恢复视频质量下节省了大约28%的码率,编码复杂度有所增加,大约为HEVC的2.6倍,解码器时间增加到大约1.7倍。这个性能对市场而言已经可以明显判别EVC Main profile优于HEVC。

为了技术生态发展,适当收费或者说适时公布专利许可条款都是无可厚非的,所以MPEG在EVC新的标准上就是这样的定位。不论现在新增的功能多炫酷,技术核心仍然离不开2D视频压缩编码,所以EVC也是发展新功能的一个非常好的基础。

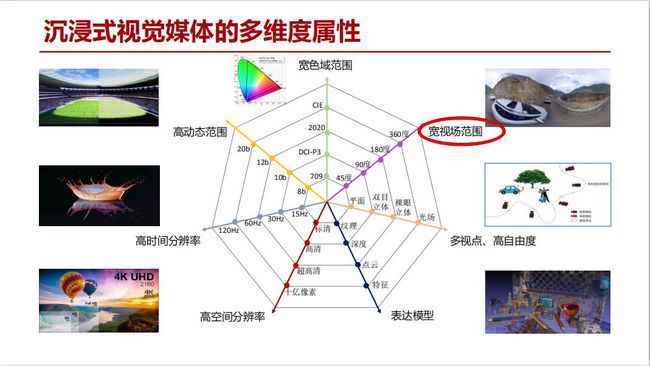

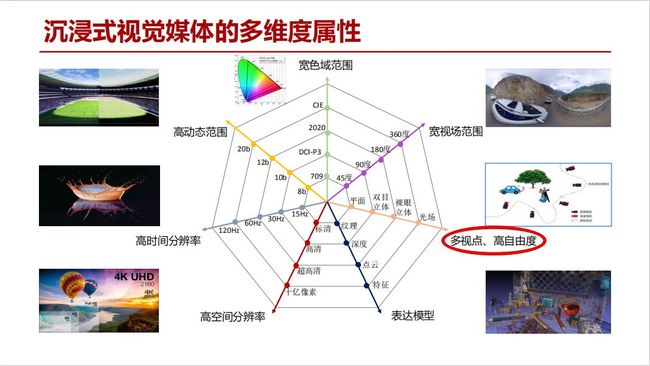

1.3 沉浸式视觉媒体的多维度属性

沉浸式视觉媒体的新功能若要达到增强沉浸感,必须在高空间分辨率、高时间分辨率、高动态分辨率和宽色域范围等方面尽可能真实的还原人眼所看到的景象,除此之外本次分享的高沉浸感媒体内容主要涉及宽视场范围、多视点和高自由度以及新型表达模型三个方面。

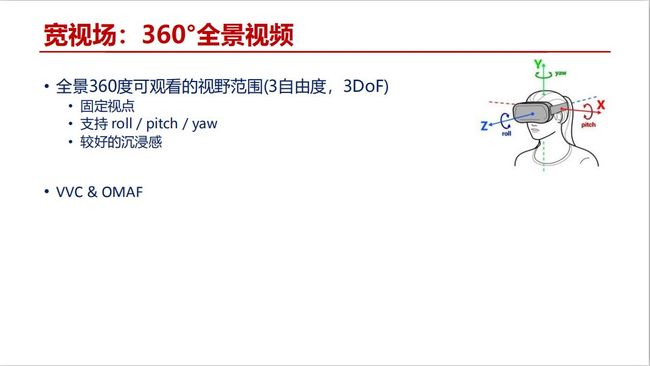

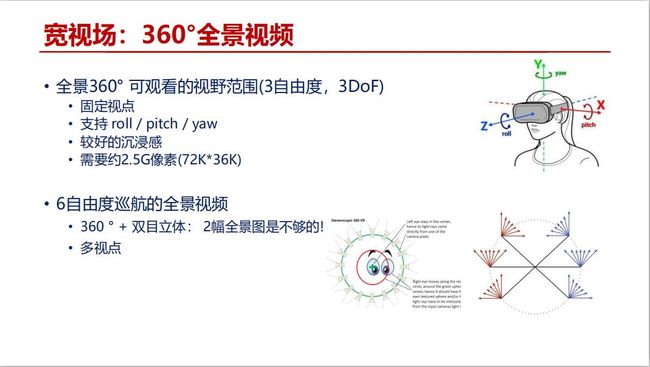

1.3.1 宽视场:360°全景视频

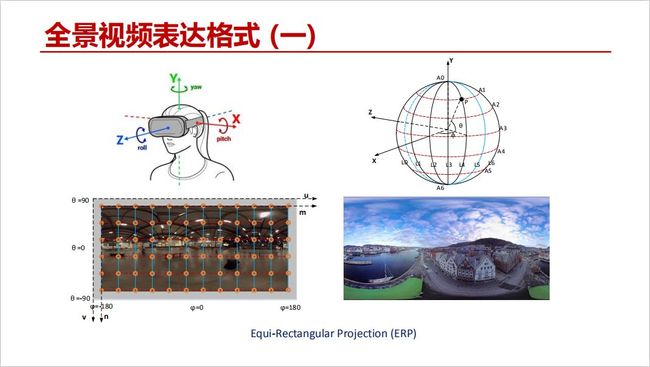

在宽视场360°全景视频中提供给用户的是3自由度,即在XYZ轴上视角可以自由转动,支持roll/pitch/yaw,虽然有较好的沉浸感但视点位置必须是固定的。

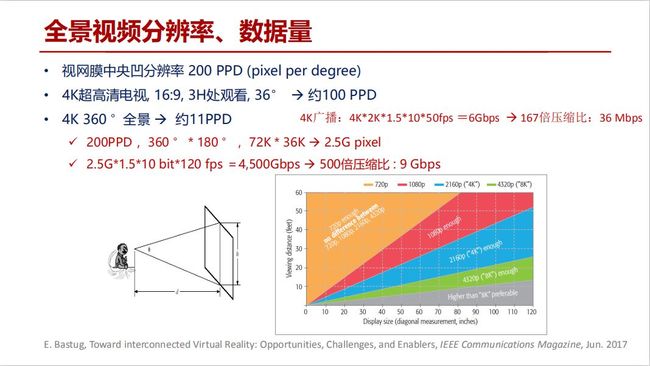

1.3.2 全景视频分辨率、数据量

视网膜中央凹分辨率在每一度的视角达到200 PPD。在距离3倍图像高度的位置处观看4K超高清电视,每度视角所接收到的像素约为100 PPD,基本接近视网膜的分辨率。360°4K全景视频每度视角所接收到的像素仅为11 PPD,远远低于视网膜的分辨率。如果需要全景视频满足视网膜分辨率的话,像素率需要达到72K*36K,整个画面达到2.5G 像素。央视4K广播使用的传输带宽是36 Mbps,那么按照2.5G像素哪怕用500倍压缩比信道宽度也将达到9Gbps,目前的技术差距还非常的大。

1.3.3 全景视频表达格式

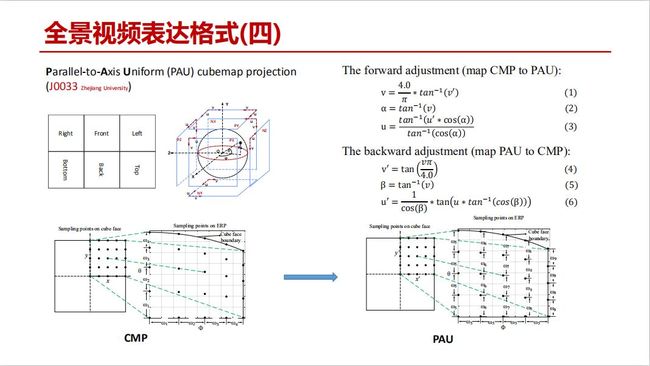

全景视频360°是固定视角的表达模式,可以看作人在球心、可以向球的各个方向观看,所以全景视频描述的是球形的影像,最常使用2D Equi-Rectangular Projection (ERP)方法,把球形影像拉成平面,但可以看到图中很多地方发生变形。

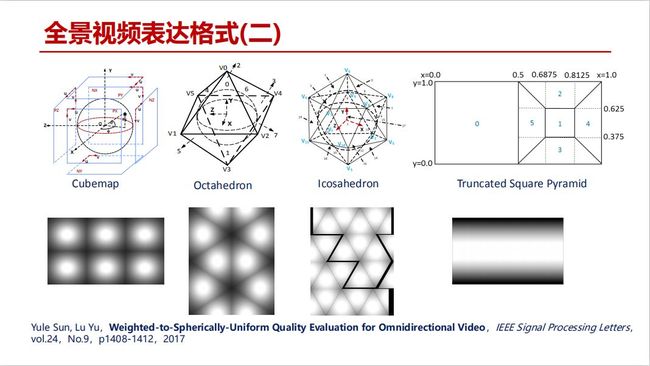

针对这样的全景视频投影模式进行了很多探讨,包括立方体、六面体、八面体、二十面体和截断的金字塔等投影模式。

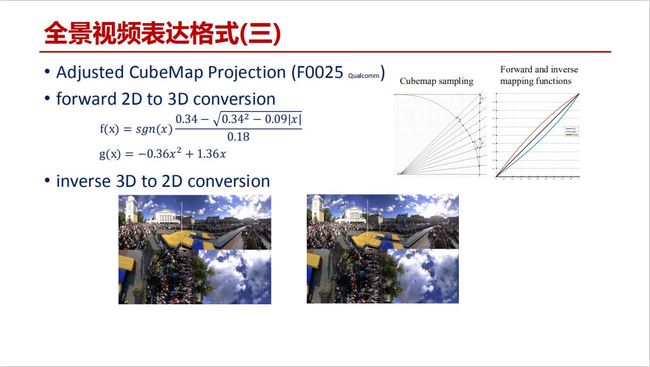

过多面体的投影模式会引出一些处理方面的问题,所以在测试中六面体是相对不错的选择。但六面体的投影是在每一个面上进行等间隔采样,映射到球面其实是不等距离的采样。因此在CMP的基础上有人提出了调整的CMP,把像素点的分布在六面体表面不是等比例的。

PAU就是我们提出的一种方式,基于对CMP方案的调整,使得在球面的经度纬度上都可以尽量采用等间隔采样。

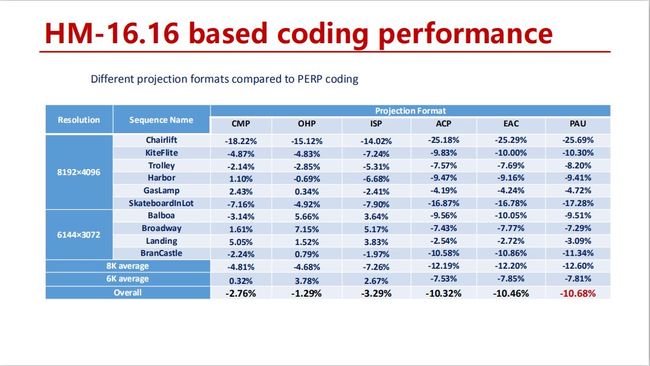

1.3.4 HM-16.16 based coding performance

对比于ERP,CMP的编码效率提高了大约2%,通过采样格式的优化最多可以提高10%以上的编码效率。所以不改变编码方式,仅选择采样格式优化成为全景视频提高压缩性能的非常重要的手段。

1.3.5 New Coding Tools for 360 Video

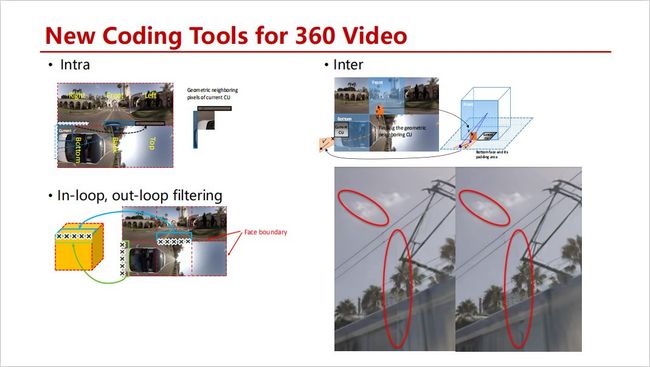

JVET在VVC的基础上探索了帧内预测、帧间预测新工具,特别是在六面体的面不连续的位置上进行新编码工具的引入,但这些编码工具提升的压缩效率非常有限。主要需要解决的问题是在不同面的拼接缝上的不连续状况,经过环路内滤波器的开关、再加上后处理基本可以解决这样的问题。

1.4 沉浸式视觉媒体的多维度属性

为了高沉浸感体验,在视场范围达到360°之后,视点还可以在三维空间里自由移动(高自由度)。

1.4.1 MPEG相关活动MPEG-1

3DoF就是固定视点的全景360°技术,MPEG在此基础上又增加了3DoF+和6DoF,从3DoF到6DoF中间的技术跨越性比较大,所以在中间引入了3DoF+这样的过渡阶段。

1.4.2 宽视场:360°全景视频

当视点不固定时,两张360°全景图像其实无法满足3DoF+或者6DoF的视觉需求。

1.4.3 超多视点视频

3DoF+和6DoF其实探讨的是超多视点视频编码的问题,上图中相机在一条直线或弧线上以极高密度排布,拍摄各个视角的影像,也可以用球形相机进行画面捕捉。

1.4.4 MPEG-1 Visual 3DoF+ Activities

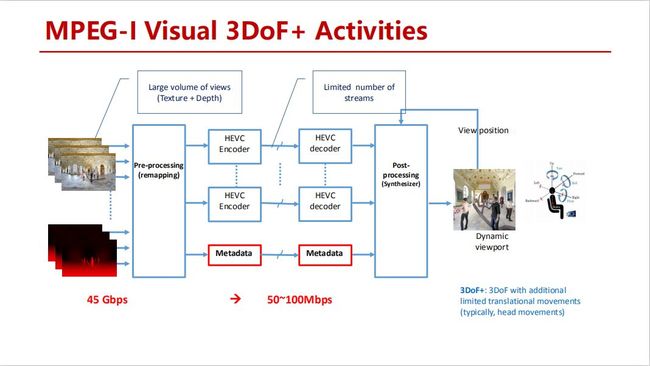

MPEG针对3DoF+已经开展了提案征集与响应。3DoF+任务约定不修改视频编解码器,为了支持3DoF+输入端可能会接收超多视点的视频,通额外增加定义新的Metadata来支持3DoF+应用,核心部分仍然使用现有的成熟编解码技术,例如HEVC。

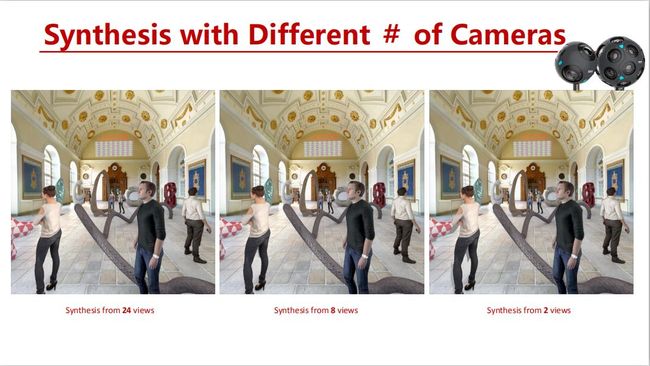

1.4.5 Synthesis with Different # of Cameras

上图分别是用24、8、2路摄像机合成视频,三段视频都是移动视点和朝向来观看,它们采用同一个头部移动路径,2路摄像机合成的视频明显存在一些遮挡区域的信息缺失情况。

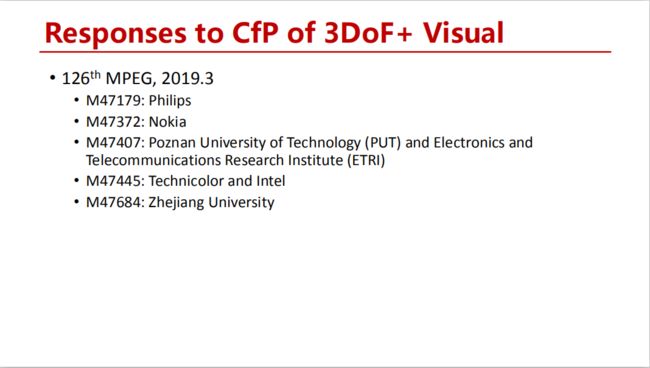

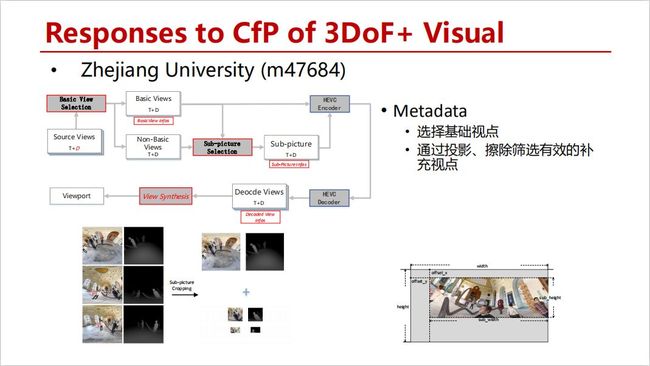

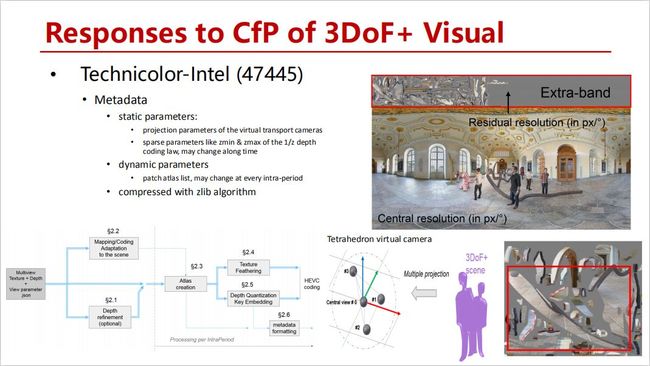

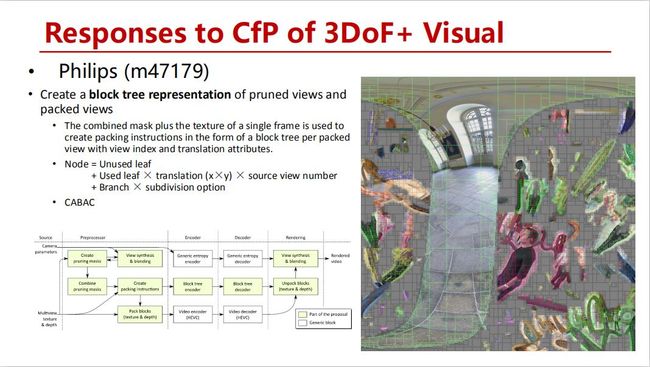

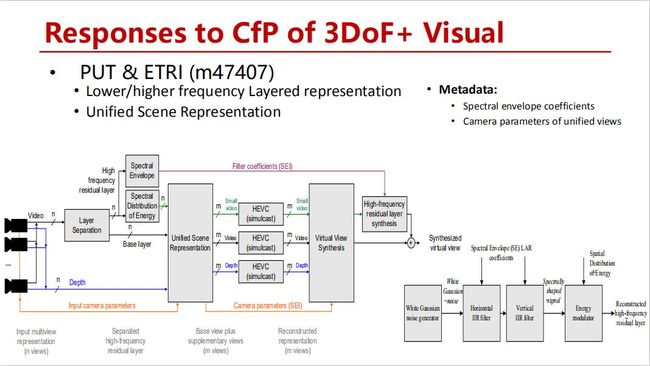

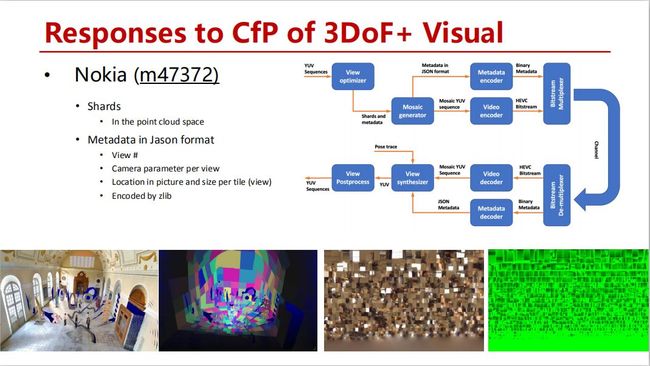

1.4.6 Responses to CfP of 3DoF+ Visual

今年三月,MPEG收到的五份响应的提案,在这里与大家分享。

浙江大学提出的方案(m47684)应该是最简洁的,首先选择所有输入视频里最中心视点的视频(从而尽可能多的覆盖整个场景),在此基础上通过投影、擦除的方法,筛选出具有补充信息的其它视点信息,将那些区域截成子图,这样编码的像素率会控制在两路视频之内。

在浙江大学提出方案的基础上,也有公司提出把补充信息分割成小片并拼接起来,在主视点上方添加一块拼接图,整个作为一路视频传输。

也有公司提出拼接以后的图可以类似于编码中常用的四叉树划分去组织表达每一个分片。

还有方案提出对于高频信息部分补充一些额外信息作为Metadata传输。

另有方案提出把多路视频信息投影到3D空间上进行分析处理和重投景,每一个小切片尽量平行于景物当中物体表面,以小切片拼成完整的图像后进行编码。

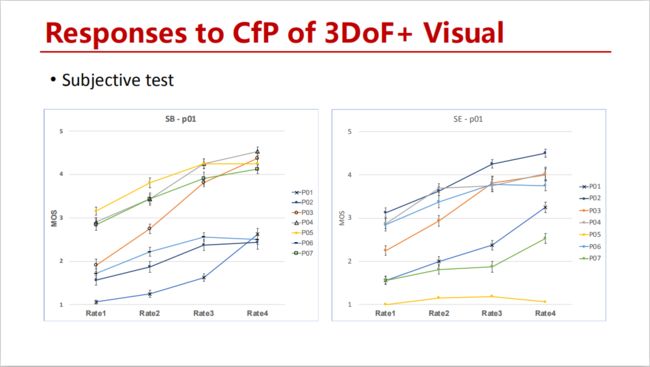

对上述各方案进行主观测试后得出的结论是,在一些测试序列上提案的方案能够超过简单的视频筛选,但在另一些测试序列上尚不能够达到很满意的效果。

1.4.7 Test Model of immersive video (TMIV) (w18470)

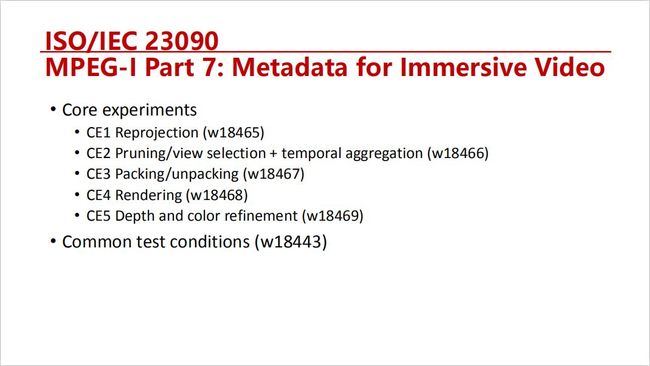

所以在三月底的会议当中确定了开发Test Model软件平台,其中包括Encoder和Decoder。编码端核心依然使用传统的编码器,它的作用主要是从多路输入的视频中筛选和组织有效信息,做编码之前的前处理;在解码端仍然使用传统的解码器,但需要额外接收一些Metadata,并进行拆解和渲染恢复。

上图是在本次会议定义的一些需要继续发展的核心实验。

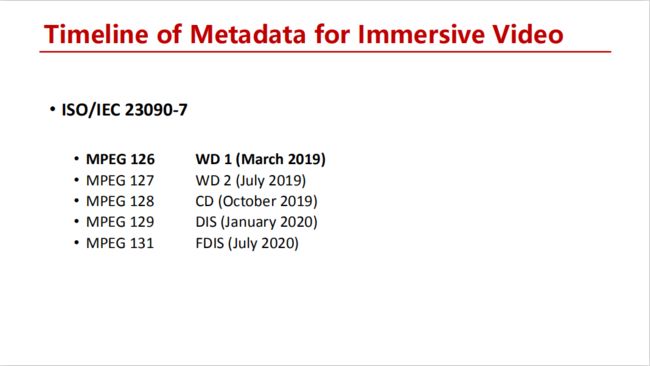

1.4.8 Timeline of Metadata for Immersive Video

目前MPEG的计划是在今年十月完成标准化工作,需要注意的是它仍然使用传统的编解码核心,只是外加一些Metadata和对的处理。

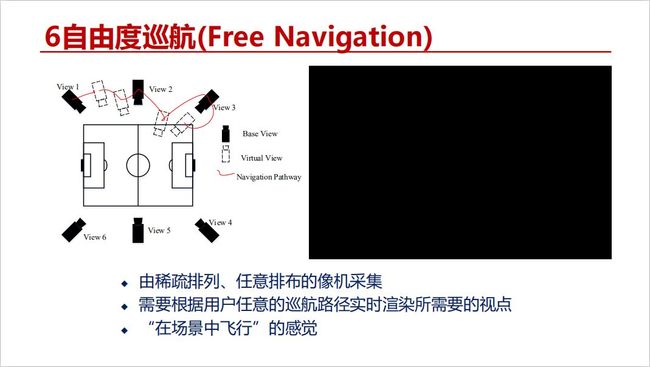

1.4.9 6自由度巡航(Free Navigation)

前面讲到的是3DoF+,即在十分有限的范围里可以移动视点;之后的发展方向是用户可以在更大的范围做更自由的视点移动,被称为6DoF。

1.4.10 MPEG-I Visual 6DoF Activities

继续沿用3DoF+无法满足更高自由度的视角朝向移动,针对6DoF+的发展将不仅限于使用新的Metadata,而且可以根据需要改变核心的编解码方案,具体内容目前还在探索当中。

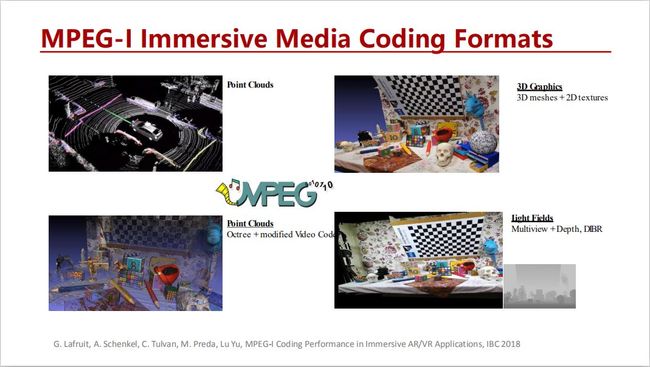

1.4.11 MPEG-I Immersive Media Coding Formats

3DoF+无论如何都是多路视频,依然是以视频的形式进行处理与传输,视频都是由二维均匀采样的点阵构成的。针对高自由度应用需求,对三维空间采用点云的方式非均匀采样,是一种新的视觉信息的表达方式。

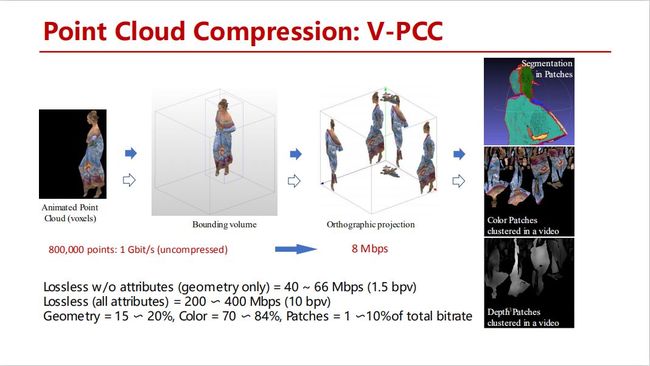

1.4.12 Point Cloud Compression: V-PCC

有意思的是,点云的压缩方案最终还是把三维空间中的点投影到了六个平面上,最后将投影成的小片图像拼接组合起来,最后还是采用2D的视频编码进行压缩。

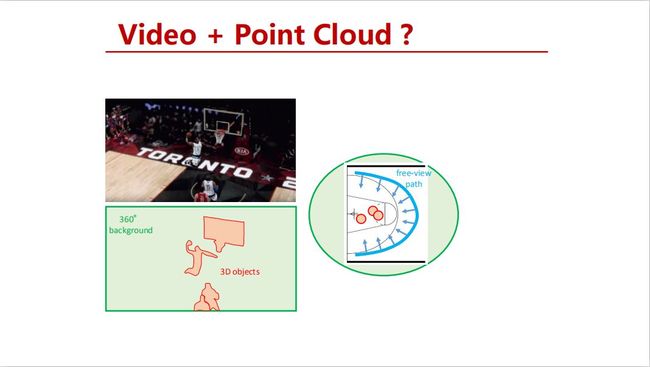

未来对于高自由度的使用场景,可以考虑不同的对象用不同的方式去表达,基于不同的表达再进行压缩的编码。比方说背景做成2D的影像,对于对象则采用点云的方式表达。

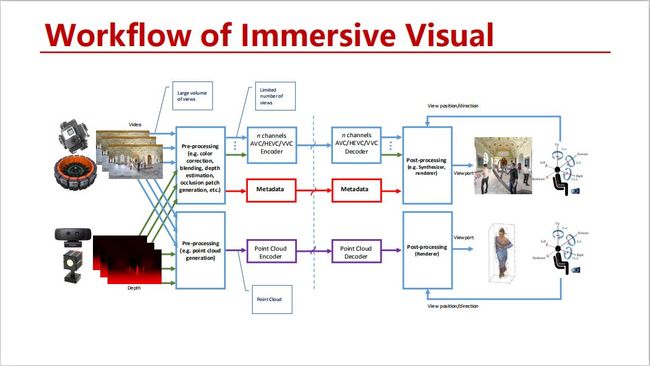

1.4.13 Workflow of Immersive Visual

作为沉浸式的视觉媒体来说,有不同的解决方案可以使用,甚至包括组合使用解决方案。

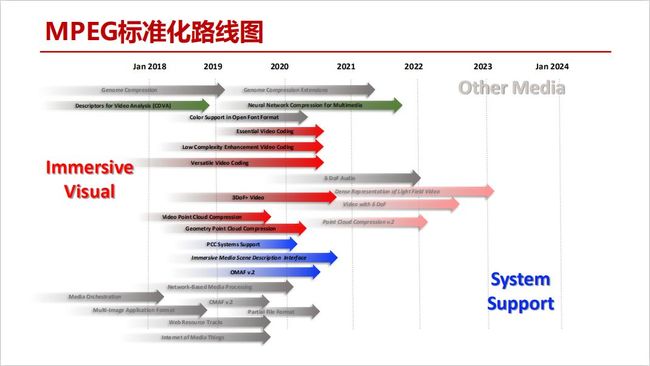

1.4.14 MPEG标准化路线图

上图是目前最新的MPEG标准化路线图,其中红色部分与Immersive Visual Content编码密切相关。

1.5 总结

总结来说,目前沉浸式媒体数据量非常大,表达形式也是多种多样,为高效的压缩带来了更大的挑战,除了技术问题之外,知识产权也是在技术发展生态中比较值得关注的问题。

LiveVideoStack 招募

LiveVideoStack正在招募编辑/记者/运营,与全球顶尖多媒体技术专家和LiveVideoStack年轻的伙伴一起,推动多媒体技术生态发展。同时,也欢迎你利用业余时间、远程参与内容生产。了解岗位信息请在BOSS直聘上搜索“LiveVideoStack”,或通过微信“Tony_Bao_”与主编包研交流。

LiveVideoStackCon 2019北京 音视频技术大会 初版日程现已上线,扫描图中二维码或点击【阅读原文】了解大会最新日程。