hive 安装教程

hive安装和配置

hive的测试

hive安装和配置

一:下载hive——地址:http://mirror.bit.edu.cn/apache/hive/

1.解压到 /usr/software/hive

2.设置环境变量

export HIVE_HOME=/usr/software/hive/hive

export CLASSPATH=.:${HIVE_HOME}/lib:$CLASSPATH

export PATH=${HIVE_HOME}/bin:${HIVE_HOME}/conf:$PATH执行source /etc.profile:

执行hive --version 检查是否安装成功

有hive的版本显现,安装成功!

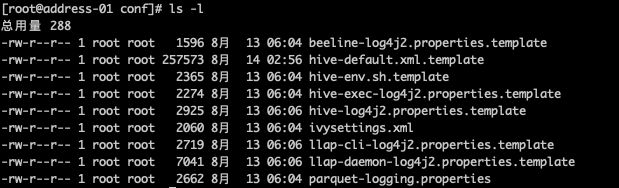

3.修改hive-site.xml:在hive/conf目录下面

这里没有,我们就以模板复制一个

cp hive-default.xml.template hive-site.xml

vim hive-site.xml 下面都有的配置项都不要插入,要替换掉。否则报错

javax.jdo.option.ConnectionUserName 用户名(这4是新添加的,记住删除配置文件原有的哦!)

root

javax.jdo.option.ConnectionPassword 密码

123456

javax.jdo.option.ConnectionURL mysql

jdbc:mysql://192.168.1.68:3306/hive

javax.jdo.option.ConnectionDriverName mysql驱动程序

com.mysql.jdbc.Driver

hive.exec.script.wrapper

这步要将cp过来的 hive-site.xml 中下面这些注释掉,否则创建的mysql数据库不是配置的hive,而是metastore_db

将 hive-site.xml 下面的内容覆盖

hive.exec.local.scratchdir和hive.downloaded.resources.dir

这二项对应的目录,是指本地目录(必须先手动建好)

root@master:conf# mkdir -p /user/hive/scratchdir

root@master:conf# mkdir -p /user/hive/downloaded

hive.exec.scratchdir和hive.metastore.warehouse.dir

这两项目录为hdfs中的目录(hive启动时,会自动建好,如果自动创建失败,也可以手动通过shell在hdfs中创建

hadoop fs -mkdir -p /tmp/hive

hadoop fs -mkdir -p /user/hive/warehouse

4.配置hive-env.sh

进入/opt/module/hive/conf目录,修改hive-env.sh.template的文件名为hive-env.sh。(可以使用cp或者mv命令)

cp hive-env.sh.template hive-env.sh

修改Hadoop的安装路径

HADOOP_HOME=/opt/module /hadoop-2.7.3

修改Hive的conf目录的路径

export HIVE_CONF_DIR=/opt/module/hive/conf

5.下载mysql-connector-java-5.1.18-bin.jar文件,并放到$HIVE_HOME/lib目录下

# wget http://downloads.mysql.com/archives/mysql-connector-java-5.0/mysql-connector-java-5.0.8.tar.gz .

解压: tar -zxvf mysql-connector-java-5.0.8.tar.gz

将mysql-connector-java-5.0.8-bin.jar拷贝到hive lib目录下:

# cp mysql-connector-java-5.0.8/mysql-connector-java-5.0.8-bin.jar ./lib

6.初始化hive

先去数据库创建hive库

schematool -initSchema -dbType mysql -userName root -passWord 123456 -verbose

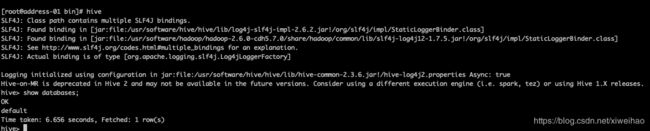

7.直接可以进入hive