CenOS7下Hive集群搭建

CentOS下hive(数据仓库工具)安装

- 采取服务端与客户端分离模式

在master上安装服务端

在node1上安装客户端

一、服务端安装

1.输入 mkdir /usr/local/hive ,建立一个hive的目录

![]()

2.将hive的tar包上传到建好的目录

3.进入hive目录,输入 tar -zxvf apache-hive-0.13.0-bin.tar.gz 解压hive的tar包

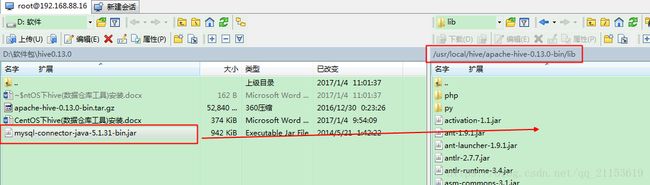

4.将mysql驱动的jar包放到hive的lib目录下

5.输入 vi /etc/profile 配置环境变量

![]()

6.添加如下内容,根据自己的解压路径填写,保存并退出

HADOOP_HOME=/usr/local/hadoop/hadoop-2.7.3/

HIVE_HOME=/usr/local/hive/apache-hive-0.13.0-bin/

PATH=$PATH:$JAVA_HOME/bin:$HADOOP_HOME/bin:$HIVE_HOME/bin

7.输入 . /etc/profile 使配置文件生效

![]()

8.输入 mysql -u root -p 进入mysql

9.输入命令 GRANT ALL PRIVILEGES ON *.* TO 'root'@'%' IDENTIFIED BY 'admin' WITH GRANT OPTION; 授权远程登陆

10.输入命令 FLUSH PRIVILEGES; 使如上修改立即生效

11.输入 exit 退出mysql

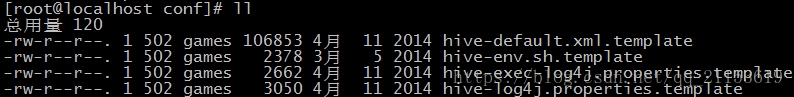

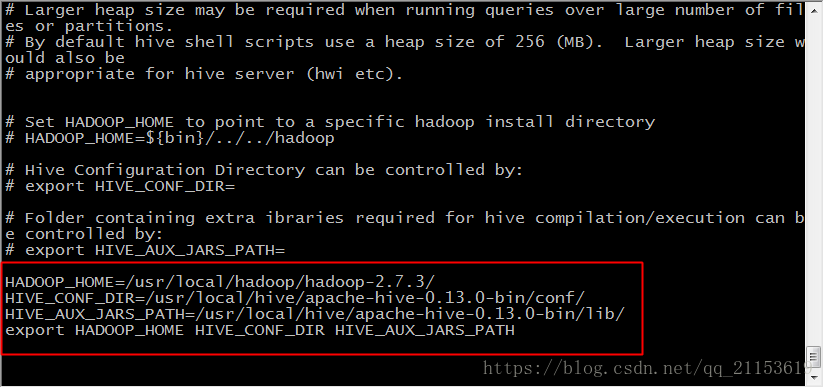

12.进入hive的conf目录,能看到4个配置文件

13.分别复制并重命名3个文件,例如cp hive-env.sh.template hive-env.sh,去掉.template后缀即可,将3个文件变为hive实际需要的配置文件,如下所示

14.输入touch hive-site.xml 新建一个配置文件

![]()

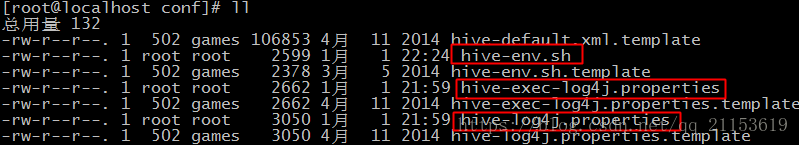

15.输入 vi hive-env.sh 修改配置文件

![]()

16.在文件末尾添加如下内容,配置HADOOP_HOME和HIVE的配置文件目录,保存并退出

HADOOP_HOME=/usr/local/hadoop/hadoop-2.7.3/

HIVE_CONF_DIR=/usr/local/hive/apache-hive-0.13.0-bin/conf/

HIVE_AUX_JARS_PATH=/usr/local/hive/apache-hive-0.13.0-bin/lib/

export HADOOP_HOME HIVE_CONF_DIR HIVE_AUX_JARS_PATH

17.输入 vi hive-site.xml 修改配置文件

![]()

18.在文件中加入一下内容,标红部分需要修改,因为你和我的IP不同,这里的mysql密码,要和前边授权的远程登陆密码一致,保存并退出

| |

二、node1建立hive客户端

1.将master上的整个hive目录移至node1上

scp -r /usr/local/hive/ root@node1:/usr/local/

2.在node1上输入cd /usr/local/hive/apache-hive-0.13.0-bin/conf/

,进入hive的conf目录,修改hive-site配置文件vi hive-site.xml

内容如下:

|

|

2.修改/etc/profile,与master配置一致,同上第5-6步

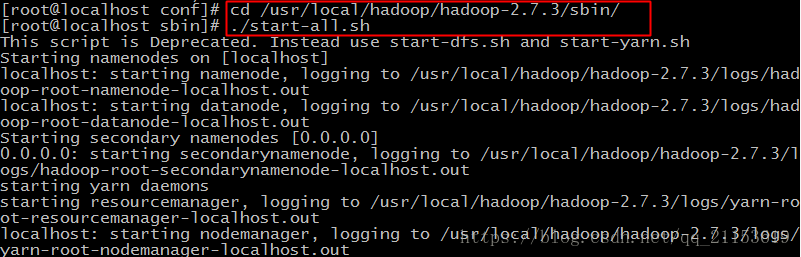

19.进入hadoop的sbin目录,输入 ./start-all.sh 启动hadoop

20.hadoop的hdfs不支持一次性建立多级目录,先输入 hadoop fs -mkdir /hive 建目录,这里建目录是与第18步中修改的数据路径相对应

![]()

21.再输入 hadoop fs -mkdir /hive/warehouse 建目录

![]()

22.输入 hive --service metastore 开启hive数据仓库,若卡住不动如下,其实已经开启了数据仓库,直接打开另一个shell窗口操作即可(例如右键CRT的IP,点击克隆会话)

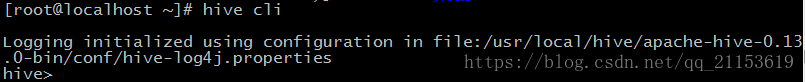

23.任意位置输入 hive cli 进入hive客户端

24.输入 create table if not exists hadoop(id int,name string); 建一张表,输入 show tables; 查看有 hadoop这张表

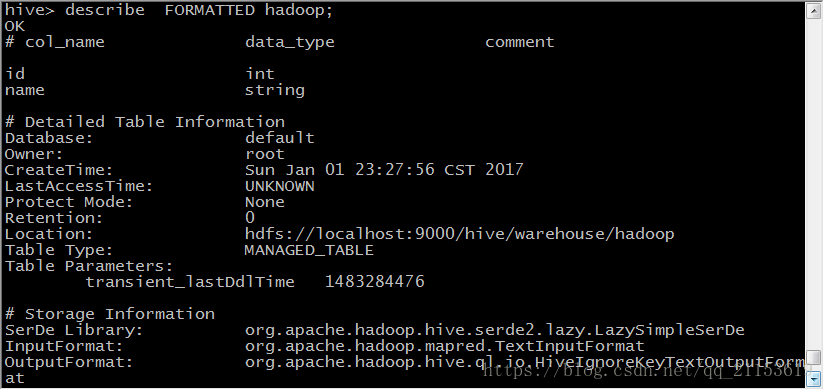

25.输入 describe FORMATTED hadoop; 查看hadoop表的相关信息

26.输入 exit; 退出hive客户端