Hadoop安装及eclipse配置

Hadoop安装

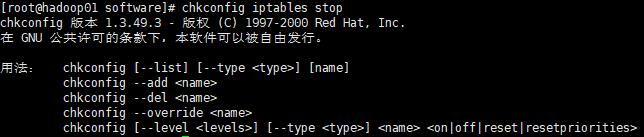

彻底关闭防火墙 chkconfig iptables off

查看主机名 hostname

![]()

修改主机名 vim /etc/sysconfig/network

![]()

修改之后不会立即执行需要重启才会生效,重启指令reboot

临时生效hostname Hadoop01

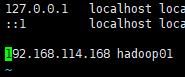

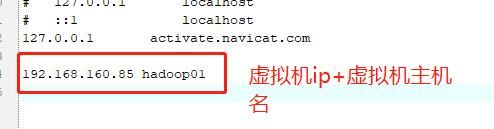

修改host文件 vim /etc/hosts

将主机ip与主机名进行映射

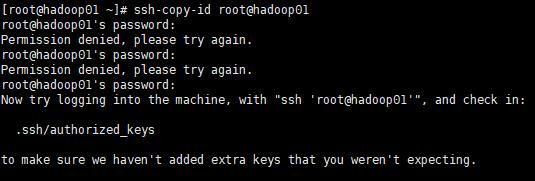

设置免密登录 ssh-keygen—一直回车

执行操作ssh-copy-id root@hadoop01—在这输入密码

安装hadoop

首先进入home目录下创建software文件夹

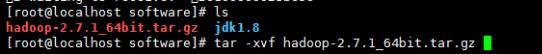

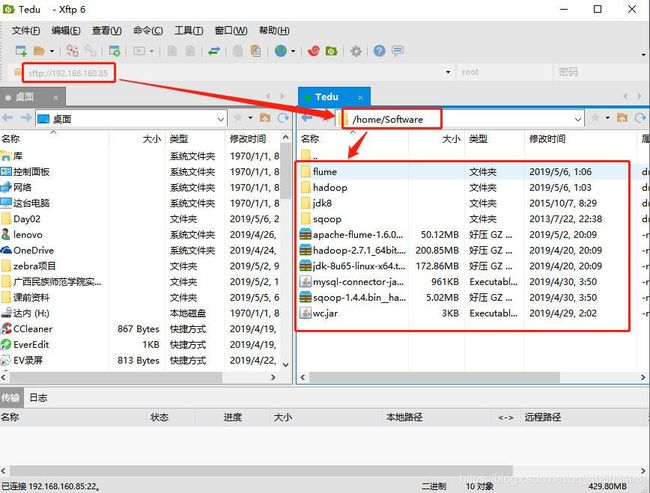

使用xftp连接虚拟机----将hadoop以及jdk的安装包拖到/home/software目录下

执行rz指令之后开始上传hadoop、JDK安装包成功,开始解压2个安装包

配置jdk环境变量vim /etc/profile

JAVA_HOME=/home/Software/jdk8

CLASSPATH=.:JAVA_HOME/lib/dt.jar:$JAVA_HOME/lib/tools.jar

PATH=JAVA_HOME/bin:PATH

export JAVA_HOME PATH CLASSPATH

让环境变量立即生效source /etc/profile jdk 配置是否成功 java -version

将解压的安装包进行重命名mv Hadoop-** Hadoop

进入到hadoop目录下的etc下的hadoop下修改配置文件vim Hadoop-env.sh

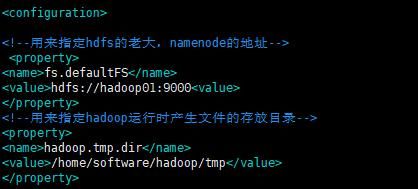

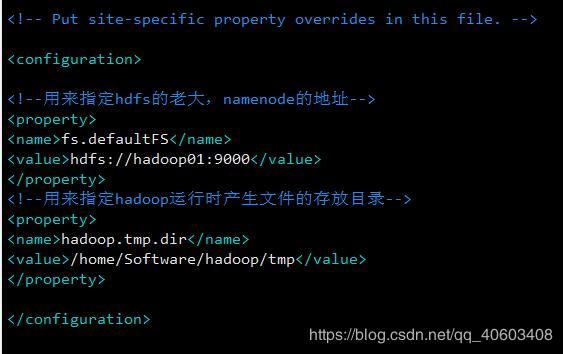

修改core-site.xml vim core-site.xml

<configuration>

<property>

<name>fs.defaultFSname>

<value>hdfs://hadoop01:9000value>

property>

<property>

<name>hadoop.tmp.dirname>

<value>/home/software/hadoop/tmpvalue>

property>

configuration>修改hdfs-site.xml vim hdfs-site.xml

<configuration>

<property>

<name>dfs.replicationname>

<value>1value>

property>

<property>

<name>dfs.permissionsname>

<value>falsevalue>

property>

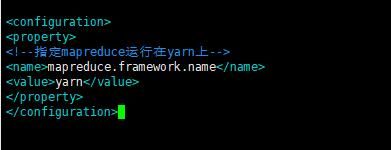

configuration>修改 mapred-site.xml 这个文件初始时是没有的,有的是模板文件,mapred-site.xml.template 所以需要拷贝一份,并重命名为mapred-site.xml 执行:cp mapred-site.xml.template mapred-site.xml

<configuration>

<property>

<name>mapreduce.framework.namename>

<value>yarnvalue>

property>

configuration>修改yarn-site.xml

<configuration>

<property>

<name>yarn.resourcemanager.hostnamename>

<value>hadoop01value>

property>

<property>

<name>yarn.nodemanager.aux-servicesname>

<value>mapreduce_shufflevalue>

property>

configuration>配置slaves文件

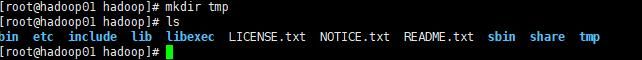

在hadoop文件目录下创建tmp文件

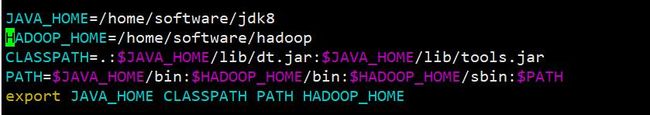

配置hadoop的环境变量 vim /etc/profile

JAVA_HOME=/home/software/jdk8

HADOOP_HOME=/home/software/hadoop

CLASSPATH=.:JAVA_HOME/lib/dt.jar:JAVA_HOME/lib/tools.jar

PATH=JAVA_HOME/bin:HADOOP_HOME/bin:HADOOP_HOME/sbin:PATH

Export JAVA_HOME CLASSPATH PATH HADOOP_HOME

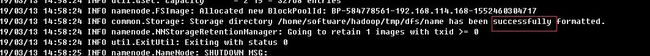

格式化namenode 执行:hadoop namenode -format

如果不好使,可以重启linux 当出现:successfully,证明格式化成功

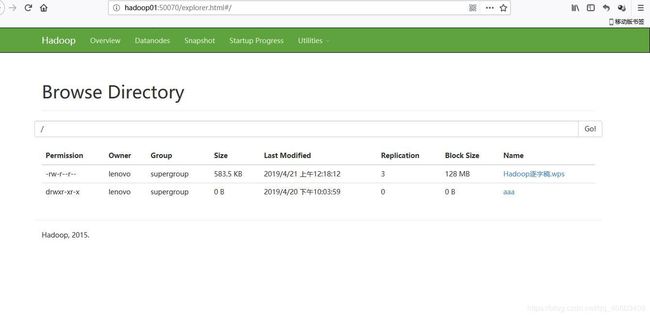

进入到hadoop目录下的sbin目录 执行 sh start-dfs.sh 之后执行jps查看

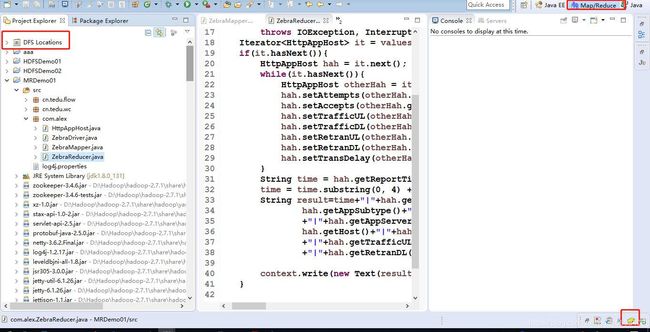

配置eclipse

将hadoop插件hadoop-eclipse-plugin-2.7.1放到eclipse的plugins目录下(打开eclipse)

点击右下角的黄色小象图标(如下图操作)

点击箭头所示的蓝色小象,如下图进行修改

在本地解压hadoop安装包

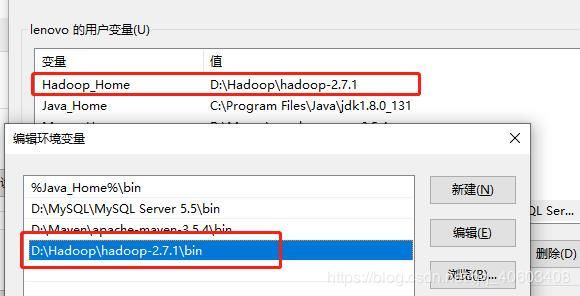

配置hadoop环境变量

将本地hadoop安装包解压引入eclipse(用于单机测试)

报错:java.net.UnknownHostException: hadoop01

未在本机做hadoop的映射关系

使用过程中出现的常见异常:

这个是hadoop插件自身的小问题,就是说这个插件是需要一个叫winutils文件支持的,这个错呢他是一个不确定的因素,是在,mr处出现,将插件hadoopbin

双击打开把里面的文件全部复制一下拷贝到hadoop插件下的bin目录里

然后配置hadoop的环境变量Hadoop_Home和Path

重启电脑(执行到这一步要是还是不可以,继续下面的操作)

在拷贝一份这个文件丢到c:/windows/system32下再重启就可以了

目前班级出现很多节点信息没有问题但是通过eclipse创建文件目录刷新出现闪退现象

解决问题

1. 删除software/Hadoop下tmp文件重新重新启动虚拟机

2. 查看logs日志文件里的日志信息根据对应的问题去解决

3. 查看hadoop/etc/hadoop下的配置的配置文件是否出现了空格出现删除空格

4. 如果以上所有配置全部没有问题那这个时候可以将这个安装文档里的配置全部复制粘贴重新启动

5. 最后问题没有改观,重新配置