首试GPU并行运算

今天首次尝试了GPU的并行计算,总得感觉上CPU与GPU之间的数据传输速度太慢,所以永远不要低估了GPU与CPU之间的数据传输速率,当需要用到GPU强大的并行计算能力时,一定要衡量好数据传输之间所花费的时间与GPU并行计算之间所省下的时间,看看得是否偿失,频繁的数据传输只会适得其反。

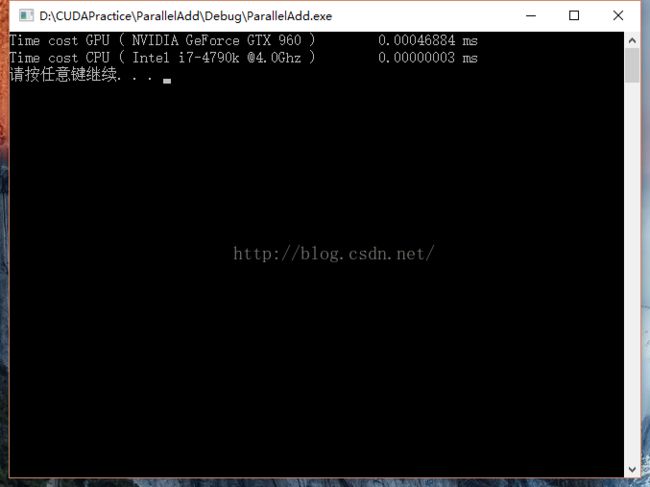

下面就放一个10个矢量之间的计算,GPU并行计算与CPU的串行计算所花的时间对比。

注意:那个时间单位错了,是s,不是ms

测试源代码:

#include

#include

#include

#include "cuda_runtime.h"

using namespace std;

clock_t start, stop;

double duration;

__global__ void add(int *a, int *b, int *c)

{

int tid = 0;

while (tid<10)

{

c[tid] = a[tid] + b[tid];

tid += 1;

}

}

int main()

{

start = clock();

for (int j = 0; j < 100000; j++)

{

int a[10], b[10], c[10];

int *dev_a, *dev_b, *dev_c;

cudaMalloc((void**)&dev_a, 10 * sizeof(int));

cudaMalloc((void**)&dev_b, 10 * sizeof(int));

cudaMalloc((void**)&dev_c, 10 * sizeof(int));

for (int i = 0; i < 10; i++)

{

a[i] = -i;

b[i] = i*i;

}

cudaMemcpy(dev_a, a, 10 * sizeof(int), cudaMemcpyHostToDevice);

cudaMemcpy(dev_b, b, 10 * sizeof(int), cudaMemcpyHostToDevice);

cudaMemcpy(dev_c, c, 10 * sizeof(int), cudaMemcpyHostToDevice);

add << <10, 1 >> >(dev_a, dev_b, dev_c);

cudaMemcpy(c, dev_c, 10 * sizeof(int), cudaMemcpyDeviceToHost);

cudaFree(dev_a);

cudaFree(dev_b);

cudaFree(dev_c);

}

stop = clock();

duration = (double)(stop - start) / CLK_TCK;

system("pause");

return 0;

}