认知智能,AI的下一个十年 | AI Procon 2020

![]()

![]()

整理 | 屠敏

出品 | AI科技大本营(ID:rgznai100)

60 年间的「三起两落」 ,人工智能的沉浮变迁。

在 1956 年的夏天,人工智能在美国达特茅斯大学召开的学术会议之上蹒跚学步,吸引无数研究学者对其智能化的探索以及未来美好愿景的描绘。不过,彼时在抽象思维、自我认知、自然处理、图像识别等基础性功能缺失的现状中,人工智能的发展从门庭若市到门口罗雀,甚至不少人视人工智能程序为“玩具”。最终,这一冷清的局面,直到 80 年代,一款从神经系统到推理都有了明显跨越性进步的“专家系统”的人工智能程序出现才被打破。

然而,所谓期望越高,落差越大,在 AI 硬件市场需求不断下跌,人工智能技术未来走向不明的趋势之下,人工智能的第二个低谷期很快来临。值得庆幸的是,值此之际,除却资本的热炒后,诸如神经网络、图像识别、语音识别、深度学习等人工智能核心技术均进入了平稳的迭代期。21 世纪,AlphaGo 在人机对抗中一战成名,凭一举之力将人工智能再次推进大众的视野。下一步,人工智能又会经历哪些机与遇?

日前,在 CSDN 举办的第三届“AI开发者大会(AI Procon)”主会上,清华大学计算机系教授、系副主任唐杰带来了主题为《人工智能的下一个十年》演讲,深度分享了人工智能的发展历程,及其背后的核心技术驱动,同时探讨了人工智能下一步的认知与推理、意识等种种的挑战。

以下内容为演讲实录,由 AI科技大本营(ID:rgznai100) 整理:

人工智能发展很快且已经进入第三个浪潮,诸多的国家也相继将人工智能列为国家发展计划。从趋势上,AI 在近十年间,从计算、感知到认知逐步迭代;在应用上,从博弈对策的 AlphaGo 开始,落地到无人驾驶、图像识别等相关场景中,AI 的发展浪潮逐步攀至顶峰。那么,在技术层面,人工智能背后的支撑力及驱动力又是什么?

![]()

人工智能近 10 年

80 年代,机器学习风生水起

机器学习从 80 年代迅速发展,彼时决策树、贝叶斯、感知机、神经网络、多层神经网络算法的崛起,使得机器学习呈现出百花齐放、百家争鸣的盛况。

90 年代深度学习势头强劲

随着时间的推移,90 年代,序列标注模型的出现,以及 2000 年以后深度学习的逐渐成熟,驱动机器学习取得了长足的进步。而回看当下,深度学习、以及细分的技术包括循环智能、深度生成模型以及深度强化学习等模型也纷涌而至。

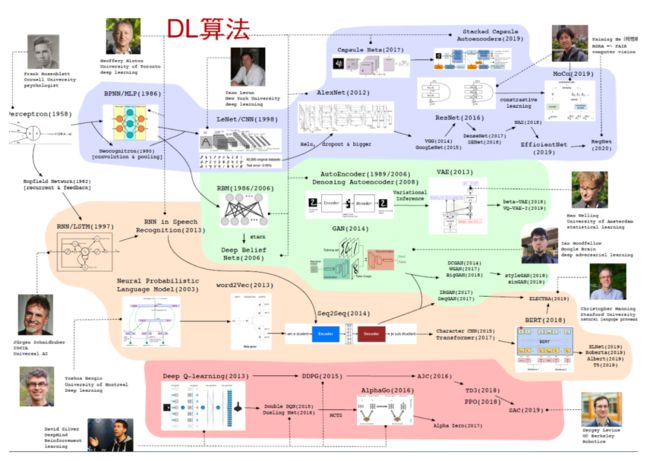

当然在整个发展历程中,每个领域都有开创者,人工智能的迭代也离不开一些核心人物的贡献。正如下图所述:

-

Geoffery Hinton 是最资深的深度学习玩家;

-

Yann Lecun、Frank Rosenblatt 和 Geoffery Hinton 都是图灵奖获得者;

-

AlphaGo 是在 David Sliver 的领导下研发出来的;

-

......

在技术落地上,近几年间,深度学习中预训练模型 BERT 是一个新的趋势。预训练模型的核心理念是通过大量的数据做预训练,基于此,针对特定的任务,进行微调。这一方法在自然语言处理中,超越了其他很多传统方法,表现尤为显著。正因此,2018 年也被业界称之为属于 BERT 的一年。

2019 年起,基于 BERT 思路,很多研究者在预训练模型上大下功夫,做出了很多开创性的工作。其中,生成模型作为人工智能领域一项重要的技术工作,也得到了很大的普及。生成模型通过大量的工具而生成,比如在视觉上,通过大量的训练,可以生成非常高清的视觉图像。

另外,从去年年底到今年初,自监督学习技术也有了最新的进展。即无需标记样本,即可学习图形表示。事实上,这一研究在几年前就已展开,譬如,让计算机通过大量的数据,就可以自动识别出猫。彼时环境下,很多人并不理解这件事的具体含义与技术,或许更多人认为这是一个很简单的问题,从机器学习角度来看,如果有一点点的标记样本,计算机就能识别这是一只猫。

那么,如果没有标记样本,计算机该如何识别出猫?

这就是自监督学习的魅力所在。它会通过数据本身的分析,比如给定一个图片 XQ,在大量的数据中自动找到 XQ 相关的图片,可以将这些图片作为正例,把其他随机找到另外一些图片作为负例,基于此,我们可以自动学习出哪些是一个正例,哪些是一个负例。在此过程中,或许有人提问,如果这里图片标注错误会怎么办?

事实上,在机器学习与人工智能的时代,大数据是基础,这就需要大量的数据为支撑。回归现下的自监督学习,在很多效果上,其甚至超过了有监督学习。

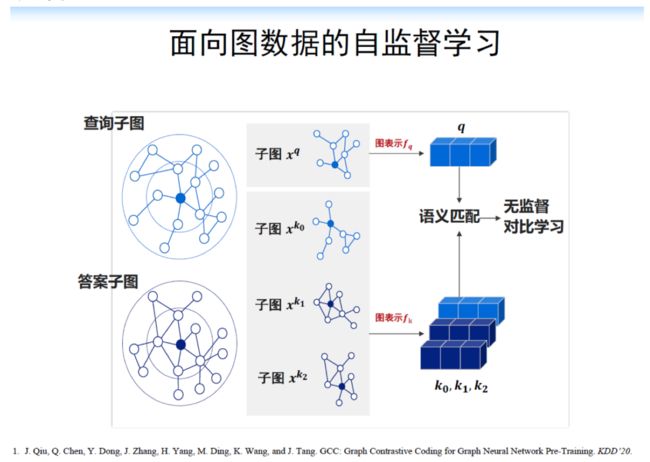

举例说明,我们研发了一个面向图数据的自监督学习。从下图中,如何让图数据划分正例和负例。首先,可以将蓝色的点视为正例。在图数据中,正例除了与自身属性有关,也与周围邻居节点相关。因此在海量数据中,任选一节点,随机生成一张子图 XQ,对于随机的子图,可能没有正例。

这可以再基于蓝色的点,随机生成另外的子图XK0,然后当做 XQ 的正例。同时从另外大量海量的图中,随机找一个点,如下图,再随机生成子图,即XK1,XK2,其中将 XK1 和 XK2 看做 XQ 的副例,把XK0看作 XQ 的正例,于是通过这样的方法,就能够自动构建了一个正例数据集和一个负例数据集,由此在超大规模的图数据上进行训练,最终发现效果可以超过有监督学习,因此,无监督学习也将必然是机器学习下一个重要的方向

基于此,我们研发了一个面向图数据的自监督学习。从下图中,如何让图数据划分正例与负例。举例说明,首先,将蓝色的点视为正例。在图数据中,正例除了与自身属性有关,也与周围邻居节点相关。因此从任一节点,随机生成一张子图。

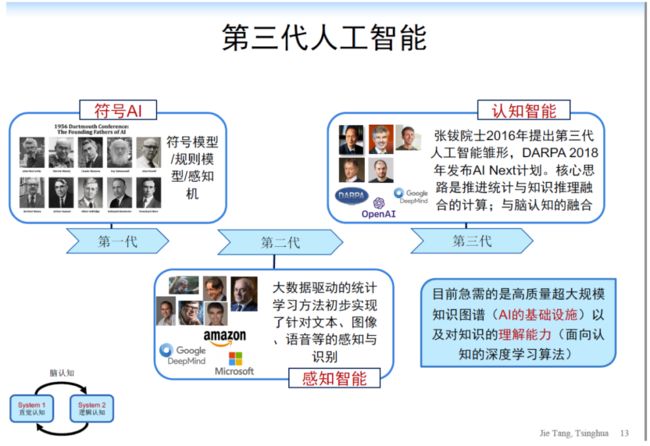

那当然了,我今天要探讨的不是机器学习的一个无监督,而更加要探讨的是人工智能的下一代,人工智能今天这个符号AI,也经历了感知AI,那下一个AI是什么呢?

![]()

人工智能的未来

2016 年,张钹院士提出第三代人工智能雏形。DARPA 在 2018 年也发布了AI Next的一个计划,核心的思路是推进统计与知识推理融合,包括机器学习和脑认知的融合。

其实,想要实现认知智能,目前最缺乏两个方面:

-

高质量超大规模知识图谱,这是AI的基础设施。

-

对知识的理解能力,即面向认知的深度学习算法。相较于当下更像黑盒子的深度学习算法,我们更需要可解释、鲁棒、具有理解能力的机器学习方法,亦或者叫做推理算法。

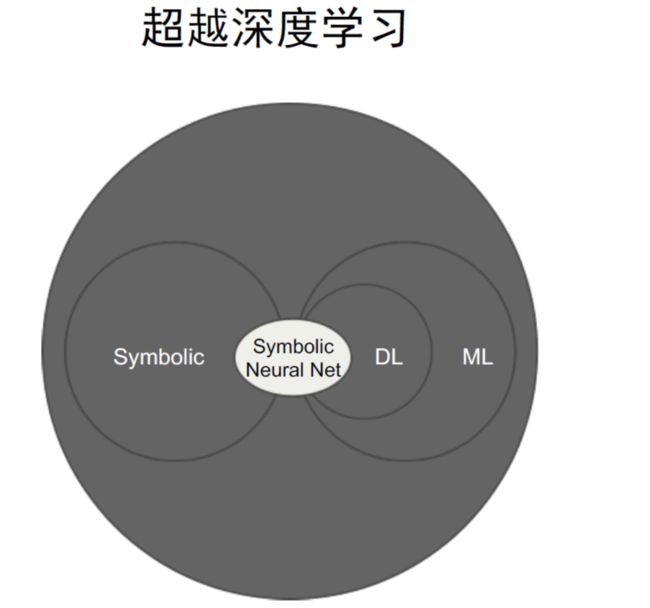

未来,人工智能必是超越深度学习的存在。如图所示,左边的 Symbolic 即符号 AI。右边为深度学习,时下深度学习和机器学习处于交融的状态,业界很多人评价道,深度学习是机器学习的一小块,很多人有认为它超越了机器学习。事实上,想要超越深度学习,我们需要结合符号 AI,也就是最终的 Symbolic Neural Net。

在此之中,算法是核心,计算、数据是基础。不过,需要强调的是,场景更为重要。

同样以一个简单的例子为据:

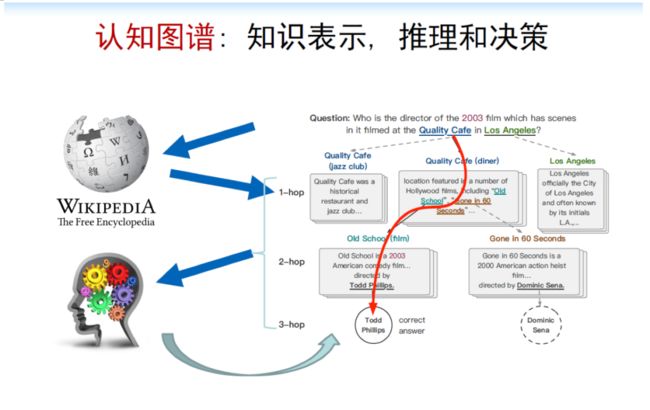

在认知智能研究中,核心是基于知识图谱之上,并在认知推理、机器学习算法做逻辑表达。下述案例中,是一个较为经典的使用认知图谱做算法和认知的结构的问题:

在洛杉矶的 Quality Cafe 的咖啡店中,于 2003 年拍过电影的导演是谁?

如果人想要得到答案,或许会从洛杉矶或 Quality Cafe 地点着手,盘点在这个咖啡厅中拍过的电影有哪些,进而查找电影的导演是谁,在根据 2003 年的年份去判断,最终找到答案。

如果是机器,它会怎么完成?

在这里,倘若我们采用传统方法或深度学习如 BIDAF、BERT、XLNet 等算法,那么需要构建一个冗长的预训练上下文,从而进行推理匹配。这样做其实弊端很多,一方面,它是一个黑盒子,缺乏可解释性。另一方面,缺乏在知识上面的推理能力,所以未必会得出的最终结果。

针对这一问题,或许可以从关键点入手。首先可以从维基百科进行相应地查询,找到相关的实体,通过实体再做下一个选择,如从 Old school 找到 Todd Phillips,最终人脑进行一个推理决策,判断最终的答案。

在这个过程中涉及非常简单的两个阶段:

-

快速匹配。比如给定 Quality Cafe,我们会迅速找到维基百科的结果,或从大脑中的一个记忆系统中找到相关的记忆;

-

另外,我们会做决策推理,也就下面的这个过程,人脑进行思考,不过这个过程相对比较慢。

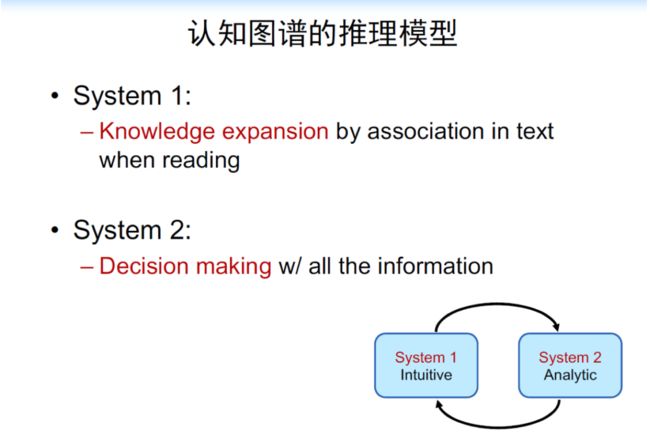

因为认知推理过程中,人脑在思考的时候,会有两个系统,被称之为双系统理论:

-

System 1 为直觉匹配,它具有无意识性,会快速地进行知觉匹配;

-

System 2 为逻辑分析,具有规划推理,带有意识的生产过程,做最后的决策。

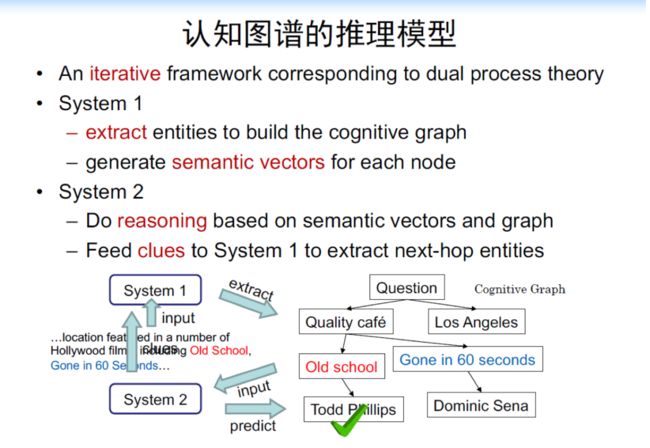

时下的深度学习大部分针对 System1 也就是在做无意识的匹配,而未来的深度学习,更应该进行逻辑、规划、推理学习。那么,该双系统理论如何与上述的问题结合?对此,可以通过认知图谱的推理模型,与双系统对接,在这一过程中,System 1 做知识匹配,简单地将知识节点和知识正文匹配起来,System 2 进行决策。

根据上述案例,当问题出现后,我们首先突出两个实体,Quality Café 和 Los Angeles ,对 Quality Cafe 做快速匹配,从而找到相应的文档,并从中抽出新的实体,比如 Old School、Gone in 60 seconds,这两个实体都是两个电影的名字,System2 会做决策,会判断 Old School是我们要的答案吗?或者 Gone in 60 seconds 是我们要的。

在判断后,如果不是正确答案,那么它会将当前这个作为一个新的线索,放到 System1 中,这就和人脑推理的过程一模一样,System1 就会进一步做知识或实体的抽取,比如快速找到 Old school 对应的页面,从里面再抽出新的实体,像 Dodd Phillips,或者其他实体,System2 再做决策,于是这两个过程就变成抽取决策。

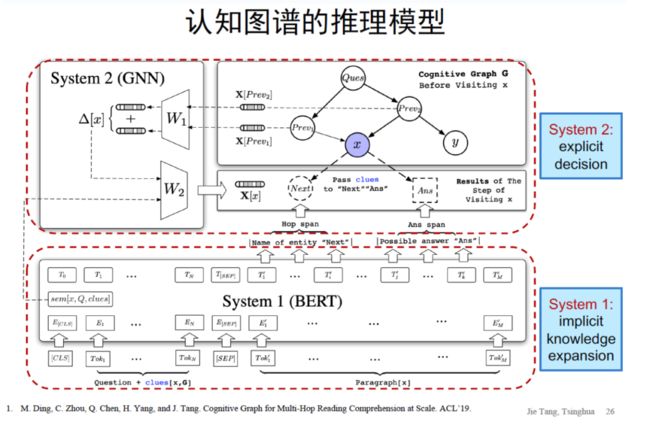

细分而言,对于 System1 实现,可以用 BERT 进行预训练,在预训练的基础上,我们可以做一个快速的匹配,而对于 System2 该如何实现?

此处,System2 可以用图神经网络把内容信息都结合进来,即每一个节点可以把上下文所有的信息进行整合,然后决策。如下图所述,基于神经网络、深度学习方法,实现了双系统理论的推理,继而两个系统可以互相协作,互相帮助。

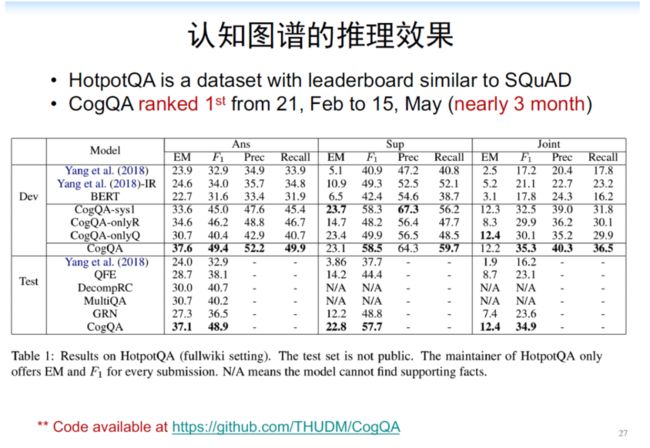

最终,该推理可以帮忙回答非常深的各种推理过程的问题。譬如,Hotpot QA 是一个专门面向多条推理问题回答的数据,当时我们将认知图谱的方法 Quality Graph 应用在 Hotpot QA 后,可以发现,在第一列得出的 F1 值,比 BERT 相对高度弱 50% 多,绝对高度是原来的结果 31%。另外,它的可解释能力也非常强。

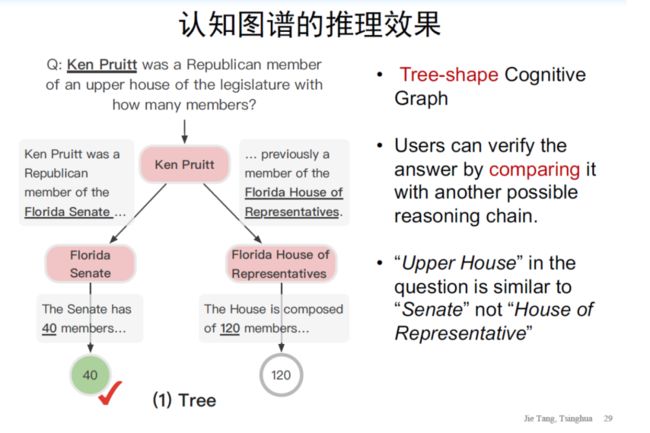

其实,人在认知过程中不一定是找到最佳的答案,而更需要的是,由推理过程,让人自己决定真正想要的答案。其中涉及到的推理过程可以用分支图或者树状图实现,如下图所示。围绕推理过程,还可以增强线索来帮助决策,如果答案不对也可以作溯源,解析并反诉答案为什么会推理错误,相当于是追诉的过程。

![]()

人工智能的挑战

立足于当下,探讨人工智能的下一步该何去何从?

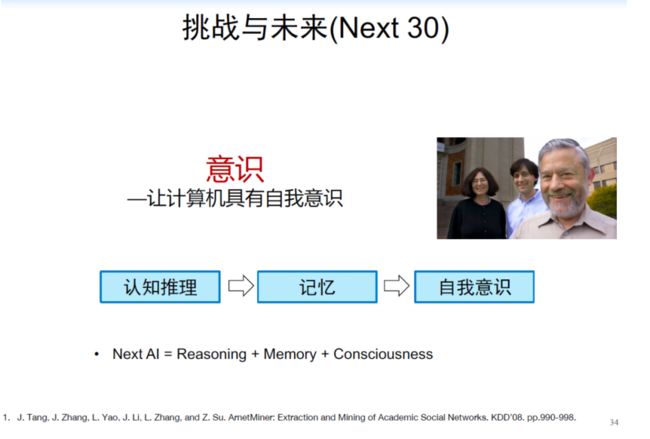

剖开本质,认知和推理必然是人工智能下十年的重点。之所以这么判定,是因为从原来的大数据到知识到智能,中间最为缺乏的就是推理过程,因此我们需要克服该推理过程的挑战。以万亿级的长时知识图谱为支撑,在推理的基础上,来实现下一个人工智能的认知智能。

以 30 年为周期,人工智能的再下一步将会是意识——让计算机具有自我意识。个人而言,我认为所谓有意识学习,就是有目标的机器学习,给定数据,训练一个模型,通过模型进行分类(决策),如当观看某物时,你的眼睛会迅速做出一个有意识的判断或决策,这相当于有意识学习输出是一个短期记忆模型。不过,该短期记忆模型比较简单,数据有限、无背景知识。

而无意识对应的是长期记忆模型,类似于半监督或无监督学习模型,或者当下比较流行的预训练和自监督学习。无意识处理对应多种长期记忆,所以无意识可以考虑多个不同的处理器,这些处理器之间可以有链接,也可以没有,很多时候是并行处理,但针对特定任务,比如有意识思考某个问题的时候,形成特定连接,包括无意识处理器(无监督模型)和有意识处理器(有监督模型)之间的连接,这里可以考虑成fine-tune。

当然连接权重可以通过外界反馈强化学习来实现。无意识处理器之间的连接以及和有意识处理器之间的连接可以类比为注意力机制。最后值得注意的是长期记忆的构造和实现,人脑记忆保存的是模型图,而不是概念图。每个长期记忆的都可能是一个模型,可以生成样本,具体学习方法,可以想象一下是一个层次聚类。通过这样就可以用有监督、无监督、强化、注意力、fine-tune来实现GWT模型。

更多精彩推荐

☞机器学习算法易受攻击?阿里“安全基建”这样应对AI的不安全

☞代码恒久远,GitHub 永流传

☞腾讯员工每天在岗不足 8 小时被辞?背后原因可能不止你看到的这些

☞5G:新基建的压舱石,如何为新基建按下“加速键”?

☞中国人工智能市场破 50 亿!你还不了解 AI 云服务吗?

☞员工导致Twitter陷入史诗级加密黑客风暴?官方回应来了

点分享点点赞点在看