(源码)群体智能优化算法之灰狼优化(Grey Wolf Optimizer,GWO)

![]()

获取更多资讯,赶快关注上面的公众号吧!

文章目录

- 第三十三章 灰狼优化(Grey Wolf Optimizer,GWO)

- 启发

- 数学模型和算法

- 社会等级

- 包围捕食

- 狩猎

- 攻击猎物(利用)

- 搜索猎物(探索)

- GWO算法

- 源码

第三十三章 灰狼优化(Grey Wolf Optimizer,GWO)

Grey Wolf Optimizer是Seyedali Mirjalili受大灰狼捕食策略的启发,于2014年提出的一种元启发式算法,主要模拟了搜索猎物、包围猎物和攻击猎物,源代码关注公众号后,回复"灰狼"或"GWO"获取。

启发

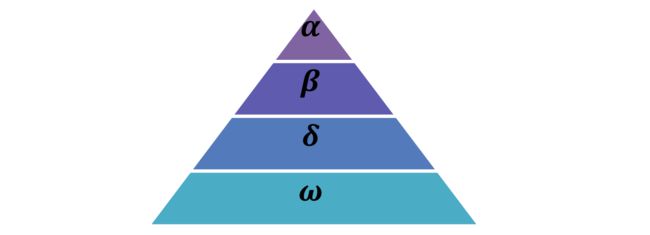

灰狼属于犬科动物,是食物链顶端的顶级掠食者,它们大多喜欢群居生活,每个种群平均5~12不等。特别有趣的是,它们有非常严格的社会等级,如下图所示。

领头狼(领导者)是一公一母,称为alphas(个人理解,之所以这么叫,是因为alpha是希腊字幕中的第一个,用来表示最前面的)。alpha狼主要负责决策狩猎、睡觉地点、起床时间等等,然后再将决策下达至整个种群,如果狼群垂下尾巴说明它们都认可。然而种群中也会存在民主行为,alpha狼也会听从种群中的其他狼。有趣的是,alpha狼不一定是最强壮的成员,但在管理团队方面是最好的。这说明一个狼群的组织和纪律远比它的力量重要。

第二层是beta。deta狼是从属狼,可公可母,用于辅助alpha狼制定决策或其他种群活动。当其中一只alpha狼去世或变老时,它就是alpha狼的最佳替补。beta狼应该遵从alpha狼,但也会命令其他低级别的狼,因而起到承上启下的作用。

最底层的是omega狼。它们扮演了"替罪羊"的角色(好惨),必须屈服于其他领头狼,进食时也是排在最后。看起来omega狼在狼群中并不是一个重要的个体,但是一旦失去omega狼,整个狼群就会面临内部争斗和问题。

如果一头狼既不是alpha,beta,也不是omega,就称为从属狼或delta狼。delta狼必须听从于alpha和beta狼,但会支配omega狼。侦察狼、守卫狼、老狼、捕食狼和看管狼都是这一类。侦察狼负责监视领地的边界,一旦有危险就向狼群发出警告;守卫狼保护和保证狼群的安全;老狼是从alpha或beta退下来的经验丰富的狼;捕食狼帮助alpha和beta捕猎并为狼群提供食物;看管狼负责照顾狼群中的老弱病残。

除此之外,群体狩猎是灰狼的另一个有趣的社会行为,主要包括以下几个阶段:

- 跟踪、追逐和接近猎物;

- 追捕、包围和骚扰猎物,直到它停止移动;

- 向猎物发起攻击。

数学模型和算法

首先给出社会等级、跟踪、包围和攻击猎物的数学模型,然后再提供完整的GWO算法。

社会等级

为了在设计GWO时对狼的社会等级进行数学建模,认为最合适的解是alpha( α \alpha α),那么第二和第三最优解分别表示为beta( β \beta β)和delta( δ \delta δ),而剩余其他解都假定为omega( ω \omega ω)。在GWO中,通过 α \alpha α、 β \beta β和 δ \delta δ来导引捕食(优化), ω \omega ω听从于这三种狼。

包围捕食

灰狼在捕食时会将猎物包围,使用下式进行表达这种行为:

D ⃗ = ∣ C ⃗ ⋅ X p → ( t ) − X ⃗ ( t ) ∣ (1) \vec{D}=|\vec{C} \cdot \overrightarrow{X_{p}}(t)-\vec{X}(t)|\tag{1} D=∣C⋅Xp(t)−X(t)∣(1)

X ⃗ ( t + 1 ) = X p → ( t ) − A ⃗ ⋅ D ⃗ (2) \vec{X}(t+1)=\overrightarrow{X_{p}}(t)-\vec{A} \cdot \vec{D}\tag{2} X(t+1)=Xp(t)−A⋅D(2)

其中 t t t表示当前迭代次数, A ⃗ \vec{A} A和 C ⃗ \vec{C} C为系数向量, X p → \overrightarrow{X_{p}} Xp是猎物的位置向量, X ⃗ \vec{X} X是灰狼的位置向量。

向量 A ⃗ \vec{A} A和 C ⃗ \vec{C} C的计算如下:

A ⃗ = 2 a ⃗ ⋅ r ⃗ 1 − a ⃗ (3) \vec{A}=2 \vec{a} \cdot \vec{r}_{1}-\vec{a}\tag{3} A=2a⋅r1−a(3)

C ⃗ = 2 ⋅ r 2 → (4) \vec{C}=2 \cdot \overrightarrow{r_{2}}\tag{4} C=2⋅r2(4)

其中 a ⃗ \vec{a} a的各个分量在迭代过程中线性地从2减少到0, r ⃗ 1 \vec{r}_{1} r1和 r 2 → \overrightarrow{r_{2}} r2为[0,1]之间的随机向量。

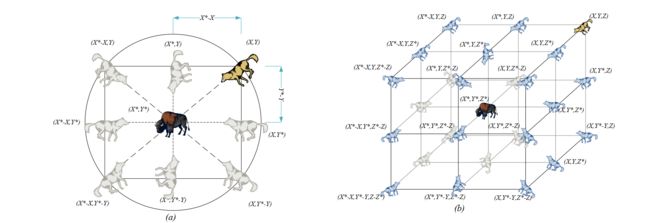

为了清楚地反映等式(1)和(2)的效果,图3(a)中显示了二维的位置向量以及可能的邻域,可以看出,灰狼的位置 ( X , Y ) (X,Y) (X,Y)可以根据猎物的位置 ( X ∗ , Y ∗ ) (X^*,Y^*) (X∗,Y∗)进行更新,通过调整 A ⃗ \vec{A} A和 C ⃗ \vec{C} C的值,可以在最优代理周围到达相对于当前位置的不同地方。例如,当 A ⃗ = ( 0 , 1 ) \vec{A}=(0,1) A=(0,1)和 C ⃗ = ( 1 , 1 ) \vec{C}=(1,1) C=(1,1)时,灰狼的新位置为 ( X ∗ − X , Y ∗ ) (X^*-X,Y^*) (X∗−X,Y∗)。三维空间中也是类似。注意,此处的两张图仅仅展示了 A ⃗ = ( 0 , 1 ) \vec{A}=(0,1) A=(0,1)和 C ⃗ = ( 1 , 1 ) \vec{C}=(1,1) C=(1,1)这一种情况,当随机向量 r 1 r_1 r1和 r 2 r_2 r2取不同的值时,灰狼可以到达任意两点之间的位置。同时还注意到, A A A的取值不同还会决定灰狼靠近还是远离猎物,后面再详细说明。

狩猎

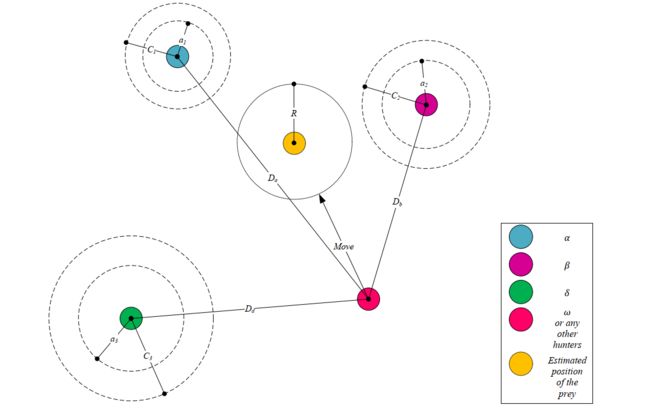

灰狼能够识别猎物的位置并包围它们,狩猎通常是是由alpha狼领导的,beta和和delta狼偶尔也会参与狩猎。然而,在一个抽象的搜索空间中,我们不知道最佳(猎物)的位置。为了在数学上模拟灰狼的狩猎行为,我们假设alpha(最佳候选解)、beta和delta狼对猎物的潜在位置有更好的了解。因此,我们保存到目前为止获得的前三个最佳解,并迫使其他搜索代理(包括omegas)根据最佳搜索代理的位置更新其位置。对此,提出以下公式:

D α → = ∣ C ⃗ 1 ⋅ X α → − X ⃗ ∣ , D β → = ∣ C ⃗ 2 ⋅ X β → − X ⃗ ∣ , D δ → = ∣ C 3 → ⋅ X δ → − X ⃗ ∣ (5) \overrightarrow{D_{\alpha}}=\left|\vec{C}_{1} \cdot \overrightarrow{X_{\alpha}}-\vec{X}\right|, \overrightarrow{D_{\beta}}=\left|\vec{C}_{2} \cdot \overrightarrow{X_{\beta}}-\vec{X}\right|, \overrightarrow{D_{\delta}}=|\overrightarrow{C_{3}} \cdot \overrightarrow{X_{\delta}}-\vec{X}|\tag{5} Dα=∣∣∣C1⋅Xα−X∣∣∣,Dβ=∣∣∣C2⋅Xβ−X∣∣∣,Dδ=∣C3⋅Xδ−X∣(5)

X 1 → = X α → − A 1 → ⋅ ( D α → ) , X 2 → = X β → − A 2 → ⋅ ( D β → ) , X 3 → = X δ → − A 3 → ⋅ ( D δ → ) 6 ) (() \overrightarrow{X_{1}}=\overrightarrow{X_{\alpha}}-\overrightarrow{A_{1}} \cdot(\overrightarrow{D_{\alpha}}), \overrightarrow{X_{2}}=\overrightarrow{X_{\beta}}-\overrightarrow{A_{2}} \cdot(\overrightarrow{D_{\beta}}), \overrightarrow{X_{3}}=\overrightarrow{X_{\delta}}-\overrightarrow{A_{3}} \cdot(\overrightarrow{D_{\delta}})\tag(6) X1=Xα−A1⋅(Dα),X2=Xβ−A2⋅(Dβ),X3=Xδ−A3⋅(Dδ)6)(()

X ⃗ ( t + 1 ) = X 1 → + X 2 → + X 3 → 3 (7) \vec{X}(t+1)=\frac{\overrightarrow{X_{1}}+\overrightarrow{X_{2}}+\overrightarrow{X_{3}}}{3}\tag{7} X(t+1)=3X1+X2+X3(7)

图4展示了2D空间中如何根据alpha,beta和delta进行代理位置的更新。可以看到,最终位置将是圆内的一个随机位置,该圆由alpha、beta和delta定义,换句话说,alpha、beta和delta狼对猎物的位置进行估计,而其他狼则再猎物周围随机更新它们的位置。

攻击猎物(利用)

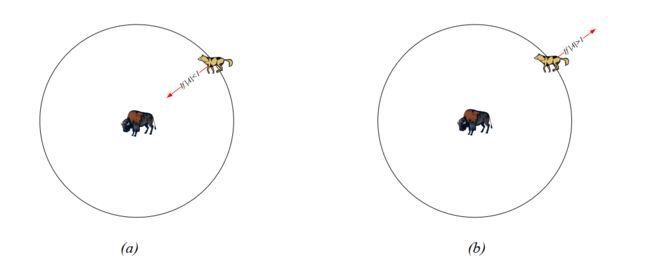

正如上面提到的,当猎物停止移动时,灰狼就会攻击它来完成狩猎。为了对接近猎物进行建模,需要不断降低 a ⃗ \vec a a的值,那么 A ⃗ \vec A A的波动范围也会降低。当 A ⃗ ∈ [ − 1 , 1 ] \vec A\in[-1,1] A∈[−1,1],搜索代理的下一位置可以是代理当前位置和猎物位置之间的任意位置。图5(a)表明当 ∣ A ∣ < 1 |A|<1 ∣A∣<1时,灰狼向猎物发起攻击。

搜索猎物(探索)

灰狼通常根据alpha、beta和delta狼的位置进行搜索,它们彼此分散寻找猎物,然后汇聚攻击猎物。为了数学上对分散建模,利用随机值大于1或小于-1的 A ⃗ \vec A A迫使搜索代理偏离猎物,从而保证了探索。图5(b)表明当 ∣ A ∣ > 1 |A|>1 ∣A∣>1时,迫使灰狼离开猎物,希望能找到更合适的猎物。另一个支持GWO进行探索的因素是 C ⃗ \vec C C,根据公式(4), C ⃗ \vec C C的取值范围为 [ 0 , 2 ] [0,2] [0,2],该分量为猎物提供随机权重,以随机强调(C>1)或弱化(C<1)

猎物在定义等式(1)中的距离时的作用。这有助于GWO在整个优化过程中表现出更随机的行为,有利于探索和避免局部最优。 C C C并不是和 A A A一样线性递减,特意要求 C C C在任何时候都提供随机值,以便不仅在初始迭代中强调探索,而且在最终迭代中也强调探索。

C C C向量也可以被认为是在自然界中障碍物对接近猎物的影响,一般来说,自然中的障碍出现在狼的捕猎路径上,实际上阻碍了它们快速、方便地接近猎物。这就是向量 C C C的作用。根据狼所处的位置,它可以随机地给猎物一个权重,从而让狼的捕食变得更加困难和遥远,反之亦然。

GWO算法

总之,搜索过程从在GWO算法中创建一个随机的灰狼种群(候选解)开始。在迭代过程中,alpha、beta和delta狼估计猎物可能的位置。每一个候选解更新它与猎物的距离。为了分别强调探索和利用,将参数 a a a从2降低到0。当 ∣ A ⃗ ∣ > 1 |\vec A|>1 ∣A∣>1时,候选解有偏离猎物的倾向,当 ∣ A ⃗ ∣ < 1 |\vec A|<1 ∣A∣<1时,候选解收敛于猎物。最后,当满足结束条件时终止GWO算法。GWO的伪代码如下。

初始化灰狼种群 X i ( i = 1 , 2 , . . . , n ) X_i(i=1,2,...,n) Xi(i=1,2,...,n)

初始化 a , A , C a,A,C a,A,C

计算每个搜索代理的适应度值

X α = X_{\alpha}= Xα=最优搜索代理

X β = X_{\beta}= Xβ=第二优搜索代理

X δ = X_{\delta}= Xδ=第三优搜索代理

while(t<最大迭代次数)

for 每个搜索代理

根据等式(7)更新当前代理的位置

end for

更新 a , A , C a,A,C a,A,C

计算所有搜索代理的适应度值

更新 X α X_{\alpha} Xα、 X β X_{\beta} Xβ、 X δ X_{\delta} Xδ

KaTeX parse error: Expected 'EOF', got '&' at position 1: &̲emsp; t=t+…

end while

return X α X_{\alpha} Xα

通过以下几点可以了解GWO在理论上是如何解决优化问题的:

- 所提出的社会等级有助于GWO在迭代过程中保存目前的最优解;

- 所提出的包围机制在解周围定义了一个圆形邻域,该邻域可以作为超球体扩展到更高维度;

- 随机参数 A A A和 C C C辅助候选解具有不同随机半径的超球体;

- 所提出的狩猎方法允许候选解确定猎物的可能位置;

- a a a和 A A A的适配保证了探索和利用;

- 参数 a a a和 A A A的自适应值使GWO在探索和利用之间实现平稳过渡;

- 随着 A A A的下降,一半迭代致力于探索( ∣ A ∣ ≥ 1 |A|≥1 ∣A∣≥1),另一半致力于利用( ∣ A ∣ < 1 |A|<1 ∣A∣<1);

- GWO只有两个主要参数需要调整( a a a和 C C C)。

源码

扫码关注后,回复"灰狼"或"GWO"获取。