1 问题

1.1 场景1

用户服务与订单服务部署在同一机子不同目录,一次下单流程设计用户服务与订单服务,但下单过程抛异常,为了定位异常(哪个服务产生的?具体代码行数?),要分别打开用户服务所在目录,查看各自的日志文件,然后定位问题。

1.2 场景2

由于业务压力,订单服务有多个实例,分别部署在多个不同服务器上,一次下单流程失败,确定由订单服务引起,为了定位异常,需要查看日志,但是由于负载均衡,无法确定该异常是哪台服务器打印的,因此只能逐一登录服务器,进行一一查看。

1.3 综述

场景1和场景2是分布式应用在日志采集上遇到的普遍问题,因为应用的分散,日志也被分散在不同服务器的不同目录上,这给开发定位问题带来了极大的不便。

2 解决方案

2.1 传统方案

2.1.1 手动查看

逐一登录服务器,然后执行命名监听日志文件,该方案费时费力,效率较为低下

tail -f trade.log

2.1.2 写数据库

需在主业务库外新建一套辅库,写入日志文件,日志写入可有以下几种方式,该方案侵入性较强,大量的日志输出日志库,日志库可能存在瓶颈,从而影响到业务。

- 代码或aop写入日志(不推荐,侵入性强);

- 日志框架配置输出到数据库(同样存在侵入性,当日志库挂掉,服务无法正常启动)。

2.2 elk

elk由elasticsearch、logstash和kibana三部分组件组成,官网https://www.elastic.co/cn/

- elasticsearch:搜索引擎,主要用来存储日志文件,可单机,可集群

- logstash:日志采集、过滤工具,主要采集日志,然后格式化,过滤后存储到elasticsearch

- kibana:可视化的web平台日志分析工具,主要用来分析elasticsearch上的日志

该方案的优点是,业界成熟的方案,性能高,方便后续的日志统一分析和查询,但缺点在于日志框架配置强依赖与elk,即日志框架配置中必须配置elk的部分,才能输出日志到elk,侵入性较强。

2.3 elk+filebeat

- filebeat:轻量级开源日志文件数据搜集器

-

工作流图

该方案的弥补了单elk的缺点,无项目配置的侵入。

3 环境搭建

本次搭建的elk版本统一为5.6.4版本,下载地址https://www.elastic.co/downloads/past-releases

3.1 elasticsearch搭建

- 下载

wget https://artifacts.elastic.co/downloads/elasticsearch/elasticsearch-5.6.4.zip

unzip elasticsearch-5.6.4.zip

mv elasticsearch-5.6.4 elasticsearch

cd elasticsearch

- 启动

./bin/elasticsearch -d

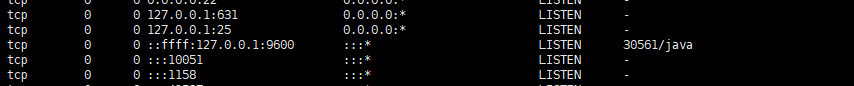

- 查看网络状态,验证服务启动

netstat -tunpl

-

使用elasticsearch-head插件查看

3.2 logstash搭建

- 下载

wget https://artifacts.elastic.co/downloads/logstash/logstash-5.6.4.zip

unzip logstash-5.6.4.zip

mv logstash-5.6.4 logstash

cd logstash

- 配置文件

vi config/logstash.conf

#输入

input {

beats {

port => 5044

}

}

#过滤

filter {

#nginx 日志过滤

if "nginx-accesslog" in [tags] {

grok {

match => { "message" => "%{HTTPDATE:timestamp}\|%{IP:remote_addr}\|%{IPORHOST:http_host}\|(?:%{DATA:http_x_forwarded_for}|-)\|%{DATA:request_method}\|%{DATA:request_uri}\|%{DATA:server_protocol}\|%{NUMBER:status}\|(?:%{NUMBER:body_bytes_sent}|-)\|(?:%{DATA:http_referer}|-)\|%{DATA:http_user_agent}\|(?:%{DATA:request_time}|-)\|"}

}

mutate {

convert => ["status","integer"]

convert => ["body_bytes_sent","integer"]

convert => ["request_time","float"]

}

geoip {

source=>"remote_addr"

}

date {

match => [ "timestamp","dd/MMM/YYYY:HH:mm:ss Z"]

}

useragent {

source=>"http_user_agent"

}

}

#logback日志过滤

if "sys-messages" in [tags] {

grok {

match => {"message" => "%{DATA:timestamp} %{LOGLEVEL:level} \[%{DATA:class} :%{INT:line}\] %{DATA:log_message}" }

}

date {

match => [ "timestamp", "MMM d HH:mm:ss" ]

}

}

#log4j2过滤

if "gateway-messages" in [tags] {

grok {

match => {"message" => "%{DATA:timestamp} \[%{DATA:log_pid}\] %{LOGLEVEL:level}- %{DATA:log_message}" }

}

date {

match => [ "timestamp", "MMM d HH:mm:ss" ]

}

}

}

#输出

output {

elasticsearch {

hosts => ["192.168.10.210:9200"]

index => "logstash-%{type}-%{+YYYY.MM.dd}"

document_type => "%{type}"

}

stdout { codec => rubydebug }

}

- 启动

./bin/logstash -f ./config/logstash.conf > /dev/null 2>&1 &

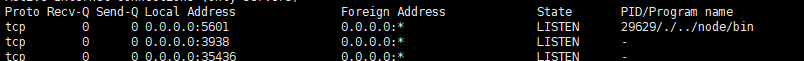

- 查看端口,验证服务已启动

netstat -tunpl

3.4 kibana搭建

- 下载

wget https://artifacts.elastic.co/downloads/kibana/kibana-5.6.4-linux-x86_64.tar.gz

tar -zxvf kibana-5.6.4-linux-x86_64.tar.gz

mv kibana-5.6.4-linux-x86_64 kibana

cd kibana

- 配置

vi ./config/kibana.yml

server.port: 5601

server.host: "0.0.0.0"

elasticsearch.url: "http://192.168.10.210:9200"

- 启动

./bin/kibana > /dev/null 2>&1 &

- 验证服务

netstat -tunpl

- 访问验证

http://192.168.10.210:5601/app/kibana

3.5 filebeat搭建

- 下载

wget https://artifacts.elastic.co/downloads/beats/filebeat/filebeat-5.6.4-linux-x86_64.tar.gz

tar -zxvf filebeat-5.6.4-linux-x86_64.tar.gz

mv filebeat-5.6.4-linux-x86_64 filebeat

cd filebeat

- 配置

filebeat.prospectors:

- input_type: log

paths:

- /opt/release/nginx/logs/access.log

tags: ["nginx-accesslog"]

document_type: nginxaccess

output.logstash:

hosts: ["192.168.10.210:5044"]

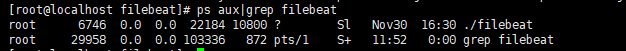

- 启动

./filebeat > /dev/null 2>&1 &

- 验证

ps aux|grep filebeat

4 使用

4.1 采集nginx日志

- nginx日志配置

log_format main $time_local | $remote_addr | $http_host | $http_x_forwarded_for | $request_method | $request_uri | $server_protocol | $status | $body_bytes_sent | $http_referer | $http_user_agent | $request_time |;

- nginx filebeat配置

filebeat.prospectors:

- input_type: log

paths:

- /opt/release/nginx/logs/access.log

tags: ["nginx-accesslog"]

document_type: nginxaccess

output.logstash:

hosts: ["192.168.10.210:5044"]

4.2 采集java日志

filebeat.prospectors:

#log4j2配置

- input_type: log

paths:

- /home/openapi/out.log

- /home/citizen/trade/out.log

tags: ["gateway-messages"]

document_type: gatewaymessages

multiline.pattern: '^[0-9]{2}:[0-9]{2}:[0-9]{2}.[0-9]{3}'

multiline.negate: true

multiline.match: after

#logback配置

- input_type: log

paths:

- /data/logs/*/*.log

tags: ["sys-messages"]

document_type: sysmessages

multiline.pattern: '^[0-9]{4}-[0-9]{2}-[0-9]{2}'

multiline.negate: true

multiline.match: after

#输出logstash

output.logstash:

hosts: ["192.168.10.210:5044"]

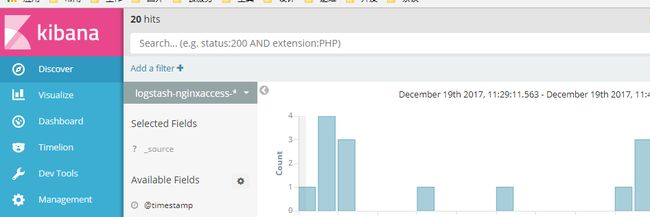

4.3 采集效果

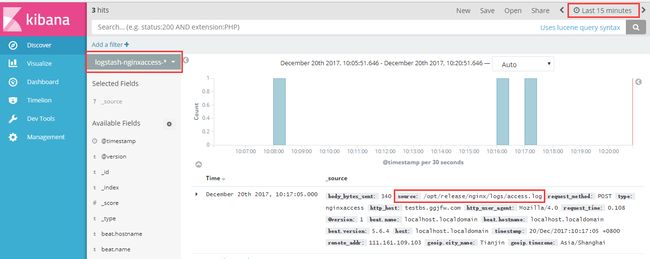

4.3.1 nginx日志收集与分析

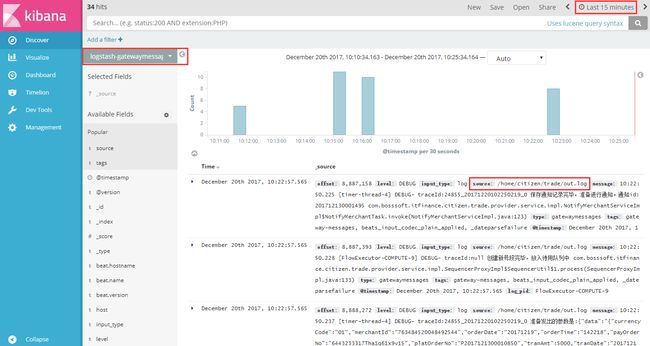

4.3.2 java日志收集与分析

5 引用

- http://shildon.leanote.com/post/%E6%90%AD%E5%BB%BAELK%E7%AC%94%E8%AE%B0

- https://www.iyunv.com/thread-354749-1-1.html

- http://www.dahouduan.com/2016/10/17/bigdata-filebeat-elasticsearch-kibana-elk/