- nosql数据库技术与应用知识点

皆过客,揽星河

NoSQLnosql数据库大数据数据分析数据结构非关系型数据库

Nosql知识回顾大数据处理流程数据采集(flume、爬虫、传感器)数据存储(本门课程NoSQL所处的阶段)Hdfs、MongoDB、HBase等数据清洗(入仓)Hive等数据处理、分析(Spark、Flink等)数据可视化数据挖掘、机器学习应用(Python、SparkMLlib等)大数据时代存储的挑战(三高)高并发(同一时间很多人访问)高扩展(要求随时根据需求扩展存储)高效率(要求读写速度快)

- 分享一个基于python的电子书数据采集与可视化分析 hadoop电子书数据分析与推荐系统 spark大数据毕设项目(源码、调试、LW、开题、PPT)

计算机源码社

Python项目大数据大数据pythonhadoop计算机毕业设计选题计算机毕业设计源码数据分析spark毕设

作者:计算机源码社个人简介:本人八年开发经验,擅长Java、Python、PHP、.NET、Node.js、Android、微信小程序、爬虫、大数据、机器学习等,大家有这一块的问题可以一起交流!学习资料、程序开发、技术解答、文档报告如需要源码,可以扫取文章下方二维码联系咨询Java项目微信小程序项目Android项目Python项目PHP项目ASP.NET项目Node.js项目选题推荐项目实战|p

- Spark 组件 GraphX、Streaming

叶域

大数据sparkspark大数据分布式

Spark组件GraphX、Streaming一、SparkGraphX1.1GraphX的主要概念1.2GraphX的核心操作1.3示例代码1.4GraphX的应用场景二、SparkStreaming2.1SparkStreaming的主要概念2.2示例代码2.3SparkStreaming的集成2.4SparkStreaming的应用场景SparkGraphX用于处理图和图并行计算。Graph

- 大数据毕业设计hadoop+spark+hive知识图谱租房数据分析可视化大屏 租房推荐系统 58同城租房爬虫 房源推荐系统 房价预测系统 计算机毕业设计 机器学习 深度学习 人工智能

2401_84572577

程序员大数据hadoop人工智能

做了那么多年开发,自学了很多门编程语言,我很明白学习资源对于学一门新语言的重要性,这些年也收藏了不少的Python干货,对我来说这些东西确实已经用不到了,但对于准备自学Python的人来说,或许它就是一个宝藏,可以给你省去很多的时间和精力。别在网上瞎学了,我最近也做了一些资源的更新,只要你是我的粉丝,这期福利你都可拿走。我先来介绍一下这些东西怎么用,文末抱走。(1)Python所有方向的学习路线(

- Spark集群的三种模式

MelodyYN

#Sparksparkhadoopbigdata

文章目录1、Spark的由来1.1Hadoop的发展1.2MapReduce与Spark对比2、Spark内置模块3、Spark运行模式3.1Standalone模式部署配置历史服务器配置高可用运行模式3.2Yarn模式安装部署配置历史服务器运行模式4、WordCount案例1、Spark的由来定义:Hadoop主要解决,海量数据的存储和海量数据的分析计算。Spark是一种基于内存的快速、通用、可

- Java中的大数据处理框架对比分析

省赚客app开发者

java开发语言

Java中的大数据处理框架对比分析大家好,我是微赚淘客系统3.0的小编,是个冬天不穿秋裤,天冷也要风度的程序猿!今天,我们将深入探讨Java中常用的大数据处理框架,并对它们进行对比分析。大数据处理框架是现代数据驱动应用的核心,它们帮助企业处理和分析海量数据,以提取有价值的信息。本文将重点介绍ApacheHadoop、ApacheSpark、ApacheFlink和ApacheStorm这四种流行的

- 写出渗透测试信息收集详细流程

卿酌南烛_b805

一、扫描域名漏洞:域名漏洞扫描工具有AWVS、APPSCAN、Netspark、WebInspect、Nmap、Nessus、天镜、明鉴、WVSS、RSAS等。二、子域名探测:1、dns域传送漏洞2、搜索引擎查找(通过Google、bing、搜索c段)3、通过ssl证书查询网站:https://myssl.com/ssl.html和https://www.chinassl.net/ssltools

- Spark MLlib模型训练—推荐算法 ALS(Alternative Least Squares)

不二人生

SparkML实战spark-ml推荐算法算法

SparkMLlib模型训练—推荐算法ALS(AlternativeLeastSquares)如果你平时爱刷抖音,或者热衷看电影,不知道有没有过这样的体验:这类影视App你用得越久,它就好像会读心术一样,总能给你推荐对胃口的内容。其实这种迎合用户喜好的推荐,离不开机器学习中的推荐算法。在今天这一讲,我们就结合两个有趣的电影推荐场景,为你讲解SparkMLlib支持的协同过滤与频繁项集算法电影推荐场

- Python基础知识进阶之正则表达式_头歌python正则表达式进阶

前端陈萨龙

程序员python学习面试

最后硬核资料:关注即可领取PPT模板、简历模板、行业经典书籍PDF。技术互助:技术群大佬指点迷津,你的问题可能不是问题,求资源在群里喊一声。面试题库:由技术群里的小伙伴们共同投稿,热乎的大厂面试真题,持续更新中。知识体系:含编程语言、算法、大数据生态圈组件(Mysql、Hive、Spark、Flink)、数据仓库、Python、前端等等。网上学习资料一大堆,但如果学到的知识不成体系,遇到问题时只是

- 分布式离线计算—Spark—基础介绍

测试开发abbey

人工智能—大数据

原文作者:饥渴的小苹果原文地址:【Spark】Spark基础教程目录Spark特点Spark相对于Hadoop的优势Spark生态系统Spark基本概念Spark结构设计Spark各种概念之间的关系Executor的优点Spark运行基本流程Spark运行架构的特点Spark的部署模式Spark三种部署方式Hadoop和Spark的统一部署摘要:Spark是基于内存计算的大数据并行计算框架Spar

- spark常用命令

我是浣熊的微笑

spark

查看报错日志:yarnlogsapplicationIDspark2-submit--masteryarn--classcom.hik.ReadHdfstest-1.0-SNAPSHOT.jar进入$SPARK_HOME目录,输入bin/spark-submit--help可以得到该命令的使用帮助。hadoop@wyy:/app/hadoop/spark100$bin/spark-submit--

- spark启动命令

学不会又听不懂

spark大数据分布式

hadoop启动:cd/root/toolssstart-dfs.sh,只需在hadoop01上启动stop-dfs.sh日志查看:cat/root/toolss/hadoop/logs/hadoop-root-datanode-hadoop03.outzookeeper启动:cd/root/toolss/zookeeperbin/zkServer.shstart,三台都要启动bin/zkServ

- 大数据领域的深度分析——AI是在帮助开发者还是取代他们?

阳爱铭

大数据与数据中台技术沉淀大数据人工智能后端数据库架构数据库开发etl工程师chatgpt

在大数据领域,生成式人工智能(AIGC)的应用正在迅速扩展,改变了数据科学家和开发者的工作方式。本文将从大数据的专业视角,探讨AI工具在这一领域的作用,以及它们是如何帮助开发者而非取代他们的。1.大数据领域的AI工具现状在大数据领域,AI工具已经取得了显著进展,以下是几款主要的AI工具及其功能和实际应用:ApacheSpark+MLlib:ApacheSpark是一个开源的分布式计算系统,广泛用于

- 大数据新视界 --大数据大厂之 Spark 性能优化秘籍:从配置到代码实践

青云交

大数据新视界Spark性能优化内存分配并行度存储级别shuffle减少算法优化代码实践数据读取广播变量数据倾斜Spark数据库

亲爱的朋友们,热烈欢迎你们来到青云交的博客!能与你们在此邂逅,我满心欢喜,深感无比荣幸。在这个瞬息万变的时代,我们每个人都在苦苦追寻一处能让心灵安然栖息的港湾。而我的博客,正是这样一个温暖美好的所在。在这里,你们不仅能够收获既富有趣味又极为实用的内容知识,还可以毫无拘束地畅所欲言,尽情分享自己独特的见解。我真诚地期待着你们的到来,愿我们能在这片小小的天地里共同成长,共同进步。本博客的精华专栏:Ja

- 编程常用命令总结

Yellow0523

LinuxBigData大数据

编程命令大全1.软件环境变量的配置JavaScalaSparkHadoopHive2.大数据软件常用命令Spark基本命令Spark-SQL命令Hive命令HDFS命令YARN命令Zookeeper命令kafka命令Hibench命令MySQL命令3.Linux常用命令Git命令conda命令pip命令查看Linux系统的详细信息查看Linux系统架构(X86还是ARM,两种方法都可)端口号命令L

- 【面试系列】Spark 高频面试题解答

野老杂谈

全网最全IT公司面试宝典面试spark职场和发展大数据

欢迎来到我的博客,很高兴能够在这里和您见面!欢迎订阅相关专栏:⭐️全网最全IT互联网公司面试宝典:收集整理全网各大IT互联网公司技术、项目、HR面试真题.⭐️AIGC时代的创新与未来:详细讲解AIGC的概念、核心技术、应用领域等内容。⭐️大数据平台建设指南:全面讲解从数据采集到数据可视化的整个过程,掌握构建现代化数据平台的核心技术和方法。⭐️《遇见Python:初识、了解与热恋》:涵盖了Pytho

- spark常见面试题

爱敲代码的小黑

spark大数据分布式

文章目录1.Spark的运行流程?2.Spark中的RDD机制理解吗?3.RDD的宽窄依赖4.DAG中为什么要划分Stage?5.Spark程序执行,有时候默认为什么会产生很多task,怎么修改默认task执行个数?6.RDD中reduceBykey与groupByKey哪个性能好,为什么?7.SparkMasterHA主从切换过程不会影响到集群已有作业的运行,为什么?8.SparkMaster使

- Spark面试题

golove666

面试题大全spark大数据分布式面试

Spark面试题1.Spark基础概念1.1解释Spark是什么以及它的主要特点Spark是什么?Spark的主要特点1.2描述Spark运行时架构和组件主要的Spark架构组件:1.3讲述Spark中的弹性分布式数据集(RDD)和数据帧(DataFrame)弹性分布式数据集(RDD)主要特征:创建和转换:使用场景:数据帧(DataFrame)主要特征:创建和操作:使用场景:RDD与DataFra

- 图计算:基于SparkGrpahX计算聚类系数

妙龄少女郭德纲

Spark图算法Scala聚类数据挖掘机器学习

图计算:基于SparkGrpahX计算聚类系数文章目录图计算:基于SparkGrpahX计算聚类系数一、什么是聚类系数二、基于SparkGraphX的聚类系数代码实现总结一、什么是聚类系数聚类系数(ClusteringCoefficient)是图计算和网络分析中的一个重要概念,用于衡量网络中节点的局部聚集程度。它有助于理解网络中节点之间的紧密程度和网络的结构特性。这是一种用来衡量图中节点聚类程度的

- 亦菲喊你来学机器学习(20) --PCA数据降维

方世恩

机器学习人工智能深度学习python算法sklearn

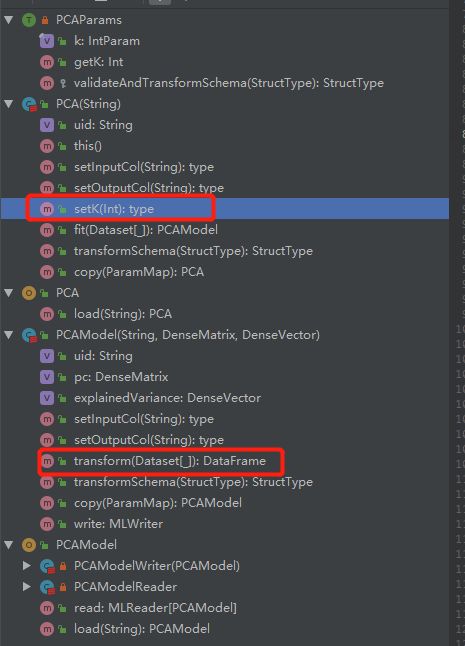

文章目录PCA数据降维一、降维二、优缺点三、参数四、实例应用1.读取文件2.分离特征和目标变量3.使用PCA进行降维4.打印特征所占百分比和具体比例5.PCA降维后的数据6.划分数据集7.训练逻辑回归模型8.评估模型性能总结PCA数据降维主成分分析(PrincipalComponentAnalysis,PCA)是一种常用的数据降维技术,它可以在保留数据集中最重要的特征的同时,减少数据的维度。PCA

- 2024年最全使用Python求解方程_python解方程(1),字节面试官迟到

2401_84569545

程序员python学习面试

最后硬核资料:关注即可领取PPT模板、简历模板、行业经典书籍PDF。技术互助:技术群大佬指点迷津,你的问题可能不是问题,求资源在群里喊一声。面试题库:由技术群里的小伙伴们共同投稿,热乎的大厂面试真题,持续更新中。知识体系:含编程语言、算法、大数据生态圈组件(Mysql、Hive、Spark、Flink)、数据仓库、Python、前端等等。网上学习资料一大堆,但如果学到的知识不成体系,遇到问题时只是

- Spark运行时架构

tooolik

spark架构大数据

目录一,Spark运行时架构二,YARN集群架构(一)YARN集群主要组件1、ResourceManager-资源管理器2、NodeManager-节点管理器3、Task-任务4、Container-容器5、ApplicationMaster-应用程序管理器6,总结(二)YARN集群中应用程序的执行流程三、SparkStandalone架构(一)client提交方式(二)cluster提交方式四、

- 使用SparkSql进行表的分析与统计

xingyuan8

大数据java

背景我们的数据挖掘平台对数据统计有比较迫切的需求,而Spark本身对数据统计已经做了一些工作,希望梳理一下Spark已经支持的数据统计功能,后期再进行扩展。准备数据在参考文献6中下载鸢尾花数据,此处格式为iris.data格式,先将data后缀改为csv后缀(不影响使用,只是为了保证后续操作不需要修改)。数据格式如下:SepalLengthSepalWidthPetalLengthPetalWid

- 13.Spark Core-Spark中广播变量和累加器

__元昊__

一、前述Spark中因为算子中的真正逻辑是发送到Executor中去运行的,所以当Executor中需要引用外部变量时,需要使用广播变量。累机器相当于统筹大变量,常用于计数,统计。二、具体原理1、广播变量广播变量理解图image注意事项1、能不能将一个RDD使用广播变量广播出去?不能,因为RDD是不存储数据的。可以将RDD的结果广播出去。2、广播变量只能在Driver端定义,不能在Executor

- 比较Spark与Flink

傲雪凌霜,松柏长青

大数据后端sparkflink大数据

ApacheSpark和ApacheFlink都是目前非常流行的大数据处理引擎,但它们在架构、处理模式、应用场景等方面有一些显著的区别。下面是二者的对比:1.处理模式Spark:主要支持批处理(BatchProcessing),也能通过SparkStreaming处理流式数据,但SparkStreaming本质上是通过微批(micro-batching)的方式处理流数据,延迟相对较高。SparkS

- Spark底层逻辑

傲雪凌霜,松柏长青

大数据后端spark大数据

ApacheSpark的底层逻辑可以从其核心概念、组件和执行流程等方面来理解。Spark提供了一个分布式数据处理框架,其底层逻辑基于批处理架构,能够在大规模集群中高效地处理数据。以下是Spark的底层逻辑的详细介绍:1.核心概念Spark的底层基于几个核心概念来实现分布式计算,包括:RDD(ResilientDistributedDataset,弹性分布式数据集):RDD是Spark最基础的数据抽

- Spark - 升级版数据源JDBC2

大猪大猪

在spark的数据源中,只支持Append,Overwrite,ErrorIfExists,Ignore,这几种模式,但是我们在线上的业务几乎全是需要upsert功能的,就是已存在的数据肯定不能覆盖,在mysql中实现就是采用:ONDUPLICATEKEYUPDATE,有没有这样一种实现?官方:不好意思,不提供,dounine:我这有呀,你来用吧。哈哈,为了方便大家的使用我已经把项目打包到mave

- PySpark

静听山水

Sparkspark

PySpark的本质确实是Python的一个接口层,它允许你使用Python语言来编写ApacheSpark应用程序。通过这个接口,你可以利用Spark强大的分布式计算能力,同时享受Python的易用性和灵活性。1、PySpark的工作原理PySpark的工作原理可以概括为以下几个步骤:编写Python代码:开发者使用Python语法来编写Spark应用程序。这些程序通常涉及创建RDDs(弹性分布

- Ubuntu的ssh

请不要问我是谁

安装sshsudoapt-getupdatesudoapt-getinstallopenssh-server检测ssh是否启动sudops-e|grepssh创建root用户sudopasswdroot配置本机无密码ssh登录cd/home/spark0ssh-keygen-trsa-P""cat.ssh/id_rsa.pub>>.ssh/authorized_keyschmod600.ssh/a

- 2024年大数据最新实时数仓之实时数仓架构(Hudi)

2401_84185556

程序员大数据架构

技术框架Kafka:用于接入数据源;FlinkCDC:如果直接接入业务数据源可以考虑CDC方式,如果通过Kafka缓冲接入业务数据可以忽略;Flink:用于数据ETL,包括接入数据、处理数据及输出数据全链路数据计算任务;Spark:用于数据ETL,包括处理数据及输出数据全链路数据计算任务;Hudi:湖仓一体数据管理框架,用来管理模型数据,包括ODS/DWD/DWS/DIM/ADS等;Doris:O

- redis学习笔记——不仅仅是存取数据

Everyday都不同

returnSourceexpire/delincr/lpush数据库分区redis

最近项目中用到比较多redis,感觉之前对它一直局限于get/set数据的层面。其实作为一个强大的NoSql数据库产品,如果好好利用它,会带来很多意想不到的效果。(因为我搞java,所以就从jedis的角度来补充一点东西吧。PS:不一定全,只是个人理解,不喜勿喷)

1、关于JedisPool.returnSource(Jedis jeids)

这个方法是从red

- SQL性能优化-持续更新中。。。。。。

atongyeye

oraclesql

1 通过ROWID访问表--索引

你可以采用基于ROWID的访问方式情况,提高访问表的效率, , ROWID包含了表中记录的物理位置信息..ORACLE采用索引(INDEX)实现了数据和存放数据的物理位置(ROWID)之间的联系. 通常索引提供了快速访问ROWID的方法,因此那些基于索引列的查询就可以得到性能上的提高.

2 共享SQL语句--相同的sql放入缓存

3 选择最有效率的表

- [JAVA语言]JAVA虚拟机对底层硬件的操控还不完善

comsci

JAVA虚拟机

如果我们用汇编语言编写一个直接读写CPU寄存器的代码段,然后利用这个代码段去控制被操作系统屏蔽的硬件资源,这对于JVM虚拟机显然是不合法的,对操作系统来讲,这样也是不合法的,但是如果是一个工程项目的确需要这样做,合同已经签了,我们又不能够这样做,怎么办呢? 那么一个精通汇编语言的那种X客,是否在这个时候就会发生某种至关重要的作用呢?

&n

- lvs- real

男人50

LVS

#!/bin/bash

#

# Script to start LVS DR real server.

# description: LVS DR real server

#

#. /etc/rc.d/init.d/functions

VIP=10.10.6.252

host='/bin/hostname'

case "$1" in

sta

- 生成公钥和私钥

oloz

DSA安全加密

package com.msserver.core.util;

import java.security.KeyPair;

import java.security.PrivateKey;

import java.security.PublicKey;

import java.security.SecureRandom;

public class SecurityUtil {

- UIView 中加入的cocos2d,背景透明

374016526

cocos2dglClearColor

要点是首先pixelFormat:kEAGLColorFormatRGBA8,必须有alpha层才能透明。然后view设置为透明glView.opaque = NO;[director setOpenGLView:glView];[self.viewController.view setBackgroundColor:[UIColor clearColor]];[self.viewControll

- mysql常用命令

香水浓

mysql

连接数据库

mysql -u troy -ptroy

备份表

mysqldump -u troy -ptroy mm_database mm_user_tbl > user.sql

恢复表(与恢复数据库命令相同)

mysql -u troy -ptroy mm_database < user.sql

备份数据库

mysqldump -u troy -ptroy

- 我的架构经验系列文章 - 后端架构 - 系统层面

agevs

JavaScriptjquerycsshtml5

系统层面:

高可用性

所谓高可用性也就是通过避免单独故障加上快速故障转移实现一旦某台物理服务器出现故障能实现故障快速恢复。一般来说,可以采用两种方式,如果可以做业务可以做负载均衡则通过负载均衡实现集群,然后针对每一台服务器进行监控,一旦发生故障则从集群中移除;如果业务只能有单点入口那么可以通过实现Standby机加上虚拟IP机制,实现Active机在出现故障之后虚拟IP转移到Standby的快速

- 利用ant进行远程tomcat部署

aijuans

tomcat

在javaEE项目中,需要将工程部署到远程服务器上,如果部署的频率比较高,手动部署的方式就比较麻烦,可以利用Ant工具实现快捷的部署。这篇博文详细介绍了ant配置的步骤(http://www.cnblogs.com/GloriousOnion/archive/2012/12/18/2822817.html),但是在tomcat7以上不适用,需要修改配置,具体如下:

1.配置tomcat的用户角色

- 获取复利总收入

baalwolf

获取

public static void main(String args[]){

int money=200;

int year=1;

double rate=0.1;

&

- eclipse.ini解释

BigBird2012

eclipse

大多数java开发者使用的都是eclipse,今天感兴趣去eclipse官网搜了一下eclipse.ini的配置,供大家参考,我会把关键的部分给大家用中文解释一下。还是推荐有问题不会直接搜谷歌,看官方文档,这样我们会知道问题的真面目是什么,对问题也有一个全面清晰的认识。

Overview

1、Eclipse.ini的作用

Eclipse startup is controlled by th

- AngularJS实现分页功能

bijian1013

JavaScriptAngularJS分页

对于大多数web应用来说显示项目列表是一种很常见的任务。通常情况下,我们的数据会比较多,无法很好地显示在单个页面中。在这种情况下,我们需要把数据以页的方式来展示,同时带有转到上一页和下一页的功能。既然在整个应用中这是一种很常见的需求,那么把这一功能抽象成一个通用的、可复用的分页(Paginator)服务是很有意义的。

&nbs

- [Maven学习笔记三]Maven archetype

bit1129

ArcheType

archetype的英文意思是原型,Maven archetype表示创建Maven模块的模版,比如创建web项目,创建Spring项目等等.

mvn archetype提供了一种命令行交互式创建Maven项目或者模块的方式,

mvn archetype

1.在LearnMaven-ch03目录下,执行命令mvn archetype:gener

- 【Java命令三】jps

bit1129

Java命令

jps很简单,用于显示当前运行的Java进程,也可以连接到远程服务器去查看

[hadoop@hadoop bin]$ jps -help

usage: jps [-help]

jps [-q] [-mlvV] [<hostid>]

Definitions:

<hostid>: <hostname>[:

- ZABBIX2.2 2.4 等各版本之间的兼容性

ronin47

zabbix更新很快,从2009年到现在已经更新多个版本,为了使用更多zabbix的新特性,随之而来的便是升级版本,zabbix版本兼容性是必须优先考虑的一点 客户端AGENT兼容

zabbix1.x到zabbix2.x的所有agent都兼容zabbix server2.4:如果你升级zabbix server,客户端是可以不做任何改变,除非你想使用agent的一些新特性。 Zabbix代理(p

- unity 3d还是cocos2dx哪个适合游戏?

brotherlamp

unity自学unity教程unity视频unity资料unity

unity 3d还是cocos2dx哪个适合游戏?

问:unity 3d还是cocos2dx哪个适合游戏?

答:首先目前来看unity视频教程因为是3d引擎,目前对2d支持并不完善,unity 3d 目前做2d普遍两种思路,一种是正交相机,3d画面2d视角,另一种是通过一些插件,动态创建mesh来绘制图形单元目前用的较多的是2d toolkit,ex2d,smooth moves,sm2,

- 百度笔试题:一个已经排序好的很大的数组,现在给它划分成m段,每段长度不定,段长最长为k,然后段内打乱顺序,请设计一个算法对其进行重新排序

bylijinnan

java算法面试百度招聘

import java.util.Arrays;

/**

* 最早是在陈利人老师的微博看到这道题:

* #面试题#An array with n elements which is K most sorted,就是每个element的初始位置和它最终的排序后的位置的距离不超过常数K

* 设计一个排序算法。It should be faster than O(n*lgn)。

- 获取checkbox复选框的值

chiangfai

checkbox

<title>CheckBox</title>

<script type = "text/javascript">

doGetVal: function doGetVal()

{

//var fruitName = document.getElementById("apple").value;//根据

- MySQLdb用户指南

chenchao051

mysqldb

原网页被墙,放这里备用。 MySQLdb User's Guide

Contents

Introduction

Installation

_mysql

MySQL C API translation

MySQL C API function mapping

Some _mysql examples

MySQLdb

- HIVE 窗口及分析函数

daizj

hive窗口函数分析函数

窗口函数应用场景:

(1)用于分区排序

(2)动态Group By

(3)Top N

(4)累计计算

(5)层次查询

一、分析函数

用于等级、百分点、n分片等。

函数 说明

RANK() &nbs

- PHP ZipArchive 实现压缩解压Zip文件

dcj3sjt126com

PHPzip

PHP ZipArchive 是PHP自带的扩展类,可以轻松实现ZIP文件的压缩和解压,使用前首先要确保PHP ZIP 扩展已经开启,具体开启方法就不说了,不同的平台开启PHP扩增的方法网上都有,如有疑问欢迎交流。这里整理一下常用的示例供参考。

一、解压缩zip文件 01 02 03 04 05 06 07 08 09 10 11

- 精彩英语贺词

dcj3sjt126com

英语

I'm always here

我会一直在这里支持你

&nb

- 基于Java注解的Spring的IoC功能

e200702084

javaspringbeanIOCOffice

- java模拟post请求

geeksun

java

一般API接收客户端(比如网页、APP或其他应用服务)的请求,但在测试时需要模拟来自外界的请求,经探索,使用HttpComponentshttpClient可模拟Post提交请求。 此处用HttpComponents的httpclient来完成使命。

import org.apache.http.HttpEntity ;

import org.apache.http.HttpRespon

- Swift语法之 ---- ?和!区别

hongtoushizi

?swift!

转载自: http://blog.sina.com.cn/s/blog_71715bf80102ux3v.html

Swift语言使用var定义变量,但和别的语言不同,Swift里不会自动给变量赋初始值,也就是说变量不会有默认值,所以要求使用变量之前必须要对其初始化。如果在使用变量之前不进行初始化就会报错:

var stringValue : String

//

- centos7安装jdk1.7

jisonami

jdkcentos

安装JDK1.7

步骤1、解压tar包在当前目录

[root@localhost usr]#tar -xzvf jdk-7u75-linux-x64.tar.gz

步骤2:配置环境变量

在etc/profile文件下添加

export JAVA_HOME=/usr/java/jdk1.7.0_75

export CLASSPATH=/usr/java/jdk1.7.0_75/lib

- 数据源架构模式之数据映射器

home198979

PHP架构数据映射器datamapper

前面分别介绍了数据源架构模式之表数据入口、数据源架构模式之行和数据入口数据源架构模式之活动记录,相较于这三种数据源架构模式,数据映射器显得更加“高大上”。

一、概念

数据映射器(Data Mapper):在保持对象和数据库(以及映射器本身)彼此独立的情况下,在二者之间移动数据的一个映射器层。概念永远都是抽象的,简单的说,数据映射器就是一个负责将数据映射到对象的类数据。

&nb

- 在Python中使用MYSQL

pda158

mysqlpython

缘由 近期在折腾一个小东西须要抓取网上的页面。然后进行解析。将结果放到

数据库中。 了解到

Python在这方面有优势,便选用之。 由于我有台

server上面安装有

mysql,自然使用之。在进行数据库的这个操作过程中遇到了不少问题,这里

记录一下,大家共勉。

python中mysql的调用

百度之后能够通过MySQLdb进行数据库操作。

- 单例模式

hxl1988_0311

java单例设计模式单件

package com.sosop.designpattern.singleton;

/*

* 单件模式:保证一个类必须只有一个实例,并提供全局的访问点

*

* 所以单例模式必须有私有的构造器,没有私有构造器根本不用谈单件

*

* 必须考虑到并发情况下创建了多个实例对象

* */

/**

* 虽然有锁,但是只在第一次创建对象的时候加锁,并发时不会存在效率

- 27种迹象显示你应该辞掉程序员的工作

vipshichg

工作

1、你仍然在等待老板在2010年答应的要提拔你的暗示。 2、你的上级近10年没有开发过任何代码。 3、老板假装懂你说的这些技术,但实际上他完全不知道你在说什么。 4、你干完的项目6个月后才部署到现场服务器上。 5、时不时的,老板在检查你刚刚完成的工作时,要求按新想法重新开发。 6、而最终这个软件只有12个用户。 7、时间全浪费在办公室政治中,而不是用在开发好的软件上。 8、部署前5分钟才开始测试。