SIFT算法特征描述子构建---关键点定位原理及代码

0.引言

sift针对局部特征进行特征提取,在尺度空间寻找极值点,提取位置,尺度,旋转不变量,生成特征描述子。

总共分四个步骤:

- 尺度金字塔生成

- 关键点/极值点提取

- 生成梯度直方图

- 特征描述子构建

step2 关键点/极值点提取

2.1 关键点位置初步探查

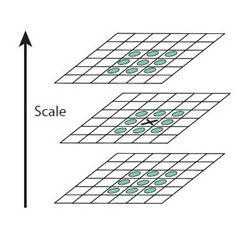

生成DOG金字塔后,要找到DOG空间中的局部极值点。第一步首先根据DOG空间内,各点响应大小检测和筛选极值点。

选择策略如下:

中间的检测点和它同尺度的8个相邻点和上下相邻尺度对应的9×2个点共26个点比较,以确保在尺度空间和二维图像空间都检测到极值点。

由于要在相邻尺度进行比较,高斯差分金子塔S+2层,头尾两层无法计算,因此,定义的INTERVALS层数就是指检测极值点的层数。

bool isExtremum(int x,int y,const vector当然这样产生离散空间的极值点并不全都是稳定的特征点,因为某些极值点响应较弱(对比度低),同时DOG算子会产生较强的边缘响应。为了解决这两个问题,需要对极值点进行插值和筛选。

2.2 关键点插值定位修正和边缘响应去除

2.2.1位置修正及去除低响应

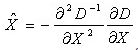

插值需要将离散的图像表达式,表达为连续的函数。以下通过拟合三维二次函数(二阶的泰勒展开式)来精确确定关键点的位置和尺度。

![]()

此处,为了求此公式,需要提前定义好计算逆矩阵,二阶偏导,一阶偏导 的函数。

/*************************************************************************************************************************

*模块说明:

* 求偏差量预备工作 【1】返回第index层的金字塔在y行x列的值

*功能说明:

* PryAt()---At:在该层y行x列的值

**************************************************************************************************************************/

pixel_t PyrAt(const vector<Mat>& pyr, int index, int x, int y)

{

pixel_t *data = (pixel_t*)pyr[index].data;

pixel_t val = *(data + y*pyr[index].cols + x);

return val;

}

#define At(index, x, y) (PyrAt(dog_pyr, (index), (x), (y)))

/*************************************************************************************************************************

*模块说明:

* 求偏差量预备工作,【2】对x,y,sigma的一阶偏导存入dx[3]

*功能说明:

* 使用节点的一阶中心差分近似导数, 取最小h=1时,最精确

* f'(xi)=(f(xi+h)-f(xi-h))/2h

* f'(yi)=(f(yi+h)-f(yi-h))/2h

* f'(si)=(f(si+h)-f(si-h))/2h

**************************************************************************************************************************/

void DerivativeOf3D(int x,int y,const vector<Mat>& dog_pyr,int index,double *dx)

{

dx[0] = (double)(At(index, x + 1, y) - At(index, x - 1, y)) / 2.0;

dx[1] = (double)(At(index, x, y + 1) - At(index, x, y - 1)) / 2.0;

dx[2] = (double)(At(index + 1, x, y) - At(index - 1, x, y)) / 2.0;

}

/*************************************************************************************************************************

*模块说明:

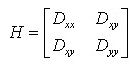

* 求偏差量预备工作,【3】对x,y,sigma的二阶偏导存入Hat(3*3),对称阵

* | Dxx Dxy Dxs |

* | Dyx Dxy Dys |

* | Dsx Dsy Dss |

*功能说明:

* 使用节点的一阶中心差分近似导数, 取最小h=1时,最精确

* Dxx=f''(xi)=(f(xi+h)+f(xi-h)-2*f(xi))/h^2

* Dxy=f''(yi)=(f(yi+h)+f(yi-h)-2*f(yi))/h^2

* Dss=f''(si)=(f(si+h)+f(si-h)-2*f(si)))/h^2

*

* Dyx=Dxy=f''(xi)(yi)=(f(xi+h,yi+h)+f(xi-h,yi-h)-f(xi+h,yi-h)-f(xi-h,yi+h))/4*h

**************************************************************************************************************************/

#define Hat(i,j) (*(H+3*(i)+(j)))

void Hessian3D(int x, int y, const vector<Mat>& dog_pyr, int index, double*H)

{

Hat(0, 0) = At(index, x + 1, y) + At(index, x - 1, y) - 2 * At(index, x, y);//Dxx

Hat(1, 1) = At(index, x, y + 1) + At(index, x, y - 1) - 2 * At(index, x, y);//Dyy

Hat(1, 1) = At(index + 1, x, y) + At(index - 1, x, y) - 2 * At(index, x, y);//Dss

Hat(1, 0) = Hat(0, 1) = (At(index, x + 1, y + 1) + At(index, x - 1, y - 1) - At(index, x + 1, y - 1) - At(index, x - 1, y + 1)) / 4.0;//Dxy

Hat(2, 0) = Hat(0, 2) = (At(index + 1, x + 1, y) + At(index - 1, x - 1, y) - At(index - 1, x + 1, y) - At(index + 1, x - 1, y)) / 4.0;//Dxs

Hat(2, 1) = Hat(1, 2) = (At(index + 1, x, y + 1) + At(index - 1, x, y - 1) - At(index + 1, x, y - 1) - At(index - 1, x, y + 1)) / 4.0;//Dsy

}

/*************************************************************************************************************************

*模块说明:

* 三阶矩阵求逆

**************************************************************************************************************************/

#define HIat(i, j) (*(H_inve+3*(i)+j))

bool Inverse3D(const double *H,double *H_inve)

{

//行列式

double A =Hat(0, 0)*Hat(1, 1)*Hat(2, 2)

+ Hat(0, 1)*Hat(1, 2)*Hat(2, 0)

+ Hat(0, 2)*Hat(1, 0)*Hat(2, 1)

- Hat(0, 0)*Hat(1, 2)*Hat(2, 1)

- Hat(0, 1)*Hat(1, 0)*Hat(2, 2)

- Hat(0, 2)*Hat(1, 1)*Hat(2, 0);

if (fabs(A)<1e-10) return false;

HIat(0, 0) = Hat(1, 1) * Hat(2, 2) - Hat(2, 1)*Hat(1, 2);

HIat(0, 1) = -(Hat(0, 1) * Hat(2, 2) - Hat(2, 1) * Hat(0, 2));

HIat(0, 2) = Hat(0, 1) * Hat(1, 2) - Hat(0, 2)*Hat(1, 1);

//伴随矩阵第二行

HIat(1, 0) = Hat(1, 2) * Hat(2, 0) - Hat(2, 2)*Hat(1, 0);

HIat(1, 1) = -(Hat(0, 2) * Hat(2, 0) - Hat(0, 0) * Hat(2, 2));

HIat(1, 2) = Hat(0, 2) * Hat(1, 0) - Hat(0, 0)*Hat(1, 2);

//伴随矩阵第三行

HIat(2, 0) = Hat(1, 0) * Hat(2, 1) - Hat(1, 1)*Hat(2, 0);

HIat(2, 1) = -(Hat(0, 0) * Hat(2, 1) - Hat(0, 1) * Hat(2, 0));

HIat(2, 2) = Hat(0, 0) * Hat(1, 1) - Hat(0, 1)*Hat(1, 0);

for (int i = 0; i < 9; i++)

{

*(H_inve + i) /= A;

}

return true;

}这样就可以计算偏差量了。

/*************************************************************************************************************************

*模块说明:计算x,y,sigma 的偏差量x^、y^、sigma^

*

*模块内容 1.x^=-(Dxx*dx+Dxy*dy+Dxs*ds) DOG函数拟合函数的逆矩阵的二阶和拟合函数一阶(为什么这个公式)

**************************************************************************************************************************/

void GetoffsetX(int x, int y, const vector<Mat>& dog_pyr, int index, double* offset_x)

{

//求一阶偏导

double dx[3];

DerivativeOf3D(x, y, dog_pyr, index, dx);

//求二阶偏导

double H[9], H_inve[9] = {0};

Hessian3D(x, y, dog_pyr, index, H);

if (Inverse3D(H, H_inve))

{

for (int i = 0; i < 3; i++)

{

offset_x[i] = 0.0;

for (int j = 0; j < 3; j++)

{

offset_x[i] += H_inve[i * 3 + j] * dx[j];

}

offset_x[i]=-offset_x[i];

}

}

else

cout << "无海森逆矩阵" << endl;

得到偏移量后,首先判断x,y,sigma任意维度的偏移量是否超过0.5,其次论文中拟合的迭代次数为5次。另外,对比度小于0.03的 极值点也要去除。

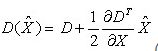

极值点处的值计算公式为:

//2.D(x^)=D+0.5*D'^T(x)*x^=D()+0.5*(Dx*offset[0] +Dy* offset[1]+Ds* offset[2])

//计算D(x^)

double GetFabsDx(int x,int y,const vector整个筛选并保存关键点如下:

/*************************************************************************************************************************

*模块说明:

* 模块四的第二步:修正极值点,删除不稳定的点

*功能说明:

* 1--根据高斯差分函数产生的极值点并不全都是稳定的特征点,因为某些极值点的响应较弱,而且DOG算子会产生较强的边缘响应

* 2--以上方法检测到的极值点是离散空间的极值点,下面通过拟合三维二次函数来精确定位关键点的位置和尺度,同时去除对比度

* 低和不稳定的边缘响应点(因为DOG算子会产生较强的边缘响应),以增强匹配的稳定性、提高抗噪声的能力。

* 3--修正极值点,删除不稳定点,|D(x)| < 0.03 Lowe 2004

**************************************************************************************************************************/

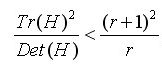

Keypoint* InterpolationExtremum(int x ,int y, const vector2.2.2边缘响应去除

为了剔除边缘响应点,需要让下比值小于一定的阈值

)成立时将关键点保留,反之剔除。

)成立时将关键点保留,反之剔除。

其中,在Lowe的文章中,取r=10。在Lowe的文章中,取r=10。

bool passEdgeResponse(int x,int y,vector2.2.3 关键点生成保存

通过调用上述过程函数,将关键点位置尺度信息保存。

关键点数据结构:

struct Keypoint

{

int octave; //【1】关键点所在组

int interval; //【2】关键点所在层

double offset_interval; //【3】调整后层的增量(是3/2吗,怎么是double?)

int x, y; //【4】x,y坐标,根据octave和interval可取的层内图像(是指所在组层?)

double scale; //【5】空间尺度坐标scale = sigma0*pow(2.0, o+s/S)

double dx, dy; //【6】特征点坐标,该坐标被缩放成原图像大小

double offset_x, offset_y;

//============================================================

//特征描述子

//============================================================

double octave_scale; //【1】offset_i

double ori; //【2】方向

double descriptor[FEATURE_ELEMENT_LENTH];//【3】特征描述子

int descr_length;

double val; //【4】极值

};保存函数:

void DetectionLocalExtrema(vector2.2.4 尺度

void CalculateScale(vector