- 郎朗大婚娶公主:所有光环的背后,都是十年如一日的自律

简小尘

近日,关于郎朗大婚的新闻上了热搜,看了新娘的照片,既有天使般的面容,更有魔鬼般的身材,关键是人家还身世好,又有才华,这真的是让所有男人羡慕嫉妒恨哪。有些人不禁会想,“凭什么郎朗的人生就象开挂了一样,可我却每天都活得这么狼狈!”其实,每个开挂的人生背后,都是苦行僧般的自律。01欲戴王冠,必承其重。练琴不能只靠兴趣,更需要自律!我们先来看一下朗朗在小时候的作息时间表:早晨5:45起床,练琴1小时。中午

- 教育

用心灵温暖心灵

@陈春丽长期学习班冯倩。今天一早就听到说高职合并,取消中专教育的教育信息。感觉是虽然知道,再听还是吓一跳。国家重视职业教育为何还要取消中专技术学校的教育?再听高中就要进行技术教育了,一部分人学习好继续努力学习考大学,一部分人在高中就可以进行职业教育接受职业教育了还要中专技术教育学校干什么呢!a有些职业教育学校转型升级快,不是孩子上完给找工作,而是学校帮孩子创业,我觉得是不错的方向!新闻新你得实时更

- 厉国刚:新闻学与传播学到底有何区别

微观大道

厉国刚:新闻学与传播学到底有何区别头几天,有人在知乎上问我:新闻学与传播学到底有何区别。他是一位想要跨专业考研的学生,对新闻传播学学科可谓了解甚少,甚至一头雾水,想要让我帮他解释解释。在研究生学硕层面,新闻传播学是一级学科,分成新闻学、传播学这两个二级学科。有些高校,还自设了广告学、出版发行学等其他二级学科,但从官方角度,新闻传播学一级学科下,正统的就是那两个二级学科。招生时,一般会按一级学科招,

- 【高中数学/三角函数/判别式法求极值】已知:实数a,b满足a^2/4-b^2=1 求:3a^2+2ab的最小值

普兰店拉马努金

高中数学之三角函数高中数学三角函数判别式

【问题】已知:实数a,b满足a^2/4-b^2=1求:3a^2+2ab的最小值【来源】App"网易新闻"中up主“我服子佩”的数学视频专辑,据其称是北京市某年的竞赛题。【解答】由a^2/4-b^2=1,联想到secθ^2-tanθ^2=1故设a/2=1/cosθ,b=sinθ/cosθ将a=2/cosθ,b=sinθ/cosθ代入3a^2+2ab得f(θ)=(12+4sinθ)/(1-sinθ^2

- 《拖延心理学》(一)你为什么会拖延?|木盒笔记

纯se蓝调

《拖延心理学》是帮助你向拖延症宣战的一本书,作者简·博克和莱诺拉·袁是全球知名的拖延症治疗专家。大概每个人或多或少总会有一点拖延症的行为。比如明天要叫论文了,今天你还没有写好,你一边在焦虑症怎么办,一边又拿着手机漫无目的的刷新闻;比如你想了很久准备减肥,但是迟迟又没有行动,想着今天晚上少吃一点吧、明天我就开始运动。今天分析的笔记来告诉你“你为什么会拖延?”,解读人杨坚。有人说拖延就像巨大的泥沼,让

- 2020年 12月3日 渥太华 阴

一生守望一人

今天结课了。全面备战,准备期末考试了。最近看到纽约州立阿尔伯尼法学院和西奈山医学院有一个联合生命科学的硕士学位,有点心动,打算考完试以后找教授和相关负责人问一下。新闻方面,中国第一次实现了外太空运载器发射,嫦娥今天正式启程返家了。这也预示着我们面对载人登月又踏出了自己坚实的一步。同时,我们继美国之后在同一年制造出了量子计算机“九章”。“九章”量子计算机可以以200秒的速度计算出当前最强大超级计算机

- 独家收藏:《咬文嚼字》“十大语文差错”3

海滨公园

独家收藏:《咬文嚼字》“十大语文差错”32008年版《咬文嚼字》“十大语文差错”目录1.电视中引用名言经常读错的字是:“有朋自远方来,不亦乐乎”的“乐”。2.社会热词容易读错的是:三聚氰胺。3.高考作文中的高频别字是:“震撼”误为“震憾”。4.旅游景点说明牌的常见别字是:“故里”误为“故裏”。5.新闻报道中容易混淆的词是:狙击/阻击。6.社会机构称谓中容易混淆的词是:营利/盈利。7.出版物上容易用

- FlagEmbedding

吉小雨

python库python

FlagEmbedding教程FlagEmbedding是一个用于生成文本嵌入(textembeddings)的库,适合处理自然语言处理(NLP)中的各种任务。嵌入(embeddings)是将文本表示为连续向量,能够捕捉语义上的相似性,常用于文本分类、聚类、信息检索等场景。官方文档链接:FlagEmbedding官方GitHub一、FlagEmbedding库概述1.1什么是FlagEmbeddi

- 今日头条极速版邀请码是多少(亲测5个可用邀请码及填写方法)

桃朵十三

第一次接触今日头条极速版app我记得是2018年7月份左右吧,当时手机上弹出一个小广告说看新闻还能赚零花钱,抱着好奇的心理下载了试一试,刚开始每天刷几条新闻或视频第二天早上金币兑换成一元多钱,可以提现到支付宝或者微信,弄得不亦乐乎。心想不给钱没事我也会看看新闻呢,何乐而不为呢。今日头条极速版邀请码是1712201738或1451455648或1805884301,秒懂你的阅读喜好,秒杀碎片化时间。

- 骑士新2号,3打5先生,塞克斯顿的标签还有什么?

篮球行为大赏

今年夏天最大的新闻早已尘埃落定,詹姆斯在近日与湖人参加合练,为下赛季做着准备。湖人在拥有联盟第一人之后,燃起了进军季后赛的希望。虽然没能吸引足够多的巨星加盟,但如今的紫金军团已经行走在崛起的路上。而反观骑士,在失去了詹姆斯之后,他们并没有获得任何好处。不仅如此,随着詹皇离去,骑士阵中部分悍将也呈鸟兽状前往其他球队,克利夫兰又一次陷入灾难。在选秀大会上,骑士没能再次成为幸运儿,手握篮网签的他们最终只

- Reflection 70B——HyperWrite推出的大型语言模型

新加坡内哥谈技术

语言模型人工智能自然语言处理

每周跟踪AI热点新闻动向和震撼发展想要探索生成式人工智能的前沿进展吗?订阅我们的简报,深入解析最新的技术突破、实际应用案例和未来的趋势。与全球数同行一同,从行业内部的深度分析和实用指南中受益。不要错过这个机会,成为AI领域的领跑者。点击订阅,与未来同行!订阅:https://rengongzhineng.io/在AI技术飞速发展的过程中,我们已经见证了可以写作、编程,甚至创造艺术的模型问世。但有一

- 免税概念股九连板?为啥免税店能成股市最热的当红“炸子鸡”?

慕容随风

根据封面新闻7月10日的报道,随着王府井6月9日的一纸“获得免税牌照”的公告,免税概念股逐渐引爆市场,此后免税概念股乘风破浪,一路飙升,个股受到追捧。6月以来王府井股价涨幅已超3倍;免税概念龙头中国国旅改名中国中免;凯撒旅业连续9天无量涨停······我国对免税业实行“统一经营、统一组织进货、统一制定零售价格、统一制定管理规定”的政策,各类免税业态均以授权牌照、指定专营公司的模式运营。王府井之前,

- 悟空浏览器app官方邀请码是多少(永久可用悟空浏览器邀请码一览)2024最新个永久邀请码大大增加

桃朵十三

悟空浏览器手机版,这款由悟空浏览器新媒体精心打造的优质新闻资讯阅读应用,悟空浏览器邀请码是J98866021填对可得41元,错了帮不了你由于不知道其邀请码是多少,始终没有开始使用。在这里,小编将悟空浏览器的邀请码给到大家,让大家时间注册悟空浏览器。悟空浏览器悟空浏览器邀请码悟空浏览器邀请码【J98866021或AE3138754或J98866021或J98866021或AE3138754】,这一年

- 差点没有日更

石头时代zy

刷完牙,躺在床上,我已经准备睡觉了,拿起手机准备最后外看看新闻,又点开了《》,才发现差点没有日更。想到原来我参加了日更挑战,根本原因就是想赚个专属徽章。目前只差两天,没想到越往后写越没有东西写,今天又忙了一天,到现在准备睡觉了也不知道该写些啥,只能勉强凑够百字来应付挑战吧!哈哈!没文化就是这样连每天写个一百字都挠破头皮,看来真得敲打敲打自己!

- 从今天开始,每天爱自己多一点

拿铁星人

文/妫1996我已经数不清这是第几次熬夜了。好像现在已经形成一种习惯了,明明到了该休息的时间,可是大脑却异常地兴奋,有时候要到凌晨一点多才睡得着。我也没做什么,无非就是刷刷微博,看看视频。偶尔看到有人因为熬夜而猝死的新闻,吓得我慌忙地丢下手机,老老实实地躺在床上。6月份开始,我们的工作需要排班了,但是都是做五休二,朝九晚六,问题不大。好不容易可以两天连休了,第一天睡得死死的,然后第二天早早就去了西

- 50/365 健康才是一切的根本

爱华zong

图片发自App最近越来越发现,健康地活着,才是长久之计。因为人生所有的比拼到最后比的都是谁活得更久。我们往往年轻时不顾及身体的熬夜、透支,无视身体发出的一次又一次的提示,总是依仗于自己年轻,觉得没事,不要紧,忽视自身的健康问题。但随着这些年年轻猝死新闻的新闻越来越多,我们真的该重视自身的健康问题啦,毕竟世间一切的经历都离不开有个好身体。愿你我从此都注重身体健康,这才是一切的长久之计……

- 欺诈文本分类检测(十四):GPTQ量化模型

沉下心来学鲁班

微调分类人工智能语言模型微调

1.引言量化的本质:通过将模型参数从高精度(例如32位)降低到低精度(例如8位),来缩小模型体积。本文将采用一种训练后量化方法GPTQ,对前文已经训练并合并过的模型文件进行量化,通过比较模型量化前后的评测指标,来测试量化对模型性能的影响。GPTQ的核心思想在于:将所有权重压缩到8位或4位量化中,通过最小化与原始权重的均方误差来实现。在推理过程中,它将动态地将权重解量化为float16,以提高性能,

- 2023-5-12晨间日记

艾美的日常

今天是什么日子:星期五起床:8:20就寝:2:00天气:阴心情:平纪念日:任务清单昨日完成的任务,最重要的三件事:1.写晚间习惯,晨间习惯2.晚上23点后不看电子产品3.23:30开始躺床上睡觉(虽然生物钟导致没睡着,但没看电子产品,听了有声书、冥想)改进:睡觉时做呼吸冥想,不要想其他事情,就很容易入睡习惯养成:咖啡阅读音乐英语日更感恩日记看新闻香薰写晚间习惯晨间习惯,吃完饭马上洗碗扔垃圾,23点

- 2021.12.21 科技新闻 | 生活很慢,世界很快【豌豆姑娘 整理】

豌豆壳外

2021.12.21科技新闻|生活很慢,世界很快【豌豆姑娘整理】1、薇娅偷逃税重罚13.41亿元,社交直播均被F号风暴中的雪梨:F号关店,买地建楼暂停,融资上市搁浅,直播公司已就地解散今年缴税110亿美元,马斯克或将成为美国史上最大纳税人2、胡润2021全球独角兽榜:字节跳动以2.25万亿估值跃升榜首(蚂蚁第二,SpaceX第三)TikTok计划在美国推出外卖餐厅,专做网红美食3、商汤重启招股,将

- 新闻传播学——新闻采访

哞哞学新传

每天学一点新闻传播学。1、新闻采访新闻采访是指记者为获取新闻对客体所进行的观察、询问、倾听、思索和记录等活动。它是一种带有特殊性质的调查活动和交流活动,是新闻工作的重要组成方式,是新闻写作的前提,并且体现了记者职业的重要特点。获取适于向大众传播的新闻是新闻采访的根本目的,观察和访问是新闻采访最基本的手段。新闻采访具有求新性、突击性、灵活性、持续性、政策性和公开性的特点。新闻采访有助于新闻记者提高认

- 买18件衣服,旅游完就退款,群众的眼睛是雪亮的

清欢意

这两天这个新闻热度很高,我也去看了一下。事情经过大概就是这个女生在某宝店里买了18件衣服。后来申请退款了。说是七天无理由退货。后来某宝客服介入这次退款退货事件了。相信会有个交代的。“人在做,天在看”老祖宗说的没错了。你以为别人不知道的事情。其实别人都看得很清楚的,所以别沾沾自喜了。世界观不正的人,做出的事情也是不正确的。虽然有时候得逞了,但是常在河边走哪有不湿鞋的?这种行为其实反映的是一个人的价值

- 文章马伊琍离婚:破镜终究难重圆

慕斯姑娘

28日下午,娱乐圈最劲爆的新闻莫过于文章马伊琍在微博宣布离婚,至此两人以相对和平的方式结束了11年的婚姻,这场曾被全国上下熟知的出轨原谅婚姻,终究在5年之后宣布结束,其中滋味,恐怕只有当事人自己最清楚。01此情有憾,好聚好散在此次双方对外宣布分开时,文章发文称“吾爱伊琍,同行半路,一别两宽,余生漫漫,依然亲情守候”。马伊琍发文则为“你我深爱过,努力过,彼此成就过。此情有憾,然无对错。往后,各生欢喜

- Vue3项目开发——新闻发布管理系统(六)

bjzhang75

Vue知识学习及项目开发实践Vue3项目开发新闻发布管理系统

文章目录八、首页设计开发1、页面设计2、登录访问拦截实现3、用户基本信息显示①封装用户基本信息获取接口②用户基本信息存储③用户基本信息调用④用户基本信息动态渲染4、退出功能实现①注册点击事件②添加退出功能③数据清理5、代码下载八、首页设计开发登录成功后,系统就进入了首页。接下来,也就进行首页的开发了。1、页面设计系统页面主要分为三部分,左侧为系统的菜单栏,右侧上部为系统的头部,下部为系统的主体区域

- 焦虑症和抑郁症不是一回事,这几点能区分

9e092dd3ef5c

焦虑症和抑郁症不是一回事,这几点能区分抑郁症和焦虑症,都是现代社会发病率比较高的心理疾病,很多人可能搞不清楚两者的区别,错误地认为抑郁症就是焦虑症,其实抑郁症和焦虑症不是同一个疾病的,并且两者的差别还是比较大的。1、发病年龄焦虑症一般发生在35岁以上的人群,多发生于老年人。而抑郁症在所有年龄群中都有发生,并且现在逐渐呈现年轻化趋势。现在新闻报道中关于抑郁症患者的人数越来越多,很多大学生因为抑郁症而

- 2019年7月26日坚持1000篇日志打卡第4轮第19天

壹童_50af

Hello,亲爱的娜娜,晚上好!挑战1000篇日志打卡今天是第82天!今天要分享的主题是《不同频的清除》今天忙了一天,就干了一件事情,就是不停的在群发好友和整顿,我昨天看到我们湖南长沙一个新闻的时候,一个13岁的男孩子因为玩手机被父亲说了一通就跳河自杀了,这个心里说真的,我看上去好难过的,为什么因为眼下孩子心理承受能力越来越差,越来越脆弱,家长也缺乏正确的育儿方式,说真的,每天看到这样的新闻出现的

- 那些30多岁就财务自由的人 都做对了什么?

大佛聊互联网金融

很多时候我们看新闻或者说我们的朋友圈,总有那么几个人,没有996甚至不用朝九晚五,生活潇洒的很。读读书养养花锻炼一下身体,偶尔再去旅旅游,感受一下蓝天白云,异域风情。这当然不是那些靠借贷来维持风光形象,人家实打实的就是完成了年少、多金、有钱、有闲这些人生目标。那么,这些并不是含着金汤匙出身的,30多岁年纪轻轻就财务自由的人,都做对了什么呢?讲为什么之前,我们先来看看,财务自由是什么。01到底什么才

- 盼望疫情早点过去

陪你今生来世

01昨天一早看到群里发布关于我省城乡各路段解封的信息,这是否意味着疫情得到了有效控制,开学和复工有望?果不其然,关注新闻确实看到了一些令人振奋的好消息。专家们发现几种对治疗新冠肺炎有效的药物,越来越多的患者被治愈。说实话,心里也算长舒了一口气,这样下去离开学,复工的日子应该不远了。后面仓库卖料的大哥已经营业,听着来往的三轮车声响,感觉生意应该还不错。我就在想:要不要也开门营业?这两天已经有客户打电

- 好书推荐 ▏《了不起的中华文明》:给孩子的中华文明百科全书,有趣又好读!

书本家读书会

《了不起的中华文明》作者:蒙曼图片:源于网络推荐理由让孩子读学习历史,不仅可以让孩子通晓古今,更能提高他的大语文素养。更重要的是,孩子从历史中,可以培养“宠辱不惊”的胸怀和气魄,做到“不以物喜、不以己悲”,受益一生。《了不起的中华文明》全书共20册,拥有海量知识条目。诗词名句、名著名篇、成语含义、经典故事、名人思想、冷门知识…是一套由蒙曼主编的传统文化绘本,已入选国家新闻出版署“2020年全国有声

- 浩瀚字海,如何取最甜一瓢来饮?

似水流年72

图片发自App在这即将奔5的路上,深深地意识到浪漫或者叫文艺这两样东西都是我骨子里缺少的。最有感触的就是关于起名字这件事。01自己的本名是爹妈给的,在刚刚降临这个凡世红尘明台尚未清明的时候,就作为一个标记深深地与我融为一体,这个用了40多年的标记,我深以为是极其不错的一个标记。在很多的文艺作品里我的名字出境频率较高,在某些实名报道的新闻里也会时有提及,那说明我的这个本名是被广大人士极其认可的,具有

- 2023-10-09

b2a585406465

“回报家乡人民——李荣海捐赠菏泽市人民政府书画作品六百幅大型回报展”作品欣赏(第十二期)菏泽市李荣海美术馆菏泽市艺术博物馆“回报家乡人民——李荣海捐赠菏泽市人民政府书画作品大型回报展”在菏泽市李荣海美术馆(菏泽市艺术博物馆)拉开帷幕,这是继李荣海先生捐赠美术馆后的又一义举,对推动菏泽文化建设具有重要意义。本次展览得到菏泽市领导、艺术界人士、院校师生、新闻媒体的广泛关注和高度评价。李荣海先生是我国著

- 多线程编程之理财

周凡杨

java多线程生产者消费者理财

现实生活中,我们一边工作,一边消费,正常情况下会把多余的钱存起来,比如存到余额宝,还可以多挣点钱,现在就有这个情况:我每月可以发工资20000万元 (暂定每月的1号),每月消费5000(租房+生活费)元(暂定每月的1号),其中租金是大头占90%,交房租的方式可以选择(一月一交,两月一交、三月一交),理财:1万元存余额宝一天可以赚1元钱,

- [Zookeeper学习笔记之三]Zookeeper会话超时机制

bit1129

zookeeper

首先,会话超时是由Zookeeper服务端通知客户端会话已经超时,客户端不能自行决定会话已经超时,不过客户端可以通过调用Zookeeper.close()主动的发起会话结束请求,如下的代码输出内容

Created /zoo-739160015

CONNECTEDCONNECTED

.............CONNECTEDCONNECTED

CONNECTEDCLOSEDCLOSED

- SecureCRT快捷键

daizj

secureCRT快捷键

ctrl + a : 移动光标到行首ctrl + e :移动光标到行尾crtl + b: 光标前移1个字符crtl + f: 光标后移1个字符crtl + h : 删除光标之前的一个字符ctrl + d :删除光标之后的一个字符crtl + k :删除光标到行尾所有字符crtl + u : 删除光标至行首所有字符crtl + w: 删除光标至行首

- Java 子类与父类这间的转换

周凡杨

java 父类与子类的转换

最近同事调的一个服务报错,查看后是日期之间转换出的问题。代码里是把 java.sql.Date 类型的对象 强制转换为 java.sql.Timestamp 类型的对象。报java.lang.ClassCastException。

代码:

- 可视化swing界面编辑

朱辉辉33

eclipseswing

今天发现了一个WindowBuilder插件,功能好强大,啊哈哈,从此告别手动编辑swing界面代码,直接像VB那样编辑界面,代码会自动生成。

首先在Eclipse中点击help,选择Install New Software,然后在Work with中输入WindowBui

- web报表工具FineReport常用函数的用法总结(文本函数)

老A不折腾

finereportweb报表工具报表软件java报表

文本函数

CHAR

CHAR(number):根据指定数字返回对应的字符。CHAR函数可将计算机其他类型的数字代码转换为字符。

Number:用于指定字符的数字,介于1Number:用于指定字符的数字,介于165535之间(包括1和65535)。

示例:

CHAR(88)等于“X”。

CHAR(45)等于“-”。

CODE

CODE(text):计算文本串中第一个字

- mysql安装出错

林鹤霄

mysql安装

[root@localhost ~]# rpm -ivh MySQL-server-5.5.24-1.linux2.6.x86_64.rpm Preparing... #####################

- linux下编译libuv

aigo

libuv

下载最新版本的libuv源码,解压后执行:

./autogen.sh

这时会提醒找不到automake命令,通过一下命令执行安装(redhat系用yum,Debian系用apt-get):

# yum -y install automake

# yum -y install libtool

如果提示错误:make: *** No targe

- 中国行政区数据及三级联动菜单

alxw4616

近期做项目需要三级联动菜单,上网查了半天竟然没有发现一个能直接用的!

呵呵,都要自己填数据....我了个去这东西麻烦就麻烦的数据上.

哎,自己没办法动手写吧.

现将这些数据共享出了,以方便大家.嗯,代码也可以直接使用

文件说明

lib\area.sql -- 县及县以上行政区划分代码(截止2013年8月31日)来源:国家统计局 发布时间:2014-01-17 15:0

- 哈夫曼加密文件

百合不是茶

哈夫曼压缩哈夫曼加密二叉树

在上一篇介绍过哈夫曼编码的基础知识,下面就直接介绍使用哈夫曼编码怎么来做文件加密或者压缩与解压的软件,对于新手来是有点难度的,主要还是要理清楚步骤;

加密步骤:

1,统计文件中字节出现的次数,作为权值

2,创建节点和哈夫曼树

3,得到每个子节点01串

4,使用哈夫曼编码表示每个字节

- JDK1.5 Cyclicbarrier实例

bijian1013

javathreadjava多线程Cyclicbarrier

CyclicBarrier类

一个同步辅助类,它允许一组线程互相等待,直到到达某个公共屏障点 (common barrier point)。在涉及一组固定大小的线程的程序中,这些线程必须不时地互相等待,此时 CyclicBarrier 很有用。因为该 barrier 在释放等待线程后可以重用,所以称它为循环的 barrier。

CyclicBarrier支持一个可选的 Runnable 命令,

- 九项重要的职业规划

bijian1013

工作学习

一. 学习的步伐不停止 古人说,活到老,学到老。终身学习应该是您的座右铭。 世界在不断变化,每个人都在寻找各自的事业途径。 您只有保证了足够的技能储

- 【Java范型四】范型方法

bit1129

java

范型参数不仅仅可以用于类型的声明上,例如

package com.tom.lang.generics;

import java.util.List;

public class Generics<T> {

private T value;

public Generics(T value) {

this.value =

- 【Hadoop十三】HDFS Java API基本操作

bit1129

hadoop

package com.examples.hadoop;

import org.apache.hadoop.conf.Configuration;

import org.apache.hadoop.fs.FSDataInputStream;

import org.apache.hadoop.fs.FileStatus;

import org.apache.hadoo

- ua实现split字符串分隔

ronin47

lua split

LUA并不象其它许多"大而全"的语言那样,包括很多功能,比如网络通讯、图形界面等。但是LUA可以很容易地被扩展:由宿主语言(通常是C或 C++)提供这些功能,LUA可以使用它们,就像是本来就内置的功能一样。LUA只包括一个精简的核心和最基本的库。这使得LUA体积小、启动速度快,从 而适合嵌入在别的程序里。因此在lua中并没有其他语言那样多的系统函数。习惯了其他语言的字符串分割函

- java-从先序遍历和中序遍历重建二叉树

bylijinnan

java

public class BuildTreePreOrderInOrder {

/**

* Build Binary Tree from PreOrder and InOrder

* _______7______

/ \

__10__ ___2

/ \ /

4

- openfire开发指南《连接和登陆》

开窍的石头

openfire开发指南smack

第一步

官网下载smack.jar包

下载地址:http://www.igniterealtime.org/downloads/index.jsp#smack

第二步

把smack里边的jar导入你新建的java项目中

开始编写smack连接openfire代码

p

- [移动通讯]手机后盖应该按需要能够随时开启

comsci

移动

看到新的手机,很多由金属材质做的外壳,内存和闪存容量越来越大,CPU速度越来越快,对于这些改进,我们非常高兴,也非常欢迎

但是,对于手机的新设计,有几点我们也要注意

第一:手机的后盖应该能够被用户自行取下来,手机的电池的可更换性应该是必须保留的设计,

- 20款国外知名的php开源cms系统

cuiyadll

cms

内容管理系统,简称CMS,是一种简易的发布和管理新闻的程序。用户可以在后端管理系统中发布,编辑和删除文章,即使您不需要懂得HTML和其他脚本语言,这就是CMS的优点。

在这里我决定介绍20款目前国外市面上最流行的开源的PHP内容管理系统,以便没有PHP知识的读者也可以通过国外内容管理系统建立自己的网站。

1. Wordpress

WordPress的是一个功能强大且易于使用的内容管

- Java生成全局唯一标识符

darrenzhu

javauuiduniqueidentifierid

How to generate a globally unique identifier in Java

http://stackoverflow.com/questions/21536572/generate-unique-id-in-java-to-label-groups-of-related-entries-in-a-log

http://stackoverflow

- php安装模块检测是否已安装过, 使用的SQL语句

dcj3sjt126com

sql

SHOW [FULL] TABLES [FROM db_name] [LIKE 'pattern']

SHOW TABLES列举了给定数据库中的非TEMPORARY表。您也可以使用mysqlshow db_name命令得到此清单。

本命令也列举数据库中的其它视图。支持FULL修改符,这样SHOW FULL TABLES就可以显示第二个输出列。对于一个表,第二列的值为BASE T

- 5天学会一种 web 开发框架

dcj3sjt126com

Web框架framework

web framework层出不穷,特别是ruby/python,各有10+个,php/java也是一大堆 根据我自己的经验写了一个to do list,按照这个清单,一条一条的学习,事半功倍,很快就能掌握 一共25条,即便很磨蹭,2小时也能搞定一条,25*2=50。只需要50小时就能掌握任意一种web框架

各类web框架大同小异:现代web开发框架的6大元素,把握主线,就不会迷路

建议把本文

- Gson使用三(Map集合的处理,一对多处理)

eksliang

jsongsonGson mapGson 集合处理

转载请出自出处:http://eksliang.iteye.com/blog/2175532 一、概述

Map保存的是键值对的形式,Json的格式也是键值对的,所以正常情况下,map跟json之间的转换应当是理所当然的事情。 二、Map参考实例

package com.ickes.json;

import java.lang.refl

- cordova实现“再点击一次退出”效果

gundumw100

android

基本的写法如下:

document.addEventListener("deviceready", onDeviceReady, false);

function onDeviceReady() {

//navigator.splashscreen.hide();

document.addEventListener("b

- openldap configuration leaning note

iwindyforest

configuration

hostname // to display the computer name

hostname <changed name> // to change

go to: /etc/sysconfig/network, add/modify HOSTNAME=NEWNAME to change permenately

dont forget to change /etc/hosts

- Nullability and Objective-C

啸笑天

Objective-C

https://developer.apple.com/swift/blog/?id=25

http://www.cocoachina.com/ios/20150601/11989.html

http://blog.csdn.net/zhangao0086/article/details/44409913

http://blog.sunnyxx

- jsp中实现参数隐藏的两种方法

macroli

JavaScriptjsp

在一个JSP页面有一个链接,//确定是一个链接?点击弹出一个页面,需要传给这个页面一些参数。//正常的方法是设置弹出页面的src="***.do?p1=aaa&p2=bbb&p3=ccc"//确定目标URL是Action来处理?但是这样会在页面上看到传过来的参数,可能会不安全。要求实现src="***.do",参数通过其他方法传!//////

- Bootstrap A标签关闭modal并打开新的链接解决方案

qiaolevip

每天进步一点点学习永无止境bootstrap纵观千象

Bootstrap里面的js modal控件使用起来很方便,关闭也很简单。只需添加标签 data-dismiss="modal" 即可。

可是偏偏有时候需要a标签既要关闭modal,有要打开新的链接,尝试多种方法未果。只好使用原始js来控制。

<a href="#/group-buy" class="btn bt

- 二维数组在Java和C中的区别

流淚的芥末

javac二维数组数组

Java代码:

public class test03 {

public static void main(String[] args) {

int[][] a = {{1},{2,3},{4,5,6}};

System.out.println(a[0][1]);

}

}

运行结果:

Exception in thread "mai

- systemctl命令用法

wmlJava

linuxsystemctl

对比表,以 apache / httpd 为例 任务 旧指令 新指令 使某服务自动启动 chkconfig --level 3 httpd on systemctl enable httpd.service 使某服务不自动启动 chkconfig --level 3 httpd off systemctl disable httpd.service 检查服务状态 service h

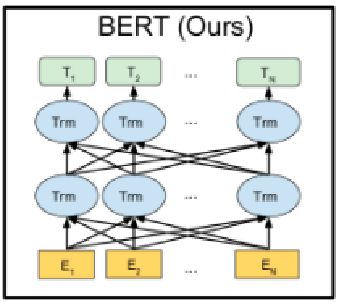

BERT模型进一步增加词向量模型泛化能力,充分描述字符级、词级、句子级甚至句间关系特征。

BERT模型进一步增加词向量模型泛化能力,充分描述字符级、词级、句子级甚至句间关系特征。