第一章 统计学习和监督学习概论

1.绪

刚看到这本书的时候,就有一个疑问:统计学习方法是不是就等于机器学习?假如不是得话,那么统计学习和机器学习有什么关系呢?

目前流行的一种说法是,机器学习和统计学之间的主要区别就在于他们的目的:机器学习模型旨在去达到最准确的预测,而统计模型被设计用于推断变量之间的关系。更加倾向于模型的可解释性。

在统计学方法中,模型的要点是表征数据和结果变量之间的关系,而不是对未来数据进行预测。这个过程被称之为统计推断,而不是预测。

在机器学习中,机器学习的目的是为了获得可以进行重复预测的模型,不关心模型是否可解释,只关心模型的结果。

所以说,大部分机器学习算法缺乏可解释性去证明数据内的关系。

2.统计学习方法

统计学习方法可以被概括为从给定的,有限的,用于学习的训练数据出发,假设数据是独立同分布的,从假设空间中选取最优的模型,使得这个模型对已知的训练数据及未知的测试数据在给定的评价标准下有着最优的的预测.

统计学习方法的步骤:

1.得到一个训练数据集合

2.确定要学习的模型及学习的策略

3.求解最优模型

4.利用学习到的新模型对新数据进行预测及分析

3.统计学习的基本分类

目前一般将其分为:监督学习,无监督学习,强化学习,半监督学习和主动学习

1.监督学习:

数据+标注的标签---->学习到最优的模型

监督学习假设输入和输出变量X和Y遵循联合概率分布.P(X,Y)表示分布函数.

监督学习的模型可以是概率模型或者非概率模型,由条件概率分布P(Y|X)或者决策函数Y = f(X)表示.当具体的输入进行相对应的输出预测时,写为:P(y|x)或y=f(x).P(y|x)意味着给定输入x,得到预测结果为y的概率.

下面讲一下自己对于监督学习的理解:

首先是数据,数据是带标签的,然后将数据输入到监督模型中,得到预测结果,然后和真实结果比较,将比较结果反馈给监督模型进行校正.如此不断迭代,使得预测的结果尽可能的接近真实的结果,这时候选出我们所需要的最优模型.然后用测试输入我们选择出来的最优模型中,得到预测的结果,去衡量这个最优模型的普适性.

2.无监督学习

无监督学习就是从无标注的数据中学习预测模型的机器学习问题,其本质是为了学习到数据本身的统计规律或者说是数据的内在结构.

3.强化学习

强化学习是指智能系统在环境的连续互动中学习最优行为策略的机器学习问题,

4.半监督学习和主动学习

半监督学习是指利用标注数据和无标注数据预测模型的机器学习问题.通常是少量标注数据,大量无标注数据.,半监督学习旨在利用未标注数据之中的信息,辅助标注数据,进行监督学习.以较低的成本以用来达到较好的学习效果.

统计学习模型又可以分为线性模型和非线性模型,如果y =f(x)是非线性的,那么模型就是非线性模型.

感知机,线性支持向量机,k近邻,k均值,潜在语义分析都属于线性模型,核函数支持向量机和AdaBoost,神经网络都是非线性模型.

统计学习模型又可以分为参数化模型和非参数化模型.

感知机,朴素贝叶斯,逻辑斯蒂回归,k均值,高斯混合模型都是参数化模型.决策树.支持向量机,AdaBoost,k近邻.潜在语义分析和潜在概率狄利克雷分配都是非参数化模型.

统计学习方法也可以根据其使用的技巧进行分类:

1.贝叶斯学习

贝叶斯学习也被称之为贝叶斯推理,其主要思想是,在概率模型的学习和推理中,利用贝叶斯定理,计算在给定数据条件下模型的条件概率,即后验概率,并利用这个原理进行模型的估计以及对数据的预测.使用模型的先验分布是贝叶斯学习的特点

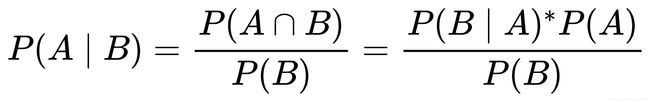

贝叶斯公式:

推理:根据文氏图:

P(A|B) = P(AB)/P(B) ,公式左边的意思是,在B发生的概率下,A发生的概率.公式右边的意思是,AB同时发生的概率除以B发生的概率,就是A和B相交的面积除以B的面积.P(AB) = P(A|B)P(B)

P(B|A) = P(AB)/P(A). -------->.P(AB) = P(B|A)P(A)

所有有:P(A|B)P(B) = P(B|A)P(A)

所有有:P(A|B)= P(B|A)P(A) /P(B)

其中,P(A)是先验概率,P(B|A)是似然函数,在模型估计时,估计整个后验概率P(A|B)最大的模型.,后验概率最大就是期望风险最小化.

2核方法:

是使用核函数表示和学习非线性模型的一种机器学习方法.可以用在监督学习和半监督学习.核支持向量机和核PCA和核k均值都属于核方法.

将线性模型扩展到非线性模型,直接的做法就是显式的定义从输入空间到特征空间的映射,在特征空间进行内积计算.