- spark学习资料

Liam_ml

AdvancedApacheSpark-SameerFarooqui(Databricks)”(https://www.youtube.com/watch?v=7ooZ4S7Ay6Y)将几天的课程浓缩到了一天,质量非常好。Spark的文档:Overview-Spark1.6.1Documentation,这里面包含项目介绍,代码示例,配置,部署,调优等等,入门使用足够了。Sparkrepo:apa

- Hudi学习 6:Hudi使用

hzp666

Hudihudi数据湖湖仓一体湖仓融合实时数仓

准备工作:1.安装hdfshttps://mp.csdn.net/mp_blog/creation/editor/1096891432.安装sparkspark学习4:spark安装_hzp666的博客-CSDN博客3.安装ScalaHudi学习6:安装和基本操作_hzp666的博客-CSDN博客spark-shell写入和读取hudi2.模拟数据插入hudi使用spark写入数据

- spark学习4:spark安装

hzp666

sparkspark大数据

1.下载spark安装包2.配置环境1.cd/bigdata/spark-3.0.1-bin-hadoop3.2/conf/2.4.添加动态库在hadoop-3.2.2/bin目录下添加hadoop.dll和winutils.exe文件,可以从https://github.com/cdarlint/winutils和https://github.com/steveloughran/winutils

- pyspark学习-自定义udf

heiqizero

sparkspark

#demo1:frompyspark.sqlimportSparkSession,Rowif__name__=='__main__':spark=SparkSession.builder.getOrCreate()num=spark.sparkContext.parallelize([1,2,3,4,5]).map(lambdax:Row(num=x))numDF=spark.createData

- pyspark学习-spark.sql.functions normal函数

heiqizero

sparkspark

1.col#col(col)"""作用:返回一个基于已给列名的列信息场景:类似于dataframe格式中提取data["id"],能够进行计算参数: col:列名 返回: column:返回一个基于已给列名的列信息"""spark=SparkSession.builder.getOrCreate()data=spark.range(3)data.select(col("id").alias(

- [Spark] 如何设置Spark资源

LZhan

转自1.公众号[Spark学习技巧]如何设置Spark资源2.Spark性能优化篇一:资源调优Spark和YARN管理的两个主要资源:CPU和内存应用程序中每个SparkExecutor都具有相同的固定数量的核心和相同的固定堆大小。使用--executor-cores命令行参数或者通过设置spark.executor.cores属性指定核心数;使用--executor-memory命令行参数或者通

- pyspark学习-spark.sql.functions 聚合函数

heiqizero

sparkspark

https://spark.apache.org/docs/3.4.1/api/python/reference/pyspark.sql/functions.html1.approx_count_distinct和count_distinct#approx_count_distinct(col:ColumnOrName,rsd:Optionnal[float]=None)"""作用:返回列col的

- spark学习笔记:弹性分布式数据集RDD(Resilient Distributed Dataset)

黄道婆

bigdata

弹性分布式数据集RDD1.RDD概述1.1什么是RDDRDD(ResilientDistributedDataset)叫做弹性分布式数据集,是Spark中最基本的数据抽象,它代表一个不可变、可分区、里面的元素可并行计算的集合。RDD具有数据流模型的特点:自动容错、位置感知性调度和可伸缩性。RDD允许用户在执行多个查询时显式地将数据缓存在内存中,后续的查询能够重用这些数据,这极大地提升了查询速度。D

- pyspark学习_dataframe常用操作_02

heiqizero

sparkspark

#回顾01常用操作frompysparkimportSparkSession,DataFramespark=SparkSession.builder.getOrCreate()peopleDF=spark.read.json("people.json")peopleDF.printSchema()#显示DataFrame的模式信息peopleDF.show()#显示DataFrame的数据信息pe

- Spark学习笔记五:Spark资源调度和任务调度

开发者连小超

一、StageSpark任务会根据RDD之间的依赖关系,形成一个DAG有向无环图,DAG会提交给DAGScheduler,DAGScheduler会把DAG划分相互依赖的多个stage,划分stage的依据就是RDD之间的宽窄依赖。遇到宽依赖就划分stage,每个stage包含一个或多个task任务。然后将这些task以taskSet的形式提交给TaskScheduler运行。stage切割规则切

- pyspark学习_wordcount

heiqizero

sparksparkpython

#统计文件中每个字母出现次数#第一版rdd文件行类型:Aaron,OperatingSystem,100frompysparkimportSparkConf,SparkContextconf=SparkConf().setAppName("RddwordCount").setMaster("local[*]")sc=SparkContext(conf=conf)lines=sc.textFile(

- pyspark学习_RDD转为DataFrame

heiqizero

sparksparkpython

#方法1:反射机制推断RDD模式people.txtTom12Jack13Janny14frompyspark.sqlimportSparkSession,Rowspark=SparkSession.builder.getOrCreate()lines=spark.sparkContext.textFile("people.txt")people=lines.map(lambdax:x.split

- pyspark学习-RDD转换和动作

heiqizero

sparksparkpython

#RDD创建#1.parallelize方法:创建RDD,参数为list,返回RDDsc.parallelize(param:list)#demosc.parallelize(['tom','jack','black'])#2.textFile方法:读取文件,创建RDD,参数为hdfs文件地址或者本地文件地址,返回RDDsc.textFile(param:filepath)#demosc.text

- pyspark学习_dataframe常用操作_01

heiqizero

sparksparkpython

1.创建DataFrame本文使用DataFrame通过读取json文件获取数据,代码如下:frompyspark.sqlimportSparkSessionspark=SparkSeesion.builder.getOrCreate()#创建sparkSessionpeopleDF=spark.read.format("json").load("people.json")"""spark支持读取

- Spark学习(8)-SparkSQL的运行流程,Spark On Hive

技术闲聊DD

大数据hivespark学习

1.SparkSQL的运行流程1.1SparkRDD的执行流程回顾1.2SparkSQL的自动优化RDD的运行会完全按照开发者的代码执行,如果开发者水平有限,RDD的执行效率也会受到影响。而SparkSQL会对写完的代码,执行“自动优化”,以提升代码运行效率,避免开发者水平影响到代码执行效率。这是因为:RDD:内含数据类型不限格式和结构。DataFrame:100%是二维表结构,可以被针对Spar

- Apriori

BluthLeee

Apriori算法原理总结-刘建平FPTree算法原理总结-刘建平PrefixSpan算法原理总结-刘建平用Spark学习FPTree算法和PrefixSpan算法-刘建平

- Spark学习之Spark Core

John Stones

sparkbigdatascala

什么是Spark?(官网:http://spark.apache.org)https://www.cnblogs.com/lq0310/p/9841647.html

- 【大数据】Spark学习笔记

pass night

学习笔记javaspark大数据sql

初识SparkSpark和HadoopHadoopSpark起源时间20052009起源地MapReduceUniversityofCaliforniaBerkeley数据处理引擎BatchBatch编程模型MapReduceResilientdistributedDatesets内存管理DiskBasedJVMManaged延迟高中吞吐量中高优化机制手动手动APILowlevelhighleve

- spark学习之旅(2)之之RDD常用方法

浩哥的技术博客

sparkspark大数据

RDD(ResilientDistributedDataset)叫做弹性分布式数据集,是Spark中最基本的数据抽象,它代表一个不可变、可分区、里面的元素可并行计算的集合。这里的弹性指的是RDD可以根据当前情况自动进行内存和硬盘存储的转换简单点讲就是spark中对数据的一个封装,把数据封装进对象,容易操作在spark中所有的计算都是围绕着RDD操作的,每个RDD都被分为多个分区,这些分区运行在集群

- spark学习一-------------------Spark算子最详细介绍

创作者mateo

spark大数据专栏spark学习ajax

Spark学习–spark算子介绍1.基本概念spark算子:为了提供方便的数据处理和计算,spark提供了一系列的算子来进行数据处理。一般算子分为action(执行算子)算子Transformation(懒执行)算子。2.Transformation算子基本介绍简介:transformation被称为懒执行算子,如果没有action算子,则代码是不会执行的,一般分为:map算子:map算子是将r

- 2017.09.06 scala spark学习

RazorH

日记

2.scala没有静态的修饰符,但object下的成员都是静态的,若有同名的class,这其作为它的伴生类。在object中一般可以为伴生类做一些初始化等操作,如我们常常使用的valarray=Array(1,2,3)(ps:其使用了apply方法)scala里的object一般特指的是伴生对象,可以通过对象名直接调用其中的成员,类似Java中的static成员,如果不在当前作用域,需要impor

- spark学习笔记(十一)——sparkStreaming-概述/特点/构架/DStream入门程序wordcount

一个人的牛牛

spark学习sparkscala大数据

目录SparkStreamingsparkStreamingDStreamsparkStreaming特点sparkStreaming构架背压机制DStream入门SparkStreamingsparkStreamingSparkStreaming用于流式数据的处理。SparkStreaming支持的数据输入源很多:Kafka、Flume、Twitter、ZeroMQ和简单的TCP套接字等等。数据

- Spark学习——1.代表性大数据技术

楓尘林间

SparkSpark大数据学习

本篇博客是学习子雨大数据之Spark入门教程的学习笔记,仅作学习之用。1.代表性的大数据技术HadoopSparkFlinkBeam主要计算模式如图1-11.1HadoopHadoop的生态系统图如图1-2开源谷歌GFS,利用MapReduce分布式并行编程,MapReduce和HDFS是Hadoop的两大核心。HDFS分布式文件管理系统Hive数据仓库数据仓库,借助底层HDFS和HBase完成存

- Spark学习笔记一

孤独的偷学者

开发环境的搭建大数据spark

文章目录1Spark架构设计与原理思想1.1Spark初始1.2Spark架构核心1.3Spark的计算阶段1.4Spark执行流程1.4Spark核心模块2Spark运行环境2.1Local模式2.2Standalone模式2.2.1上传与解压Spark压缩包2.2.2默认配置文件的修改2.2.3启动集群2.2.4配置历史服务2.2.5配置高可用(HA)1Spark架构设计与原理思想1.1Spa

- 大数据Spark学习笔记—sparkcore

Int mian[]

大数据大数据sparkhadoopscala分布式

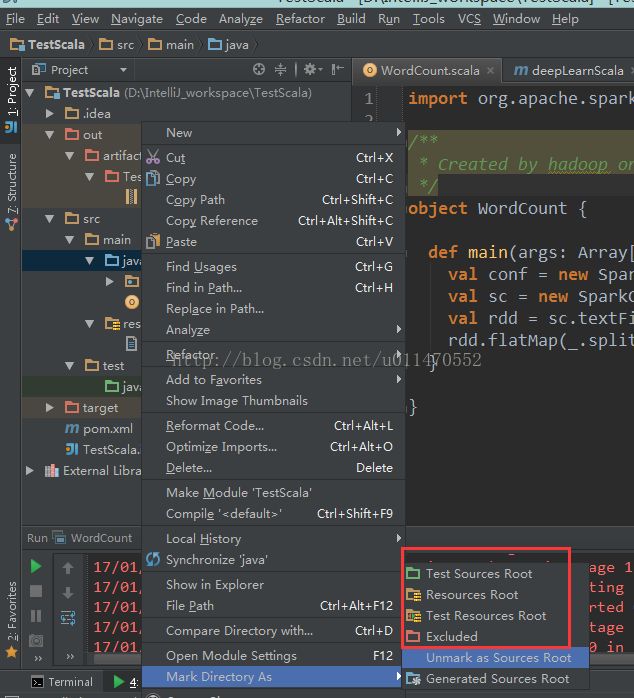

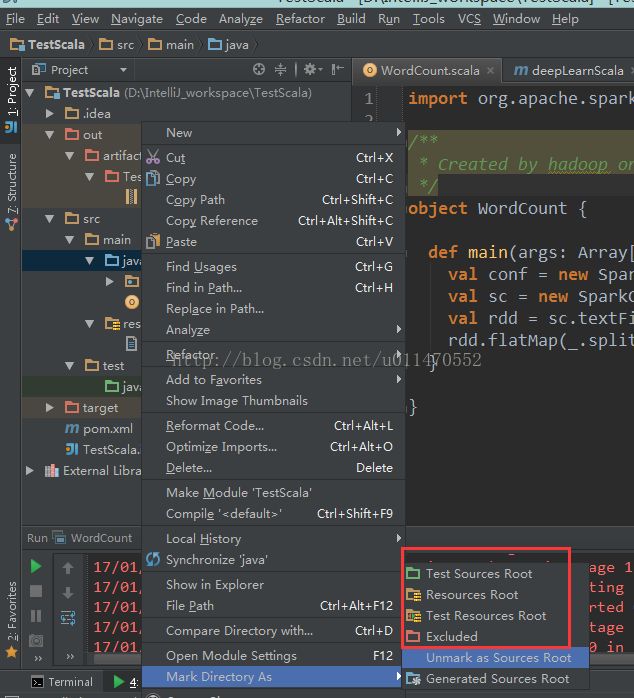

目录Spark概述核心模块Spark编程配置IDEA配置scala环境WordCount案例Spark-Standalone运行环境Local配置步骤集群分工解压文件修改配置启动集群配置历史服务器Spark-Yarn运行环境配置步骤配置历史服务器Windows运行环境配置步骤常用端口号Spark架构核心组件DriverExecutorMaster&WorkerApplicationMasterHa

- 20210127_spark学习笔记

yehaver

spark

一、部分理论spark:由Scala语言开发的快速、通用、可扩展的基于内存的大数据分析引擎。在mapreduce上进行了优化,但没mapreduce稳定。SparkCore是spark平台的基础通用执行引擎,所有其他功能都是基于。它在外部存储系统中提供内存计算和引用数据集。spark最基础的最核心的功能SparkSQL是SparkCore之上的一个组件,它引入了一个称为SchemaRDD的新数据抽

- 【Spark学习笔记】- 1Spark和Hadoop的区别

拉格朗日(Lagrange)

#Spark学习笔记spark学习笔记

目录标题Spark是什么SparkandHadoop首先从时间节点上来看:功能上来看:SparkorHadoopSpark是什么Spark是一种基于内存的快速、通用、可扩展的大数据分析计算引擎。SparkandHadoop在之前的学习中,Hadoop的MapReduce是大家广为熟知的计算框架,那为什么咱们还要学习新的计算框架Spark呢,这里就不得不提到Spark和Hadoop的关系。首先从时间

- Spark学习笔记【基础概念】

java路飞

大数据Sparkspark大数据java

文章目录前言Spark基础Spark是什么spark和hadoop区别Spark核心模块Spark运行模式Spark运行架构运行架构Executor与Core(核)并行度(Parallelism)有向无环图(DAG)spark的提交方式clientclusterSpark核心编程三大数据结构RDD什么是RDD执行原理RDDAPIRDD创建RDD转换算子Action行动算子统计操作RDD序列化RDD

- Spark学习笔记(3)——Spark运行架构

程光CS

#Spark学习笔记

本系列文章内容全部来自尚硅谷教学视频,仅作为个人的学习笔记一、运行架构Spark框架的核心是一个计算引擎,整体来说,它采用了标准master-slave的结构。如下图所示,它展示了一个Spark执行时的基本结构。图形中的Driver表示master,负责管理整个集群中的作业任务调度。图形中的Executor则是slave,负责实际执行任务。二、核心组件由上图可以看出,对于Spark框架有两个核心组

- 【Spark学习笔记】- 4运行架构&核心组件&核心概念

拉格朗日(Lagrange)

#Spark学习笔记spark学习笔记

目录标题1运行架构2核心组件2.1Driver2.2Executor2.3Master&Worker2.4ApplicationMaster3核心概念3.1Executor与Core3.2并行度(Parallelism)3.3有向无环图(DAG)4提交流程4.1YarnClient模式4.2YarnCluster模式5分布式计算模拟5.1Driver5.2Executor5.3Executor25

- windows下源码安装golang

616050468

golang安装golang环境windows

系统: 64位win7, 开发环境:sublime text 2, go版本: 1.4.1

1. 安装前准备(gcc, gdb, git)

golang在64位系

- redis批量删除带空格的key

bylijinnan

redis

redis批量删除的通常做法:

redis-cli keys "blacklist*" | xargs redis-cli del

上面的命令在key的前后没有空格时是可以的,但有空格就不行了:

$redis-cli keys "blacklist*"

1) "blacklist:12:

[email protected]

- oracle正则表达式的用法

0624chenhong

oracle正则表达式

方括号表达示

方括号表达式

描述

[[:alnum:]]

字母和数字混合的字符

[[:alpha:]]

字母字符

[[:cntrl:]]

控制字符

[[:digit:]]

数字字符

[[:graph:]]

图像字符

[[:lower:]]

小写字母字符

[[:print:]]

打印字符

[[:punct:]]

标点符号字符

[[:space:]]

- 2048源码(核心算法有,缺少几个anctionbar,以后补上)

不懂事的小屁孩

2048

2048游戏基本上有四部分组成,

1:主activity,包含游戏块的16个方格,上面统计分数的模块

2:底下的gridview,监听上下左右的滑动,进行事件处理,

3:每一个卡片,里面的内容很简单,只有一个text,记录显示的数字

4:Actionbar,是游戏用重新开始,设置等功能(这个在底下可以下载的代码里面还没有实现)

写代码的流程

1:设计游戏的布局,基本是两块,上面是分

- jquery内部链式调用机理

换个号韩国红果果

JavaScriptjquery

只需要在调用该对象合适(比如下列的setStyles)的方法后让该方法返回该对象(通过this 因为一旦一个函数称为一个对象方法的话那么在这个方法内部this(结合下面的setStyles)指向这个对象)

function create(type){

var element=document.createElement(type);

//this=element;

- 你订酒店时的每一次点击 背后都是NoSQL和云计算

蓝儿唯美

NoSQL

全球最大的在线旅游公司Expedia旗下的酒店预订公司,它运营着89个网站,跨越68个国家,三年前开始实验公有云,以求让客户在预订网站上查询假期酒店时得到更快的信息获取体验。

云端本身是用于驱动网站的部分小功能的,如搜索框的自动推荐功能,还能保证处理Hotels.com服务的季节性需求高峰整体储能。

Hotels.com的首席技术官Thierry Bedos上个月在伦敦参加“2015 Clou

- java笔记1

a-john

java

1,面向对象程序设计(Object-oriented Propramming,OOP):java就是一种面向对象程序设计。

2,对象:我们将问题空间中的元素及其在解空间中的表示称为“对象”。简单来说,对象是某个类型的实例。比如狗是一个类型,哈士奇可以是狗的一个实例,也就是对象。

3,面向对象程序设计方式的特性:

3.1 万物皆为对象。

- C语言 sizeof和strlen之间的那些事 C/C++软件开发求职面试题 必备考点(一)

aijuans

C/C++求职面试必备考点

找工作在即,以后决定每天至少写一个知识点,主要是记录,逼迫自己动手、总结加深印象。当然如果能有一言半语让他人收益,后学幸运之至也。如有错误,还希望大家帮忙指出来。感激不尽。

后学保证每个写出来的结果都是自己在电脑上亲自跑过的,咱人笨,以前学的也半吊子。很多时候只能靠运行出来的结果再反过来

- 程序员写代码时就不要管需求了吗?

asia007

程序员不能一味跟需求走

编程也有2年了,刚开始不懂的什么都跟需求走,需求是怎样就用代码实现就行,也不管这个需求是否合理,是否为较好的用户体验。当然刚开始编程都会这样,但是如果有了2年以上的工作经验的程序员只知道一味写代码,而不在写的过程中思考一下这个需求是否合理,那么,我想这个程序员就只能一辈写敲敲代码了。

我的技术不是很好,但是就不代

- Activity的四种启动模式

百合不是茶

android栈模式启动Activity的标准模式启动栈顶模式启动单例模式启动

android界面的操作就是很多个activity之间的切换,启动模式决定启动的activity的生命周期 ;

启动模式xml中配置

<activity android:name=".MainActivity" android:launchMode="standard&quo

- Spring中@Autowired标签与@Resource标签的区别

bijian1013

javaspring@Resource@Autowired@Qualifier

Spring不但支持自己定义的@Autowired注解,还支持由JSR-250规范定义的几个注解,如:@Resource、 @PostConstruct及@PreDestroy。

1. @Autowired @Autowired是Spring 提供的,需导入 Package:org.springframewo

- Changes Between SOAP 1.1 and SOAP 1.2

sunjing

ChangesEnableSOAP 1.1SOAP 1.2

JAX-WS

SOAP Version 1.2 Part 0: Primer (Second Edition)

SOAP Version 1.2 Part 1: Messaging Framework (Second Edition)

SOAP Version 1.2 Part 2: Adjuncts (Second Edition)

Which style of WSDL

- 【Hadoop二】Hadoop常用命令

bit1129

hadoop

以Hadoop运行Hadoop自带的wordcount为例,

hadoop脚本位于/home/hadoop/hadoop-2.5.2/bin/hadoop,需要说明的是,这些命令的使用必须在Hadoop已经运行的情况下才能执行

Hadoop HDFS相关命令

hadoop fs -ls

列出HDFS文件系统的第一级文件和第一级

- java异常处理(初级)

白糖_

javaDAOspring虚拟机Ajax

从学习到现在从事java开发一年多了,个人觉得对java只了解皮毛,很多东西都是用到再去慢慢学习,编程真的是一项艺术,要完成一段好的代码,需要懂得很多。

最近项目经理让我负责一个组件开发,框架都由自己搭建,最让我头疼的是异常处理,我看了一些网上的源码,发现他们对异常的处理不是很重视,研究了很久都没有找到很好的解决方案。后来有幸看到一个200W美元的项目部分源码,通过他们对异常处理的解决方案,我终

- 记录整理-工作问题

braveCS

工作

1)那位同学还是CSV文件默认Excel打开看不到全部结果。以为是没写进去。同学甲说文件应该不分大小。后来log一下原来是有写进去。只是Excel有行数限制。那位同学进步好快啊。

2)今天同学说写文件的时候提示jvm的内存溢出。我马上反应说那就改一下jvm的内存大小。同学说改用分批处理了。果然想问题还是有局限性。改jvm内存大小只能暂时地解决问题,以后要是写更大的文件还是得改内存。想问题要长远啊

- org.apache.tools.zip实现文件的压缩和解压,支持中文

bylijinnan

apache

刚开始用java.util.Zip,发现不支持中文(网上有修改的方法,但比较麻烦)

后改用org.apache.tools.zip

org.apache.tools.zip的使用网上有更简单的例子

下面的程序根据实际需求,实现了压缩指定目录下指定文件的方法

import java.io.BufferedReader;

import java.io.BufferedWrit

- 读书笔记-4

chengxuyuancsdn

读书笔记

1、JSTL 核心标签库标签

2、避免SQL注入

3、字符串逆转方法

4、字符串比较compareTo

5、字符串替换replace

6、分拆字符串

1、JSTL 核心标签库标签共有13个,

学习资料:http://www.cnblogs.com/lihuiyy/archive/2012/02/24/2366806.html

功能上分为4类:

(1)表达式控制标签:out

- [物理与电子]半导体教材的一个小问题

comsci

问题

各种模拟电子和数字电子教材中都有这个词汇-空穴

书中对这个词汇的解释是; 当电子脱离共价键的束缚成为自由电子之后,共价键中就留下一个空位,这个空位叫做空穴

我现在回过头翻大学时候的教材,觉得这个

- Flashback Database --闪回数据库

daizj

oracle闪回数据库

Flashback 技术是以Undo segment中的内容为基础的, 因此受限于UNDO_RETENTON参数。要使用flashback 的特性,必须启用自动撤销管理表空间。

在Oracle 10g中, Flash back家族分为以下成员: Flashback Database, Flashback Drop,Flashback Query(分Flashback Query,Flashbac

- 简单排序:插入排序

dieslrae

插入排序

public void insertSort(int[] array){

int temp;

for(int i=1;i<array.length;i++){

temp = array[i];

for(int k=i-1;k>=0;k--)

- C语言学习六指针小示例、一维数组名含义,定义一个函数输出数组的内容

dcj3sjt126com

c

# include <stdio.h>

int main(void)

{

int * p; //等价于 int *p 也等价于 int* p;

int i = 5;

char ch = 'A';

//p = 5; //error

//p = &ch; //error

//p = ch; //error

p = &i; //

- centos下php redis扩展的安装配置3种方法

dcj3sjt126com

redis

方法一

1.下载php redis扩展包 代码如下 复制代码

#wget http://redis.googlecode.com/files/redis-2.4.4.tar.gz

2 tar -zxvf 解压压缩包,cd /扩展包 (进入扩展包然后 运行phpize 一下是我环境中phpize的目录,/usr/local/php/bin/phpize (一定要

- 线程池(Executors)

shuizhaosi888

线程池

在java类库中,任务执行的主要抽象不是Thread,而是Executor,将任务的提交过程和执行过程解耦

public interface Executor {

void execute(Runnable command);

}

public class RunMain implements Executor{

@Override

pub

- openstack 快速安装笔记

haoningabc

openstack

前提是要配置好yum源

版本icehouse,操作系统redhat6.5

最简化安装,不要cinder和swift

三个节点

172 control节点keystone glance horizon

173 compute节点nova

173 network节点neutron

control

/etc/sysctl.conf

net.ipv4.ip_forward =

- 从c面向对象的实现理解c++的对象(二)

jimmee

C++面向对象虚函数

1. 类就可以看作一个struct,类的方法,可以理解为通过函数指针的方式实现的,类对象分配内存时,只分配成员变量的,函数指针并不需要分配额外的内存保存地址。

2. c++中类的构造函数,就是进行内存分配(malloc),调用构造函数

3. c++中类的析构函数,就时回收内存(free)

4. c++是基于栈和全局数据分配内存的,如果是一个方法内创建的对象,就直接在栈上分配内存了。

专门在

- 如何让那个一个div可以拖动

lingfeng520240

html

<!DOCTYPE html PUBLIC "-//W3C//DTD XHTML 1.0 Transitional//EN" "http://www.w3.org/TR/xhtml1/DTD/xhtml1-transitional.dtd">

<html xmlns="http://www.w3.org/1999/xhtml

- 第10章 高级事件(中)

onestopweb

事件

index.html

<!DOCTYPE html PUBLIC "-//W3C//DTD XHTML 1.0 Transitional//EN" "http://www.w3.org/TR/xhtml1/DTD/xhtml1-transitional.dtd">

<html xmlns="http://www.w3.org/

- 计算两个经纬度之间的距离

roadrunners

计算纬度LBS经度距离

要解决这个问题的时候,到网上查了很多方案,最后计算出来的都与百度计算出来的有出入。下面这个公式计算出来的距离和百度计算出来的距离是一致的。

/**

*

* @param longitudeA

* 经度A点

* @param latitudeA

* 纬度A点

* @param longitudeB

*

- 最具争议的10个Java话题

tomcat_oracle

java

1、Java8已经到来。什么!? Java8 支持lambda。哇哦,RIP Scala! 随着Java8 的发布,出现很多关于新发布的Java8是否有潜力干掉Scala的争论,最终的结论是远远没有那么简单。Java8可能已经在Scala的lambda的包围中突围,但Java并非是函数式编程王位的真正觊觎者。

2、Java 9 即将到来

Oracle早在8月份就发布

- zoj 3826 Hierarchical Notation(模拟)

阿尔萨斯

rar

题目链接:zoj 3826 Hierarchical Notation

题目大意:给定一些结构体,结构体有value值和key值,Q次询问,输出每个key值对应的value值。

解题思路:思路很简单,写个类词法的递归函数,每次将key值映射成一个hash值,用map映射每个key的value起始终止位置,预处理完了查询就很简单了。 这题是最后10分钟出的,因为没有考虑value为{}的情