- 性能优化案例:通过合理设置spark.default.parallelism参数的值来优化PySpark程序的性能

weixin_30777913

大数据sparkpython

在PySpark中,spark.default.parallelism是一个关键参数,直接影响作业的并行度和资源利用率。通过合理设置spark.default.parallelism并结合数据特征调整,可显著提升PySpark作业的并行效率和资源利用率。建议在开发和生产环境中进行多轮基准测试以确定最优值。以下是如何通过调整此参数优化性能的详细说明,结合案例和最佳实践:1.参数作用与问题场景参数意义

- Redis学习笔记

csdn_bobo_6

redis学习数据库

认识NoSQLNoSQL,泛指非关系型的数据库。随着互联网web2.0网站的兴起,传统的关系数据库在处理web2.0网站,特别是超大规模和高并发的SNS类型的web2.0纯动态网站已经显得力不从心,出现了很多难以克服的问题,而非关系型的数据库则由于其本身的特点得到了非常迅速的发展。NoSQL数据库的产生就是为了解决大规模数据集合多重数据种类带来的挑战,特别是大数据应用难题。NoSQL特点方便扩展(

- 性能优化案例:通过合理设置spark.storage.memoryFraction参数的值来优化PySpark程序的性能

weixin_30777913

python大数据spark

优化PySpark程序的性能时,合理设置spark.storage.memoryFraction(或相关内存参数)是关键。合理设置spark.storage.memoryFraction需结合任务类型和内存使用监控。对于缓存密集型任务,适当提高存储内存比例;对于Shuffle密集型任务,优先保障执行内存。新版本Spark的动态内存机制简化了调优,但手动干预在极端场景下仍有效。最终需通过反复测试验证

- 转:Spark RDD算子练习题

爱萨萨

技术-大数据sparkRDD练习

版权声明:本文为博主原创文章,遵循CC4.0BY-SA版权协议,转载请附上原文出处链接和本声明。本文链接:https://blog.csdn.net/qq_40825218/article/details/83720732给定数据如下:12张三25男chinese5012张三25男math6012张三25男english7012李四20男chinese5012李四20男math5012李四20男e

- spark sql的练习题

a大数据yyds

sparkspark

1、使用StructuredStreaming读取Socket数据,把单词和单词的反转组成json格式写入到当前目录中的file文件夹中2、请使用StructuredStreaming读取student_info文件夹写的csv文件,2.1、统计出文件中的男女生各有多少人2.2、统计出姓“王”男生和女生的各有多少人3、请使用StructuredStreaming读取department_info文

- Spark>sql练习题

BigMoM1573

Sparkspark

练习题-------------------------------以下使用StructuredStreaming:-------------------------------1、请使用StructuredStreaming读取Socket数据,统计出每个单词的个数2、请使用StructuredStreaming读取student_info文件夹写的csv文件,2.1、统计出文件中的男女生各有多

- 《Spark大数据分析与内存计算》——第三章

阿万古

课程作业spark数据分析大数据

第三章作业及答案快捷查找:Ctrl+F在搜索框中输入题目一.单选题(共17题)1.(单选题)并不是所有企业都能自己产生数据,从而用于决策辅助,而更多的互联网企业如电商等大部分是要靠什么来抓取互联网数据进行分析A.HadoopB.pythonC.SparkD.网路爬虫正确答案:D:网路爬虫;2.(单选题)什么负责即席查询的应用A.MLlibB.SparkStreamingC.GraphXD.Spar

- PySpark之金融数据分析(Spark RDD、SQL练习题)

唯余木叶下弦声

大数据大数据sparkpysparkpython数据分析sql

目录一、数据来源二、PySparkRDD编程1、查询特定日期的资金流入和流出情况2、活跃用户分析三、PySparkSQL编程1、按城市统计2014年3月1日的平均余额2、统计每个城市总流量前3高的用户四、总结一、数据来源本文使用的数据来源于天池大赛数据集,由蚂蚁金服提供,包含用户基本信息、申购赎回记录、收益率、银行间拆借利率等多个维度,本文通过PySpark实现对该数据集的简单分析。数据来源:天池

- 探秘FreeMovie:一个开源的电影推荐系统

孟振优Harvester

探秘FreeMovie:一个开源的电影推荐系统去发现同类优质开源项目:https://gitcode.com/项目简介是一个基于深度学习的开源电影推荐系统,由pojiezhiyuanjun开发并维护。该项目的目标是为用户提供个性化的电影推荐服务,通过机器学习算法理解用户的观影偏好,并据此进行智能推荐。技术分析FreeMovie的核心架构包括以下关键组件:数据处理-项目采用Hadoop进行大数据预处

- Lambda离线实时分治架构深度解析与实战

喜欢猪猪

架构

一、引言在大数据技术日新月异的今天,Lambda架构作为一种经典的数据处理模型,在应对大规模数据应用方面展现出了强大的能力。它整合了离线批处理和实时流处理,为需要同时处理批量和实时数据的应用场景提供了成熟的解决方案。本文将对Lambda架构的演变、核心组件、工作原理及痛点进行深度解析,并通过Java代码实现一个实战实例。二、Lambda架构的演变Lambda架构是由Storm的作者NathanMa

- “大模型横扫千军”背后的大数据挖掘--浅谈MapReduce

绒绒毛毛雨

大数据挖掘数据挖掘mapreduce人工智能

文章目录O背景知识1数据挖掘2邦费罗尼原则3TF.IDF4哈希函数5分布式文件系统一、MapReduce基本介绍1.Map任务2.按键分组3.Reduce任务4.节点失效处理5.小测验:在一个大型语料库上有100个map任务和若干reduce任务:二、基于MapReduce的基本运算1.选择(Selection)2.交(Intersection)3.并(Union)4.补(Difference)5

- 基于大数据的电影数据分析可视化系统设计与应用

AI架构设计之禅

大数据AI人工智能AI大模型应用入门实战与进阶计算科学神经计算深度学习神经网络大数据人工智能大型语言模型AIAGILLMJavaPython架构设计AgentRPA

基于大数据的电影数据分析可视化系统设计与应用作者:禅与计算机程序设计艺术1.背景介绍1.1大数据时代的电影行业随着互联网技术和数字化的发展,电影行业已经进入大数据时代。每天都有海量的电影相关数据在各个平台上生成,包括票房数据、评分数据、影评数据等。这些数据蕴含着巨大的价值,如果能够有效地分析和利用,将为电影行业的发展提供重要的决策支持。1.2电影数据分析与可视化的意义1.2.1洞察电影市场趋势通过

- Command Center AI

由数入道

应急管理人工智能机器学习智能体

CommandCenterAI是一种先进的智能决策支持系统,专门用于应急指挥和资源调度管理,尤其在高压、复杂的环境中,如自然灾害应对、军事指挥、城市公共安全等领域,帮助决策者做出快速、有效的响应。它集成了大数据处理、实时情报分析、优化调度、决策模拟等功能,为指挥官提供多维度的决策支持。1.CommandCenterAI的核心功能1.1实时数据整合与情报分析CommandCenterAI需要从多个数

- 用 Docker 搭建 Spark 集群

yeasy

BigdataDockersparkDocker云计算集群分布式计算

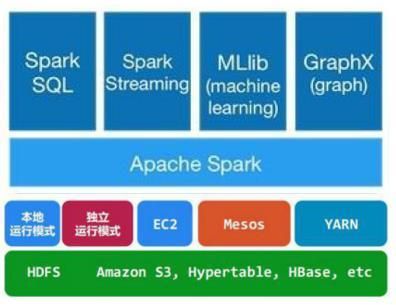

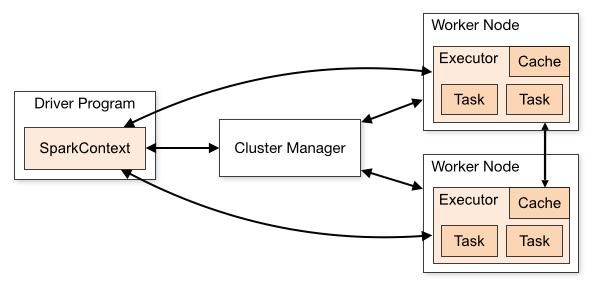

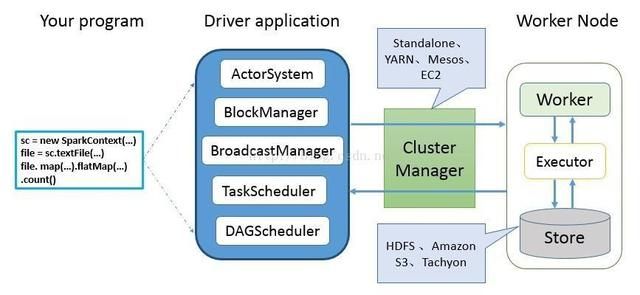

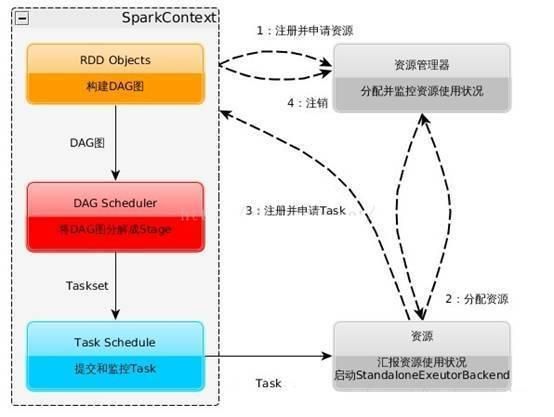

简介Spark是Berkeley开发的分布式计算的框架,相对于Hadoop来说,Spark可以缓存中间结果到内存而提高某些需要迭代的计算场景的效率,目前收到广泛关注。熟悉Hadoop的同学也不必担心,Spark很多设计理念和用法都跟Hadoop保持一致和相似,并且在使用上完全兼容HDFS。但是Spark的安装并不容易,依赖包括Java、Scala、HDFS等。通过使用Docker,可以快速的在本地

- 【2025优质学术推荐】征稿控制科学、仪器、智能系统、通信、计算机、电子信息、人工智能、大数据、机器学习、软件工程、网络安全方向

努力学习的大大

学术会议推荐人工智能大数据深度学习神经网络

【2025优质学术推荐】征稿控制科学、仪器、智能系统、通信、计算机、电子信息、人工智能、大数据、机器学习、软件工程、网络安全方向【2025优质学术推荐】征稿控制科学、仪器、智能系统、通信、计算机、电子信息、人工智能、大数据、机器学习、软件工程、网络安全方向文章目录【2025优质学术推荐】征稿控制科学、仪器、智能系统、通信、计算机、电子信息、人工智能、大数据、机器学习、软件工程、网络安全方向2025

- Github上最热门的11个Java开源项目你会了吗

Java小叮当

项目Github项目java程序员IT

前言4月份GitHub上最热门的Java开源项目排行已经出炉啦,一起来看看吧!1JimuReport(地址见文末)这是一款免费的数据可视化工具,报表与大屏设计!类似于excel操作风格,在线拖拽完成报表设计!功能涵盖:报表设计、图形报表、打印设计、大屏设计等,永久免费!2dolphinscheduler(地址见文末)ApacheDolphinScheduler是一个可视化的分布式大数据工作流任务调

- 2025年新出炉的MySQL面试题

长风清留扬

150道MySQL高频面试题mysql数据库面试sql

作者简介:CSDN\阿里云\腾讯云\华为云开发社区优质创作者,专注分享大数据、Python、数据库、人工智能等领域的优质内容个人主页:长风清留杨的博客形式准则:无论成就大小,都保持一颗谦逊的心,尊重他人,虚心学习。✨推荐专栏:Python入门到入魔,Mysql入门到入魔,Python入门基础大全,Flink入门到实战若缘分至此,无法再续相逢,愿你朝朝暮暮,皆有安好,晨曦微露道早安,日中炽热说午安,

- 精选了几道MySQL的大厂面试题,被提问的几率很高!

长风清留扬

150道MySQL高频面试题mysqlandroid数据库面试学习MySQL面试

作者简介:CSDN\阿里云\腾讯云\华为云开发社区优质创作者,专注分享大数据、Python、数据库、人工智能等领域的优质内容个人主页:长风清留杨的博客形式准则:无论成就大小,都保持一颗谦逊的心,尊重他人,虚心学习。✨推荐专栏:Python入门到入魔,Mysql入门到入魔,Python入门基础大全,Flink入门到实战若缘分至此,无法再续相逢,愿你朝朝暮暮,皆有安好,晨曦微露道早安,日中炽热说午安,

- 有史以来最全的异常类讲解没有之一!第二部分爆肝2万字,终于把Python的异常类写完了!最全Python异常类合集和案例演示,第二部分

长风清留扬

最新Python入门基础合集python笔记学习异常处理改行学it异常BUG

本文是第二部分,第一部分请看:有史以来最全的异常类讲解没有之一!爆肝3万字,终于把Python的异常类写完了!最全Python异常类合集和案例演示,第一部分博客主页:长风清留扬-CSDN博客系列专栏:Python基础专栏每天更新大数据相关方面的技术,分享自己的实战工作经验和学习总结,尽量帮助大家解决更多问题和学习更多新知识,欢迎评论区分享自己的看法感谢大家点赞收藏⭐评论异常类型IndexError

- 有史以来最全的异常类讲解没有之一!第三部分爆肝4万字,终于把Python的异常类写完了!最全Python异常类合集和案例演示,第三部分

长风清留扬

最新Python入门基础合集python面试异常处理BUG异常类型职场和发展改行学it

本文是第三部分,第一第二部分请看:有史以来最全的异常类讲解没有之一!爆肝3万字,终于把Python的异常类写完了!最全Python异常类合集和案例演示,第一部分有史以来最全的异常类讲解没有之一!第二部分爆肝2万字,终于把Python的异常类写完了!最全Python异常类合集和案例演示,第二部分博客主页:长风清留扬-CSDN博客系列专栏:Python基础专栏每天更新大数据相关方面的技术,分享自己的实

- 还在为Python“运算符”中遇到的BUG而发愁吗?,变量相关的问题和解决办法看这篇文章就够了!

长风清留扬

androidpythonbug运算符

博客主页:长风清留扬-CSDN博客系列专栏:Python疑难杂症百科-BUG编年史每天更新大数据相关方面的技术,分享自己的实战工作经验和学习总结,尽量帮助大家解决更多问题和学习更多新知识,欢迎评论区分享自己的看法感谢大家点赞收藏⭐评论关于运算符中常见的问题和解决方法在Python编程的浩瀚宇宙中,变量如同星辰般璀璨,它们承载着数据,驱动着程序的运行。然而,即便是这些看似简单的构建块,也时常隐藏着令

- 金融数据有哪些,有用的股票API接口数据

nance99

金融pythongit

一、金融数据有哪些,有用的股票API接口行情数据金融大数据是为金融机构、个人投资者以及金融应用开发者提供专业的数据和行情报价API服务,满足不同用户在投资过程中丰富多样的行情数据分析和投资研究,以API接口形式为用户提供行情数据API服务,提供的数据包括市场行情、财报、宏观等,还有基于文本分析的股票关联数据。对金融机构或者投资者而言,金融数据是企业财富。实时数据对企业成功至关重要,股票行情数据种类

- 2024 年 MathorCup 数学应用挑战赛——大数据竞赛 赛道 B:电商品类货量预测及品类分仓规划 思路和代码 持续更新中

2025年数学建模美赛

数学建模2024年大数据第五届MathorCupB题

2024年所有数学建模类比赛的个人思路和代码都会发布到专栏内,会结合最新的chatgpt发布思路,开赛一天后恢复原价99,不代写论文,不回复私信.没有群,只需订阅一次目录问题分析与解决思路问题1:货量预测模型问题2:一品一仓分仓规划问题3:一品多仓分仓规划总结这类大数据竞赛的重点在于构建一个全面的预测和优化模型,通过数据处理、时间序列分析以及运筹优化来完成货量预测和分仓规划。下面是一个解决问题的整

- 基于知识图谱的用户画像构建与应用

cooldream2009

AI技术知识图谱知识图谱人工智能

目录前言1.知识图谱在用户画像中的作用1.1数据整合与清洗1.2多维关系挖掘1.3动态更新能力1.4可解释性2.用户画像构建过程中的知识图谱应用2.1数据采集2.2知识图谱构建2.2.1实体节点构建2.2.2关系建模2.3用户画像生成2.3.1静态特征2.3.2动态特征2.3.3关系网络3.基于知识图谱的用户画像应用场景3.1精准营销3.2内容推荐3.3用户需求预测3.4风险控制结语前言随着大数据

- 智能运维分析决策系统:赋能数字化转型的智慧引擎

我的运维人生

运维运维开发技术共享

智能运维分析决策系统:赋能数字化转型的智慧引擎在数字化转型的大潮中,企业运维管理正经历着从传统手动运维向智能化、自动化运维的深刻转变。智能运维分析决策系统(AIOps,ArtificialIntelligenceforITOperations)作为这一转变的核心驱动力,通过融合大数据、机器学习、人工智能等先进技术,实现了对运维数据的深度洞察与智能决策,极大地提升了运维效率与质量,为企业数字业务的连

- 第11篇:你知道ElasticSearch聚合分析能力有多强?

老王随聊

elasticsearch搜索引擎大数据

背景:目前国内有大量的公司都在使用Elasticsearch,包括阿里、京东、滴滴、今日头条、小米、vivo等诸多知名公司。除了搜索功能之外,Elasticsearch还结合Kibana、Logstash、ElasticStack还被广泛运用在大数据近实时分析领域,包括日志分析、指标监控等多个领域。本节内容:ElasticSearch强悍聚合分析能力详解。目录1、ES的聚合Aggregations

- Elasticsearch聚合分析:未来发展趋势

AI天才研究院

计算AI大模型企业级应用开发实战ChatGPT计算科学神经计算深度学习神经网络大数据人工智能大型语言模型AIAGILLMJavaPython架构设计AgentRPA

1.背景介绍1.1大数据时代的分析需求随着互联网、物联网、移动互联网等技术的快速发展,全球数据量呈现爆炸式增长,我们正步入一个前所未有的大数据时代。海量数据的背后蕴藏着巨大的商业价值,如何高效地存储、管理、分析和挖掘这些数据,成为企业和组织面临的重大挑战。1.2Elasticsearch:分布式搜索和分析引擎Elasticsearch作为一个开源的分布式搜索和分析引擎,凭借其高性能、可扩展性和易用

- 软件工程之信息系统集成

我叫吴桂鑫

计算机基础知识软件工程信息系统集成

现在的软件开发工作大多数是集成,所有部分都从头开发效率会很低,问题也会更多,成本也会更高。系统集成就是将各类资源有机、高效地整合到一起,形成一个完整的系统。信息系统集成包括网络集成、数据集成和应用集成等。网络集成、数据集成和应用集成分别用于解决系统的互连性、互通性和互操作性。(1)网络集成(企业局域网)重点是系统中异构网络的互连。(2)数据集成(大数据)重点是系统中异构数据集的互通使用和统一管理。

- 网络安全态势感知:企业数字化转型的 “安全密钥”

知白守黑V

安全运营网络安全态势感知网络

在数字经济飞速发展的当下,网络安全已经成为企业平稳运营的关键所在。从大型企业的数据泄露事故,到中小企业遭遇的各类网络攻击,网络安全威胁无处不在。而网络安全态势感知产品,作为应对复杂网络威胁的关键技术,正逐渐成为企业守护数字资产的“智慧大脑”。一、态势感知:全景掌控,精准防御你可以把网络安全态势感知想象成企业网络的“超级侦察兵”。它借助大数据分析、机器学习这些先进技术,就像是拥有了超级强大的“洞察力

- Apache Flink 替换 Spark Stream的架构与实践( bilibili 案例解读)_streamsparkflink加载udf

2501_90243308

apacheflinkspark

3.基于ApacheFlink的流式计算平台为解决上述问题,bilibili希望根据以下三点要求构建基于ApacheFlink的流式计算平台。第一点,需要提供SQL化编程。bilibili对SQL进行了扩展,称为BSQL。BSQL扩展了Flink底层SQL的上层,即SQL语法层。**第二点,**DAG拖拽编程,一方面用户可以通过画板来构建自己的Pipeline,另一方面用户也可以使用原生Jar方式

- apache ftpserver-CentOS config

gengzg

apache

<server xmlns="http://mina.apache.org/ftpserver/spring/v1"

xmlns:xsi="http://www.w3.org/2001/XMLSchema-instance"

xsi:schemaLocation="

http://mina.apache.o

- 优化MySQL数据库性能的八种方法

AILIKES

sqlmysql

1、选取最适用的字段属性 MySQL可以很好的支持大数据量的存取,但是一般说来,数据库中的表越小,在它上面执行的查询也就会越快。因此,在创建表的时候,为了获得更好的 性能,我们可以将表中字段的宽度设得尽可能小。例如,在定义邮政编码这个字段时,如果将其设置为CHAR(255),显然给数据库增加了不必要的空间,甚至使用VARCHAR这种类型也是多余的,因为CHAR(6)就可以很

- JeeSite 企业信息化快速开发平台

Kai_Ge

JeeSite

JeeSite 企业信息化快速开发平台

平台简介

JeeSite是基于多个优秀的开源项目,高度整合封装而成的高效,高性能,强安全性的开源Java EE快速开发平台。

JeeSite本身是以Spring Framework为核心容器,Spring MVC为模型视图控制器,MyBatis为数据访问层, Apache Shiro为权限授权层,Ehcahe对常用数据进行缓存,Activit为工作流

- 通过Spring Mail Api发送邮件

120153216

邮件main

原文地址:http://www.open-open.com/lib/view/open1346857871615.html

使用Java Mail API来发送邮件也很容易实现,但是最近公司一个同事封装的邮件API实在让我无法接受,于是便打算改用Spring Mail API来发送邮件,顺便记录下这篇文章。 【Spring Mail API】

Spring Mail API都在org.spri

- Pysvn 程序员使用指南

2002wmj

SVN

源文件:http://ju.outofmemory.cn/entry/35762

这是一篇关于pysvn模块的指南.

完整和详细的API请参考 http://pysvn.tigris.org/docs/pysvn_prog_ref.html.

pysvn是操作Subversion版本控制的Python接口模块. 这个API接口可以管理一个工作副本, 查询档案库, 和同步两个.

该

- 在SQLSERVER中查找被阻塞和正在被阻塞的SQL

357029540

SQL Server

SELECT R.session_id AS BlockedSessionID ,

S.session_id AS BlockingSessionID ,

Q1.text AS Block

- Intent 常用的用法备忘

7454103

.netandroidGoogleBlogF#

Intent

应该算是Android中特有的东西。你可以在Intent中指定程序 要执行的动作(比如:view,edit,dial),以及程序执行到该动作时所需要的资料 。都指定好后,只要调用startActivity(),Android系统 会自动寻找最符合你指定要求的应用 程序,并执行该程序。

下面列出几种Intent 的用法

显示网页:

- Spring定时器时间配置

adminjun

spring时间配置定时器

红圈中的值由6个数字组成,中间用空格分隔。第一个数字表示定时任务执行时间的秒,第二个数字表示分钟,第三个数字表示小时,后面三个数字表示日,月,年,< xmlnamespace prefix ="o" ns ="urn:schemas-microsoft-com:office:office" />

测试的时候,由于是每天定时执行,所以后面三个数

- POJ 2421 Constructing Roads 最小生成树

aijuans

最小生成树

来源:http://poj.org/problem?id=2421

题意:还是给你n个点,然后求最小生成树。特殊之处在于有一些点之间已经连上了边。

思路:对于已经有边的点,特殊标记一下,加边的时候把这些边的权值赋值为0即可。这样就可以既保证这些边一定存在,又保证了所求的结果正确。

代码:

#include <iostream>

#include <cstdio>

- 重构笔记——提取方法(Extract Method)

ayaoxinchao

java重构提炼函数局部变量提取方法

提取方法(Extract Method)是最常用的重构手法之一。当看到一个方法过长或者方法很难让人理解其意图的时候,这时候就可以用提取方法这种重构手法。

下面是我学习这个重构手法的笔记:

提取方法看起来好像仅仅是将被提取方法中的一段代码,放到目标方法中。其实,当方法足够复杂的时候,提取方法也会变得复杂。当然,如果提取方法这种重构手法无法进行时,就可能需要选择其他

- 为UILabel添加点击事件

bewithme

UILabel

默认情况下UILabel是不支持点击事件的,网上查了查居然没有一个是完整的答案,现在我提供一个完整的代码。

UILabel *l = [[UILabel alloc] initWithFrame:CGRectMake(60, 0, listV.frame.size.width - 60, listV.frame.size.height)]

- NoSQL数据库之Redis数据库管理(PHP-REDIS实例)

bijian1013

redis数据库NoSQL

一.redis.php

<?php

//实例化

$redis = new Redis();

//连接服务器

$redis->connect("localhost");

//授权

$redis->auth("lamplijie");

//相关操

- SecureCRT使用备注

bingyingao

secureCRT每页行数

SecureCRT日志和卷屏行数设置

一、使用securecrt时,设置自动日志记录功能。

1、在C:\Program Files\SecureCRT\下新建一个文件夹(也就是你的CRT可执行文件的路径),命名为Logs;

2、点击Options -> Global Options -> Default Session -> Edite Default Sett

- 【Scala九】Scala核心三:泛型

bit1129

scala

泛型类

package spark.examples.scala.generics

class GenericClass[K, V](val k: K, val v: V) {

def print() {

println(k + "," + v)

}

}

object GenericClass {

def main(args: Arr

- 素数与音乐

bookjovi

素数数学haskell

由于一直在看haskell,不可避免的接触到了很多数学知识,其中数论最多,如素数,斐波那契数列等,很多在学生时代无法理解的数学现在似乎也能领悟到那么一点。

闲暇之余,从图书馆找了<<The music of primes>>和<<世界数学通史>>读了几遍。其中素数的音乐这本书与软件界熟知的&l

- Java-Collections Framework学习与总结-IdentityHashMap

BrokenDreams

Collections

这篇总结一下java.util.IdentityHashMap。从类名上可以猜到,这个类本质应该还是一个散列表,只是前面有Identity修饰,是一种特殊的HashMap。

简单的说,IdentityHashMap和HashM

- 读《研磨设计模式》-代码笔记-享元模式-Flyweight

bylijinnan

java设计模式

声明: 本文只为方便我个人查阅和理解,详细的分析以及源代码请移步 原作者的博客http://chjavach.iteye.com/

import java.util.ArrayList;

import java.util.Collection;

import java.util.HashMap;

import java.util.List;

import java

- PS人像润饰&调色教程集锦

cherishLC

PS

1、仿制图章沿轮廓润饰——柔化图像,凸显轮廓

http://www.howzhi.com/course/retouching/

新建一个透明图层,使用仿制图章不断Alt+鼠标左键选点,设置透明度为21%,大小为修饰区域的1/3左右(比如胳膊宽度的1/3),再沿纹理方向(比如胳膊方向)进行修饰。

所有修饰完成后,对该润饰图层添加噪声,噪声大小应该和

- 更新多个字段的UPDATE语句

crabdave

update

更新多个字段的UPDATE语句

update tableA a

set (a.v1, a.v2, a.v3, a.v4) = --使用括号确定更新的字段范围

- hive实例讲解实现in和not in子句

daizj

hivenot inin

本文转自:http://www.cnblogs.com/ggjucheng/archive/2013/01/03/2842855.html

当前hive不支持 in或not in 中包含查询子句的语法,所以只能通过left join实现。

假设有一个登陆表login(当天登陆记录,只有一个uid),和一个用户注册表regusers(当天注册用户,字段只有一个uid),这两个表都包含

- 一道24点的10+种非人类解法(2,3,10,10)

dsjt

算法

这是人类算24点的方法?!!!

事件缘由:今天晚上突然看到一条24点状态,当时惊为天人,这NM叫人啊?以下是那条状态

朱明西 : 24点,算2 3 10 10,我LX炮狗等面对四张牌痛不欲生,结果跑跑同学扫了一眼说,算出来了,2的10次方减10的3次方。。我草这是人类的算24点啊。。

然后么。。。我就在深夜很得瑟的问室友求室友算

刚出完题,文哥的暴走之旅开始了

5秒后

- 关于YII的菜单插件 CMenu和面包末breadcrumbs路径管理插件的一些使用问题

dcj3sjt126com

yiiframework

在使用 YIi的路径管理工具时,发现了一个问题。 <?php

- 对象与关系之间的矛盾:“阻抗失配”效应[转]

come_for_dream

对象

概述

“阻抗失配”这一词组通常用来描述面向对象应用向传统的关系数据库(RDBMS)存放数据时所遇到的数据表述不一致问题。C++程序员已经被这个问题困扰了好多年,而现在的Java程序员和其它面向对象开发人员也对这个问题深感头痛。

“阻抗失配”产生的原因是因为对象模型与关系模型之间缺乏固有的亲合力。“阻抗失配”所带来的问题包括:类的层次关系必须绑定为关系模式(将对象

- 学习编程那点事

gcq511120594

编程互联网

一年前的夏天,我还在纠结要不要改行,要不要去学php?能学到真本事吗?改行能成功吗?太多的问题,我终于不顾一切,下定决心,辞去了工作,来到传说中的帝都。老师给的乘车方式还算有效,很顺利的就到了学校,赶巧了,正好学校搬到了新校区。先安顿了下来,过了个轻松的周末,第一次到帝都,逛逛吧!

接下来的周一,是我噩梦的开始,学习内容对我这个零基础的人来说,除了勉强完成老师布置的作业外,我已经没有时间和精力去

- Reverse Linked List II

hcx2013

list

Reverse a linked list from position m to n. Do it in-place and in one-pass.

For example:Given 1->2->3->4->5->NULL, m = 2 and n = 4,

return

- Spring4.1新特性——页面自动化测试框架Spring MVC Test HtmlUnit简介

jinnianshilongnian

spring 4.1

目录

Spring4.1新特性——综述

Spring4.1新特性——Spring核心部分及其他

Spring4.1新特性——Spring缓存框架增强

Spring4.1新特性——异步调用和事件机制的异常处理

Spring4.1新特性——数据库集成测试脚本初始化

Spring4.1新特性——Spring MVC增强

Spring4.1新特性——页面自动化测试框架Spring MVC T

- Hadoop集群工具distcp

liyonghui160com

1. 环境描述

两个集群:rock 和 stone

rock无kerberos权限认证,stone有要求认证。

1. 从rock复制到stone,采用hdfs

Hadoop distcp -i hdfs://rock-nn:8020/user/cxz/input hdfs://stone-nn:8020/user/cxz/运行在rock端,即源端问题:报版本

- 一个备份MySQL数据库的简单Shell脚本

pda158

mysql脚本

主脚本(用于备份mysql数据库): 该Shell脚本可以自动备份

数据库。只要复制粘贴本脚本到文本编辑器中,输入数据库用户名、密码以及数据库名即可。我备份数据库使用的是mysqlump 命令。后面会对每行脚本命令进行说明。

1. 分别建立目录“backup”和“oldbackup” #mkdir /backup #mkdir /oldbackup

- 300个涵盖IT各方面的免费资源(中)——设计与编码篇

shoothao

IT资源图标库图片库色彩板字体

A. 免费的设计资源

Freebbble:来自于Dribbble的免费的高质量作品。

Dribbble:Dribbble上“免费”的搜索结果——这是巨大的宝藏。

Graphic Burger:每个像素点都做得很细的绝佳的设计资源。

Pixel Buddha:免费和优质资源的专业社区。

Premium Pixels:为那些有创意的人提供免费的素材。

- thrift总结 - 跨语言服务开发

uule

thrift

官网

官网JAVA例子

thrift入门介绍

IBM-Apache Thrift - 可伸缩的跨语言服务开发框架

Thrift入门及Java实例演示

thrift的使用介绍

RPC

POM:

<dependency>

<groupId>org.apache.thrift</groupId>