UTA研究团队提出首个3D点云+GAN新方法,让机器人“眼神”更犀利 | AI日报

![]()

韩国NAVER AI LAB重新标注128万张ImageNet图片:多标签,全面提升模型性能

ImageNet是机器学习社区最流行的图像分类基准数据集,包含超过1400张标注图像。该数据集由斯坦福教授李飞飞等人于2006年开始创建,后成为评估计算机视觉模型在下游视觉任务中能力的试金石。

然而ImageNet并不完美,其标签存在大量噪声。近期多项研究表明,该数据集中许多样本包含多个类别,而ImageNet本身是一个单标签基准数据集。一些研究者提出将 ImageNet 转换为多标签任务评估基准,但是可能是由于标注成本过高,他们并未修复训练集。

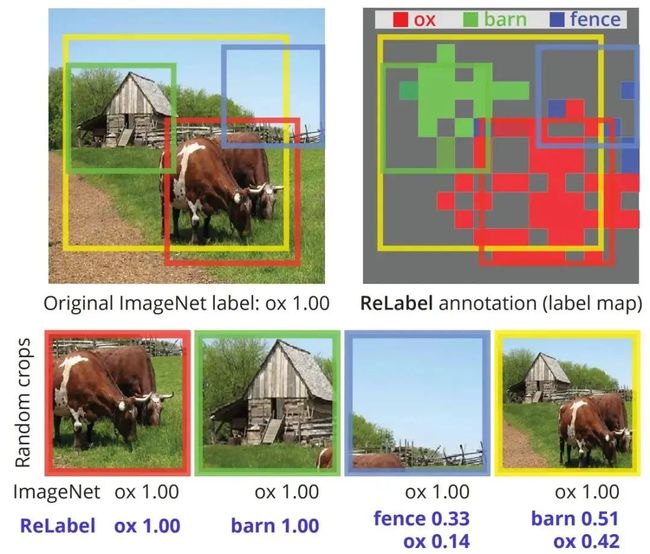

在近日发布的一篇论文中,来自韩国NAVER AI LAB的研究者认为,在应用了随机剪裁的训练设置下,单标签标注和高效多标签图像之间的不匹配带来了同等问题。在使用单标签标注时,图像随机剪裁可能包含与真值完全不同的对象,为训练带来噪声甚至不准确的监督信号。

为此,这些研究者决定使用多标签对ImageNet训练集进行重新标注:他们在额外的数据源上训练了一个强大的图像分类器,使用其生成多标签,解决了标注成本问题;在最终池化层之前使用像素级多标签预测,以充分利用额外的位置特定监督信号。

图注:原始ImageNet标签(左上)与本文ReLabel标注器的效果对比

图注:原始ImageNet标签(左上)与本文ReLabel标注器的效果对比

基于重新标注样本的训练可以全面提升模型性能。例如,使用该研究提出的局部多标签后,ResNet-50在ImageNet 上的top-1分类准确率达到 78.9%,使用CutMix正则化后还可以进一步提升至 80.2%。实验表明,使用局部多标签训练的模型在迁移至目标检测和实例分割任务以及多种稳健性基准时,性能优于基线方法。此外,研究者还开源了重新标注的 ImageNet 训练集、预训练权重和源代码。

论文地址:

https://arxiv.org/pdf/2101.05022.pdf

GitHub 地址:

https://github.com/naver-ai/relabel_imagenet

OpenAI CLIP模型新尝试,有开发者在Colab上实现近200万图片的精准检索匹配

本月初,OpenAI同时发布了两个连接文本与图像的神经网络:DALL·E 和 CLIP。其中,DALL·E 可以基于文本直接生成图像,CLIP能够完成图像与文本类别的匹配。这两个模型发布之后,机器学习社区出现了一些复现DALL·E模型的尝试,如开发者Phil Wang的GitHub项目 DALLE-pytorch,短短二十余天就收获了1.9k star。

近日,又有开发者创建了一个利用CLIP模型搜索文本精准匹配图片的项目。该项目所有图片出自Unsplash数据集,大约有200万张,利用CLIP模型进行处理。项目既可以在给定的免费谷歌 Colab notebook中运行,也可以在用户自己的机器上运行。

在具体实现上,项目作者在 Colab Notebook上将所有图片处理成了预计算特征向量,然后找到与自然语言搜索查询(即输入的文本)最匹配的图片。

项目作者提供了一些效果展示图,如输入搜索词条「"Two dogs playing in the snow"」,就会出现以下几幅图片:

项目地址:https://github.com/haltakov/natural-language-image-search#two-dogs-playing-in-the-snow

UTA研究团队提出首个3D点云+GAN新方法,让机器人“眼神”更犀利

近日,来自德克萨斯大学阿灵顿分校(University of Texas at Arlington,UTA)的一个研究团队,提出了一种名为PCGAN的方法。据研究人员介绍,这是第一个以无监督方式生成3D点云(3D point cloud)的条件生成对抗网络(GAN),该网络能够产生具有多分辨率和精细细节的3D彩色点云,以生成利于辨别的物体图像,这将极有利于机器人视觉灵敏度的提升。如下图。

图注:real列为真实物体的3D点云图像,后列为PCGAN产生的的结果

图注:real列为真实物体的3D点云图像,后列为PCGAN产生的的结果

整个研究小组由UTA的计算机科学与工程学系助理教授William Beksi和他的六名博士学生组成。参与这项研究的博士生Mohammad Samiul Arshad表示:“手动设计这些对象将耗费大量资源和人力,而如果进行适当的培训,生成网络就可以在几秒钟之内完成同样的任务。”

此次研究中的图像数据则通过3D点云呈现,这是一种透过3D扫描器所取得的物体图像形式,它以点的形式记录对象,每一个点包含有三维座标,强度信息(可以反映目标物体的材质、粗糙度、入射角方向等信息),还可能含有色彩信息(RGB)。

对此,Beksi 解释道:“我们可以将它们移动到新位置,甚至使用不同的灯光、颜色和纹理,将它们渲染为可在数据集中使用的训练图像。这种方法可能会提供无限的数据来训练机器人。”接下来,Beksi团队希望将软件部署在机器人上,并查看它与模拟真实的领域之间还存在何种差距。

论文标题:A Progressive Conditional Generative Adversarial Network for Generating Dense and Colored 3D Point Clouds

论文地址:https://arxiv.org/abs/2010.05391

南加州大学华人博士创建小工具Rebiber,可规范arXiv论文引用信息

伴随着预印本平台arXiv的广泛使用,越来越多的研究者喜欢在写论文参考文献时直接使用arXiv信息。这看似非常方便,但也存在问题:这篇arXiv论文是否在ACL、EMNLP、NAACL、ICLR 或 AAAI等学术会议上发表过?

没错,在某些情况下,只引用arXiv信息显得不那么准确,这种不准确的文献条目甚至可能会违反某些会议的论文提交或camera-ready版本提交规则。

如何解决这一问题呢?最近,上交毕业生、南加州大学博士生林禹臣开发了一个简单的 Python 工具——Rebiber,它能够基于ACL Anthology 和DBLP数据库自动解决这一问题。

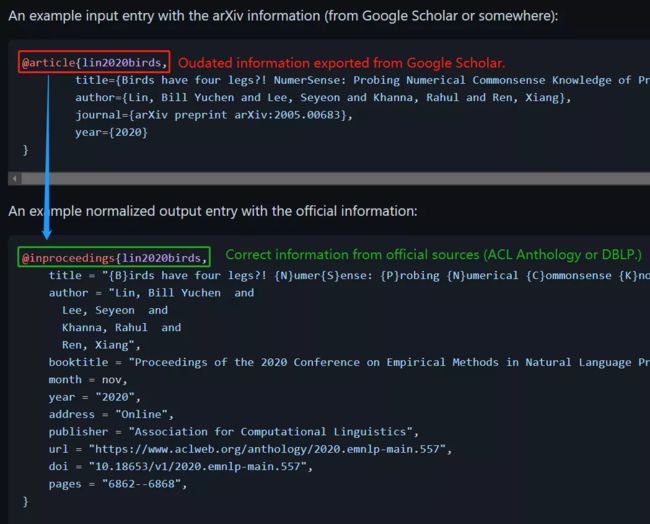

下图展示了Rebiber的使用示例:

在该示例中,文章的原始信息来自Google Scholar,仅包括标题、作者、期刊(arXiv)、年份。而事实上该论文已被EMNLP 2020接收,原始信息显然不够准确。

经过Rebiber转换后,原始 arXiv 信息被转换为来自正式来源的准确信息,包括标题、作者、年月、出版商、数字对象识别码(doi)、网址等详细内容。

Rebiber支持的会议包括 ACL Anthology涵盖的会议,如 ACL、EMNLP、NAACL 及其 workshop,以及DBLP涵盖的会议,如 ICLR 2020。

项目地址:https://github.com/yuchenlin/rebiber

朱松纯教授创办公司暗物智能完成5亿A轮融资

今日,强认知人工智能平台企业暗物智能科技(以下简称“暗物智能”)官网宣布,已于2020年年中完成5亿元人民币的A轮融资。本轮融资由赛领资本和吉富创投共同领投,联想创投、广州基金、将门创投、花城创投跟投。

暗物智能由全球著名计算机视觉专家、统计与应用数学家、人工智能专家朱松纯教授于2017年创办。公司基于朱松纯提出的“小数据、大任务”技术范式,以人机交互与跨领域融合为主攻方向,致力于打造新一代基于强认知的人工智能技术平台,并通过与教育、新零售等垂直行业深度融合,构建以强认知AI为核心的产业生态。

朱松纯认为,人工智能应用进入深水区,AI从感知走向认知是必然趋势。他指出:“教育等垂直领域的智能化升级需求与强认知AI的深度人机互动、个性化服务等能力高度契合,是拥有广阔市场和技术纵深的赛道,强认知AI的赋能也将产生巨大的社会价值。”

据悉,暗物智能本轮融资将用于继续加大公司在新一代强认知AI领域的研发投入,在巩固核心技术平台的领先性的同时,完善在智慧教育等领域的商业布局,并深入更多垂直场景。

![]()

点击左下角“阅读原文”,了解更多!