深度神经网络DNN(一)——感知机

文章目录

- 感知机的概念

- 逻辑电路实现

- 感知机的实现

- 感知机的局限性

- 多层感知机

- 感知机与计算机

- 小结

感知机的概念

感知机接收多个输入信号,输出一个信号。这里所说的“信号”可以想象成电流或河流那样具备“流动性”的东西。和实际的电流不同的是,感知机的信号只有“流/ 不流”(1/0)两种取值。0对应“不传递信号”,1 对应“传递信号”。

下图是一个接收两个输入信号的感知机的例子。x1、x2是输入信号,y是输出信号,w1、w2是权重。图中的○称为“神经元”或者“节点”。输入信号被送往神经元时,会被分别乘以固定的权(w1x1、w2x2)。神经元会计算传送过来的信号的总和,只有当这个总和超过了某个界限值时,才会输出1。这也称为“神经元被激活” 。这里将这个界限值称为阈值,用符号θ表示。

把上述内容用数学式来表示,就是下式:

y = { 0 ( w 1 x 1 + w 2 x 2 ≤ θ ) 1 ( w 1 x 1 + w 2 x 2 > θ ) y=\begin{cases} 0 \text{ } (w_{1}x_{1}+w_{2}x_{2}\leθ) \\ 1 \text{ } (w_{1}x_{1}+w_{2}x_{2}>θ) \end{cases} y={ 0 (w1x1+w2x2≤θ)1 (w1x1+w2x2>θ)

感知机的多个输入信号都有各自固有的权重,这些权重发挥着控制各个信号的重要性的作用。也就是说,权重越大,对应该权重的信号的重要性就越高。

逻辑电路实现

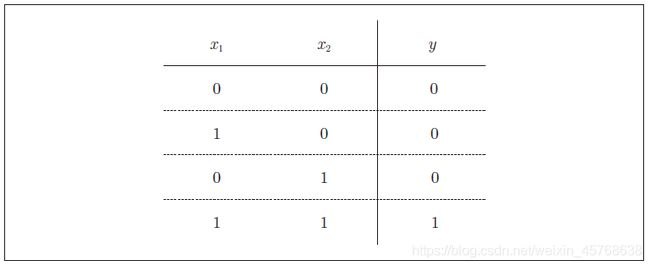

- 与门(AND gate)

与门是有两个输入和一个输出的门电路。下图是这种输入信号和输出信号的真值表:

下面考虑用感知机来表示这个与门。需要做的就是确定能满足上图的真值表的w1、w2、θ 的值。实际上,满足上图的条件的参数的选择方法有无数多个:当(w1, w2, θ) = (0.5, 0.5, 0.7) 时,可以满足;当(w1, w2, θ)为(0.5, 0.5, 0.8) 或者(1.0, 1.0, 1.0) 时,同样也满足与门的条件。设定这样的参数后,仅当x1和x2同时为1时,信号的加权总和才会超过给定的阈值θ。

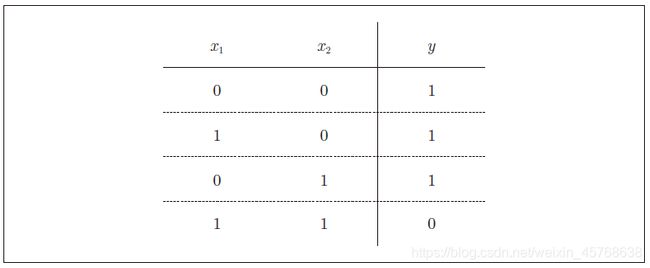

2. 与非门(NAND gate)

与非门就是颠倒了与门的输出。用真值表表示的话,如下图所示,仅当x1和x2同时为1时输出0,其他时候则输出1。

要表示与非门,可以用(w1, w2, θ) = (−0.5, −0.5, −0.7) 这样的组合。实际上,只要把实现与门的参数值的符号取反,就可以实现与非门。

3. 或门(OR gate)

或门是“只要有一个输入信号是1,输出就为1”的逻辑电路

这里决定感知机参数的并不是计算机,而是我们人。我们看着真值表这种“训练数据”,人工考虑(想到)了参数的值。而机器学习的课题就是将这个决定参数值的工作交由计算机自动进行。学习是确合适的参数的过程,而人要做的是思考感知机的构造(模型),并把训练数据交给计算机。

这里重要的一点是:与门、与非门、或门的感知机构造是一样的。实际上,3 个门电路只有参数的值(权重和阈值)不同。也就是说,相同构造的感知机,只需通过适当地调整参数的值,就可以像“变色龙演员”表演不同的角色一样,变身为与门、与非门、或门。

感知机的实现

- 简单实现

用Python 来实现刚才的逻辑电路。先定义一个接收参数x1和x2的AND函数:

def AND(x1, x2):

w1, w2, theta = 0.5, 0.5, 0.7

tmp = x1*w1 + x2*w2

if tmp <= theta:

return 0

elif tmp > theta:

return 1

AND(0, 0) # 输出0

AND(1, 0) # 输出0

AND(0, 1) # 输出0

AND(1, 1) # 输出1

果然和我们预想的输出一样!这样我们就实现了与门。按照同样的步骤,也可以实现与非门和或门,不过让我们来对它们的实现稍作修改。

2. 导入权重和偏置

把上述公式中的θ换成−b,于是就可以用下式来表示感知机的行为:

y = { 0 ( w 1 x 1 + w 2 x 2 + b ≤ 0 ) 1 ( w 1 x 1 + w 2 x 2 + b > 0 ) y=\begin{cases} 0 \text{ } (w_{1}x_{1}+w_{2}x_{2}+b\le0) \\ 1 \text{ } (w_{1}x_{1}+w_{2}x_{2}+b>0) \end{cases} y={ 0 (w1x1+w2x2+b≤0)1 (w1x1+w2x2+b>0)

上述两式虽然有一个符号不同,但表达的内容是完全相同的。此处,b 称为偏置,w1和w2称为权重。感知机会计算输入信号和权重的乘积,然后加上偏置,如果这个值大于0则输出1,否则输出0。下面,我们使用NumPy来实现感知机:

>>> import numpy as np

>>> x = np.array([0, 1]) # 输入

>>> w = np.array([0.5, 0.5]) # 权重

>>> b = -0.7 # 偏置

>>> w*x

array([ 0. , 0.5])

>>> np.sum(w*x)

0.5

>>> np.sum(w*x) + b

-0.19999999999999996 # 大约为-0.2(由浮点小数造成的运算误差)

在NumPy数组的乘法运算中,当两个数组的元素个数相同时,各个元素分别相乘,因此w * x的结果就是它们的各个元素分别相乘([0, 1] * [0.5, 0.5] => [0, 0.5])。之后,np.sum(w * x)再计算相乘后的各个元素的总和。最后再把偏置加到这个加权总和上,就完成了上式的计算。

3. 使用权重和偏置的实现门电路

def AND(x1, x2):

x = np.array([x1, x2])

w = np.array([0.5, 0.5])

b = -0.7

tmp = np.sum(w*x) + b

if tmp <= 0:

return 0

else:

return 1

这里把−θ命名为偏置b,但偏置和权重w1、w2的作用是不一样的。w1和w2是控制输入信号的重要性的参数,而偏置是调整神经元被激活的容易程度(输出信号为1 的程度)的参数。比如,若b 为−0.1,则只要输入信号的加权总和超过0.1,神经元就会被激活。但是如果b为−20.0,则输入信号的加权总和必须超过20.0,神经元才会被激活。

接着,我们继续实现与非门和或门:

def NAND(x1, x2):

x = np.array([x1, x2])

w = np.array([-0.5, -0.5]) # 仅权重和偏置与AND不同!

b = 0.7

tmp = np.sum(w*x) + b

if tmp <= 0:

return 0

else:

return 1

def OR(x1, x2):

x = np.array([x1, x2])

w = np.array([0.5, 0.5]) # 仅权重和偏置与AND不同!

b = -0.2

tmp = np.sum(w*x) + b

if tmp <= 0:

return 0

else:

return 1

感知机的局限性

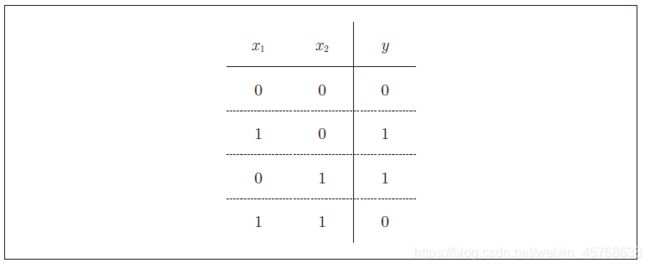

- 异或门实现的困境

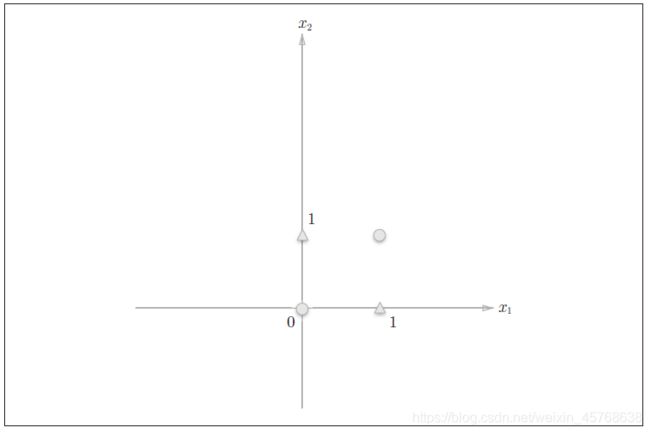

现在我们来考虑一下异或门(XOR gate)。异或门也被称为逻辑异或电路。如下图所示,仅当x1或x2中的一方为1时,才会输出1(“异或”是拒绝其他的意思)

实际上,用前面介绍的感知机是无法实现这个异或门的。我们尝试通过画图来思考其中的原因。

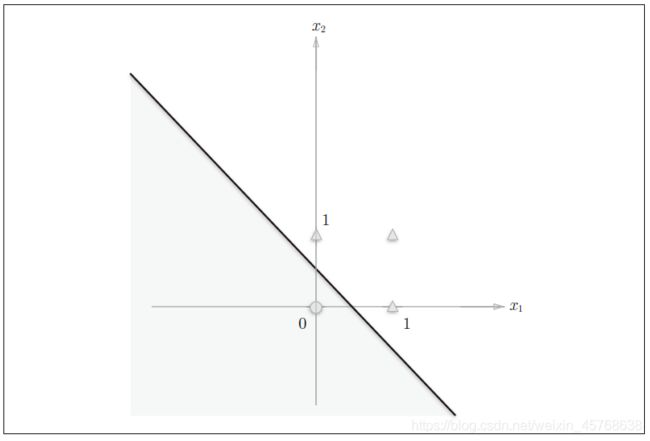

首先,我们试着将或门的动作形象化。或门的情况下,当权重参数(b, w1, w2) = (−0.5, 1.0, 1.0) 时,可满足或门真值表条件。此时,感知机可用下面的式表示

y = { 0 ( x 1 + x 2 − 0.5 ≤ 0 ) 1 ( x 1 + x 2 − 0.5 > 0 ) y=\begin{cases} 0 \text{ } (x_{1}+x_{2}-0.5\le0) \\ 1 \text{ } (x_{1}+x_{2}-0.5>0) \end{cases} y={ 0 (x1+x2−0.5≤0)1 (x1+x2−0.5>0)

上式表示的感知机会生成由直线 x1 + x2 − 0.5 = 0 分割开的两个空间。其中一个空间输出1,另一个空间输出0

或门在(x1, x2) = (0, 0) 时输出0,在(x1, x2) 为(0, 1)、(1, 0)、(1, 1) 时输出1。上图中,○表示0,△表示1。如果想制作或门,需要用直线将上图中的○和△分开。实际上,刚才的那条直线就将这4 个点正确地分开了。

那么,换成异或门的话会如何呢?能否像或门那样,用一条直线作出分割下图中的○和△的空间呢?

想要用一条直线将上图中的○和△分开,无论如何都做不到。

2. 线性和非线性

上图中的○和△无法用一条直线分开,但是如果将“直线”这个限制条件去掉,就可以实现了。比如,我们可以像下图 那样,作出分开○和△的空间。

感知机的局限性就在于它只能表示由一条直线分割的空间。上图这样弯曲的曲线无法用感知机表示

由上图这样的曲线分割而成的空间称为非线性空间,由直线分割而成的空间称为线性空间

线性、非线性这两个术语在机器学习领域很常见,可以将其想象成上图所示的直线和曲线。

多层感知机

感知机的绝妙之处在于它可以“叠加层”

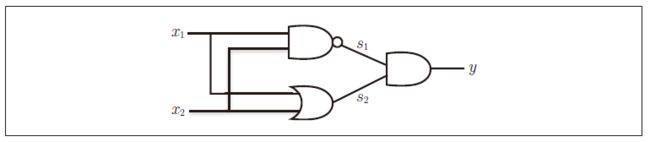

异或门的制作方法有很多,其中之一就是组合我们前面做好的与门、与非门、或门进行配置。这里,与门、与非门、或门用下图中的符号表示。另外,下图中与非门前端的○表示反转输出的意思。

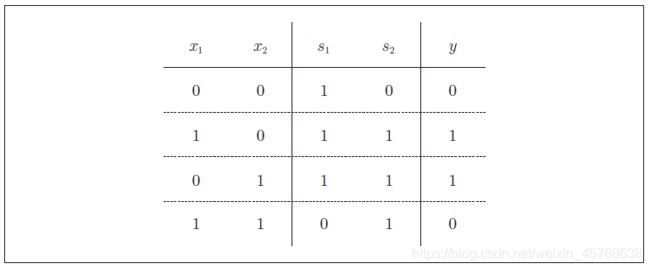

异或门可以通过下图所示的配置来实现。这里,x1和x2表示输入信号,y表示输出信号。x1和x2是与非门和或门的输入,而与非门和或门的输出则是与门的输入。

现在,我们来确认一下上图 的配置是否真正实现了异或门。这里,把s1作为与非门的输出,把s2作为或门的输出,填入真值表中。结果如下图所示,观察x1、x2、y,可以发现确实符合异或门的输出。

下面我们试着用Python来实现上图所示的异或门。使用之前定义的

AND函数、NAND函数、OR函数,可以像下面这样实现:

def XOR(x1, x2):

s1 = NAND(x1, x2)

s2 = OR(x1, x2)

y = AND(s1, s2)

return y

XOR(0, 0) # 输出0

XOR(1, 0) # 输出1

XOR(0, 1) # 输出1

XOR(1, 1) # 输出0

这样,异或门的实现就完成了。下面我们试着用感知机的表示方法(明确地显示神经元)来表示这个异或门:

如上图所示,异或门是一种多层结构的神经网络。这里,将最左边的一列称为第0层,中间的一列称为第1层,最右边的一列称为第2层。

这里的感知机与前面介绍的与门、或门的感知机形状不同。实际上,与门、或门是单层感知机,而异或门是2层感知机。叠加了多层的感知机也称为多层感知机multi-layered perceptron。

具体过程:

第0层的两个神经元接收输入信号,并将信号发送至第1层的神经元。

第1层的神经元将信号发送至第2 层的神经元,第2层的神经元输出y。

这种2层感知机的运行过程可以比作流水线的组装作业。第1层的工人对传送过来的零件进行加工,完成后再传送给第2层的工人。第2层的工人对第1层的工人传过来的零件进行加工,完成这个零件后出货。

像这样,在异或门的感知机中,工人之间不断进行零件的传送。通过这样的2层结构,感知机得以实现异或门。这可以解释为“单层感知机无法表示的东西,通过增加一层就可以解决”。也就是说,通过叠加层(加深层),感知机能进行更加灵活的表示。

感知机与计算机

多层感知机可以实现比之前见到的电路更复杂的电路。比如,进行加法运算的加法器也可以用感知机实现。此外,将二进制转换为十进制的编码器、满足某些条件就输出1 的电路(用于等价检验的电路)等也可以用感知机表示。实际上,使用感知机甚至可以表示计算机。计算机和感知机一样,也有输入和输出,会按照某个既定的规则进行计算。理论上可以说2层感知机就能构建计算机。这是因为,已有研究证明,2层感知机可以表示任意函数。

感知机通过叠加层能够进行非线性的表示,理论上还可以表示计算机进行的处理。

小结

- 感知机是具有输入和输出的算法。给定一个输入后,将输出一个既定的值。

- 感知机将权重和偏置设定为参数。

- 使用感知机可以表示与门和或门等逻辑电路。

- 异或门无法通过单层感知机来表示。

- 使用2层感知机可以表示异或门。

- 单层感知机只能表示线性空间,而多层感知机可以表示非线性空间。

- 多层感知机(在理论上)可以表示计算机。