Ubuntu安装Hadoop

首先准备两个安装包jdk和Hadoop,注意不要用Hadoop-src的tar包,需要的话可以联系我。

注意:本文的所有环境变量以及文件夹命名都是我自主命名,请一定要注意自己配置时的设置

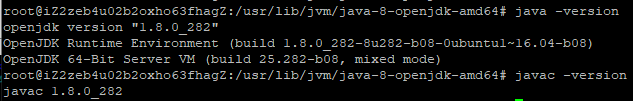

一、安装JDK

先将jdk包移动到/usr/local(上传时可直接上传到此处),然后解压。

此处出现了二进制文件无法读取的问题,百度说是32位机器和64位安装包不匹配,所以使用了openjdk代替。

安装命令 :

apt -y install openjdk-8-jre openjdk-8-jdk配置环境变量

vim ~/.bashrc在结尾添加以下代码

export JAVA_HOME=/usr/lib/jvm/java-8-openjdk-amd64

export JRE_HOME=$JAVA_HOME/jre

export CLASSPATH=.:$JAVA_HOME/lib:$JRE_HOME/lib

export PATH=.:$JAVA_HOME/bin:$PATH

然后使环境变量生效 source ~/.bashrc

查看是否安装成功 使用Java version

Javac version二、安装Hadoop

设置SSH

安装ssh sudo apt-get install ssh

免密登录 ssh-keygen -t rsa

验证 cd ~/.ssh

cat id_rsa.pub >> authorized_keys

ssh localhost

exit

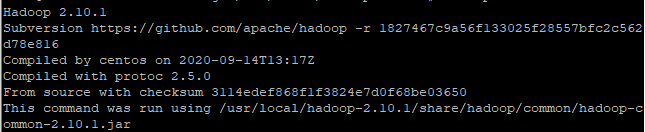

安装Hadoop

cd 压缩包位置

解压缩 sudo tar –zxvf had* –C /usr/local/

设置权限

cd /usr/local

sudo chown –R root Hadoop-2.10.1

然后添加到变量

vim /etc/profile

# set hadoop environment

export HADOOP_HOME=/usr/local/hadoop-2.10.1

export PATH=$PATH:$HADOOP_HOME/bin

修改环境变量 .bashrc

export HADOOP_HOME=/usr/local/Hadoop-2.10.1

export CLASSPATH=.:{JAVA_HOME}/lib:${HADOOP_HOME}/sbin:$PATH

export PATH=.:${HADOOP_HOME}/bin:${HADOOP_HOME}/sbin:$PATH

输入Hadoop version

三、配置伪分布式

修改Hadoop中JAVA—Home的变量 解压文件夹/etc/hadoop/Hadoop-env.sh中。变量改为Java-home的变量。前面已经提到过了。

修改/etc/hadoop下的core-site.xml文件

hadoop.tmp.dir

file:/usr/local/hadoop-2.10.1/tmp

fs.defaultFS

hdfs://localhost:9000

修改hdfs-site.xml文件

dfs.replication

1

dfs.namenode.name.dir

file:/usr/local/hadoop-2.10.1/tmp/dfs/name

dfs.datanode.data.dir

file:/usr/local/hadoop-2.10.1/tmp/dfs/data

配置YARN-1

cd /usr/local/Hadoop-2.10.1/etc/hadoop

cp mapred-site.xml.template mapred-site.xml

vim mapred-site.xml

mapreduce.framework.name

yarn

配置YARN-2

Vim yarn-site.xml

yarn.nodemanager.aux-services

mapreduce_shuffle

执行NameNode格式化

cd /usr/local/hadoop-2.10.1/bin

./hdfs namenode –format

出现以下代码表示格式化成功

启动Hadoop组件

cd /usr/local/hadoop-2.10.1/sbin

./start-all.sh

最后输入jps查询