1.2监督学习

统计学习包括监督学习,非监督学习,半监督学习及强化学习。

监督学习(supervised learning)的任务是学习一个模型,使模型能够对人意给定的输入,对其相应的输出作出一个好的预测。

1.2.1基本概念

1.输入空间,特征空间和输出空间

(1)将输入与输出所有可能取值的集合分别称为输入空间与输出空间

(2)特征空间:每个具体的输入是一个实例,通常由特征向量表示,所有特征向量存在的空间。

如果输入空间和特征空间为相同空间,对它们不予以区分;?不理解

如果输入空间与特征空间为不同空间,将实例从输入空间映射到特征空间。?不理解

(3)根据输入,输出变量的不同类型,对预测任务给予不同的名称:

回归问题:输入变量与输出变量均为连续变量的预测问题

分类问题:输出变量为有限个离散变量的预测问题

标注问题:输入变量与输出变量均为变量序列的预测问题

2.联合概率分布

统计学习假设数据存在一定的统计规律,X和Y具有联合概率分布( p(x,y) )的假设就是监督学习关于数据的基本假设。 // p(x,y)表示的是X和Y确实存在关联性,只有有关联性,才有规律可循,才是可预测的,这是监督学习的假设基础。

3.假设空间

监督学习的目的在于学习一个由输入到输出的映射,这一映射由模型来表示,模型属于由输入空间到输出空间的映射的集合,这个集合就是假设空间。

监督学习的模型可以是概率模型P(Y|X)或者非概率模型Y=f(X)表示,随具体的学习方法而定。

1.2.2问题的形式化

监督学习:由于在学习过程中需要训练数据集,而训练数据集往往是人工给出的,所以称为监督学习。

1.3统计学习的三要素

1.3.1模型

在监督学习过程中,模型就是所要学习的条件概率分布或决策函数。模型的假设空间包括所有可能的条件概率或决策函数。

1.3.2策略

有了模型的假设空间,统计学习接着需要考虑的是按照什么样的准则学习或者选择最优的模型。统计学习的目标在于从假设空间中选取最优模型。

1.损失函数和风险函数

损失函数:输出的预测值f(X)与真实值Y可能一致也可能不一致,用一个损失函数(loss function)或者代价函数(cost function)来度量预测错误的程度

统计学习常用的损失函数有:

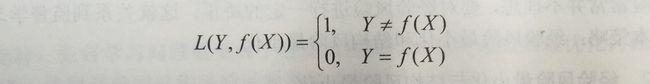

(1)0-1损失函数(0-1 loss function):

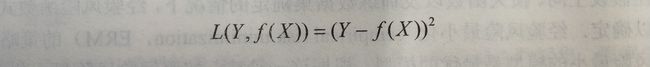

(2)平方损失函数(quadratic loss function):

(3)绝对损失函数(absolute loss function):

(4)对数损失函数(logarithm loss function)或对数似然损失函数(loglikelihood loss function):

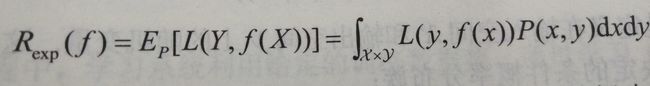

损失函数值越小,模型就越好,由于模型的输入,输出(X,Y)是随机变量,遵循联合分布P(X,Y),所以损失函数的期望是:(期望值是E=x1p1+x2p2+...+xnpn+...)这是理论上模型f(X)关于联合分布P(X,Y)的平均意义下的损失

称为风险函数(risk function)或期望损失(expected loss):

给定一个训练数据集

模型f(X)关于训练数据集的平均损失称为经验风险(empirical risk)或经验损失(empirical loss),记作Remp:

根据大数定律,当样本容量N趋向于无穷大时,经验风险趋向于期望风险。由于现实中训练样本数量有限,甚至很小,所以用经验风险估计期望风险往往不理想,要对经验风险进行一定的矫正。

2.经验风险最小化与结构风险最小化

经验最小化的策略认为,经验风险最小的模型是最优的模型:

当模型是条件概率分布,损失函数是对数损失函数时,经验风险最小化等价于极大似然估计(maximum likelihood estimation),当样本容量足够大时,经验风险最小化能够保证有很好的学习效果,但当样本容量很小时,经验风险最小化学习的效果就未必很好,会产生过拟合现象。

结构风险最小化(structural risk minimization,SRM)是为防止过拟合而提出来的策略。结构风险在经验风险上加上表示模型复杂度的正则化项或罚项,在假设空间,损失函数以及训练数据集确定的情况下,结构风险的定义是:

模型f越复杂,复杂度J(f)就越大,反之,模型f越简单,复杂度J(f)就越小。复杂度表示了对复杂模型的惩罚。lambda>=0是系数用以权衡经验风险和模型复杂度。结构风险小需要经验风险与模型复杂度同时小。结构风险小的模型往往对训练数据以及未知数据都有较好的预测。

当模型是条件概率分布,损失函数是对数损失函数,模型复杂度由模型的先验概率表示时结构风险最小化等价于最大后验概率估计。

结构风险最小化的策略认为结构风险最小的模型是最优的模型:

这样,监督学习问题就变成了经验风险或结构风险函数的最优化问题。这时,经验或结构风险函数时最优化的目标函数。

1.3.3算法

算法是指学习模型的具体计算方法。统计学习给予训练数据集,根据学习策略,从假设空间中选择最优模型,最后需要考虑用什么样的计算方法求解最优模型。