大数据学习——hbase安装使用教程

下载地址:http://archive.apache.org/dist/hbase/hbase-0.98.8/

百度网盘备份:

主要包括:hbase安装、hbase运行和检查、hbase基本操作

一 、hbase安装

1.1 下载解压

上面有下载链接,下载好hbase***.tar.gz安装包后解压 tar -zxvf hbase***.tar.gz

解压后使用mv命令将来加压出来的文件夹更名为hbase。进入到hbase根目录,看看都有什么

1.2 修改hbase配置

配置文件在conf文件夹下,主要修改hbase-env.sh 和 hbase-site.xml

首先是hbase-env.sh 添加jdk

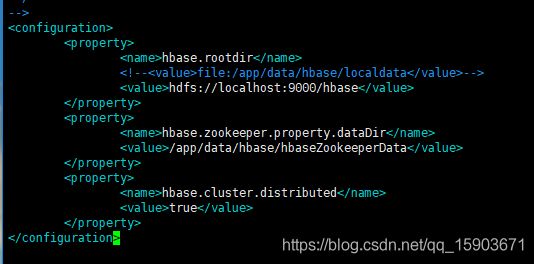

然后是hbase-site.xml

配置hbase.rootdir数据存储地址。如果是本地单机玩则value写file://...伪分布式(data存到hadoop-hdfs)的话写hdfs://..

这里有个巨大的坑,value中的hdfs://....一定要跟hadoop的core-site.xml中的fs.defaultFS(HADOOP2.*用这个,1.*是fs.default.**.**)中的value一模一样!!!,一定要注意ip和端口的匹配。

配置zookeeper数据存储地址,真的会生成一些文件出来,博主还没有单独安装zookeeper,不影响运行。

配置hbas.cluster.distributed为true。如果本地单机测试的话就不用配置这个了,需要关联hadoop-hdfs的话要配成true。

二、hbase运行和检查

2.1 启动关闭脚本

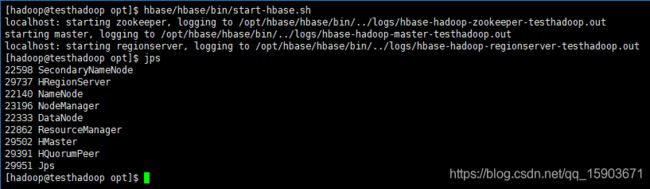

bin/start-hbase.sh 脚本是hbase的启动脚本

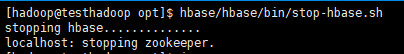

bin/stop-hbase.sh 脚本是hbase的关闭脚本

jps 指令可以看到所有的java进程 HMaster、HquorumPeer、HRegionServer 这三个java进程是HBase的。

2.2 错误排查:

如果jps中没有看到HMaster,那么很可能是hbase启动时报错了。

logs 路径下是日志文件,可以对应查看启动日志排查错误。

2.3 查看运行生成的数据文件

本地单机运行就到file://...路径下,结合hadoop-hdfs就到 hadoop fs -ls .... (hdfs://ip:port/...的路径)看看生成的数据文件

三、Hbase基本操作(shell方式)

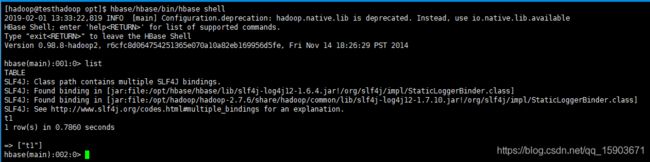

shell操作。bin路径下 ./hbase shell 进入到hbase的shell命令窗口。exit退出。

列出所有table的指令 list

创建表空间指令: create_namespace 'namespace'

建表指令: create 'namespace:tableName','column family1',‘column family2’...

插入数据: put 'namespace:tableName','rowkey','column family:column name','value'

修改数据:写了这么多,其实就是在往row1这行里里面插数据。修改数据还是put直接覆盖就好。

删除单元格数据:delete 'namespace:tableName','rowkey','column family:column name' (删除掉某行中的某列数据)

删除行数据 deleteall 'namespace:tableName','rowkey' (删除掉某行中的所有数据)

删除表 drop 'namespace:tableName' (整张表干掉)

当然还可以使用禁用 disable 、截断 truncate等方式达到类似效果

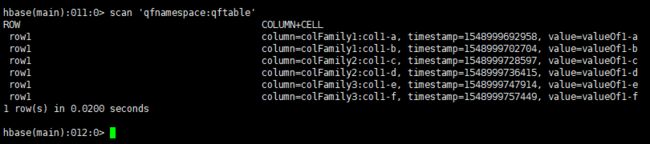

查询数据——扫面表 scan 'namespace:tableName'

查询数据——查询行 get 'namespace:tableName' , 'rowkey'

查询数据——查询列 get 'namespace:tableName' , 'rowkey' , 'column family:column name'

真正的数据存储在data中,data-【namespace】-【table】-【描述文件+数据文件夹】-【column family】-***