机器学习---数学基础(三、线性代数)

文章目录

- 一、线性空间与线性变换

-

- 1.1 可交换性 和 结合律

- 1.2 线性空间

- 1.3 傅里叶变换

-

- 1.3.1 连续傅里叶变换

- 1.3.2 离散傅里叶变换

- 1.4 线性相关和线性无关

-

- 1.4.1 线性相关

- 1.5 秩

- 1.6 线性变换

- 二、矩阵、等价类和行列式

-

- 2.1 可逆矩阵表示坐标变换

- 2.2 相似矩阵

- 2.3 线性代数解微分方程

- 2.4 转秩 和 求逆

-

- 2.4.1 转秩

- 2.4.2 求逆

- 2.5 等价类

- 2.6 行列式 d e t ( A ) det(A) det(A)

- 三、特征值与特征向量

-

- 3.1 特征值与特征向量

- 3.2 特征值的计算

- 3.3 线性代数核心定理

- 3.4 欧式空间与闵氏空间

一、线性空间与线性变换

1.1 可交换性 和 结合律

- A B ≠ B A AB \neq BA AB=BA

- 对角矩阵可以交换

- 结合律: A i × j ( B j × k C k × s ) = ( A i × j B j × k ) C k × s A_{i×j}(B_{j×k}C_{k×s}) = (A_{i×j}B_{j×k})C_{k×s} Ai×j(Bj×kCk×s)=(Ai×jBj×k)Ck×s

1.2 线性空间

存 在 集 合 V = { v i ∣ i 是 指 数 集 } , 配 数 域 k 存在集合 V = \{ v_i | i 是指数集 \},配数域 k 存在集合V={ vi∣i是指数集},配数域k

任 意 , α , β , θ ∈ V , 满 足 以 下 8 条 定 律 : 任意, \alpha ,\beta, \theta \in V,满足以下8条定律: 任意,α,β,θ∈V,满足以下8条定律:

- α ⃗ + β ⃗ = β ⃗ + α ⃗ \vec{\alpha} + \vec{\beta} = \vec{\beta} + \vec{\alpha} α+β=β+α

- ( α ⃗ + β ⃗ ) + θ ⃗ = α ⃗ + ( β ⃗ + θ ⃗ ) (\vec{\alpha} + \vec{\beta}) + \vec{\theta} = \vec{\alpha} + (\vec{\beta} + \vec{\theta}) (α+β)+θ=α+(β+θ)

- 存 在 ( 零 元 ) 0 ⃗ ∈ V , α ⃗ + 0 ⃗ = α ⃗ 存在(零元) \vec{0} \in V, \quad \vec{\alpha} +\vec{0} = \vec{\alpha} 存在(零元)0∈V,α+0=α

- 逆元存在性: 任 意 α ⃗ , 存 在 β ⃗ , 使 得 α ⃗ + β ⃗ = 0 ⃗ 任意\vec{\alpha},存在\vec{\beta},使得 \vec{\alpha} + \vec{\beta} = \vec{0} 任意α,存在β,使得α+β=0

- 数乘单位元: 1 ∈ k 1 ∗ α ⃗ = α ⃗ 1 \in k \quad 1* \vec{\alpha}=\vec{\alpha} 1∈k1∗α=α

- 数乘结合律: m , n ∈ k m ( n α ⃗ ) = n ( m α ⃗ ) m,n \in k \quad m(n\vec{\alpha}) = n(m \vec{\alpha}) m,n∈km(nα)=n(mα)

- 数乘分配率: m ∈ k m ( α ⃗ + β ⃗ ) = m α ⃗ + m β ⃗ m \in k \quad m(\vec{\alpha} + \vec{\beta}) = m\vec{\alpha} + m\vec{\beta} m∈km(α+β)=mα+mβ

- m , n ∈ k ( m + n ) α ⃗ = m α ⃗ + n α ⃗ m,n \in k \quad (m+n)\vec{\alpha} = m\vec{\alpha} + n\vec{\alpha} m,n∈k(m+n)α=mα+nα

1.3 傅里叶变换

1.3.1 连续傅里叶变换

-

傅里叶变换

g ( k ) = ∫ − ∞ + ∞ f ( x ) e − i k x d x g(k) = \int_{-\infty}^{+\infty}f(x)e^{-ikx} dx g(k)=∫−∞+∞f(x)e−ikxdx- 求 f ′ ( x ) f^{'}(x) f′(x)的傅里叶变换:

F . T ( f ′ ( x ) ) = ∫ − ∞ + ∞ f ′ ( x ) e − i k x d x = ∫ − ∞ + ∞ e − i k x d f ( x ) = f ( x ) e − i k x ∣ − ∞ + ∞ − ( − i k ) ∫ − ∞ + ∞ f ( x ) e − i k x d x = 0 − ( − i k ) ∫ − ∞ + ∞ f ( x ) e − i k x d x = ( i k ) F . T ( f ( x ) ) F.T(f^{'}(x)) = \int_{-\infty}^{+\infty}f^{'}(x)e^{-ikx} dx = \int_{-\infty}^{+\infty}e^{-ikx} df(x) \\ =f(x)e^{-ikx} |_{- \infty}^{+\infty}- (-ik)\int_{-\infty}^{+\infty}f(x)e^{-ikx} dx\\ = 0 - (-ik)\int_{-\infty}^{+\infty}f(x)e^{-ikx} dx \\ = (ik) \ F.T (f(x)) F.T(f′(x))=∫−∞+∞f′(x)e−ikxdx=∫−∞+∞e−ikxdf(x)=f(x)e−ikx∣−∞+∞−(−ik)∫−∞+∞f(x)e−ikxdx=0−(−ik)∫−∞+∞f(x)e−ikxdx=(ik) F.T(f(x)) - 求 f ′ ′ ( x ) f^{''}(x) f′′(x)的傅里叶变换:

计算过程同上;

F . T ( f ′ ′ ( x ) ) = ( i k ) 2 F . T ( f ( x ) ) F.T(f^{''}(x)) = (ik)^2 \ F.T (f(x)) F.T(f′′(x))=(ik)2 F.T(f(x))

- 求 f ′ ( x ) f^{'}(x) f′(x)的傅里叶变换:

-

傅里叶逆变换

f ( x ) = 1 2 π ∫ − ∞ + ∞ g ( k ) e i k x d k f(x) = \frac{1}{2\pi} \int_{-\infty}^{+\infty}g(k) e^{ikx} dk f(x)=2π1∫−∞+∞g(k)eikxdk

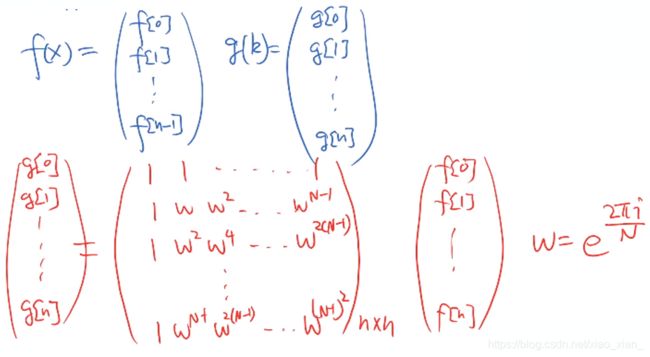

1.3.2 离散傅里叶变换

- 离散傅里叶变换的时间复杂度: O ( n 2 ) O(n^2) O(n2)

- 快速傅里叶变换的时间复杂度: O ( n ln n ) O(n\ln n) O(nlnn)

1.4 线性相关和线性无关

1.4.1 线性相关

- 有冗余的内容信息

- 线性相关定义:

n 个向量 v 1 ⃗ , v 2 ⃗ , . . . , v n ⃗ ∈ V \vec{v_1},\vec{v_2},...,\vec{v_n} \in V v1,v2,...,vn∈V

存在 a 1 , a 2 , . . . , a n {a_1},{a_2},...,{a_n} a1,a2,...,an不全为 0

若存在, a 1 v 1 ⃗ + a 2 v 2 ⃗ + . . . + a n v n ⃗ = 0 ⃗ a_1\vec{v_1} + a_2\vec{v_2} + ... + a_n \vec{v_n} = \vec{0} a1v1+a2v2+...+anvn=0

则, { v 1 ⃗ , v 2 ⃗ , . . . , v n ⃗ } 线 性 相 关 。 \{ \vec{v_1},\vec{v_2},...,\vec{v_n} \} 线性相关。 { v1,v2,...,vn}线性相关。

-

线性无关的定义则与线性相关相反。

不存在 a 1 , a 2 , . . . , a n {a_1},{a_2},...,{a_n} a1,a2,...,an不全为 0;

使 a 1 v 1 ⃗ + a 2 v 2 ⃗ + . . . + a n v n ⃗ = 0 ⃗ a_1\vec{v_1} + a_2\vec{v_2} + ... + a_n \vec{v_n} = \vec{0} a1v1+a2v2+...+anvn=0

则, { v 1 ⃗ , v 2 ⃗ , . . . , v n ⃗ } 线 性 无 关 。 \{ \vec{v_1},\vec{v_2},...,\vec{v_n} \} 线性无关。 { v1,v2,...,vn}线性无关。 -

最大线性无关组

1.5 秩

-

矩阵按行/ 列切成的向量组成的"极大线性无关组的个数" 相同。

-

秩 = " 极 大 线 性 无 关 组 的 个 数 " 秩 = "极大线性无关组的个数" 秩="极大线性无关组的个数"

-

决定是否可逆

1.6 线性变换

-

初等变换

- k 列乘以 a 倍

- k 列的 a 倍 加到 s 列上

- k 列与 s 列对调

-

定义:

从一个线性空间变换到另一个线性空间。

L ( a α ⃗ + b β ⃗ ) = a L ( α ⃗ ) + b L ( β ⃗ ) L(a \vec{\alpha} + b \vec{\beta}) = a L(\vec{\alpha}) + b L(\vec{\beta}) L(aα+bβ)=aL(α)+bL(β) -

变换的方式

- 向量不变,基底变换

r ⃗ = a 1 e 1 ⃗ + a 2 e 2 ⃗ = a 1 ′ e 1 ⃗ ′ + a 2 ′ e 2 ⃗ ′ \vec{r} = a_1 \vec{e_1} + a_2 \vec{e_2} = a_1^{'} \vec{e_1}^{'} + a_2^{'} \vec{e_2}^{'} r=a1e1+a2e2=a1′e1′+a2′e2′ - 向量变换,基底不变

r ⃗ = a 1 e 1 ⃗ + a 2 e 2 ⃗ \vec{r} = a_1 \vec{e_1} + a_2 \vec{e_2} r=a1e1+a2e2

r ⃗ = a 1 ′ ′ e 1 ⃗ + a 2 ′ ′ e 2 ⃗ \vec{r} = a_1^{''} \vec{e_1} + a_2^{''} \vec{e_2} r=a1′′e1+a2′′e2

- 向量不变,基底变换

-

由于任何一个向量都可以用一组基向量进行表示,所以根据基向量的变化就可以得到任一向量的表示。

二、矩阵、等价类和行列式

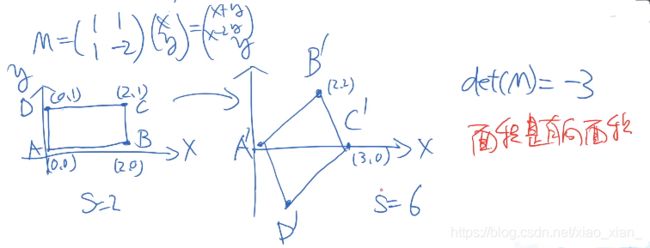

2.1 可逆矩阵表示坐标变换

- 任意向量的坐标变换都可以由 M n × n M_{n×n} Mn×n表示

2.2 相似矩阵

-

定义:

相似矩阵是指具有相似关系的矩阵。假设 M , N 为 n 阶 矩 阵 。 如 果 有 n 阶 可 逆 矩 阵 P 存 在 , 满 足 以 下 条 件 M,N 为 n 阶矩阵。如果有n 阶可逆矩阵 P 存在,满足以下条件 M,N为n阶矩阵。如果有n阶可逆矩阵P存在,满足以下条件

A = P − 1 B P A=P^{-1} B P A=P−1BP

则 称 矩 阵 A 与 B 相 似 , 记 为 A ∼ B 。 则称 矩阵 A 与 B 相似,记为 A\sim B。 则称矩阵A与B相似,记为A∼B。 -

相似矩阵表示相同的线性变换

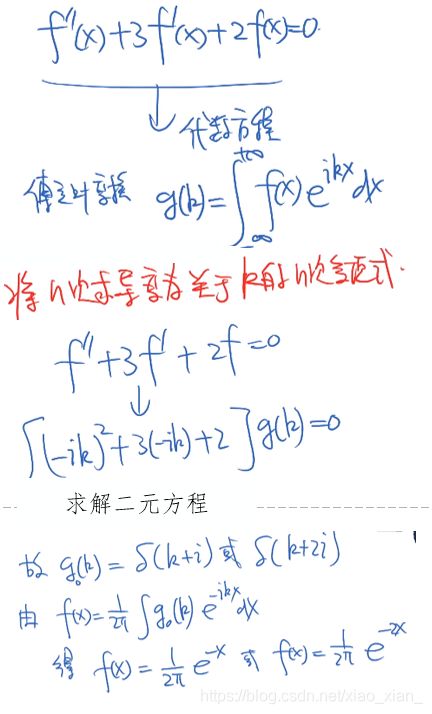

2.3 线性代数解微分方程

全体 f ( x ) f(x) f(x) 构成线性空间 V ⃗ \vec{V} V,存在大量的线性映射。

2.4 转秩 和 求逆

2.4.1 转秩

- ( A B ) T = B T A T (AB)^T = B^T A^T (AB)T=BTAT

2.4.2 求逆

- M − 1 M = I = M M − 1 n M^{-1}M = I = MM^{-1} n M−1M=I=MM−1n

- ( A B ) − 1 = B − 1 A − 1 (AB)^{-1} = B^{-1} A^{-1} (AB)−1=B−1A−1

2.5 等价类

-

等价关系

A ∼ B ; B ∼ C , → A ∼ C A \sim B; B \sim C, \rightarrow A \sim C A∼B;B∼C,→A∼C

二元关系, 区分前后(有序对)- 1)反身性: A ∼ A A \sim A A∼A

- 2)互反性: A ∼ B ; B ∼ A A \sim B; B \sim A A∼B;B∼A

- 3)传递性: A ∼ B ; B ∼ C , → A ∼ C A \sim B; B \sim C, \rightarrow A \sim C A∼B;B∼C,→A∼C

-

矩阵证明 A ∼ B ; B ∼ C , → A ∼ C A \sim B; B \sim C, \rightarrow A \sim C A∼B;B∼C,→A∼C:

- A ∼ B → A = M − 1 B M A \sim B \rightarrow A = M^{-1}BM A∼B→A=M−1BM

- B ∼ C → B = N − 1 C N B\sim C \rightarrow B= N^{-1}CN B∼C→B=N−1CN

- A = M − 1 N − 1 C N M = ( N M ) − 1 C ( N M ) → A ∼ C A = M^{-1}N^{-1}CNM \\ = (NM)^{-1}C(NM) \rightarrow A \sim C A=M−1N−1CNM=(NM)−1C(NM)→A∼C

-

等价类

若集合 O O O 存在等价关系,

则集合 O O O,可分割成不相关的子集 O 1 ∪ O 2 ∪ O 3 . . . O_1 \cup O_2 \cup O_3... O1∪O2∪O3...

==> 且 O i O_i Oi 的所有元素都等价;

任意一个 a , b ∈ O i ; a ∼ b a,b \in O_i; a \sim b a,b∈Oi;a∼b

2.6 行列式 d e t ( A ) det(A) det(A)

-

定义:

-

d e t ( A B ) = d e t ( A ) d e t ( B ) det(AB) = det(A)det(B) det(AB)=det(A)det(B)

三、特征值与特征向量

3.1 特征值与特征向量

-

物理意义:

被线性变换之后,方向不变的矢量是特征矢量。

特征向量构成用于描述线性变换的基底,可将线性变换对角化。 -

特征值和特征向量的性质:

- 相同的特征值构成的特征向量,可以构成一个子空间

- 不同特征值的特征向量详细无关。

-

相似矩阵具有相同的特征值

- 举例证明:

- M = K − 1 N K ; M , N 代 表 相 同 的 线 性 变 换 M=K^{-1} N K; \quad M,N代表相同的线性变换 M=K−1NK;M,N代表相同的线性变换

M α ⃗ = λ i α ⃗ N β ⃗ = λ i β ⃗ M \vec{\alpha} = \lambda_i \vec{\alpha} \qquad N \vec{\beta} = \lambda_i \vec{\beta} Mα=λiαNβ=λiβ

M α ⃗ = λ i α ⃗ K − 1 N K α ⃗ = λ i α ⃗ N K α ⃗ = λ i K α ⃗ → β ⃗ = K α ⃗ N β ⃗ = λ i β ⃗ M \vec{\alpha} = \lambda_i \vec{\alpha}\\ K^{-1} N K \vec{\alpha} = \lambda_i \vec{\alpha} \\ N K \vec{\alpha} = \lambda_i K \vec{\alpha} \\ \rightarrow \vec{\beta} = K \vec{\alpha} \\ N \vec{\beta} = \lambda_i \vec{\beta} Mα=λiαK−1NKα=λiαNKα=λiKα→β=KαNβ=λiβ

所以特征值相同。

3.2 特征值的计算

M α ⃗ = λ i α ⃗ ( M − λ i I ) α ⃗ = 0 → d e t ( M − λ i I ) = 0 M \vec{\alpha} = \lambda_i \vec{\alpha} \\ (M - \lambda_i I) \vec{\alpha} = 0\\ \rightarrow det(M - \lambda_i I) = 0 Mα=λiα(M−λiI)α=0→det(M−λiI)=0

- 1)证明:若 M ∼ N ; 则 d e t ( M − λ I ) = d e t ( N − λ I ) M \sim N; \ 则det(M-\lambda I)=det(N-\lambda I) M∼N; 则det(M−λI)=det(N−λI)

d e t ( N − λ I ) = d e t ( C − 1 M C − λ I ) = d e t ( C − 1 M C − C − 1 λ I C ) = d e t ( C − 1 ) d e t ( M − λ I ) d e t ( C ) det(N-\lambda I) = det(C^{-1}MC - \lambda I) \\ =det(C^{-1}MC - C^{-1} \lambda I C) \\ =det(C^{-1}) det(M - \lambda I) det(C) det(N−λI)=det(C−1MC−λI)=det(C−1MC−C−1λIC)=det(C−1)det(M−λI)det(C)- 因为 d e t ( C − 1 ) d e t ( C ) = 1 det(C^{-1}) det(C) = 1 det(C−1)det(C)=1

- 所以 d e t ( C − 1 ) d e t ( M − λ I ) d e t ( C ) = d e t ( M − λ I ) det(C^{-1}) det(M - \lambda I) det(C) = det(M - \lambda I) det(C−1)det(M−λI)det(C)=det(M−λI)

- 2)求证 d e t ( M ) = λ 1 λ 2 λ 3 . . . det(M) = \lambda_1 \lambda_2 \lambda_3 ... det(M)=λ1λ2λ3...

根据上述证明已知 d e t ( M − λ I ) = d e t ( N − λ I ) det(M-\lambda I)=det(N-\lambda I) det(M−λI)=det(N−λI)- 假设 N N N 为 λ \lambda λ 对角矩阵

- 所以 d e t ( M − λ I ) = d e t ( N − λ I ) = ( λ 1 − λ ) ( λ 2 − λ ) ( λ 3 − λ ) . . . ( λ n − λ ) det(M-\lambda I)=det(N-\lambda I)=(\lambda_1- \lambda) (\lambda_2- \lambda) (\lambda_3- \lambda)...(\lambda_n- \lambda) det(M−λI)=det(N−λI)=(λ1−λ)(λ2−λ)(λ3−λ)...(λn−λ)

- 令 λ = 0 \lambda = 0 λ=0

- 所以 d e t ( M ) = λ 1 λ 2 λ 3 . . . det(M) = \lambda_1 \lambda_2 \lambda_3 ... det(M)=λ1λ2λ3...

3.3 线性代数核心定理

五个互为充分必要条件的核心定理:

- M 可 逆 ( 存 在 M − 1 ) M 可逆(存在M^{-1}) M可逆(存在M−1)

- d e t ( M ) ≠ 0 det(M) \neq 0 det(M)=0

- r ( M ) = n ; M 满 秩 r(M) = n; \qquad M满秩 r(M)=n;M满秩

- 任何 λ i ≠ 0 ; 0 可 以 作 为 特 征 值 , 不 能 作 为 特 征 向 量 。 \lambda_i \neq 0; \qquad 0可以作为特征值,不能作为特征向量。 λi=0;0可以作为特征值,不能作为特征向量。

- k e r ( M ) = 0 ; M 的 核 ker(M)=0; \qquad M的核 ker(M)=0;M的核

- M V ⃗ = 0 ⃗ ; V ⃗ ∈ k e r ( M ) M\vec{V} = \vec{0}; \quad \vec{V} \in ker(M) MV=0;V∈ker(M)

3.4 欧式空间与闵氏空间

- 欧式空间

- n 维 线 性 空 间 + 点 积 = 欧 式 空 间 n 维线性空间 + 点积=欧式空间 n维线性空间+点积=欧式空间

- ( v 1 ⃗ , v 2 ⃗ ) = a 1 b 1 + a 2 b 2 + . . . + a n b n (\vec{v_1}, \vec{v_2})=a_1b_1 + a_2b_2 + ...+a_nb_n (v1,v2)=a1b1+a2b2+...+anbn

- 闵氏空间

- 假 设 令 v 1 ⃗ = ( Δ t 1 , Δ x 1 , Δ y 1 , Δ z 1 ) v 2 ⃗ = ( Δ t 2 , Δ x 2 , Δ y 2 , Δ z 2 ) 假设令 \vec{v_1} = (\Delta t_1,\Delta x_1,\Delta y_1,\Delta z_1) \\ \vec{v_2} = (\Delta t_2,\Delta x_2,\Delta y_2,\Delta z_2) 假设令v1=(Δt1,Δx1,Δy1,Δz1)v2=(Δt2,Δx2,Δy2,Δz2)

则 ( v 1 ⃗ , v 2 ⃗ ) = − Δ t 1 Δ t 2 + Δ x 1 Δ x 2 + Δ y 1 Δ y 2 + Δ z 1 Δ z 2 则 (\vec{v_1}, \vec{v_2})=-\Delta t_1\Delta t_2 + \Delta x_1\Delta x_2 + \Delta y_1\Delta y_2+ \Delta z_1\Delta z_2 则(v1,v2)=−Δt1Δt2+Δx1Δx2+Δy1Δy2+Δz1Δz2

- 假 设 令 v 1 ⃗ = ( Δ t 1 , Δ x 1 , Δ y 1 , Δ z 1 ) v 2 ⃗ = ( Δ t 2 , Δ x 2 , Δ y 2 , Δ z 2 ) 假设令 \vec{v_1} = (\Delta t_1,\Delta x_1,\Delta y_1,\Delta z_1) \\ \vec{v_2} = (\Delta t_2,\Delta x_2,\Delta y_2,\Delta z_2) 假设令v1=(Δt1,Δx1,Δy1,Δz1)v2=(Δt2,Δx2,Δy2,Δz2)