Gebru被辞退的背后真相:指出BERT的4大危害,威胁谷歌商业利益

2020-12-09 21:22:48

作者 | 陈彩娴

编辑 | 青暮

在12月4日《曾大战LeCun的谷歌女性科学家,刚刚被Jeff Dean开除了!》一文中,我们对各大媒体平台上讨论得如火如荼的“Gebru被谷歌辞退事件”进行了简单梳理与报道。

根据 Timnit Gebru 与 Google AI 负责人Jeff Dean被透露的邮件内容,Gebru的论文在提交审核中没有达到发表要求,因此被驳斥;接着,Gebru提出一些要求,如希望谷歌提供论文审核者的名单信息,称如果公司不同意就辞职。谷歌没有满足她的要求,并同意她的辞职。

针对 Jeff Dean 的回应,Gebru在另一条推文中解释,她曾要求度假结束后对她的任职进行一次“最后会谈”,但还没结束假期,谷歌便取消了她的公司账户,包括登录邮件权限。

而在网络上,许多AI伦理领域的领军人物都认为,Gebru被辞退,是因为她所参与撰写的研究论文触犯到了谷歌的利益底线。根据BBC的最新报道,目前已有超过4500位科研人员在支持Gebru的公开信上签名,要求谷歌公开解释阻止Gebru发表论文的原因。

这件事使许多科研者开始讨论科技“大鳄”如谷歌进行AI研究的道德与标准。一周过去,此事的讨论热度仍未消减,越来越多的细节被披露。

那么,该论文为何会威胁谷歌的商业利益?这件事的重要意义体现在哪里?结合MIT科技评论、BBC报道、Reddit议论与不断更新的推特,我们进行了二次总结。

1 论文指出的4大威胁

根据MIT科技评论的报道与一位评审人员在Reddit上po出于的论文摘要,Gebru等人合著的研究论文集中攻击了大规模语言模型(如BERT)的消极影响,而BERT模型是谷歌的王牌AI产品之一。

Reddit上论文摘要截图

MIT科技评论从华盛顿大学计算机语言系的终身教授Emily M. Bender处获得了这篇论文的复印版本。

这篇论文名为《On the Dangers of Stochastic Parrots: Can Language Models Be Too Big?》,一共由6位研究人员共同完成,其中4位是谷歌的研究人员,Bender也是作者之一。

据介绍,这篇论文基于其他研究人员的工作,参考了128篇学术文献,展示了自然语言处理的发展历史与大型语言模型的四大危害,呼吁对语言模型进行更深入的研究。

1、环境与经济成本

论文指出,训练大型AI模型需要用到大量的计算机处理能力,因此会消耗大量电力。

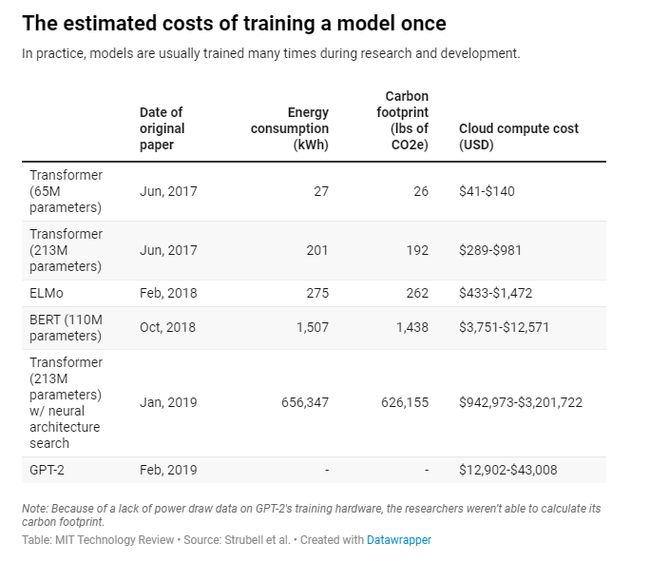

Gebru等人引用了Emma Strubell等人在2019年发表的关于大型语言模型的碳排放和财务成本的研究论文《Energy and Policy Considerations for Deep Learning in NLP》。研究发现,自2017年以来,随着向模型馈送越来越多的数据,其能耗和碳足迹也一直在呈现爆炸式增长。

论文地址:https://arxiv.org/pdf/1906.02243.pdf%20

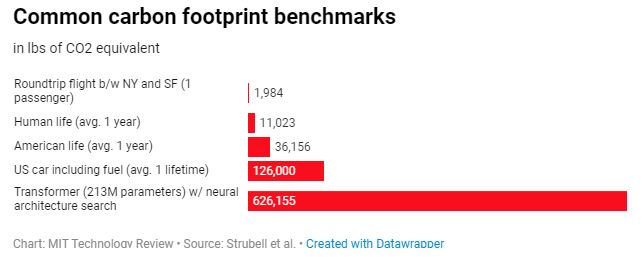

Strubell的研究发现,用“神经架构搜索”(neural architecture search)方法训练一种语言模型会产生626,155磅(284公吨)二氧化碳,大约相当于五辆普通美国汽车的使用寿命。Strubell还估计,训练一个BERT模型(该模型支撑了谷歌的搜索引擎事业),大约会产生1,438磅二氧化碳,相当于在纽约与旧金山之间的一次往返航班所产生的碳排放量。

这些数据只是对训练一次模型成本的最低估计。实际上,在研发过程中,工作人员会对模型进行多次训练和再训练。

Gebru的论文初稿指出,建立和维持大型 AI 模型所需要的资源只会使富裕的组织受益,其所造成的气候变化加剧对边缘社群的打击最大。因此,他们在论文中写道:“现在,研究人员应该优先考虑提高能源效率和规划成本,以减少对环境的负面影响和对资源使用的不平等现象。”

2、用到大量数据,模型却还是难以捉摸

大型语言模型是基于大量文本进行训练。这意味着,研究人员已经设法尽可能从网上收集了所有他们能找到的训练数据,包括那些涉及种族歧视的、具有性别歧视色彩的与其他虐待性的语言。

如果一个AI模型将具有种族歧视色彩的语言视为正常语言,显然是不好的。研究人员还指出了一些其他问题:

-

语言的改变在社会变化中扮演重要角色。比如,“Me Too”与“Black Lives Matter”运动尝试建立一种反性别歧视与反种族歧视的新词汇。而基于互联网数据训练的AI模型无法适应这些词汇的细微差别,也不会按照这些新的文化规范来产生或解释这些语言。

-

这些语言模型也无法理解对互联网访问较少、在线语言足迹罕见的国家和人民的语言和规范。结果,AI生成的语言将被同化,趋于反映最富裕国家和社区的生活实践。

-

由于训练数据集非常大,因此很难对数据集进行审核,以检查内在的偏差。研究人员总结:“因此,基于规模太大而无法记录的数据集进行训练本身就是危险的。”

3、研究机会成本:错误的研究投入

尽管大多数AI研究人员都承认大型语言模型实际上并不能理解语言,而仅是擅长操纵语言,但是大科技公司却可以从能够更准确地操纵语言的模型中获利,并继续加大对语言模型的投入。Gebru等人在论文中提到,“这些研究投入带来了机会成本。”相反,人们并没有将太多精力投入到那些能够实现理解、或使用更小但策划更仔细(也消耗更少能量)的数据集便能获得良好结果的AI模型上。

4、智能的幻觉

Gebru等人还指出,由于大型语言模型非常擅长模仿真实的人类语言,所以很容易被用来欺骗人类。这个问题已经有一些具体案例,比如之前一位大学生在博客上用GPT-3生成大量虚假博文。

这种现象的坏处是显而易见的:例如,AI模型可能会被用于生成与选举或新冠病毒有关的错误信息。用于机器翻译时,它们也会无意犯错。研究人员举了一个例子:2017年,Facebook将一个巴勒斯坦男子在网上发的帖子内容,把阿拉伯语中“早上好”的内容错误翻译成希伯来语的“打他们”,导致该男子被捕。

2 Dean解释谷歌论文审核,惨遭“打脸”

除了解释Gebru“离职”的原因,Jeff Dean的另一封内部邮件还解释了谷歌对论文的审核准则,被po到reddit上。

Reddit讨论地址:https://www.reddit.com/r/MachineLearning/comments/k6t96m/d_jeff_deans_official_post_regarding_timnit/

Dean介绍,谷歌内部有一个专门的工作组,依据公司的要求对AI研究与应用的proposal进行审核。这篇论文的审核人员包括研究人员、社会科学家、伦理学家、政策与隐私咨询师以及来自Research and Google的人权专家。他们的职责是保证谷歌所发表的研究深入全面,涵盖最新的相关研究,并符合谷歌在2018年发表的七大“AI准则”:

-

Be socially beneficial(造福社会);

-

Avoid creating or reinforcing unfair bias(避免造成或加剧不公平的偏见);

-

Be built and tested for safety(适应社会,经得起社会考验);

-

Be accountable to peaple(对人类负责);

-

Incorporate privacy design principles(保护隐私);

-

Uphold high standards of scientific excellence(拥护科学卓越的高标准);

-

Be made available for uses that accord with these principles(应用落地需遵循以上准则)。

“AI准则”详情:https://ai.google/principles

Gebru的这篇论文明确表达了对大规模语言模型的担忧,而Dean认为,“谷歌内部有很多小组正在努力解决这些问题。”他们曾要求Gebru等人将谷歌为解决这些问题的努力写入论文中,但论文显然没有。

Dean指出,这篇论文本身有一些重要“纰漏”,让他们不放心将论文与谷歌的名义联系在一起。比如,论文没有谈到大规模语言模型能够如何提高效率、减少环境危害;再比如,论文没有将谷歌与其他组织正在努力减少语言模型的偏见问题考虑在内。

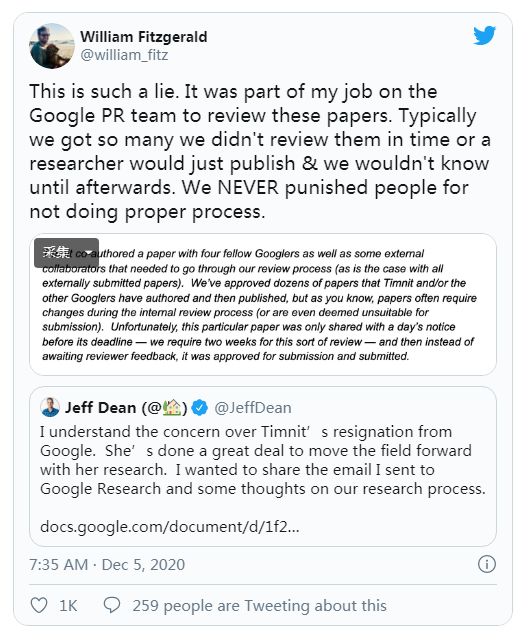

尽管 Dean 的两次回应与解释似乎“有头有尾”,但很快被“打脸”:

比如说,Jeff Dean在10月4日发送的内部邮件中“责备”,Gebru是在DDL的前一天才将论文提交至内部审核,但Gebru的小组成员提出:提交至“谷歌审核流程”的论文,接近一半的论文是在DDL前一天甚至更短的时间进行提交的。

此外,Gebru的论文在提交前收到了来自内外部28位人员的feedback,与其他论文相比,“人数大得多”。

谷歌的前PR William Fitzgerald也对Dean的邮件提出了质疑。她提到,她之前在谷歌PR团队工作时,她是负责对这些论文进行审核的人员之一。一般情况下,PR团队要审核的论文非常多,难以及时审查完,有时研究人员(没有收到反馈意见)直接发表、他们也是事后才知道。“我们从未惩罚那些没有走正确审核程序的人。”

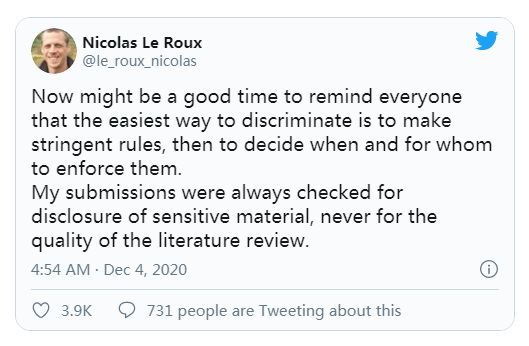

另外,Jeff Dean认为该论文“没有达到发表标准”的原因之一是“忽略了许多相关研究”,尤其体现在,没有提到大型语言模型如何节能与减少偏见的最新研究工作。

但据Bender介绍,这篇论文参考了多达128篇学术文献。此外,这篇论文也参考了几项关于减少语言模型的大小与计算成本,以及测量模型内在偏见的研究,但在这方面的研究投入仍不够。

一位驻扎在加拿大蒙特利尔的谷歌研究人员Nicolas Le Roux此前曾在推特上指出,他之前所提交的论文审核,一般只是看看有没有透露敏感信息,而不是看论文的参考文献质量。

3 Gebru被辞退为何引起这么多关注?

根据BBC最新报道,目前已有超过4500人签署公开信,包括谷歌、微软、Apple、Facebook、亚马逊、Netflix、DeepMind等大企业的研究人员与英国学者,要求谷歌公开解释驳斥Gebru论文的原因。

公开信:https://googlewalkout.medium.com/standing-with-dr-timnit-gebru-isupporttimnit-believeblackwomen-6dadc300d382

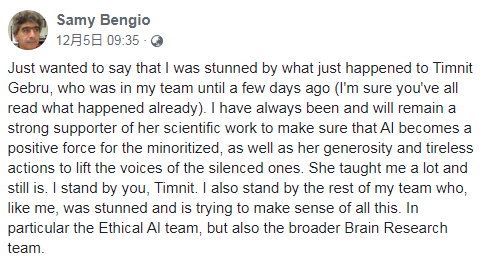

Gebru原先所在部门的经理Samy Bengio随后也发声,明确表示支持Gebru。

此次事件也被称为“selective publication”(有选择的发表)。UCL荣誉副教授Julien Cornebise称,“selective publication”也曾发生在烟草行业、癌症研究、能源行业与气候变化等敏感领域。在Cornebise看来,与Facebook、Google等企业合作是AI科研者的唯一选择,因为“这个行业几乎是垄断的。”

Bender在接受MIT科技评论的采访中也提到,这篇论文强调了学术自由的价值。这篇论文的目标是指出NLP研究的发展前景,指出人们虽然构建了大型语言模型、却没有真正掌握数据。而且,由于存在明显的弊端,研究人员也许应该退一步问问自己,如果在减少风险的同时获得收益。

DeepMind的研究科学家Iason Gabriel发推文说,“如果我们不能自由地谈论AI系统带来的道德伦理问题,那么我们永远也不能建立一个(AI)伦理体系。”

除了学术自由,英国政府AI咨询主席Tabitha Goldstaub还提到,从Gebru事件中,我们可以看到公众独立的资金支持对AI发展的重要性。

此前,谷歌一直被认为是“AI向善”的重要践行力量,但Gebru事件改变了许多人的看法。

来自计算机语言协会(Association for Computational Linguistics)的成员Donia Scott则认为,Gebru是致力于消除AI偏见的领军人物,连她这样德高望重的黑人女性都被如此对待,谷歌传递的讯息已经很明显。

针对Gebru是因为论文威胁谷歌的商业利益而被辞退的可能性,兰卡斯特大学教授Lucy Suchman谈到,如果谷歌能被这么一篇研究论文威胁到,那也是十分“令人印象深刻”。“人们只会觉得谷歌不能容纳一个黑人女权科学家。”

谷歌在许多基础研究上遥遥领先,这带来了大型语言模型的最新爆炸式增长。Google AI 在2017年首先发明了Transformer语言模型,该模型是谷歌之后研究的BERT模型以及OpenAI的GPT-2和GPT-3模型的基础。而BERT模型对谷歌的经济收入非常重要。

再反观近日,GPT-3获得NeurIPS最佳论文。若大规模语言模型果如Gebru等研究者指出的“危害大于利益”,那么,GPT-3的神话还会继续吗?

参考链接:

-

https://www.technologyreview.com/2020/12/04/1013294/google-ai-ethics-research-paper-forced-out-timnit-gebru/

-

https://www.bbc.com/news/technology-55164324